Logistic regression : Classification

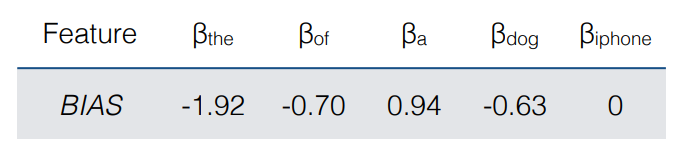

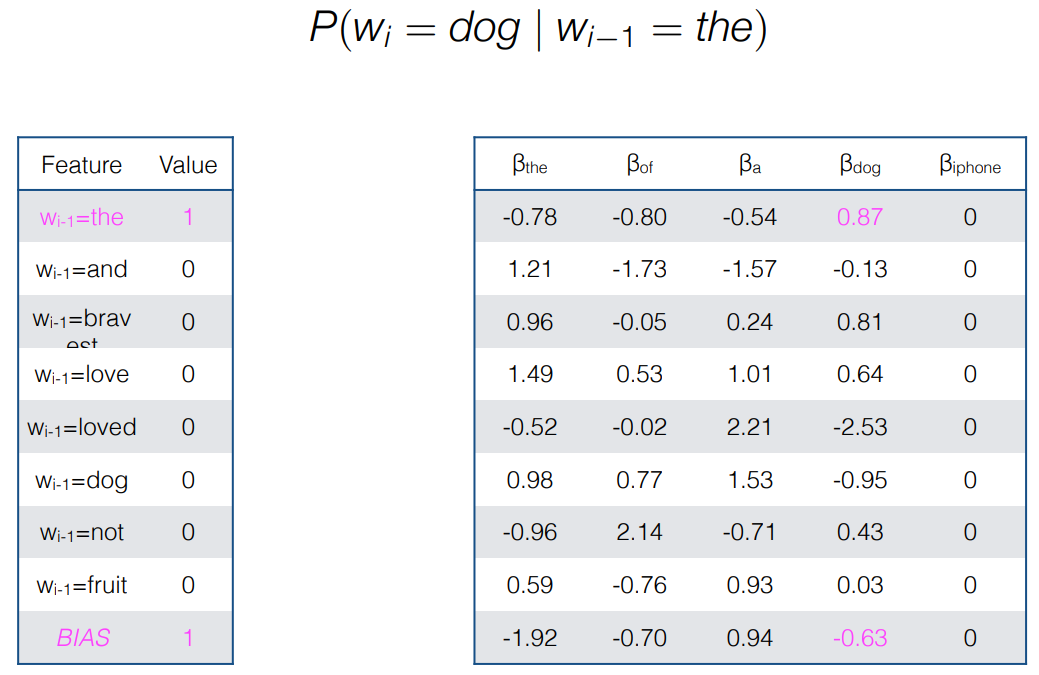

- LM : We can use multiclass logistic regression for language modeling by treating the vocabulary as the output space

여러 가지 LM 모델들

[참고]

Richer representations

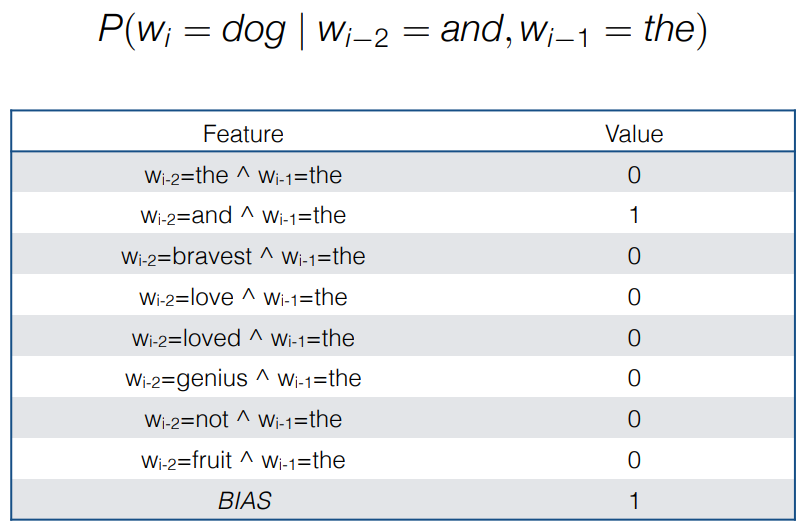

- Log-linear models give us the flexibility of encoding richer representations of the context we are conditioning on.

- We can reason about any observations from the entire history and not just the local context

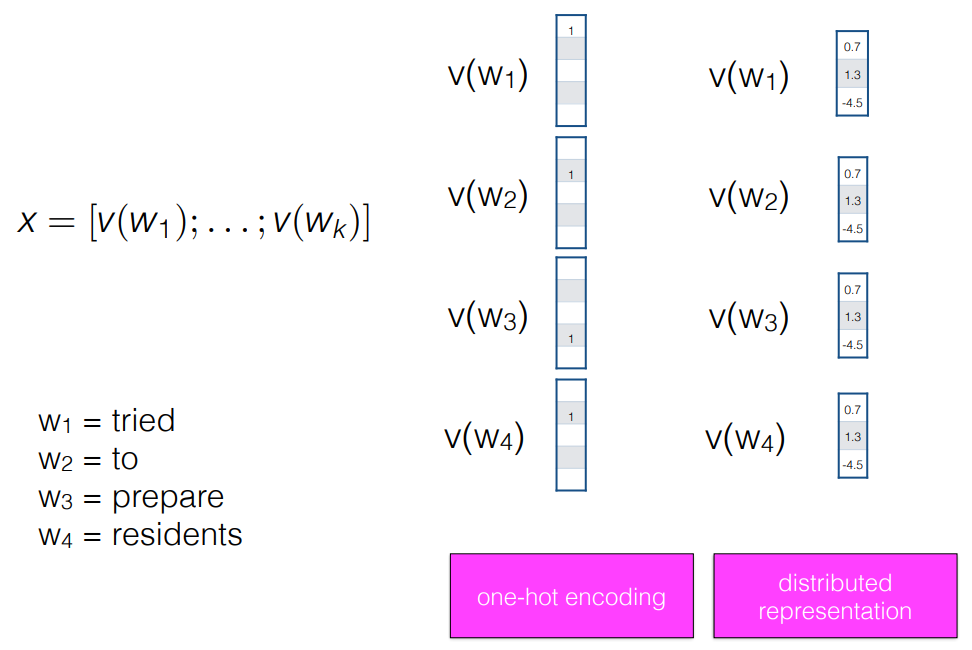

Neural LM : Classification

- input x = vector concatenation of a conditioning context of fixed size k

- 단어 vector 를 이어붙여서 x input을 만들 수 있다.

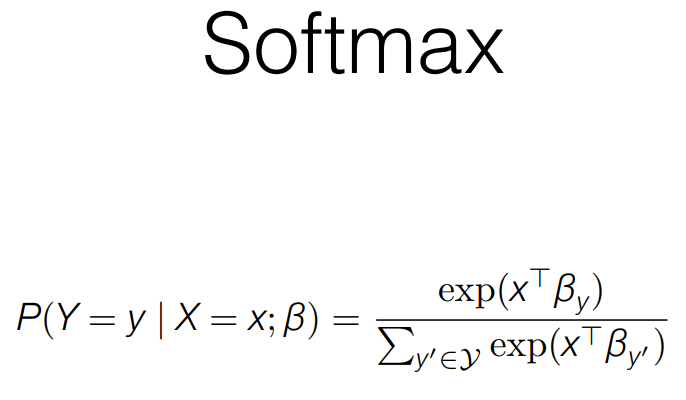

- softmax : multi classification 할 때 사용하고, 모든 y개 class 확률분포의 합이 1이 되는 함수이다.

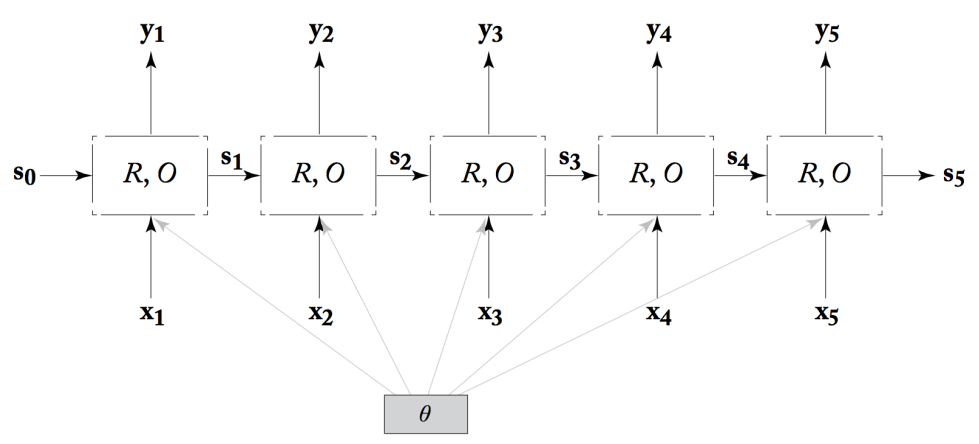

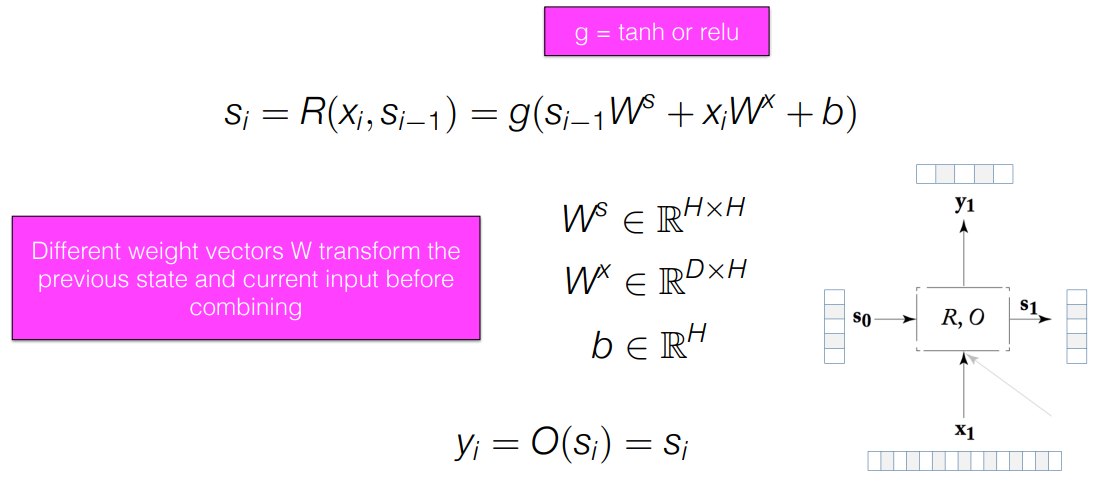

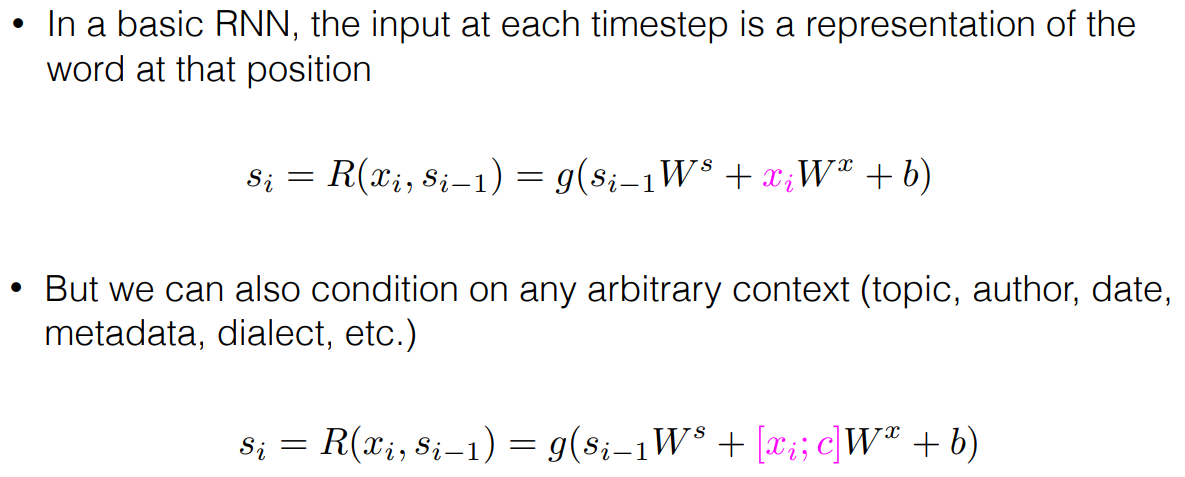

Recurrent neural network (RNN) : Classification

- Sequential data 이용할 때, RNN 주로 사용

- RNN 은 순서의 특징을 잘 잡아낸다.

- 이전 history 를 중요도에 따라 차등 적용한다.

- 각 state 마다 output 출력이 가능하다. -> 번역에 사용 가능

- RNN은 bigram, trigram, ... 을 넘어서 x1이 x5에 영향을 더 많이 준다면 x1의 β 값을 높인다.

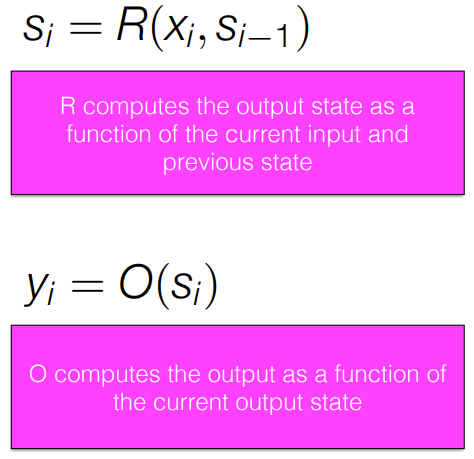

- s1은 이전까지의 상태의 정보를 다 담아둔 학습 벡터 -> 중요한 정보는 많이 기억하고, 관사 같이 덜 중요한 건 덜 담는다.

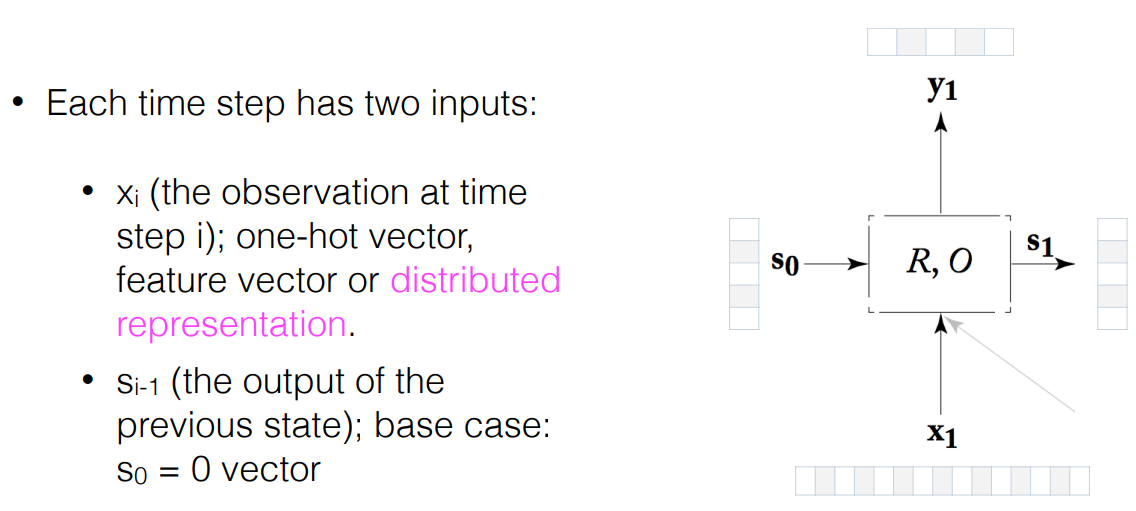

- s1 : Current state

- s0 : Previous state

- x1 : Current input

- g = tanh or relu / O = softmax

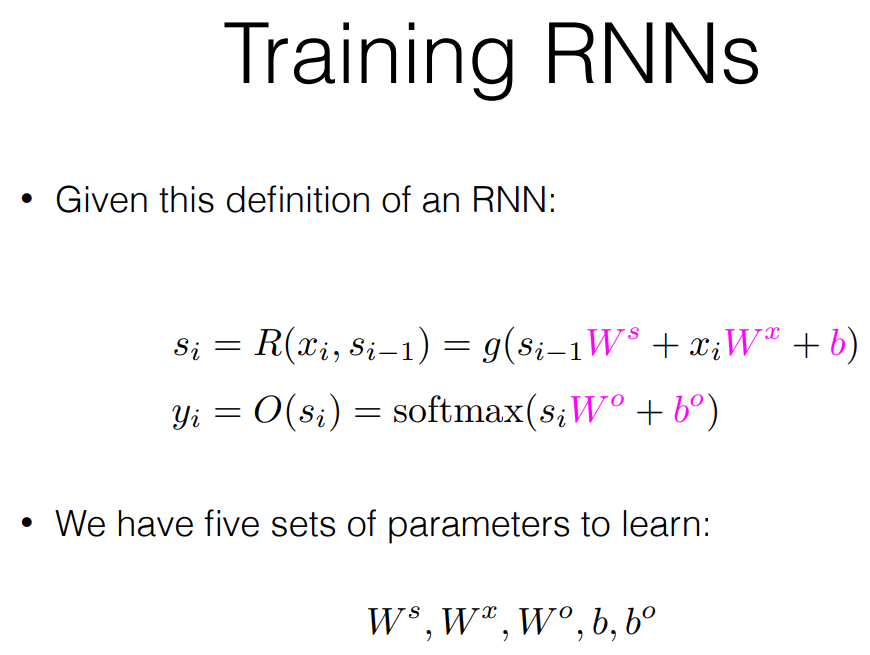

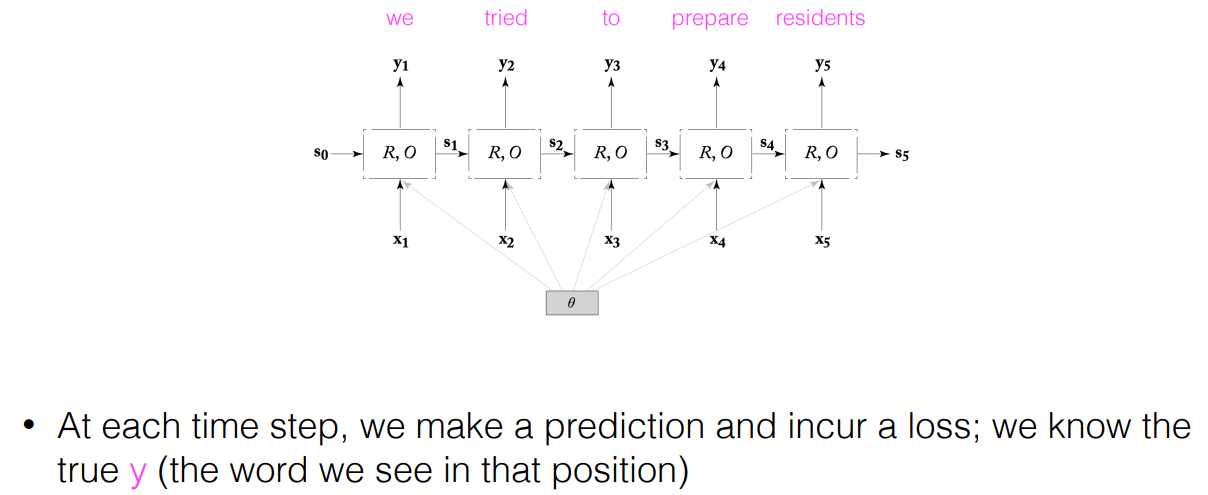

Training RNNs

- Back Propaganda 를 통해서 학습한다.

- True y와 y햇의 loss 를 매 step마다 loss가 작아지는 방향으로 update한다.

- Current input 을 변형시켜서 넣어줄 수도 있다.

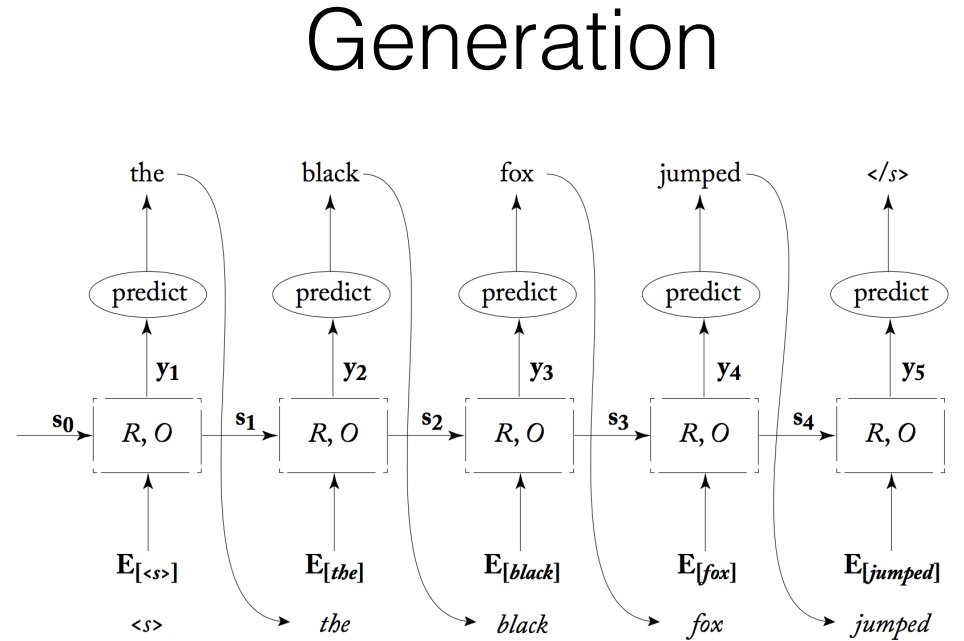

RNN : Generation -> RNN 이 Generation 모델로도 사용될 수 있다.

- RNN은 각각의 state마다 output 을 알 수 있으니까 이 output을 위의 그림과 같이 활용하면 Generation의 방법으로 사용할 수 있다.

출처 : https://people.ischool.berkeley.edu/~dbamman/nlp21.html