소프트맥스 -> 활성함수

로그우도 -> 목적함수

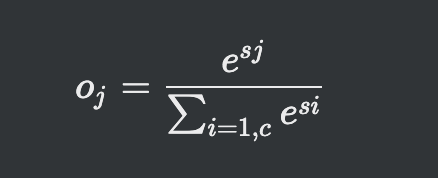

소프트맥스(활성함수)

- max 함수를 모방한 개념

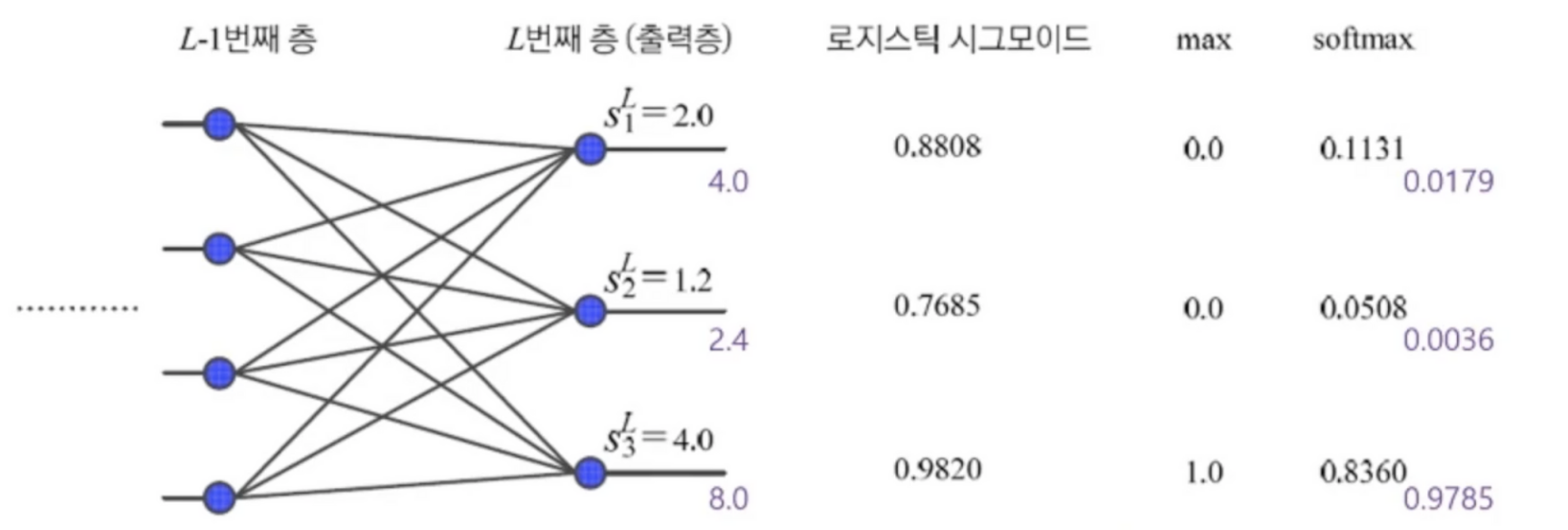

- 로지스틱 시그모이드 같은경우 기준값을 넘지 못하면 0 기준을 넘으면 무조건 1이 되버림

- 확률적 판단에는 시그모이드 함수는 적합하지 않음

- 소프트맥스느 정규분포 형태로 합쳐서 1인 수치로 확률을 계산

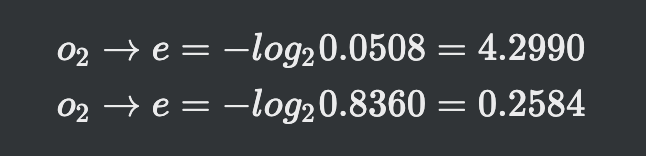

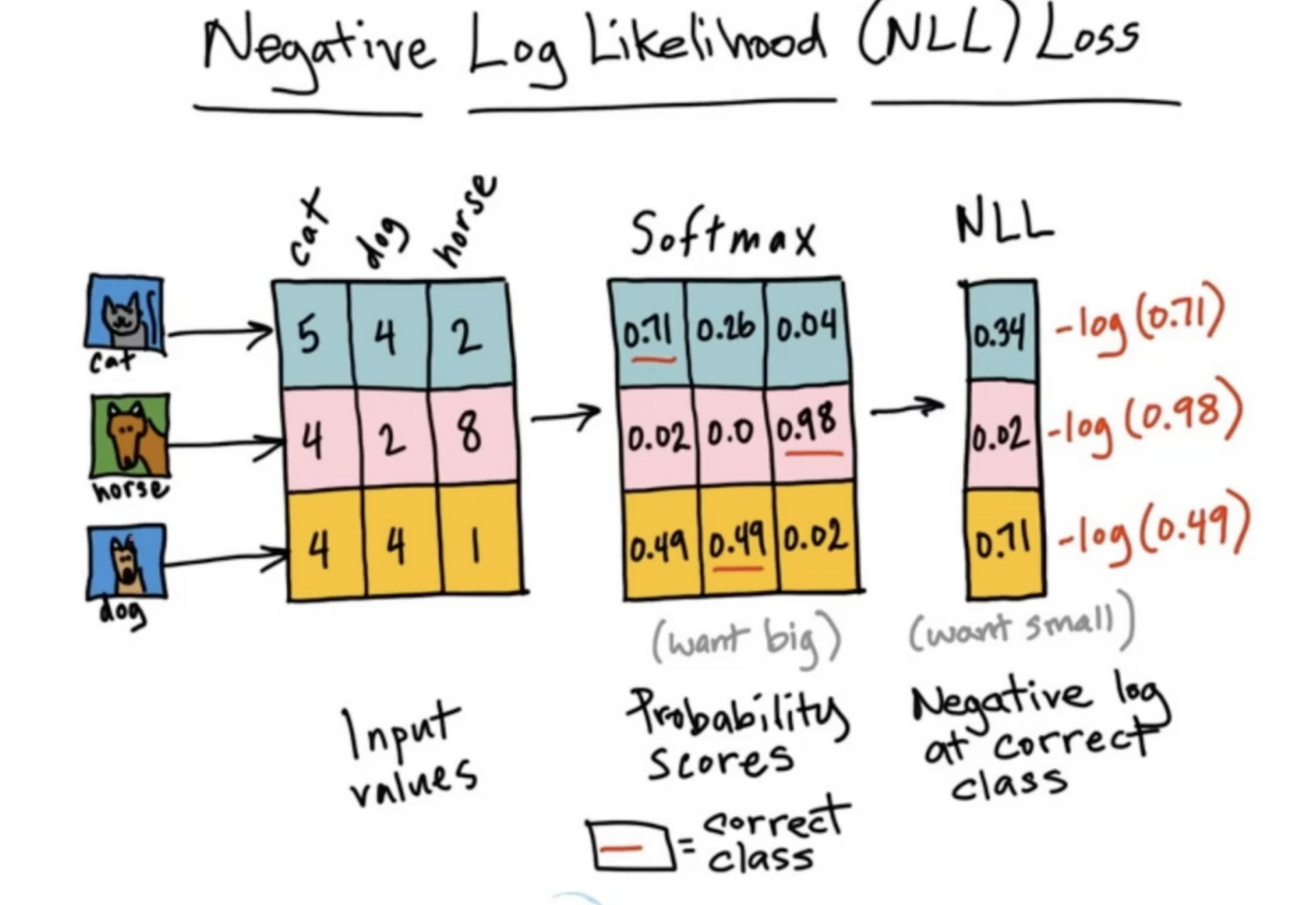

음의 로그우도(목적함수)

-

MSE, 교차 엔트로피와는 달리 하나의 노드에만 적용되는 목적함수

-

softmax로 나온 결과를 위 공식대로 한다면

0.0508의 값은 잘못분류한 값이니까 높은 수치가 나오게 돼

반면 잘 분류된 값은 수치가 낮게 나와서 비교가 가능 -

소프트맥스는 최댓값이 아닌 값을 억제하여 0에 가깝게 만든다는 의도

-

신경망에 의한 샘플의 정답에 해당하는 노드만 보겠다는 로그의도와 잘 결합

-

둘을 잘 결합해 사용함

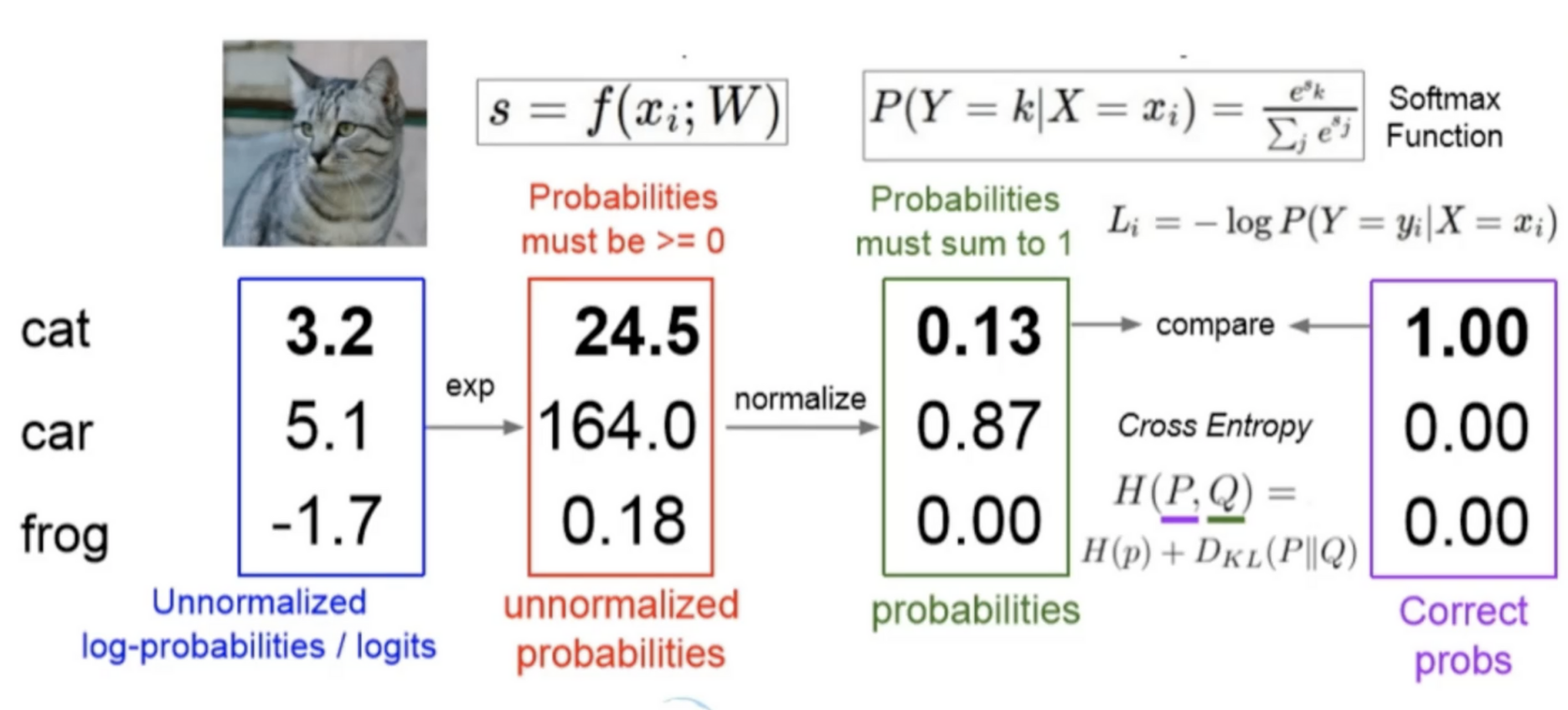

소프트맥스&엔트로피(목적함수)

-

로그우도로 계산된 값을 급수를 활용해줌

급수를 사용해주게 되면 모든 x축에대해 양의 값을 가지게 돼

급수를 사용해주게 되면 모든 x축에대해 양의 값을 가지게 돼 -

정규화(노멀라이즈)를 통해 합쳐서 1인 확률로 바꿔주고

-

H(P, Q) 라는 크로스엔트로피를 통해 값을 계산해 목적함수의 몫을 하게 됨

- 계산된 확률을 소프트맥스를 통해 확률의 최대값을 가져와주고 로그우도 목적함수를 통해 값을 비교해줌