기계 번역

- 기계 번역 훈련 샘플의 예

- 언어 모델은 입력 문장과 출력 문장의 길이가 같은데 비해 기계 번역은 길이가 서로 다른 열 대 열 문제

- 어순이 다른 문제

- 고전적인 통계적 기계 번역 방법의 한계로 현재 심층학습 기반 기계 번역 방법이 주류

- 다대일 인코더 -> 일대다 디코더로 해결

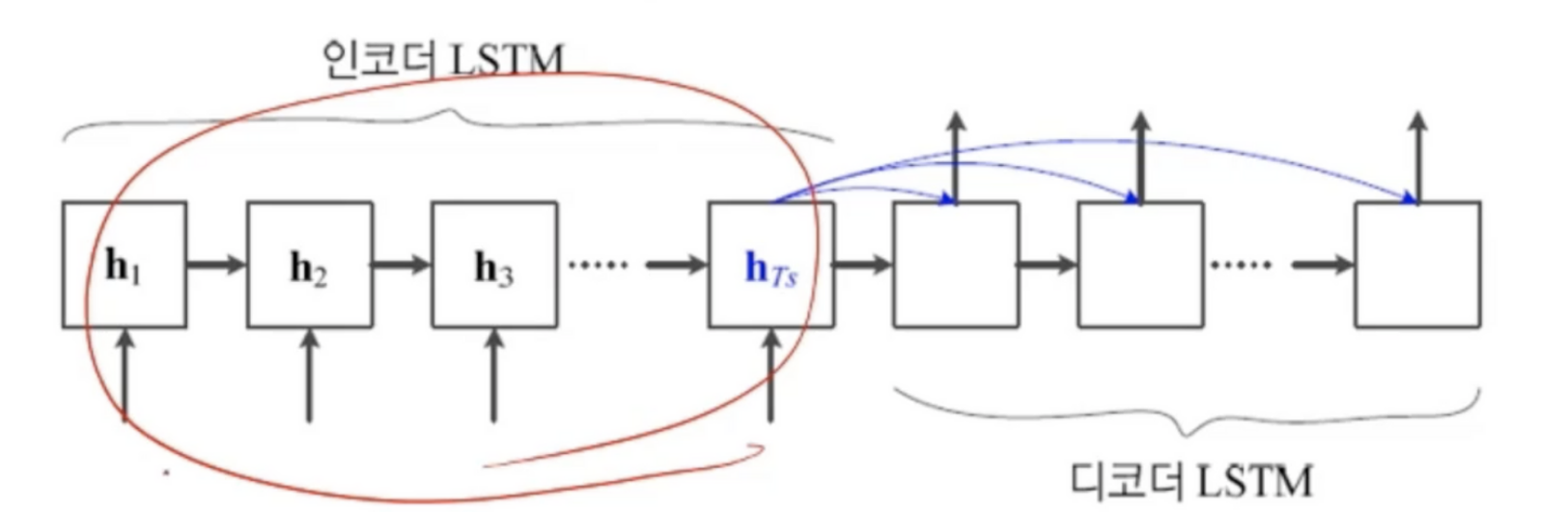

LSTM을 사용해 번역 과정 전체를 학습

- LSTM 2개를 사용(앞쪽은 부호기(인코더), 뒤쪽은 복호기(디코더))

- 부호기는 원시 언어 문장 x를 h_Ts라는 특징 벡터로 변환

- 복호기는 h_Ts를 가지고 목적 언어 문장 y를 생성

- 가변 길이의 문장을 고정 길이의 특징 벡터로 변환 후, 고정 길이에서 가변 길이 문장을 생성

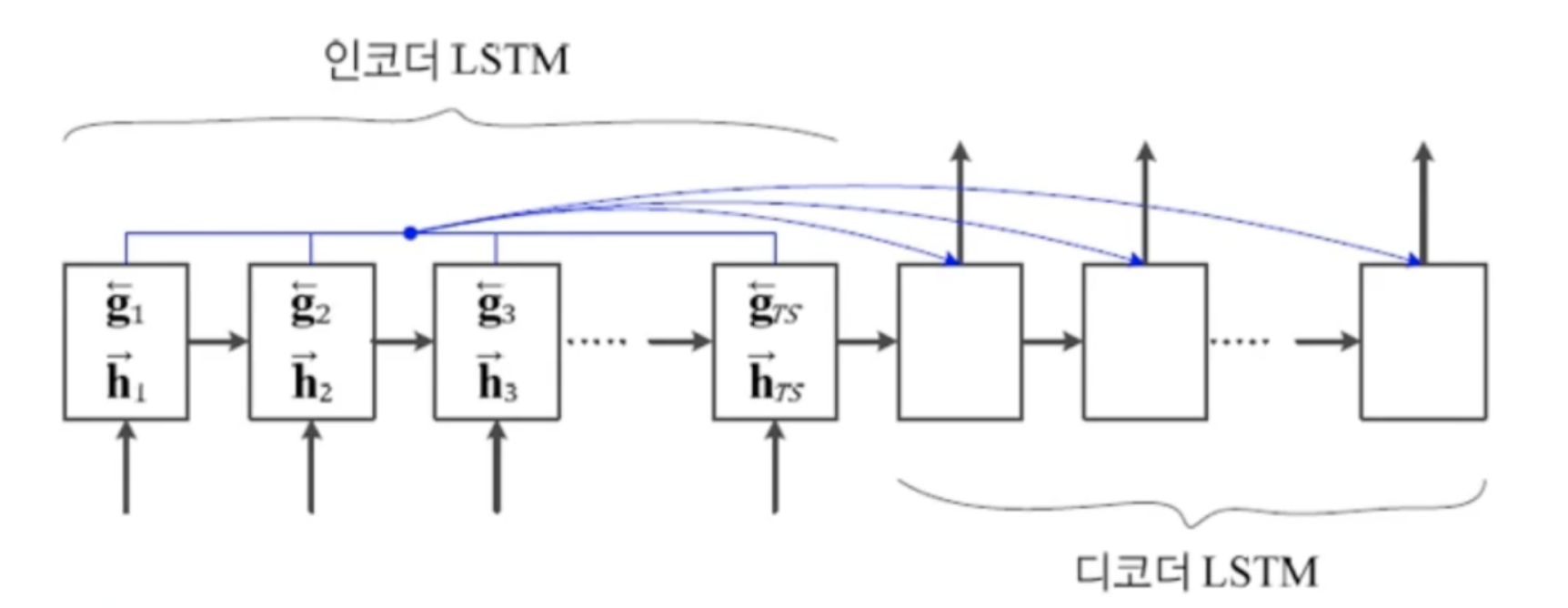

모든 순간의 상태 변수를 사용하는 방식

- 부호기의 계싼 결과인 h 전부를 모두 복호기에 넘겨 줌

- 양방향 구조를 채택하여 어순이 다른 문제를 해결