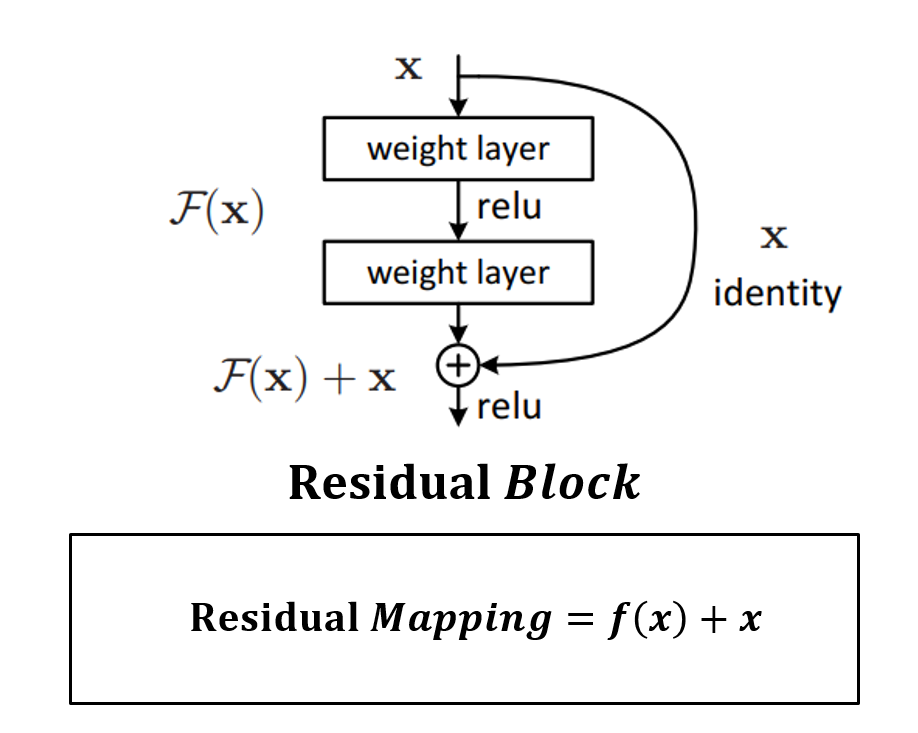

Residual Block이라는 개념을 처음 사용한 Network는 ResNet(2015)이다. Block 단위로 Parameter를 전달하기 전에 이전의 값을 더하는 방식으로 구현됬다. 이 방식은 HRNet의 에서도 동일하기 사용되고 있다.(BasicBlock, Bottleneck)

F(x): weight layer - relu - weight layer

x: identity

이 Residual Block이 결국 short skip connection을 만들게 되고 conv layer를 거친 F(x) = low level feature와 conv layer를 거치지 않은 x = high level feature의 summation을 통해 깊은 네트워크에서 vanishing gradient problem을 해결할 수 있도록 합니다.

class BasicBlock(nn.Module):

expansion = 1

def __init__(self, inplanes, planes, stride=1, downsample=None):

super(BasicBlock, self).__init__()

self.conv1 = nn.Conv2d(in_dim, mid_dim, kernel_size=3, padding=1)

self.bn1 = nn.BatchNorm2d(planes, momentum=BN_MOMENTUM)

self.relu = nn.ReLU(inplace=True)

self.conv2 = nn.Conv2d(in_dim, mid_dim, kernel_size=3, padding=1)

self.bn2 = nn.BatchNorm2d(planes, momentum=BN_MOMENTUM)

self.downsample = downsample

self.stride = stride

def forward(self, x):

residual = x

out = self.conv1(x)

out = self.bn1(out)

out = self.relu(out)

out = self.conv2(out)

out = self.bn2(out)

if self.downsample is not None:

residual = self.downsample(x)

#실제 summation을 수행하는 곳

out += residual

out = self.relu(out)

return outReferenced: https://coding-yoon.tistory.com/141, https://arxiv.org/abs/1512.03385