Natural Language Processing

1.[Paper] Attention is All You Need 논문 리뷰

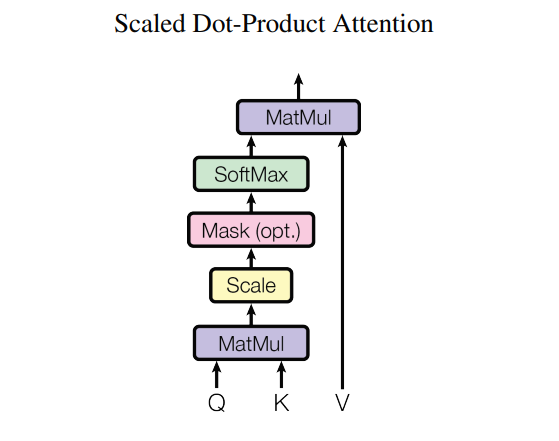

본 글은 Google Brain에서 2017 NIPS에 발표한 Attention is All You Need 논문에 대한 리뷰입니다. RNN 모델의 장기 의존성 문제(long-term dependency)를 극복하기 위해 제안된 Transformer는 BERT나 GPT

2022년 12월 28일

2.[Project] Natural Language Processing with Disaster Tweets - Kaggle

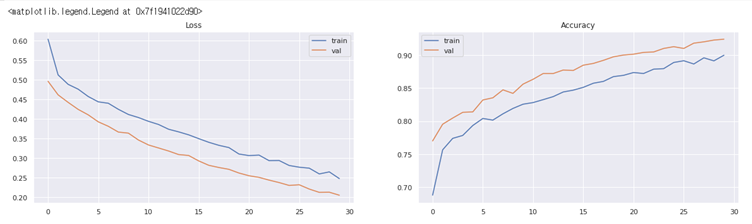

| 머리말 | 전공과목인 데이터마이닝 수업의 2달 여정의 프로젝트로 저는 LSTM을 이용한 재난관련 트윗 분류문제를 선정했습니다. 지난학기에는 타이타닉 분류예측 문제를 했었는데 교수님께서 이번에는 LSTM을 이용하여 정확도를 높여보라고 하셔서 어떤 주제를 할지 캐글을

2022년 3월 26일

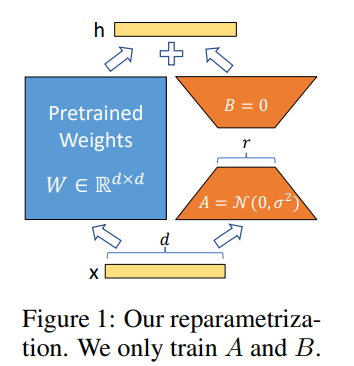

3.LoRA: Low-Rank Adaptation of Large Language Models

transformer 기반의 모델을 이용하려고 할 때 downstream task를 적용하기 위한 작은 데이터를 위해 full fine tuning 하는 것이 비효율적이다.따라서 transformer의 좋은 generalization 성능을 유지하면서 기존의 pretr

2023년 11월 23일

4.PEFT(Parameter-Efficient Fine-Tuning) 라이브러리 : 대규모 Pre-trained Language Model 효과적으로 활용하기

Pre-trained Language Model (PLM) 효율적으로 finetuning하기, PEFT 방법론 ``LoRA``, ``prompt tuning``, ``prefix tuning``

2024년 3월 8일