딥러닝

1.딥러닝 시작하기

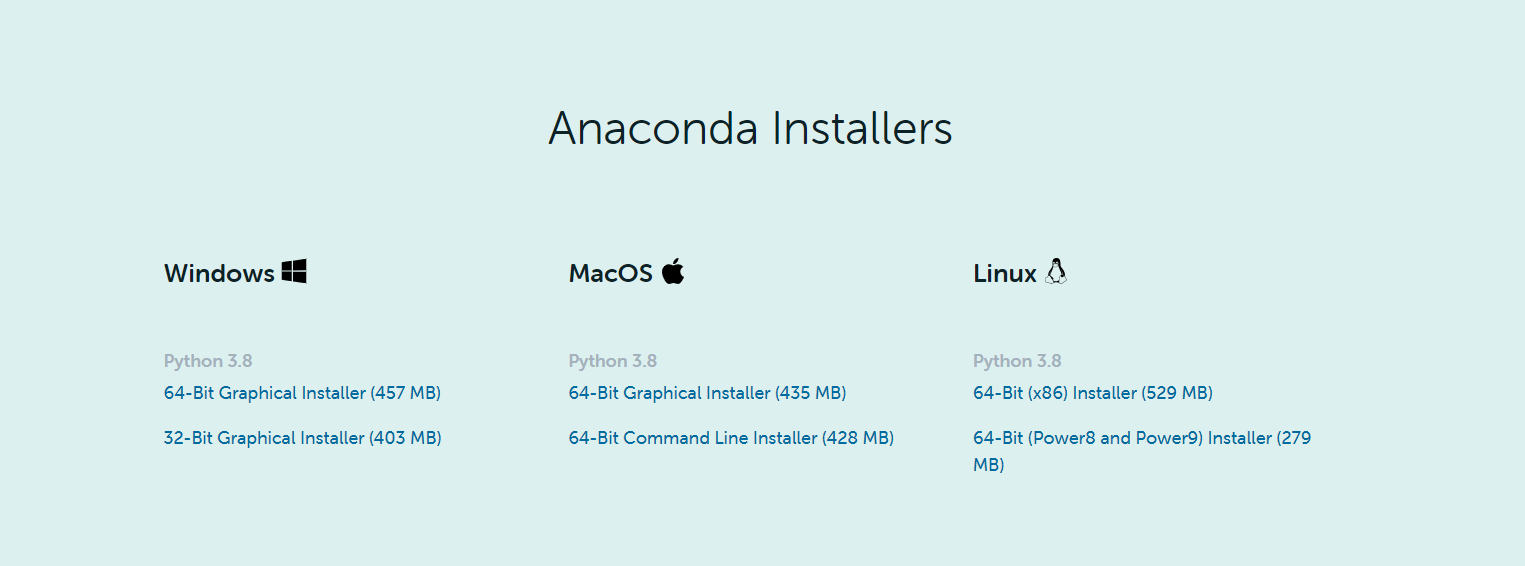

딥러닝 공부를 하기 위해 환경을 설정해보자. 구글에 anaconda를 검색해서 다운로드를 받는다. 대부분의 경우 64bit 운영체제이지만, 컴퓨터마다 다르므로 꼭 확인을 해보자.간혹 python 경로설정의 문제로 오류가 뜰때가 있다고 해서 add path를 클릭해주었

2.딥러닝_torch를 사용해보자

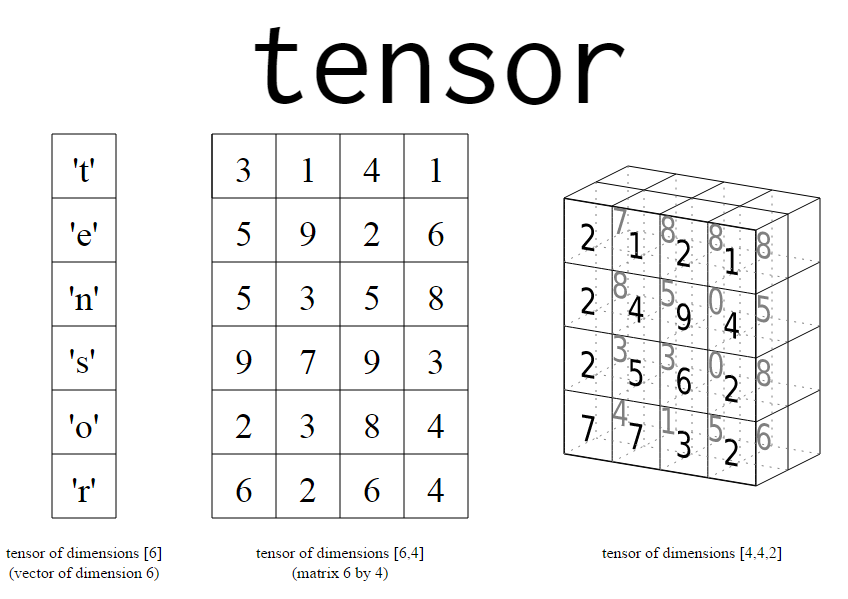

저번시간에 anaconda를 사용해서, torch를 설치하고, jupyter notebook을 사용해봤다. 그럼 이제 torch를 본격적으로 사용해보자.torch란 facebook에서 제공하는 딥러닝 도구로서, numpy와 효율적인 연동을 지원하는 편리한 도구이다.구글

3.torch.sum()에 대한 정리

torch.sum()을 사용하는데, 2차원을 넘어가면 계속해서 헷갈리다가, 어렵게 이해를 했다. 이해한 것을 토대로 정리해보려고 한다.사용법 자체는 numpy의 numpy.sum()과 다르지 않다. a가 밑처럼 생긴 4x4의 matrix라고 할 때,a를 dim없이 su

4.Optimizer의 종류와 간단한 정리

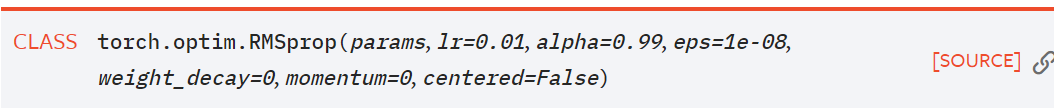

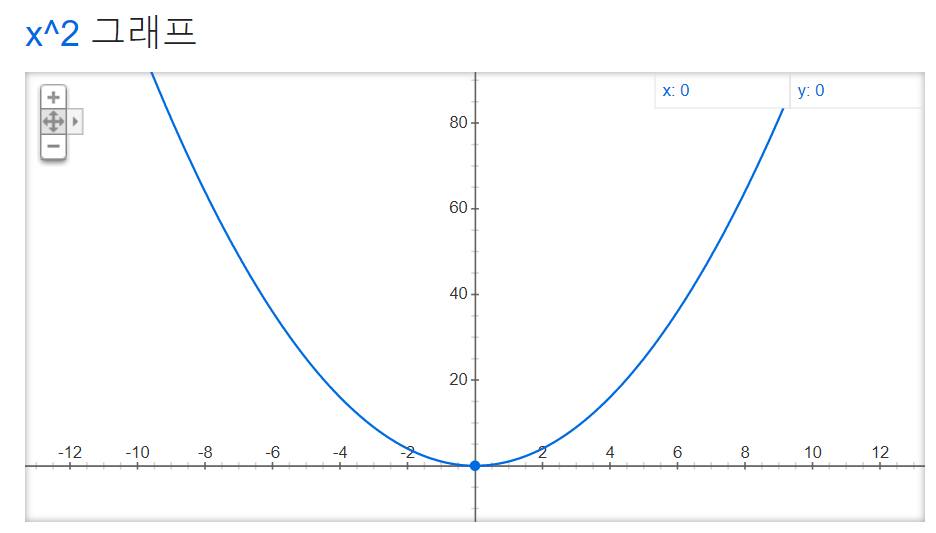

model을 학습시키기 위해선 optimization라는 작업을 해준다. weight의 torch.backward()라는 함수로, gradient를 구해서 weight의 값을 변화시켜주는 역활을 한다. 가장 기본적인 방법으로 SGD가 있는데, 아래 나오는 모든 opim

5.정리

질문이 들었던 이유: batch를 나누는 이유가 뭘까? 가 궁금했었다. https://cafe.naver.com/bakingschool/309807- 우선 batch를 나누는 확실한 이유는 dataset의 용량이 너무 커서, memory에 올릴 수 없기 때문에