[Unpaired Image-to-Image Translation using Cycle-Consistent Adversarial Networks ] (Cycle-GAN) 논문 리뷰

1.Introduction

1873년 화창한 봄, 모네는 아르장티유이 근처 센 강 둑에 이젤 앞에서 무슨 풍경을 보았을까요?

유추해보건데 만약 사진기가 있었다면 상쾌한 하늘과 이를 품고 있는 맑은 강을 담았을 것입니다.

만약 모네가 시원한 여름 저넉의 캐시스의 항구를 보았다면 어땟을까요?

모네의 그림들은 그가 여름 저녁을 어떻게 묘사했을지 상상케 합니다. 파스텔 톤의 색조, 과감한 터치, 단조로우면서 다양한 ...

우리는 이러한 장면을 보지 못했음에도 충분히 상상할 수 있습니다. 즉, 하나의 set (모네의 그림들)로 부터 다른 set (사진)으로의 스타일 변화를 충분히 상상할 수 있습니다.

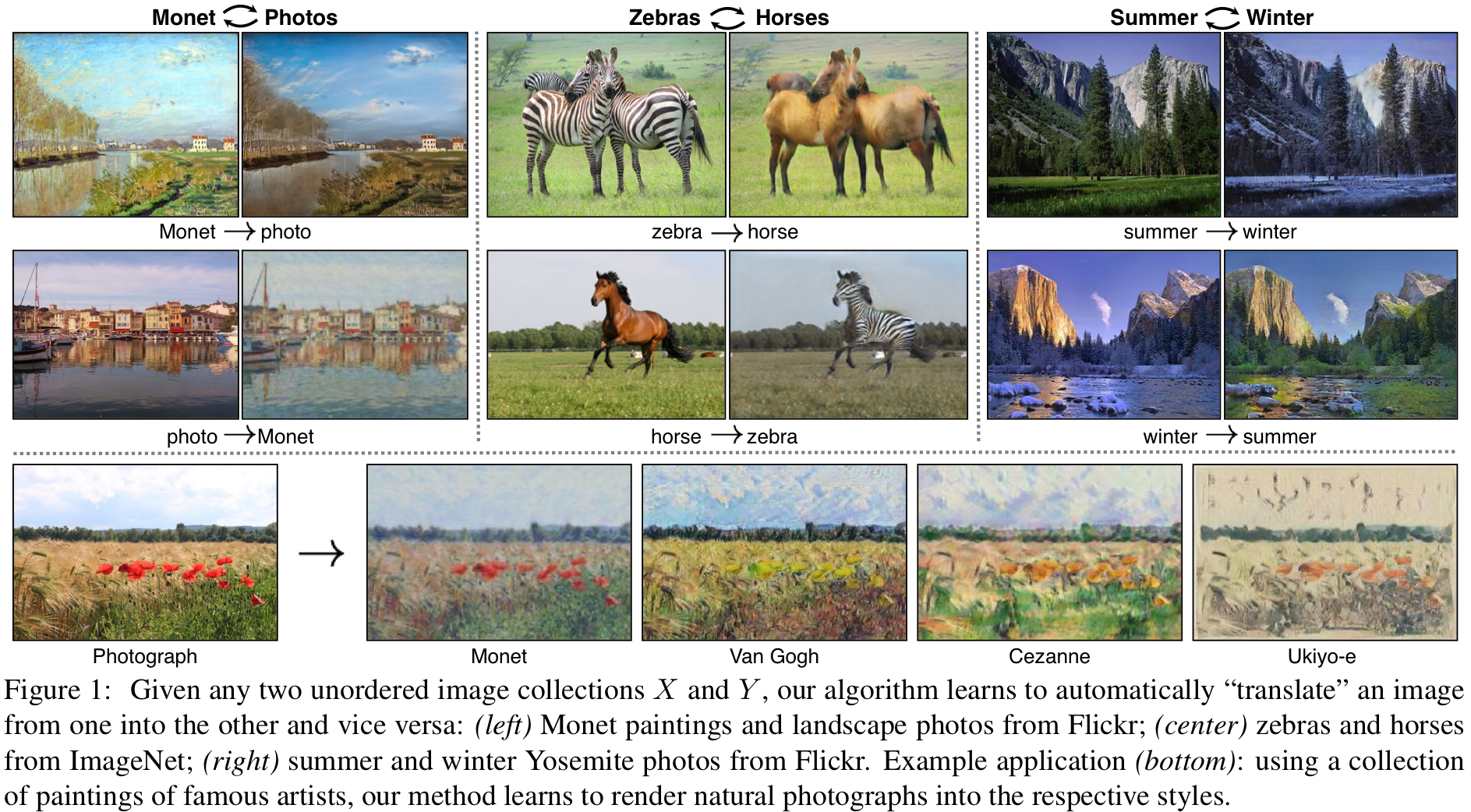

본 논문에서는 하나의 collection (set)로 부터 특성을 추출해 다른 collection (set)로의 이식을 가능케 하는 모델을 제안합니다. 또한 이에 대한 몇몇 예시는 아래 figure에 나와있습니다.

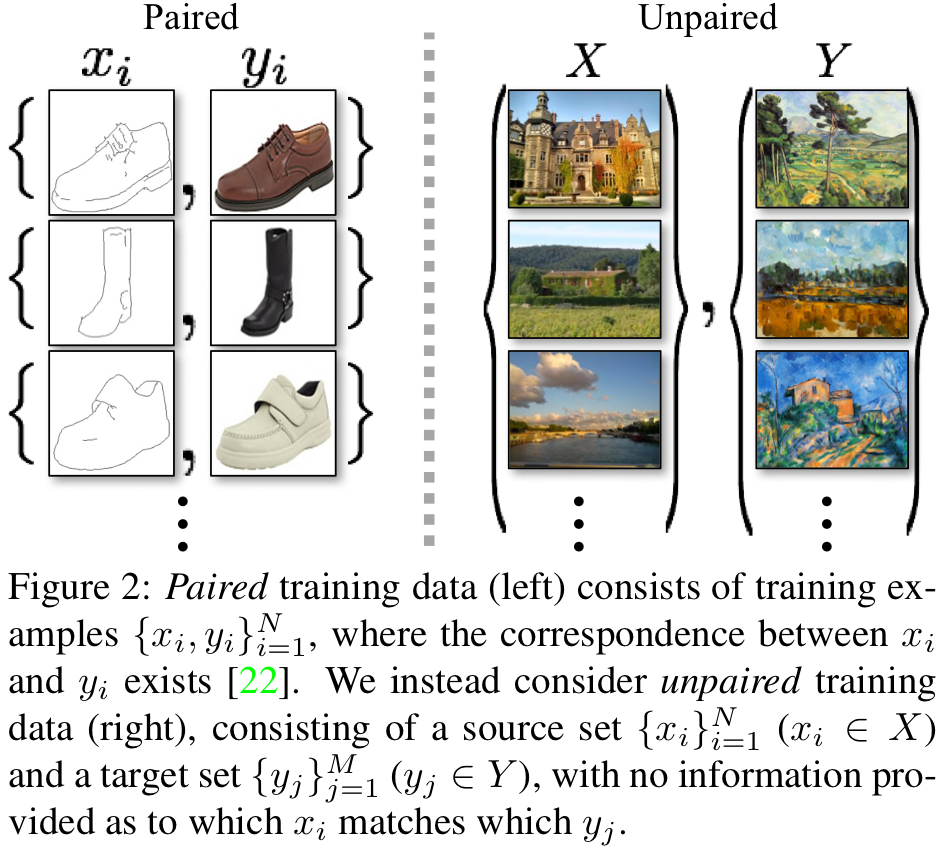

이러한 연구 분야는 image-traslation 영역으로 꾸준히 연구되어 왔습니다. 그러나 기존 연구들은 style 변화에 따른 pair iamge가 존재하여야 했습니다. 와 같은 형태로 말이죠. 그러나 이러한 데이터를 찾는 것은 매우 어렵습니다. 아래 그림의 'paired' 부분을 참고해주세요.

따라서 이러한 완전한 형태의 supervision dataset (sampel-2-sample)을 이용하기는 어렵지만 아래 그림과 같이 unpaired의 data를 이용하여 충분히 set간의 underlying realationship을 학습할 수 있습니다. 즉, 하나의 데이터 sample 끼리가 아닌 set 를 매핑 시키는 를 학습시킬 수 있습니다. 정확히는 이며 는 의 dataset들과 구분되지는 않아야 합니다. 위 그림의 'unpaired'를 참고해주세요. 이는 의 분포가 의 분포가 유사해야한다는 것을 의미하며 optimal 는 를 의 분포와 동일한 로 매핑 시킵니다. 그러나 여전히 paired data가 없고 위 조건을 만족하는 optimal 는 많기 때문에 (가장 간단하게 그냥 의 이미지들을 복사하는 매핑을 생각해볼 수 있겠네요) 최적화가 상당히 어렵다는 문제점이 있습니다.

이러한 문제점들은 본 논문에서 제안하는 방법론에 몇가지 추가적인 objective를 추가해야 해결될 수 있습니다. 따라서 본 논문에서는 translation의 Cycle consistent 성질을 사용하기로 합니다. Cycle consistent랑 번역의 양방향적인 (영어에서 한국어로, 한국어에서 영어로) 성질을 나타냅니다. 즉, 를 로 번형하는 가 존재하고 반대로 작업을 진행하는 가 존재할 때 서로가 서로의 일대일 대응 역함수 관계를 가져야 합니다. 의 관계가 만족되야 하기 때문에 이를 통해서 loss를 추출할 수 있고 본 논문에서는 'cycle consistency'로 명명하였습니다.

2.Related Work

해당 섹션에서는 Generative Adversarial Networks, Image-to-Iamge Translation, Unpaired Image-to-Image Translation, Cycle Consistency, Neural Style Transfer에 대한 이전 연구들을 다루고 있습니다.

3.Formulation

논문 내 notation들과 goal은 다음과 같다.

- 은 각각의 training sample dataset을 의미한다.

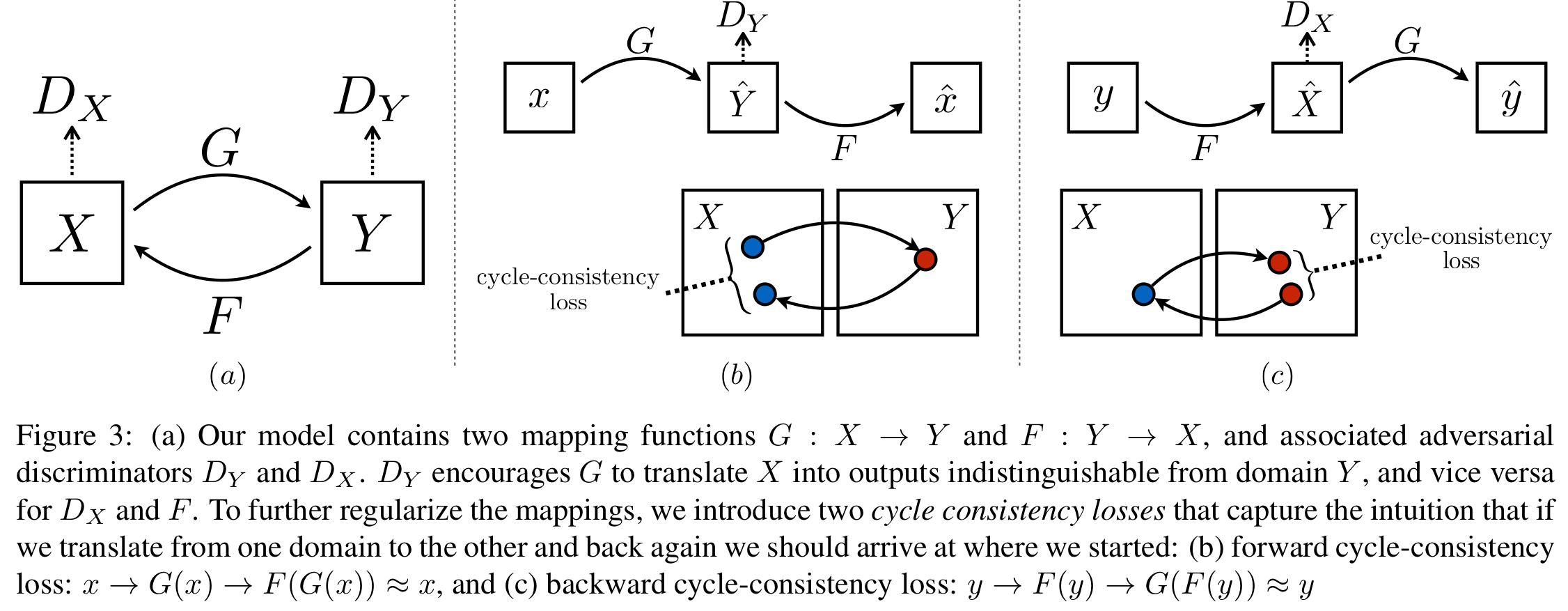

- Figure 3 (a)에서 확인할 수 있듯이 cycle-gan은 2개의 mapping function 를 포함한다.

- 총 2개의 discriminator 가 사용된다. 는 data가 로 부터왔는지 로부터 생성되었는지 판별한다. 또한 data 와 함수 에 대해 똑같이 작동한다.

- 는 gan에서 일반저긍로 사용되는 와 , 의 관계를 학습하기 위한 가 사용된다.

3.1 Adversarial Loss

해당 부분은 일반적인 GAN에 사용되는 와 거히 똑같습니다.

또한 일반적인 GAN 학습시 사용되는 min-max game training 전략이 똑같이 사용되므로 학습 objective는 가 됩니다. 또다른 discriminator 와 dataset 에 대해서도 역으로 똑같이 적용됩니다.

3.2 Cycle Consistency Loss

Introduction에서 언급했듯이 에서 혹은 역으로 맵핑 시키는 함수 는 상당히 많습니다. 따라서 'cycle-consistent'를 활용한 학습도 추가적으로 진행합니다. 즉, 가 서로서로 역함수 관계임을 활용합니다. Figure 3 (b)에서 확인할 수 있듯이 의 forward cycle consistency 과정을 통해 sampling된 와 변환과 역변환을 거친 후 생성된 를 비교하는 를 설계하였습니다. 또한 Figure 3 (c)와 같이 를 기준으로 데이터를 복원시키는 backward cycle consistency 과정을 통한 도 함께 사용하여 최종적으로 아래와 같은 Cycle Consistency Loss를 설계하였습니다.

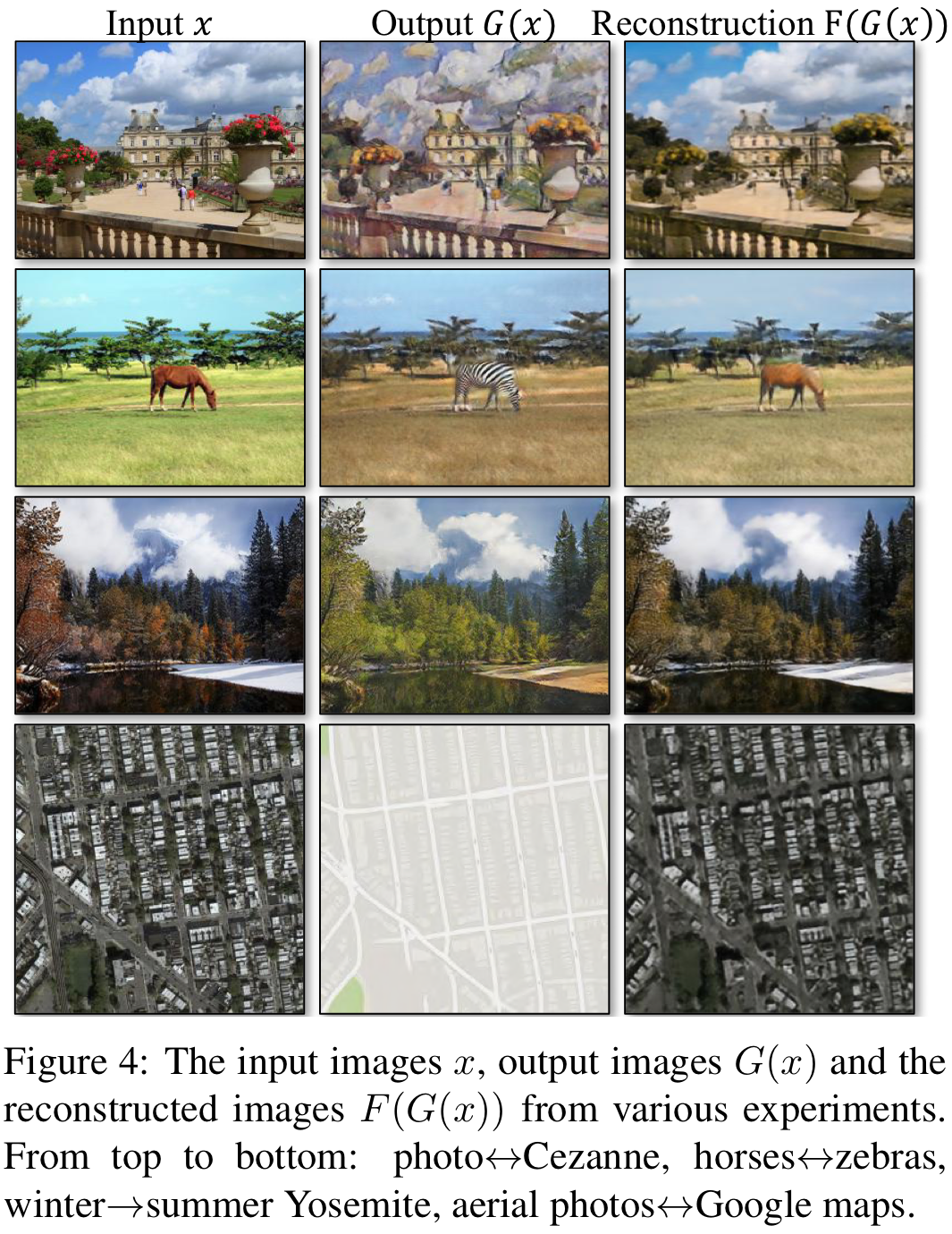

또한 원본이미지와 Cycle Consistency에 의해 복원된 이미지는 아래와 같이 Figure 4를 통해 확인하 실 수 있습니다.

3.3 Full Objective

최종 는 다음과 같습니다.

는 당연히 두 objective의 importance를 조정하기 위한 파라미터를 의미합니다. 또한 최종 objective는 다음과 같습니다.

또한 저자는 해당 학습 방법은 2개의 auto encoder ()를 학습하는 것으로 해석될 수 있다고 합니다. 또학 각각의 bottle neck layer는 서로 다른 데이터 셋의 distribution을 나타냅니다 (는 , 는 ).

4.Implementation

해당 섹션은 implementation detail을 다루고 있습니다. 한가지 특이한 것은 의 log likelihood object를 a least-squares loss로 교체하였으며 이때의 학습이 더욱 안정적이라 합니다. (이유는 왜 안알려줘...)

5.Result

5.1.1 Evaluation Metrics

- AMT perceptual studies: 해당 지표는 Amazon Mechanical Turk에서 참가자를 통해 평가한 지표입니다. 총 25, 특정 이미지에 대해 스타일이 변형된 real pair 이미지와 baseline 혹은 cycle-gan으로 변형된 이미지 중 real 같은 것을 고르는 식으로 평가를 진행했다고 합니다.

- FCN score: 신기하게도 해당 평가 지표는 그림에서 gan으로 인해 사진으로 변형된 이미지를 semantic segmentation 평가 지표인 'IOU (Intersection-Over-Union)'를 통해 평가해보았다고 합니다. 아마 해당 평가지표를 사용한 직관적인 아이디어는 사실적인 변형이 이루어졌다면 semantic segmentation이 잘 이루어질 것이다 라는 아이디어인 것 같습니다.

6. 정리

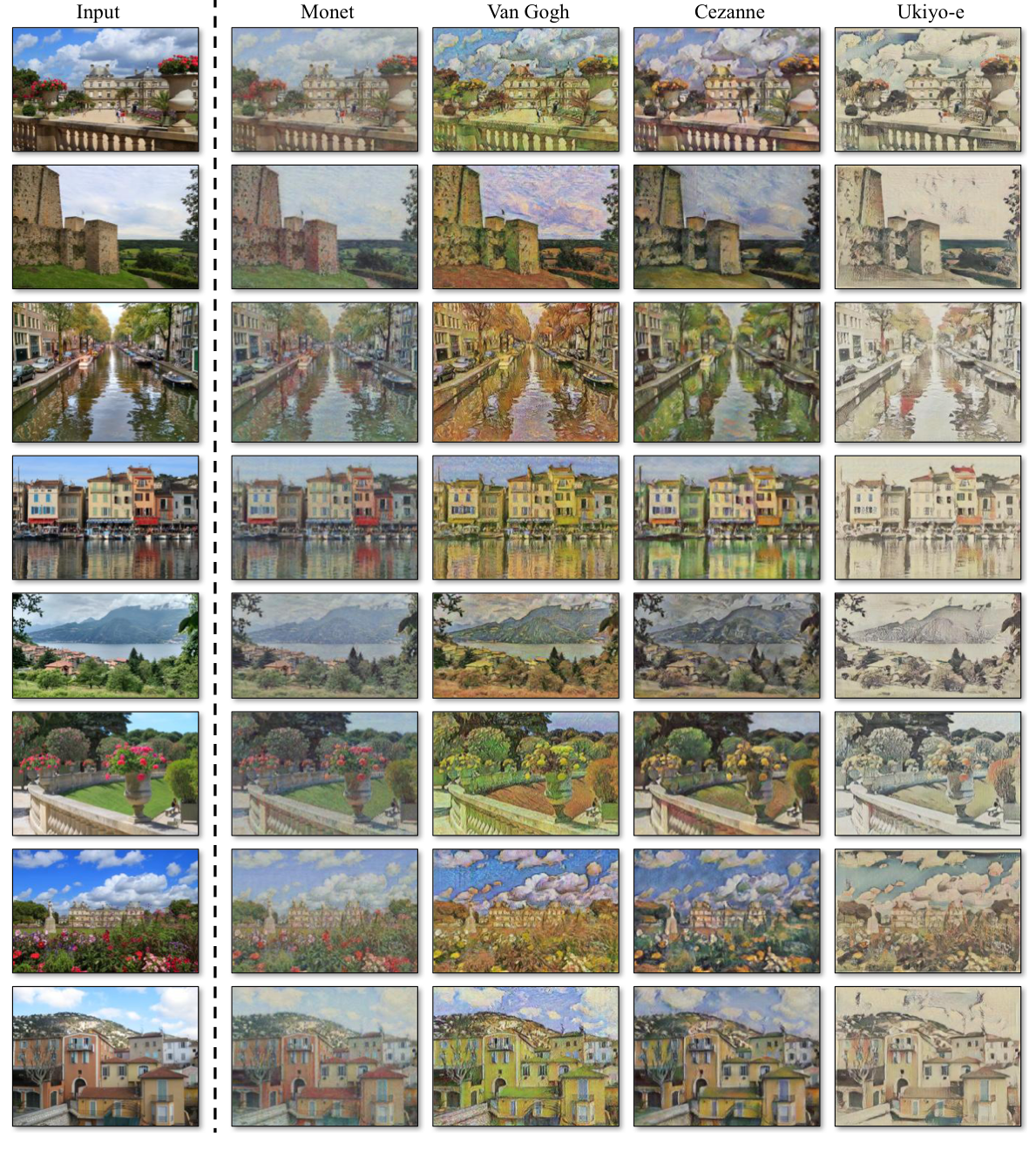

사실 result까지 천천히 살펴보고 싶었지만 표와 그림이 너무 많이 첨부되어 있어 아래 사진으로 결과를 정리하고자 합니다.

Style transfer 결과를 이미지를 통해서 확인하니 꽤 퀄리티가 좋은 것 같습니다. 사실 GAN을 비롯한 생성분야를 자세히 알지는 못하지만 기존의 style transfer model들은 pair한 이미지가 필요하지만 style gan은 그렇지 않다는 점, 기존의 GAN에서 아이디어를 착안하여 많은 변화 없이 좋은 퀄리티의 결과를 내는 점들을 해당 논문의 의의라고 말씀드리며 본 포스팅을 마치도록 하겠습니다.