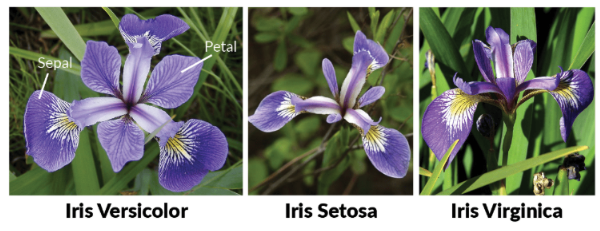

Iris 꽃 분류

- Fully Connected Layer (Dense)를 활용한 분류 모델 (Classification)

- tensorflow-datasets 를 활용한 데이터 전처리

For this task you will train a classifier for Iris flowers using the Iris dataset

The final layer in your neural network should look like: tf.keras.layers.

Dense(3, activation=tf.nn.softmax)

The input layer will expect data in the shape (4,)

We've given you some starter code for preprocessing the data

You'll need to implement the preprocess function for data.map

이 작업에서는 Iris 데이터 세트를 사용하여 Iris 꽃 분류기를 훈련시킵니다.

신경망의 마지막 계층은 tf.keras.layers와 같아야합니다.

Dense(3, activation='softmax')

입력 레이어는 모양의 데이터를 기대합니다 (4,)

데이터 전처리를위한 스타터 코드를 제공했습니다

data.map에 대한 전처리 기능을 구현해야합니다.

Solution

순서 요약

- import: 필요한 모듈 import

- 전처리: 학습에 필요한 데이터 전처리를 수행합니다.

- 모델링(model): 모델을 정의합니다.

- 컴파일(compile): 모델을 생성합니다.

- 학습 (fit): 모델을 학습시킵니다.

1. import 하기

필요한 모듈을 import 합니다.

import numpy as np

import tensorflow as tf

import tensorflow_datasets as tfds

from tensorflow.keras.layers import Dense

from tensorflow.keras.models import Sequential

from tensorflow.keras.callbacks import ModelCheckpoint2.1 전처리 (Load dataset)

tensorflow-datasets를 활용합니다.

train_dataset와 valid_dataset을 만들고 80% : 20%로 분할합니다.

train_dataset = tfds.load('iris', split='train[:80%]')

valid_dataset = tfds.load('iris', split='train[80%:]')2.2 전처리 (tensorflow-datasets)

먼저, 시험에서는 다음과 같은 전처리 요구 조건이 있습니다.

- label 값을 one-hot encoding 할 것

- feature (x), label (y)를 분할할 것

def preprocess(data): # 코드를 입력하세요 x = data['features'] y = data['label'] y = tf.one_hot(y, 3) return x, y

만든 전처리 함수(preprocessing)를 dataset에 mapping하고, batch_size도 지정합니다.

batch_size=10

train_data = train_dataset.map(preprocess).batch(batch_size)

valid_data = valid_dataset.map(preprocess).batch(batch_size)

### 3. **이미지 정규화 (Normalization)**3. 모델 정의 (Sequential)

이제 Modeling을 할 차례입니다.

Sequential 모델 안에서 층을 깊게 쌓아 올려 주면 됩니다.

input_shape는 Iris 꽃 데이터셋의 X의 feature 갯수가 4개 이므로 (4, )로 지정합니다.- 깊은 출력층과 더 많은 Layer를 쌓습니다.

- Dense Layer에

activation='relu'를 적용합니다. - 분류(Classification)의 마지막 층의 출력 숫자는 분류하고자 하는 클래스 갯수와 같아야 합니다.

model = tf.keras.models.Sequential([

# input_shape는 X의 feature 갯수가 4개 이므로 (4, )로 지정합니다.

Dense(512, activation='relu', input_shape=(4,)),

Dense(256, activation='relu'),

Dense(128, activation='relu'),

Dense(64, activation='relu'),

Dense(32, activation='relu'),

# Classification을 위한 Softmax, 클래스 갯수 = 3개

Dense(3, activation='softmax'),

])model.summary()4. 컴파일 (compile)

optimizer는 가장 최적화가 잘되는 알고리즘인 'adam'을 사용합니다.loss설정

- 출력층 activation이

sigmoid인 경우:binary_crossentropy - 출력층 activation이

softmax인 경우:- 원핫인코딩(O):

categorical_crossentropy - 원핫인코딩(X):

sparse_categorical_crossentropy)

- 원핫인코딩(O):

metrics를 'acc' 혹은 'accuracy'로 지정하면, 학습시 정확도를 모니터링 할 수 있습니다.

전처리 단계에서 one-hot encoding 을 해주었습니다. 따라서, categorical_crossentropy를 지정해주면 됩니다.

model.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['acc'])ModelCheckpoint: 체크포인트 생성

val_loss 기준으로 epoch 마다 최적의 모델을 저장하기 위하여, ModelCheckpoint를 만듭니다.

checkpoint_path는 모델이 저장될 파일 명을 설정합니다.ModelCheckpoint을 선언하고, 적절한 옵션 값을 지정합니다.

checkpoint_path = "my_checkpoint.ckpt"

checkpoint = ModelCheckpoint(filepath=checkpoint_path,

save_weights_only=True,

save_best_only=True,

monitor='val_loss',

verbose=1)5. 학습 (fit)

validation_data를 반드시 지정합니다.epochs을 적절하게 지정합니다.callbacks에 바로 위에서 만든 checkpoint를 지정합니다.

history = model.fit(train_data,

validation_data=(valid_data),

epochs=20,

callbacks=[checkpoint],

)학습 완료 후 Load Weights (ModelCheckpoint)

학습이 완료된 후에는 반드시 load_weights를 해주어야 합니다.

그렇지 않으면, 열심히 ModelCheckpoint를 만든 의미가 없습니다.

# checkpoint 를 저장한 파일명을 입력합니다.

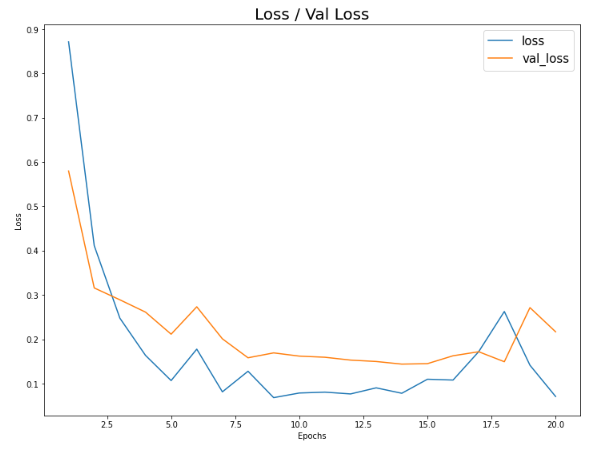

model.load_weights(checkpoint_path)오차 및 정확도 시각화

학습 Loss (오차)에 대한 시각화

import matplotlib.pyplot as plt

plt.figure(figsize=(12, 9))

plt.plot(np.arange(1, 21), history.history['loss'])

plt.plot(np.arange(1, 21), history.history['val_loss'])

plt.title('Loss / Val Loss', fontsize=20)

plt.xlabel('Epochs')

plt.ylabel('Loss')

plt.legend(['loss', 'val_loss'], fontsize=15)

plt.show()

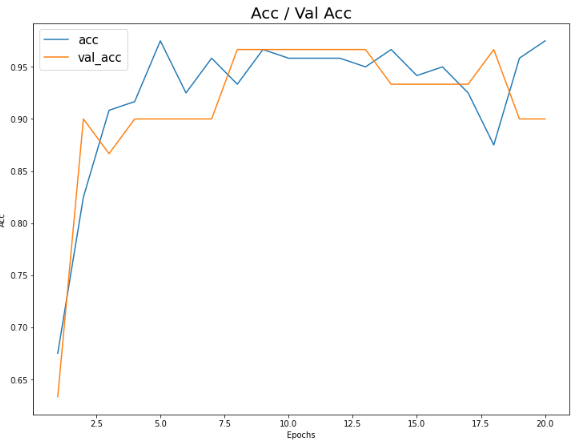

학습 accuracy (정확도)에 대한 시각화

plt.figure(figsize=(12, 9))

plt.plot(np.arange(1, 21), history.history['acc'])

plt.plot(np.arange(1, 21), history.history['val_acc'])

plt.title('Acc / Val Acc', fontsize=20)

plt.xlabel('Epochs')

plt.ylabel('Acc')

plt.legend(['acc', 'val_acc'], fontsize=15)

plt.show()

검증이 하고싶다면..

model.evaluate(x_valid, y_valid)