🧩Tensorflow Certification 취득하기 - part 7. 실전 (Cats vs Dogs transfer learning)

🌕 AI/DL -Tenserflow Certification

Cats vs Dogs transfer learning

VGG16을 이용한 전이학습을 수행합니다.

- Convolution Neural Network (합성곱 신경망)를 활용한 이미지 분류 (Image Classification)

Computer Vision with CNNs

For this exercise you will build a cats v dogs classifier

using the Cats v Dogs dataset from TFDS.

Be sure to use the final layer as shown

(Dense, 2 neurons, softmax activation)

The testing infrastructre will resize all images to 224x224

with 3 bytes of color depth. Make sure your input layer trains

images to that specification, or the tests will fail.

Make sure your output layer is exactly as specified here, or the

tests will fail.

이 연습에서는 cats v dogs 분류기를 만들 것입니다. TFDS의 Cats v Dogs 데이터 세트 사용.

그림과 같이 최종 레이어를 사용하십시오

(Dense, 뉴런 2 개, activation='softmax')

테스트 인프라는 모든 이미지의 크기를 224x224로 조정합니다(컬러사진). 입력 레이어를 확인하십시오

Solution

순서 요약

- import: 필요한 모듈 import

- 전처리: 학습에 필요한 데이터 전처리를 수행합니다.

- 모델링(model): 모델을 정의합니다.

- 컴파일(compile): 모델을 생성합니다.

- 학습 (fit): 모델을 학습시킵니다.

1. import 하기

필요한 모듈을 import 합니다.

import tensorflow_datasets as tfds

import tensorflow as tf

from tensorflow.keras.layers import Dense, Conv2D, MaxPooling2D, Flatten, Dropout

from tensorflow.keras.models import Sequential

from tensorflow.keras.callbacks import ModelCheckpoint

from tensorflow.keras.applications import VGG162.1 전처리 (Load dataset)

tensorflow-datasets를 활용합니다.

시험에서 주어지는 데이터셋 로드 형태

- 예전 방식이므로 아래처러 주어지는 코드를 과감히 삭제 후, 아래 제공되는 방식으로 변경합니다.

setattr(tfds.image_classification.cats_vs_dogs, '_URL',"https://download.microsoft.com/download/3/E/1/3E1C3F21-ECDB-4869-8368-6DEBA77B919F/kagglecatsanddogs_5340.zip")dataset_name = 'cats_vs_dogs'

# 처음 80%의 데이터만 사용

train_dataset = tfds.load(name=dataset_name, split='train[:80%]')

# 최근 20%의 데이터만 사용

valid_dataset = tfds.load(name=dataset_name, split='train[80%:]')2.2 전처리 (Define Folder)

시험에서 요구하는 전처리 요구 조건은 다음과 같습니다.

- 이미지 정규화 (Normalization)

- 이미지 사이즈 맞추기: (224 X 224)

- image(x), label(y)를 분할

def preprocess(data):

# x, y 데이터를 정의합니다.

x = data['image']

y = data['label']

# image 정규화(Normalization)

x = x / 255

# 사이즈를 (224, 224)로 변환합니다.

x = tf.image.resize(x, size=(224, 224))

# x, y 데이터를 return 합니다.

return x, y만든 전처리 함수(preprocessing)를 dataset에 mapping하고, batch_size도 지정합니다.

batch_size=32

train_data = train_dataset.map(preprocess).batch(batch_size)

valid_data = valid_dataset.map(preprocess).batch(batch_size)3. 모델 정의 (Sequential)

이제 Modeling을 할 차례입니다.

Sequential 모델 안에서 층을 깊게 쌓아 올려 주면 됩니다.

input_shape는 224 X 224 컬러사진인 (224, 224, 3)으로 지정합니다.- transfer learning 기법을 통해 VGG16 모델을 활용한 전이학습 모델을 완성합니다.

- 출력층은 class 갯수 2개의 뉴런이 요구됩니다.

transfer_model = VGG16(weights='imagenet', include_top=False, input_shape=(224, 224, 3))

transfer_model.trainable=Falsemodel = Sequential([

transfer_model,

Flatten(),

Dropout(0.5),

Dense(512, activation='relu'),

Dense(128, activation='relu'),

Dense(2, activation='softmax'),

])모델 결과 요약

model.summary()4. 컴파일 (compile)

optimizer는 가장 최적화가 잘되는 알고리즘인 'adam'을 사용합니다.loss설정

- 출력층 activation이

sigmoid인 경우:binary_crossentropy - 출력층 activation이

softmax인 경우:- 원핫인코딩(O):

categorical_crossentropy - 원핫인코딩(X):

sparse_categorical_crossentropy)

- 원핫인코딩(O):

metrics를 'acc' 혹은 'accuracy'로 지정하면, 학습시 정확도를 모니터링 할 수 있습니다.

전처리 단계에서 one-hot encoding 을 해주었습니다. 따라서, categorical_crossentropy를 지정해주면 됩니다.

model.compile(optimizer='adam', loss='sparse_categorical_crossentropy', metrics=['acc'])ModelCheckpoint: 체크포인트 생성

val_loss 기준으로 epoch 마다 최적의 모델을 저장하기 위하여, ModelCheckpoint를 만듭니다.

checkpoint_path는 모델이 저장될 파일 명을 설정합니다.ModelCheckpoint을 선언하고, 적절한 옵션 값을 지정합니다.

checkpoint_path = "my_checkpoint.ckpt"

checkpoint = ModelCheckpoint(filepath=checkpoint_path,

save_weights_only=True,

save_best_only=True,

monitor='val_loss',

verbose=1)5. 학습 (fit)

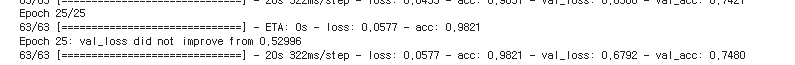

model.fit(train_data,

validation_data=(valid_data),

epochs=20,

callbacks=[checkpoint],

)

학습 완료 후 Load Weights (ModelCheckpoint)

학습이 완료된 후에는 반드시 load_weights를 해주어야 합니다.

그렇지 않으면, 열심히 ModelCheckpoint를 만든 의미가 없습니다.

# checkpoint 를 저장한 파일명을 입력합니다.

model.load_weights(checkpoint_path)