Quantized Side Tuning: Fast and Memory-Efficient Tuning of Quantized Large Language Models (2024)

자연어 논문리뷰

1.0. Abstract

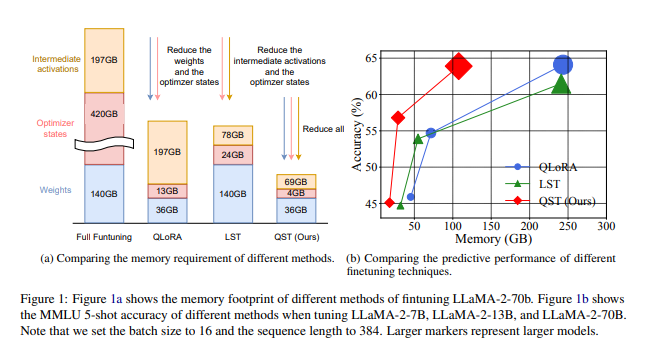

대형 언어 모델(LLM)의 파인튜닝은 다양한 작업에서 효과적인 성능을 발휘하고 있다. 그러나, 파인튜닝 과정에서 모델 가중치, 옵티마이저 상태, 중간 활성값을 저장해야 하므로 막대한 메모리가 필요하다. 기존 기법들은 이를 해결하기 위해 파라미터 효율적 튜닝(PEFT) 또는 메모리 최적화를 도입하지만, 여전히 모든 문제를 동시에 해결하지는 못하고 있다.

이 논문에서는 Quantized Side Tuning (QST)라는 새로운 접근법을 제안한다. QST는 다음과 같은 두 단계로 작동한다:

1. 4비트 양자화: LLM의 모델 가중치를 4비트로 양자화하여 메모리 사용량을 크게 줄인다.

2. 사이드 네트워크: 별도로 설계된 경량 사이드 네트워크를 사용해 작업별 예측을 수행하며, 메인 LLM의 역전파를 방지하여 중간 활성값의 메모리 요구량을 감소시킨다.

QST는 기존 최신 기법 대비 최대 2.3배의 메모리 절감과 3배 빠른 파인튜닝을 제공하며, 성능 저하는 최소화한다.

2.0. Introduction

-

LLM의 발전

최근 GPT, PaLM, OPT와 같은 대형 언어 모델은 다양한 작업에서 뛰어난 일반화 능력을 보여주고 있다. 하지만, LLM의 크기가 기하급수적으로 증가하면서 파인튜닝 과정에서 막대한 메모리와 계산 자원이 필요하다. 예를 들어, 65억 개의 파라미터를 가진 LLaMA 모델을 16비트 환경에서 파인튜닝하려면 780GB 이상의 메모리가 요구된다. 이는 실제 환경에서 적용하기 어렵다는 한계를 드러내고 있다. -

기존 기법의 한계

- Parameter-Efficient Fine-Tuning (PEFT): 기존 PEFT 기법은 일부 파라미터만 업데이트하거나, 새로운 파라미터를 소규모로 도입해 메모리 사용량을 줄이고 있다. 그러나 활성값을 저장해야 하므로, 메모리 최적화 효과는 제한적이며, 훈련 시간 또한 완전한 파인튜닝과 유사한 수준으로 소요된다.

- 양자화 접근법: QLoRA와 같은 방법은 4비트 양자화를 통해 가중치와 옵티마이저 상태의 메모리 사용량을 줄이지만, 중간 활성값 메모리 문제는 해결하지 못하고 있다. 따라서 소규모 배치 크기만 지원하고, 훈련 시간이 길어지는 단점이 있다.

- 사이드 네트워크: Ladder Side Tuning(LST) 등 일부 기법은 사이드 네트워크를 도입하여 중간 활성값 메모리를 줄이고 있다. 하지만 대규모 모델(30억 파라미터 이상)에서는 본질적으로 모델 크기가 커서 적용이 어려운 상황이다.

-

QST의 차별점

QST는 위 문제를 해결하기 위해 설계되었다. 모델 가중치를 4비트로 양자화하고, 메인 LLM과 분리된 경량 사이드 네트워크를 사용해 작업별 예측을 수행하며, LLM의 역전파를 방지한다. 이를 통해 활성값 메모리와 훈련 시간 문제를 동시에 해결한다. 실험 결과, QST는 훈련 속도를 3배 향상시키고, 메모리 사용량은 최대 7배까지 절감하며, 성능은 기존 최신 기술과 유사한 수준을 유지하는 것으로 확인되었다.

💡 중간 활성화 (Intermediate Activations)란?

정의

중간 활성화란 딥러닝 모델이 입력 데이터를 처리하는 동안 각 레이어를 통과할 때 생성되는 중간 결과값(활성화값)을 의미한다. 이러한 값은 다음 레이어로 전달되어 계산에 사용되며, 역전파(backpropagation) 단계에서도 필수적이다.

역할

순전파 (Forward Pass):

- 중간 활성화는 각 레이어의 출력값으로서, 다음 레이어로 전달되어 계산의 기초가 된다.

- 예: (여기서 는 i번째 레이어의 입력, 는 가중치, 는 활성화 함수)

역전파 (Backward Pass):

- 손실 함수의 기울기를 계산하기 위해 중간 활성화값을 저장한다.

- 저장된 값은 파라미터 업데이트에 중요한 역할을 한다.

문제점

- 메모리 부담:

딥러닝 모델이 클수록 레이어마다 생성되는 중간 활성화값의 크기가 증가하여 메모리 사용량이 급증한다.

예: LLM(대형 언어 모델)에서 긴 시퀀스와 큰 배치 크기는 중간 활성화값이 매우 커지게 한다.- 훈련 속도 저하:

중간 활성화값을 저장하고 불러오는 작업은 훈련 속도를 저하시킬 수 있다.

2.0. 파라미터 효율적 파인튜닝 (Parameter-Efficient Fine-Tuning, PEFT)

2.1 개요

PEFT는 대형 언어 모델(LLM)의 전체 파라미터를 업데이트하지 않고, 일부 파라미터만 학습하거나 새로운 파라미터를 소규모로 도입하는 방식으로 메모리와 계산 효율성을 높인다.

이 접근법은 빠른 적응과 더불어 "망각(catastrophic forgetting)"을 방지하는 데 유리하다.

2.2 주요 기법들

- Adapter (Houlsby et al., 2019):

- LLM의 트랜스포머 레이어 내부에 작은 네트워크(어댑터 모듈)를 삽입해 작업별 파라미터를 학습한다.

- LoRA (Low-Rank Adaptation, Hu et al., 2021):

- 낮은 계층의 파라미터 분해를 통해 LLM의 기존 가중치에 소규모 파라미터를 추가로 학습한다.

- 높은 성능과 낮은 메모리 사용량을 모두 달성한 대표적인 기법이다.

- Prompt Tuning (Lester et al., 2021):

- 모델의 입력 텍스트에 학습 가능한 임베딩을 추가하여 원본 LLM의 파라미터를 유지하면서 작업별 튜닝을 수행한다.

2.3 한계

- PEFT 기법들은 활성값(Intermediate Activations)을 저장해야 하며, 이는 메모리 사용량의 70% 이상을 차지한다.

- 배치 크기와 시퀀스 길이가 길어지면 메모리 절감 효과가 제한적이다.

3.0. 메모리 효율적 훈련 및 파인튜닝 (Memory-Efficient Training and Fine-Tuning)

3.1 주요 접근법

-

Gradient Checkpointing (Chen et al., 2016):

- 중간 활성값을 저장하지 않고, 필요 시 다시 계산함으로써 메모리 사용량을 절감한다.

- 계산 비용이 증가하는 단점이 있다.

-

Reversible Neural Networks (Gomez et al., 2017):

- 레이어의 출력값을 저장하지 않고, 다음 레이어의 입력값으로 복원해 메모리를 줄이는 기법이다.

-

네트워크 압축 (Network Compression):

- 프루닝(Pruning): 중요하지 않은 파라미터를 제거하여 모델을 간소화한다.

- 지식 증류(Distillation): 대형 모델의 지식을 소형 모델로 이전하여 메모리와 계산량을 줄인다.

3.2 한계

- 네트워크 압축은 주로 추론 속도 최적화에 중점을 둔다.

- 훈련 중 메모리 최적화에는 한계가 있다.

4.0. 기존 기법들의 융합 시도

4.1 QLoRA (Dettmers et al., 2023)

QLoRA는 LLM의 가중치를 4비트로 양자화하고, LoRA를 적용해 튜닝을 수행하는 기법이다.

- 장점: 가중치와 옵티마이저 상태의 메모리 사용량을 크게 줄인다.

- 한계: 중간 활성값 메모리 문제를 해결하지 못해, 소규모 배치 크기(예: 1)만 지원하며 훈련 시간이 길어진다.

4.2 사이드 네트워크 기법

- LST(Ladder Side Tuning, Sung et al., 2022):

사이드 네트워크를 활용해 중간 활성값의 역전파(backpropagation)를 방지, 메모리 사용량을 줄인다.- 한계: 작은 모델(30억 파라미터 이하)에만 적용 가능하다.

5. Quantized Side Tuning(QST)의 필요성

위의 기법들은 각자 일부 문제를 해결하고 있지만, 다음과 같은 한계가 있다:

- 모든 메모리 사용 요인(가중치, 활성값, 옵티마이저 상태)을 동시에 줄이지 못함.

- 대규모 모델에서는 여전히 적용 범위가 제한적임.

QST는 이 모든 문제를 해결하기 위해 설계되었으며, 메모리 효율적 훈련을 위한 새로운 표준을 제시한다.

6.0. Quantized Side Tuning (QST)의 구조 설명

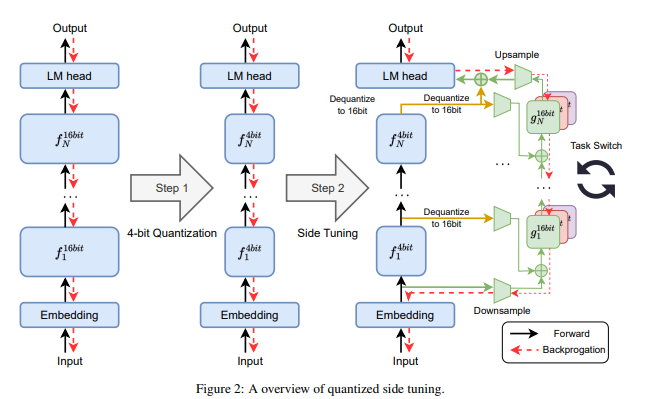

Figure 2는 QST의 이중 단계(Dual-Stage) 튜닝 구조를 시각적으로 설명한 그림이다.

QST는 대형 언어 모델(LLM)을 효율적으로 튜닝하기 위해 다음 두 가지 주요 단계를 거친다:

1. 4비트 양자화 (4-bit Quantization): 모델 가중치를 4비트로 변환하여 메모리 사용량을 줄인다.

2. 사이드 튜닝 (Side Tuning): 경량화된 사이드 네트워크를 도입해 작업별 튜닝을 수행하며, 중간 활성값 메모리를 줄인다.

7. 단계별 구조 설명

1단계: 4비트 양자화 (Step 1: 4-bit Quantization)

-

가중치 양자화:

- LLM의 가중치 를 4비트 데이터 타입으로 양자화하여 메모리를 절감한다.

- 양자화는 다음과 같은 수식을 따른다:

여기서 는 4비트 데이터의 최대값이며, 는 입력 텐서의 절댓값 최대값이다.

-

디양자화 (Dequantization):

- 양자화된 데이터를 복원하여 계산 정확도를 유지한다:

여기서 는 양자화 스케일(quantization scale)이다.

- 양자화된 데이터를 복원하여 계산 정확도를 유지한다:

-

효과:

- 이 단계는 모델 가중치 저장에 필요한 메모리를 크게 줄이며, 훈련 중에도 빠른 계산이 가능하도록 한다.

2단계: 사이드 튜닝 (Step 2: Side Tuning)

-

사이드 네트워크 구조:

- 사이드 네트워크 는 메인 LLM 와 분리된 경량 구조로 설계되며, 작업별 튜닝을 수행한다.

- 각 레이어의 입력값은 다음과 같이 결합된다:

여기서:- 는 메인 LLM의 번째 레이어 출력(디양자화된 값).

- 는 차원 축소를 수행하는 모듈.

- 는 학습 가능한 게이트 파라미터.

-

다운샘플링 모듈:

- 입력 차원을 축소하여 메모리 사용량을 절감한다.

- 다양한 방법이 사용될 수 있으며, 대표적으로:

- LoRA: 가중치 행렬의 저랭크 분해를 활용하여 효율적인 차원 축소 수행.

- Adapter: LoRA와 유사하지만, 비선형 활성화를 포함하여 더 복잡한 변환 수행.

- MaxPooling 및 AvgPooling: 훈련 가능한 파라미터 없이 단순히 차원을 축소.

-

출력 결합:

- 사이드 네트워크와 메인 LLM의 출력을 가중합하여 최종 예측을 수행한다:

여기서 는 학습 가능한 파라미터로, 초기값은 로 설정하여 메인 LLM의 출력 비중을 높인다.

- 사이드 네트워크와 메인 LLM의 출력을 가중합하여 최종 예측을 수행한다:

8. QST의 주요 특징

-

메모리 최적화:

- 4비트 양자화를 통해 가중치 메모리 사용량을 크게 줄인다.

- 사이드 네트워크는 활성값 저장을 방지하여 중간 활성값의 메모리 부담을 줄인다. ( 메인 LLM을 오차역전파의 대상에서 제외시킴 -> 측면 network만 학습하여 메모리 부담을 줄인 것이다! )

-

효율적인 학습:

- 메인 LLM의 역전파를 제거하고, 경량 사이드 네트워크만 학습하므로 계산량이 감소한다.

- 이는 훈련 속도를 크게 향상시키는 데 기여한다.

-

작업 전환의 유연성:

- LLM의 구조를 변경하지 않고 사이드 네트워크만 업데이트하여 다양한 작업에 신속히 적응 가능하다.

9. QST의 기존 기법 대비 장점

Figure 2는 QST가 기존 QLoRA 및 LST 기법들과 비교해 다음과 같은 차별점을 가진다는 점을 강조한다:

- QLoRA: 가중치 양자화는 효과적이지만, 활성값 메모리 문제는 여전히 해결하지 못함.

- LST: 활성값 메모리는 줄이지만, 가중치 양자화를 결합하지 않아 대규모 모델 적용에 한계가 있음.

- QST: 가중치, 활성값, 옵티마이저 상태를 모두 줄이며, 훈련 시간과 메모리 사용량 사이의 균형을 최적화함.

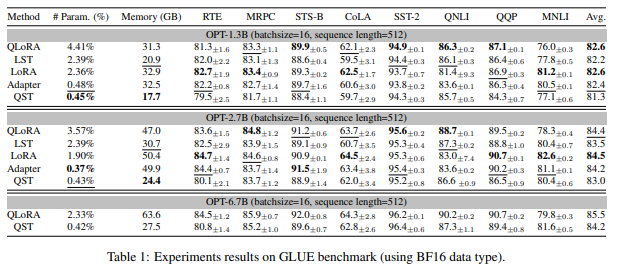

10. Table 1: GLUE 벤치마크 실험 결과 분석

Table 1은 QST와 기존 파라미터 효율적 파인튜닝 기법(QLoRA, LST, LoRA, Adapter)을 비교한 GLUE 벤치마크 실험 결과를 보여준다.

- GLUE 벤치마크: 자연어 이해(NLU) 작업의 성능 평가를 위해 사용되며, 여러 작업에서 모델의 정확도를 측정한다.

- 모델 크기별로 OPT 시리즈(1.3B, 2.7B, 6.7B)를 실험에 사용하였다.

- 비교 기준:

- 학습 가능한 파라미터 수 비율 (%)

- 메모리 사용량 (GB)

- 정확도 (Accuracy)

1) OPT-1.3B (1.3억 파라미터 모델)

-

QST의 성능:

- 학습 가능한 파라미터 비율: 0.45%로 가장 적음.

- 메모리 사용량: 17.7GB로 모든 방법 중 가장 적음.

- 평균 정확도: 81.3%, LST와 비슷하지만 다른 기법보다 약간 낮음.

-

비교:

- QLoRA는 4.41%의 파라미터와 31.3GB 메모리를 사용하면서 82.6% 정확도를 달성.

- LST는 QST보다 약간 높은 정확도(82.2%)를 보였지만, 메모리 사용량이 더 높음(20.9GB).

- LoRA와 Adapter는 메모리 사용량이 QST보다 2배 가까이 많음(각각 32.9GB, 32.5GB).

2) OPT-2.7B (2.7억 파라미터 모델)

-

QST의 성능:

- 학습 가능한 파라미터 비율: 0.43%, 여전히 가장 적음.

- 메모리 사용량: 24.4GB, 모든 방법 중 가장 낮음.

- 평균 정확도: 83.0%, 기존 기법과 유사한 수준.

-

비교:

- QLoRA는 메모리 사용량이 47GB로 QST의 2배에 달하며, 정확도는 약간 높음(84.4%).

- LST는 QST와 비슷한 메모리 절감 효과를 보였지만, 정확도는 다소 낮음(83.5%).

3) OPT-6.7B (6.7억 파라미터 모델)

-

QST의 성능:

- 학습 가능한 파라미터 비율: 0.42%, 가장 적음.

- 메모리 사용량: 27.5GB, QLoRA 대비 2.3배 감소.

- 평균 정확도: 84.2%, QLoRA보다 약간 낮음(85.5%).

-

비교:

- LoRA, Adapter, LST는 OPT-6.7B 크기에서는 메모리 사용량이 과도하게 높아 실질적인 비교가 어려움.

- QLoRA는 QST보다 높은 정확도(85.5%)를 달성했지만, 메모리 사용량이 63.6GB로 매우 높음.

11. 분석 및 QST의 장점

1) 메모리 효율성:

QST는 모든 실험에서 메모리 사용량이 가장 낮다.

- 특히, OPT-6.7B에서 QST는 QLoRA 대비 2.3배 적은 메모리를 사용하면서도 유사한 성능을 보여준다.

2) 학습 가능한 파라미터 수:

QST는 학습 가능한 파라미터 비율이 0.42~0.45%로, 다른 기법들보다 훨씬 적다.

- 이는 훈련 중 메모리 요구와 계산량을 크게 줄이는 데 기여한다.

3) 정확도:

QST의 정확도는 기존 기법들과 비교해 경쟁력 있는 수준을 유지한다.

- 소형 모델(OPT-1.3B)에서는 약간의 성능 저하가 있지만, 중대형 모델(OPT-2.7B, OPT-6.7B)에서는 기존 기법들과 유사하거나 근접한 정확도를 달성한다.

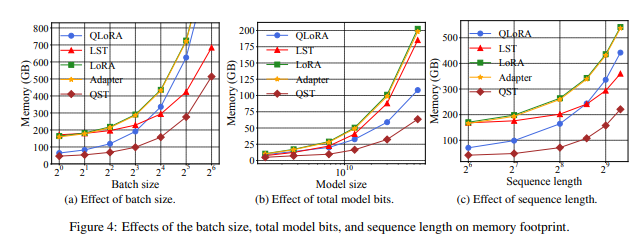

12. Figure 4

Figure 4는 배치 크기, 모델 크기, 시퀀스 길이가 메모리 사용량에 미치는 영향을 시각적으로 나타낸다.

이를 통해 QST와 기존 기법(QLoRA, LST, LoRA, Adapter) 간의 메모리 효율성을 비교할 수 있다.

1. 배치 크기의 영향 (Figure 4a)

실험 조건:

- LLaMA-2-70B 모델을 사용하며, 시퀀스 길이는 512로 고정.

- 배치 크기를 4에서 24까지 변화시켜 메모리 사용량을 측정.

결과 분석:

-

QST의 성능:

- 모든 배치 크기에서 가장 낮은 메모리 사용량을 기록.

- 배치 크기가 증가할수록 QST의 메모리 증가율은 다른 기법보다 더 완만하다.

- 배치 크기 24에서 QST의 메모리 사용량은 약 200GB, QLoRA의 약 600GB 대비 3배 이상 효율적이다.

-

기존 기법들과 비교:

- QLoRA: 배치 크기 증가에 따라 메모리 사용량이 급격히 증가.

- LST: QST와 유사하게 중간 활성값의 메모리를 줄이지만, 가중치 양자화가 없어 QST보다 메모리 사용량이 높다.

- LoRA 및 Adapter: 배치 크기에 따라 가장 빠르게 메모리 사용량이 증가하며, 대규모 배치에서는 비효율적이다.

2. 모델 크기의 영향 (Figure 4b)

실험 조건:

- OPT 모델 시리즈(1.3B부터 66B까지)를 사용하며, 배치 크기는 4로 고정.

결과 분석:

-

QST의 성능:

- 모델 크기가 증가할수록 QST는 메모리 사용량 증가를 최소화한다.

- OPT-66B 모델에서 QST의 메모리 사용량은 약 150GB로, QLoRA(약 300GB) 대비 2배 효율적이다.

-

기존 기법들과 비교:

- QLoRA: 모델 크기가 커질수록 메모리 사용량이 증가하지만, 4비트 양자화 덕분에 LoRA나 Adapter보다 효율적이다.

- LST: QST보다 비효율적이며, 메모리 사용량이 모델 크기에 따라 더 급격히 증가한다.

- LoRA 및 Adapter: OPT-30B 이상 모델에서는 메모리 사용량이 과도해져 실질적으로 적용이 어렵다.

3. 시퀀스 길이의 영향 (Figure 4c)

실험 조건:

- LLaMA-2-70B 모델을 사용하며, 배치 크기는 4로 고정.

- 시퀀스 길이를 128에서 1024까지 변화시키며 메모리 사용량을 측정.

결과 분석:

-

QST의 성능:

- 모든 시퀀스 길이에서 가장 낮은 메모리 사용량을 기록.

- 시퀀스 길이 1024에서 QST의 메모리 사용량은 약 400GB, QLoRA(약 600GB) 대비 33% 절감.

- 시퀀스 길이 증가에 따른 메모리 사용량 증가율이 가장 낮다.

-

기존 기법들과 비교:

- QLoRA: 시퀀스 길이가 증가함에 따라 중간 활성값 메모리 사용량이 크게 늘어나며, QST 대비 비효율적이다.

- LST: QST와 유사하게 활성값 메모리를 줄이지만, QST의 4비트 양자화와 최적화된 다운샘플링 모듈로 인해 여전히 QST가 더 효율적이다.

- LoRA 및 Adapter: 시퀀스 길이가 길어질수록 메모리 사용량이 급격히 증가하며, 대규모 시퀀스 환경에서는 적합하지 않다.

4. 결론 및 QST의 장점

-

효율적인 메모리 관리:

- QST는 배치 크기, 모델 크기, 시퀀스 길이가 증가하더라도 메모리 사용량 증가를 최소화한다.

- 이는 4비트 양자화와 경량 사이드 네트워크가 효과적으로 결합된 결과다.

-

대규모 작업에서의 우수성:

- 대규모 배치, 긴 시퀀스 길이, 대형 모델에서 QST는 기존 기법 대비 압도적으로 효율적이며, 실질적인 훈련 적용 가능성을 보여준다.

-

기존 기법 대비 차별성:

- QLoRA는 가중치 양자화로 일부 메모리를 절감하지만, 중간 활성값 메모리 문제는 여전히 존재.

- LST는 활성값 메모리를 줄이지만, 가중치 양자화가 없어 QST만큼 효율적이지 않다.

- QST는 가중치, 활성값, 옵티마이저 상태 메모리를 모두 줄이는 완전한 솔루션을 제공한다.

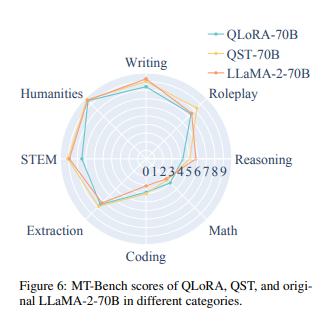

13. Figure 6: MT-Bench 점수 비교

Figure 6은 MT-Bench를 활용하여 QST, QLoRA, 그리고 원본 LLaMA-2-70B 모델의 성능을 평가한 결과를 보여준다.

MT-Bench는 다양한 카테고리에서 다중 턴 대화 성능을 측정하는 벤치마크로, 다음 8가지 카테고리에서 모델 성능을 평가한다:

- Writing (글쓰기), Roleplay (역할 수행), Reasoning (추론), Math (수학), Coding (코딩), Extraction (추출), STEM, Humanities (인문학)

1. 주요 결과 요약

1) 전반적인 성능 비교

- QST는 전체 평균 점수에서 7.07점을 기록하며, 원본 LLaMA-2-70B(6.86점)와 QLoRA(6.61점)보다 높은 점수를 달성하였다.

- 이는 QST가 메모리 효율적 튜닝을 통해 성능 저하 없이 모델을 개선했음을 보여준다.

2) 카테고리별 성능 분석

(1) QST가 우수한 카테고리

-

STEM (과학/기술/공학/수학):

- QST는 QLoRA 및 LLaMA-2-70B를 모두 능가하며 가장 높은 점수를 기록.

- 과학적 문제 해결 및 기술적 질문에 강점을 보임.

-

Extraction (추출):

- 텍스트에서 필요한 정보를 정확히 추출하는 작업에서 가장 높은 점수를 획득.

-

Coding (코딩):

- 코드 생성 및 문제 해결 성능에서 QST가 우위를 점함.

- QLoRA와 비교해 코드 일관성 및 정확도 면에서 더 나은 성과를 보임.

-

Roleplay (역할 수행):

- 다양한 대화 맥락에서의 역할 수행 능력이 뛰어나며, 다른 모델보다 더 자연스러운 대화를 생성.

(2) 유사한 성능을 보인 카테고리

- Humanities (인문학):

- 세 모델 모두 유사한 성능을 보이며, 큰 차이가 나타나지 않음.

- 이 카테고리는 모델 간 차별화가 어려운 작업 특성이 있을 수 있음.

(3) QST가 열세인 카테고리

-

Reasoning (추론):

- QLoRA가 QST 및 LLaMA-2-70B보다 높은 점수를 기록.

- 복잡한 논리적 문제나 심층적 추론 작업에서 QST가 약간의 성능 열세를 보임.

-

Writing (글쓰기):

- 글쓰기 작업에서 QLoRA가 가장 높은 점수를 기록하며, QST는 다소 낮은 성능을 보임.

-

Math (수학):

- 원본 LLaMA-2-70B가 가장 높은 점수를 기록.

- QST는 수학 문제 해결에서 상대적으로 낮은 성능을 보였다.

14. 결론 및 QST의 장점

-

전반적인 우수성:

- QST는 평균 점수에서 원본 모델과 QLoRA를 모두 능가하며, 특히 STEM, 추출, 코딩, 역할 수행 작업에서 뛰어난 성능을 보인다.

- 이는 QST의 효율적인 파라미터 튜닝과 4비트 양자화가 모델 성능을 저하시키지 않음을 증명한다.

-

특정 작업에서의 개선 가능성:

- 글쓰기, 논리적 추론, 수학 작업에서 QST의 성능은 다른 기법에 비해 약간 뒤처질 수 있다.

- 이러한 작업에서는 모델 구조 및 사이드 네트워크의 조정을 통해 추가적인 성능 향상이 가능할 것으로 보인다.

-

실용적 이점:

- 이 논문에서 QST는 성능과 메모리 효율성을 모두 만족시켜, 대규모 작업에서 매우 적합한 선택지로 자리 잡는다는 내용을 말한다.