기본 용어

Xij

- jth feature of ith Sample

벡터의 내적

- a∙b=aTb=∑K=I,Dakbk

y^i

벡터의 p차 Norm

- 벡터의 길이 혹은 크기를 측정하는 방법/함수

- Norm이 측정한 벡터의 크기는 원점에서 벡터 좌표까지의 거리 혹은 Magnitude라고 한다.

- ∣∣X∣∣p=(∑i=1,d∣xi∣p)1/p

- p는 Norm의 차수를 의미하며 p가 1이면 1차 Norm, 2이면 2차 Norm이라고 한다.

- 주로 사용되는 Norm은 1차 Norm, 2차 Norm, Maxium Norm이다.

L1 Norm

- 1차놈이며 Tacxicab Norm, Manhattan Norm이라고도 한다.

- 벡터의 요소에 대한 절댓값의 합이며 요소의 값 변화를 정확하게 파악할 수 있다.

L2 Norm

- 2차놈이며 n차원 좌표평면(유클리드 공간)에서 벡터의 크기를 계산하기 때문에 Euclidean Norm이라고도 한다.

벡터의 표현

X = ⎣⎢⎢⎢⎡12..1x1x2..xnx12x22..xn2x13x23..xn3⎦⎥⎥⎥⎤ 이라고 하면

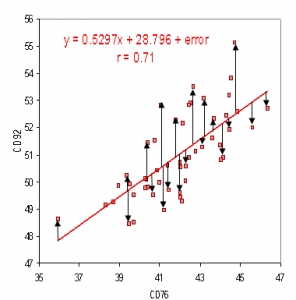

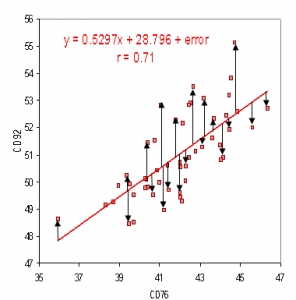

y^=Xw와 같이 선형으로 나타내거나 y^i = w1 + w2xi + w3xi3 + w4xi3와 같이 비선형/ Cubic polynomial 형태로 나타낼 수 있다.

- y^i=w0+w1x1+..+wpxip로 표현할 수 있으며 w0은 offset을 지칭한다.

- W는 가중치 행렬을 의미하며 위의 식은 <W,xi>or<xi,W>로 표현될 수 있다.

Residual

- 잔차이며 결과의 오류 값이다.

- Residual ri는 True value를 y라고 할 때 y−y^i or ri(w)=yi−y^i(w)로 표현된다.

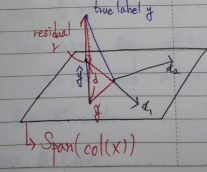

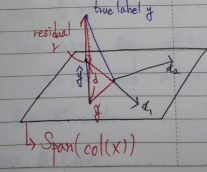

- Span은 구성 벡터들로 형성할 수 있는 공간을 의미한다.

- y^는 벡터 x1,x2가 span한 공간에서 y와 가장 가까운 점에 projection한 점을 뜻한다.

Machine Learning의 목적

- 잔차의 최소화

- w^=argminw∣∣r(w)∣∣2

- 2번째 그림과 같이 ∣∣r^∣∣=∣∣r∣∣2+∣∣d∣∣2로 표현할 수 있으며 좌표 공간의 거리를 구하기 위하여 2차 Norm을 사용한다.

- d가 최소화될 수록 잔차 r도 감소하며 따라서 유클리드 거리 중 최소거리를 찾는 과정

Least Squares Estimations

- Euclidean Norm을 이용하여 거리를 구하고 제곱의 값으로 잔차를 판별한다.

제곱 사용의 이점

- 양수와 음수 모두 같은 결과로써 사용할 수 있다.

- 수학적으로 계산이 쉬워진다.

- 큰 error일수록 그 차이를 증가시킨다.

- 기하학적으로 표현하기 쉬워진다.

- Gaussizn noise model과 양립가능하다.

w^ 식 도출

적용 이론

선형독립

- 벡터 v1,v2,...,vn이 있을 때 모든 계수가 0인 경우를 제외하고 어떤 선형조합으로도 0을 만들 수 없다면 독립

Rank

- 행렬의 열들 중 선형독립인 열들의 최대 개수

- 행과 열의 Rank는 항상 독립적이다.

- rank(A)=rank(ATA)=rank(AAT)

Full Rank

- 한 열이나 행에서 전부 다 선형독립인 벡터기저들을 가진 경우

- rank(X) = min(n, p)

inverse

- 행렬이 full rank일 때만 역행력을 가진다.

- X∈Rn∗p assume that n >= p, rank(X) = p

- X가 Full rank라면 역행렬의 가짐을 의미한다.

식 도출

- ML은 w^=argminw∣∣r(w)∣∣2의 값을 구하기 위해 실행된다.

- r^=y−y^로 표현되기에 y−Xw^로 표현될 수 있으며 양변에 XT를 곱해주면 XTr^=XT(y−Xw^) 로 식이 정리된다.

- XTr^=XT(y−Xw^)에서 2번째 그림과 같이 X와 r은 orthogonal이므로 0의 값을 가진다. 따라서 XTr^=XT(y−Xw^)=0

- 식을 정리하면 XTy=XTXw^

- 적용 이론에서 X가 Full rank를 가진다고 가정하면 양변에 역행렬을 취함으로써 w^=(XTX)−1XTy의 식이 도출된다.

w^=(XTX)−1XTy