나는 나만의 아이디어를 활용하여, Upstage에서 제공하는 LLM 모델을 사용하여 2가지 n8n Workflow를 제작해 보았다.

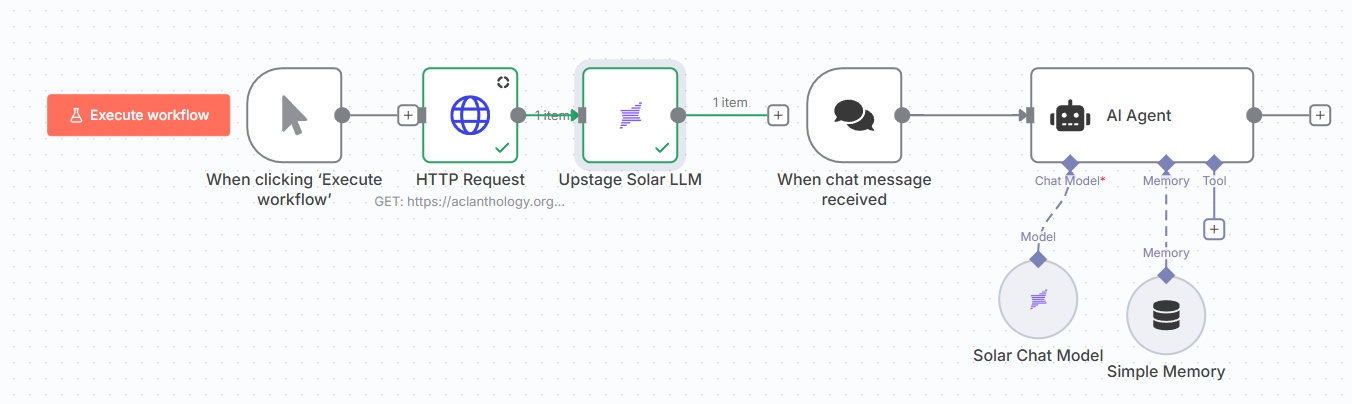

- HTTP Request로 Open Access로되어있는 논문 PDF를 받아 이에 대한 내용을 Upstage Solar LLM에게 질의응답이 가능한 워크플로우

- Solar Chat Model을 활용한 simple Question & Answering Chatting AI Agent

내가 이를 어떻게 만들었는지 처음부터 단계적으로 설명하도록 하겠다.

n8n 설치

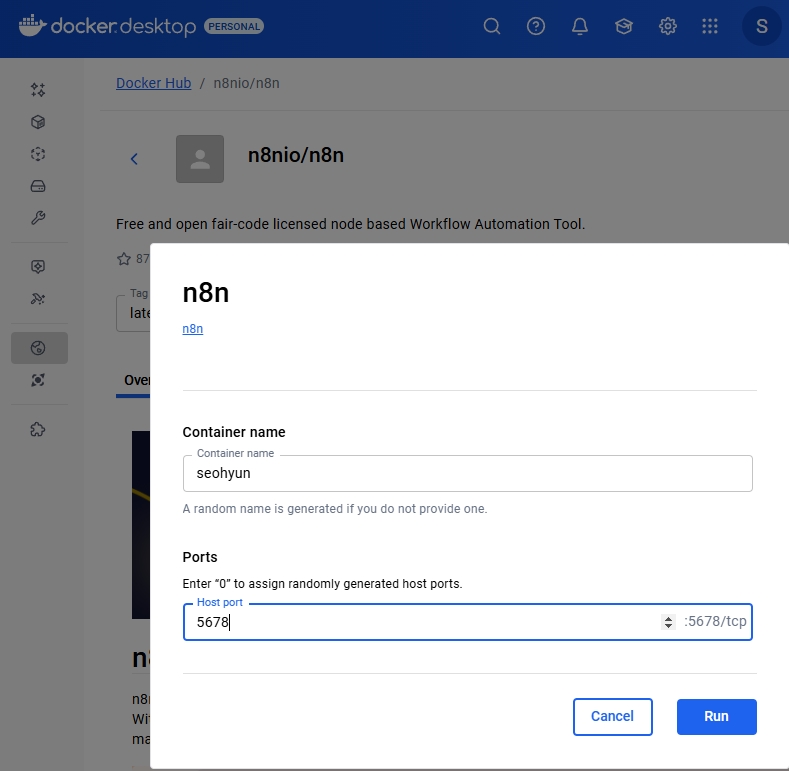

먼저 n8n을 실행하여야 한다. NPX를 이용한 간단한 설치, Node.js만 설치되어 있다면 몇분만에 실행할 수 있는 가장 간단한 방법, Docker를 이용한 설치, 크게 방법이 2가지 있는데 이중 나는 Docker로 이미지를 pull한뒤, 이를 실행하였다.

Container name은 내 마음대로 지정하면 된다. 나는 "seohyun"으로 지정하였고 아래 Run을 클릭하여 다음 단계로 진행하였다.

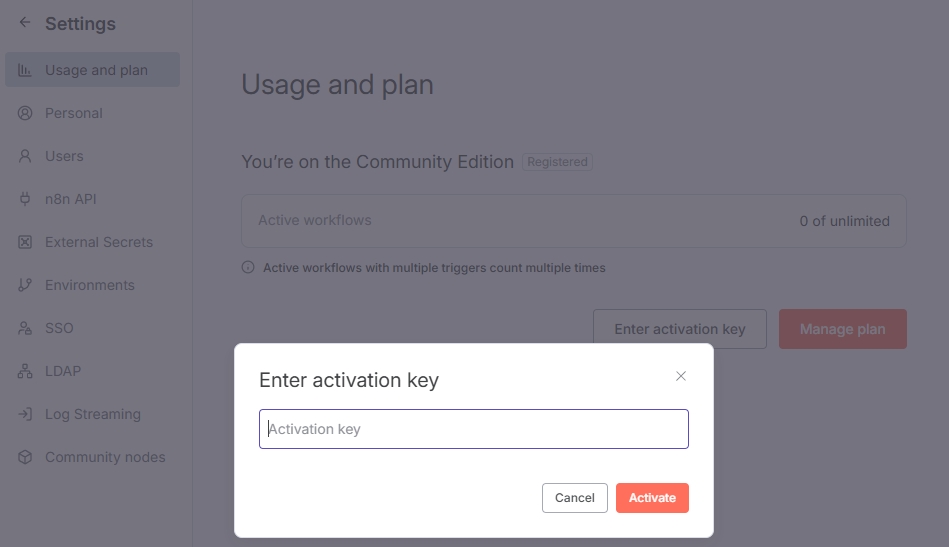

이렇게 되면, 이제 local에서 실행이 가능한 상태가 되어 다음 작업을 할 수 있게 된다. n8n을 처음 접속하는 이용자라면, 관리자 설정 및 license를 활성화해야 한다. 즉, 이름, 이메일, 비밀번호를 사용하여 관리자 계정을 생성하는 초기 admin setting을 해야하고, license key를 요청하여 이를 activation key에 입력해야 n8n의 모든 기능을 자유롭게 사용할 수 있다.

Upstage API 사용법

Upstage API를 사용하는 방법도 2가지가 있는데, 하나는 HTTP Request 방식, 두번째는 Community Node 방식이다. 첫번째 HTTP Request 방식은 직접 API를 호출하고, 세밀한 제어가 가능하다는 장점이 있지만, 복잡한 설정이 필요하다는 단점이 있다. Community Node 방식으로는 API key 관리를 자동화하는 Credential, 최적모델 사전 선택, 검증된 기본값 적용하는 parameter, 오류 처리를 내장할 수 있는 Error Handling의 미리 최적화되어 있는 세팅된 설정 옵션들이 있다. 이는 개발시간을 80% 이상 절약하고, 복잡한 API 문서 학습의 불필요, 즉시 사용 가능한 완성형 도구로서 사용가능하다는 장점이 있다.

나의 경우, n8n community node를 설치하여 Upstage API를 사용하였다.

위와 같은 창이 떳다면, Community node가 최종적으로 설치되었다는 의미이고, 이제 Upstage에서 제공하는 모든 제품들을 n8n에서 활용할 수 있게 된다.

1. PDF Q&A Workflow

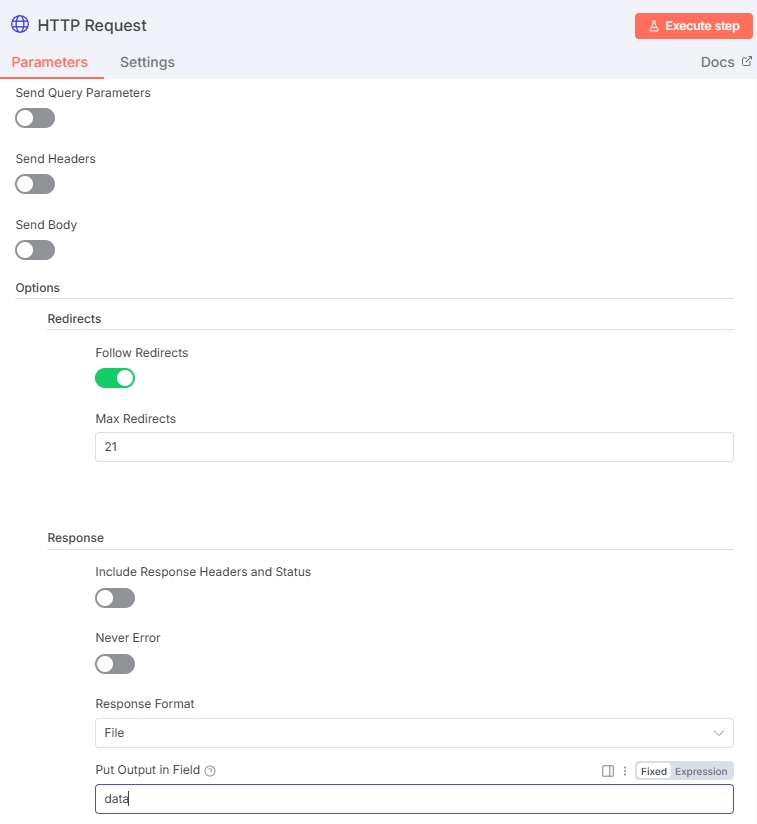

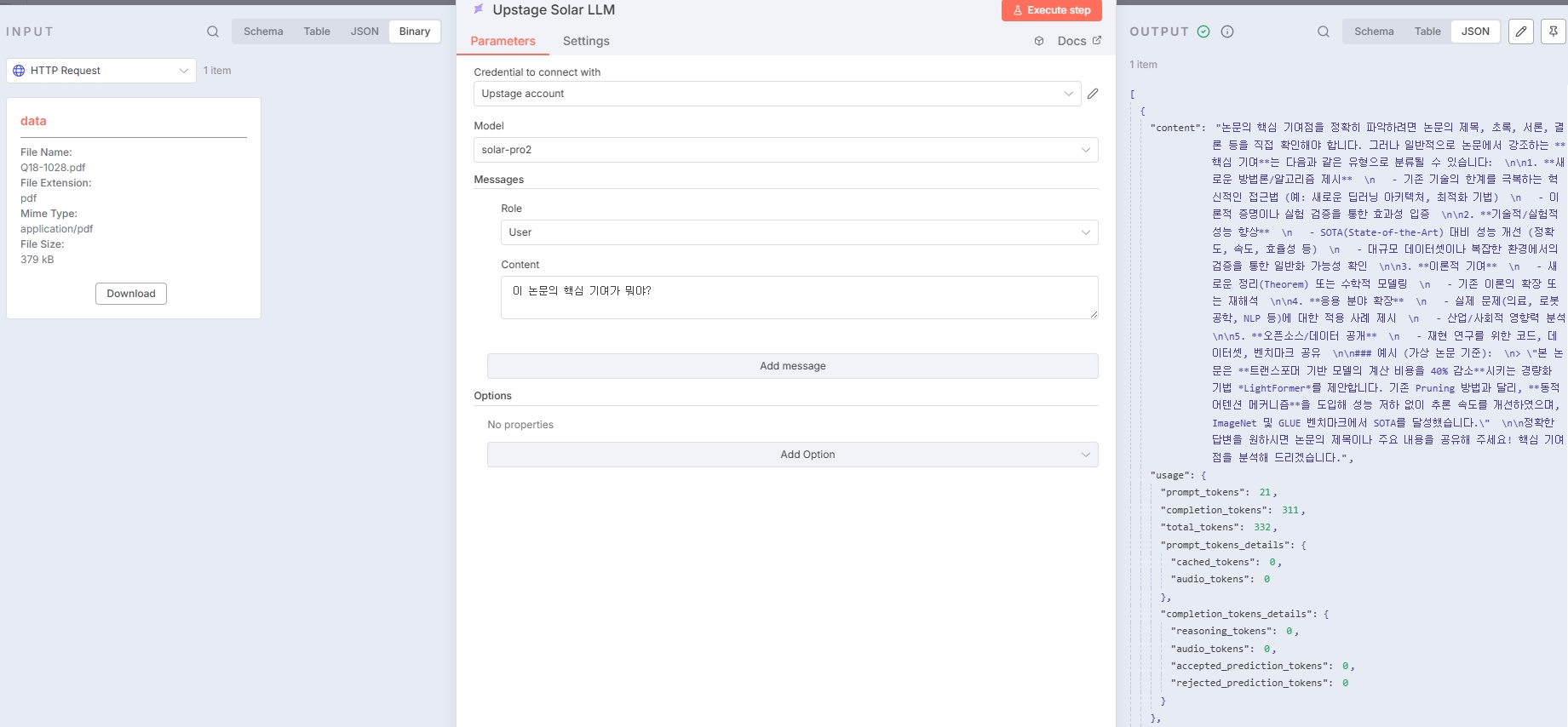

앞서 설명했듯이, 나는 2가지의 workflow를 제작해 보았다. 먼저, 첫번째 워크플로는 HTTP Request를 사용해 .pdf 형식의 파일을 받아 Solar LLM에게 질문하여 이에대한 답변을 받는 것이다. HTTP Request는 restapi 기능을 제공한다.  위에 보이는 사진은 HTTP Request node의 parameters 설정 모습이다. 나는 Web에서 공개되어 있는 .pdf 파일확장자를 HTTP의 GET Method를 사용해서 "file"로 불러왔다.

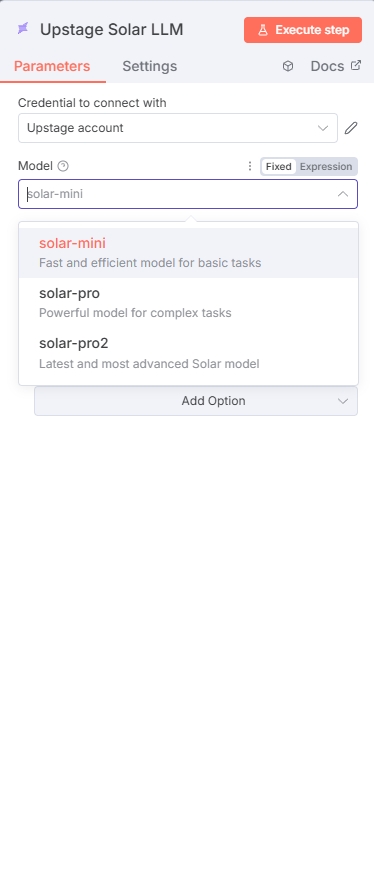

위에 보이는 사진은 HTTP Request node의 parameters 설정 모습이다. 나는 Web에서 공개되어 있는 .pdf 파일확장자를 HTTP의 GET Method를 사용해서 "file"로 불러왔다. Solar LLM model은 위 캡쳐화면에서 보다싶이, solar-mini, solar-pro, solar-pro2 3가지 중에서 하나를 선택하면 되는데, 나는 solar-pro2를 사용하였다. 아래는 해당 워크플로우를 실행한 모습이다. 상단의 INPUT에는 Schema, Table, JSON, Binary 4가지 형식을 선택할 수 있고, 오른쪽에 OUTPUT 출력화면을 보면 Schema, Table, JSON 형태로 결과값을 볼 수 있다. 앞서 내가 언급했듯이, 나는 HTTP Request를 통해서 논문.pdf 형식의 파일을 불러왔기 때문에, Upstage Solar LLM에 "이 논문의 핵심 기여가 뭐야?" 라는 질문을 해보았고 이에 대한 답을 LLM model이 해준 모습이다. 번외로, "Role" 설정 또한 가능하다.

Solar LLM model은 위 캡쳐화면에서 보다싶이, solar-mini, solar-pro, solar-pro2 3가지 중에서 하나를 선택하면 되는데, 나는 solar-pro2를 사용하였다. 아래는 해당 워크플로우를 실행한 모습이다. 상단의 INPUT에는 Schema, Table, JSON, Binary 4가지 형식을 선택할 수 있고, 오른쪽에 OUTPUT 출력화면을 보면 Schema, Table, JSON 형태로 결과값을 볼 수 있다. 앞서 내가 언급했듯이, 나는 HTTP Request를 통해서 논문.pdf 형식의 파일을 불러왔기 때문에, Upstage Solar LLM에 "이 논문의 핵심 기여가 뭐야?" 라는 질문을 해보았고 이에 대한 답을 LLM model이 해준 모습이다. 번외로, "Role" 설정 또한 가능하다.

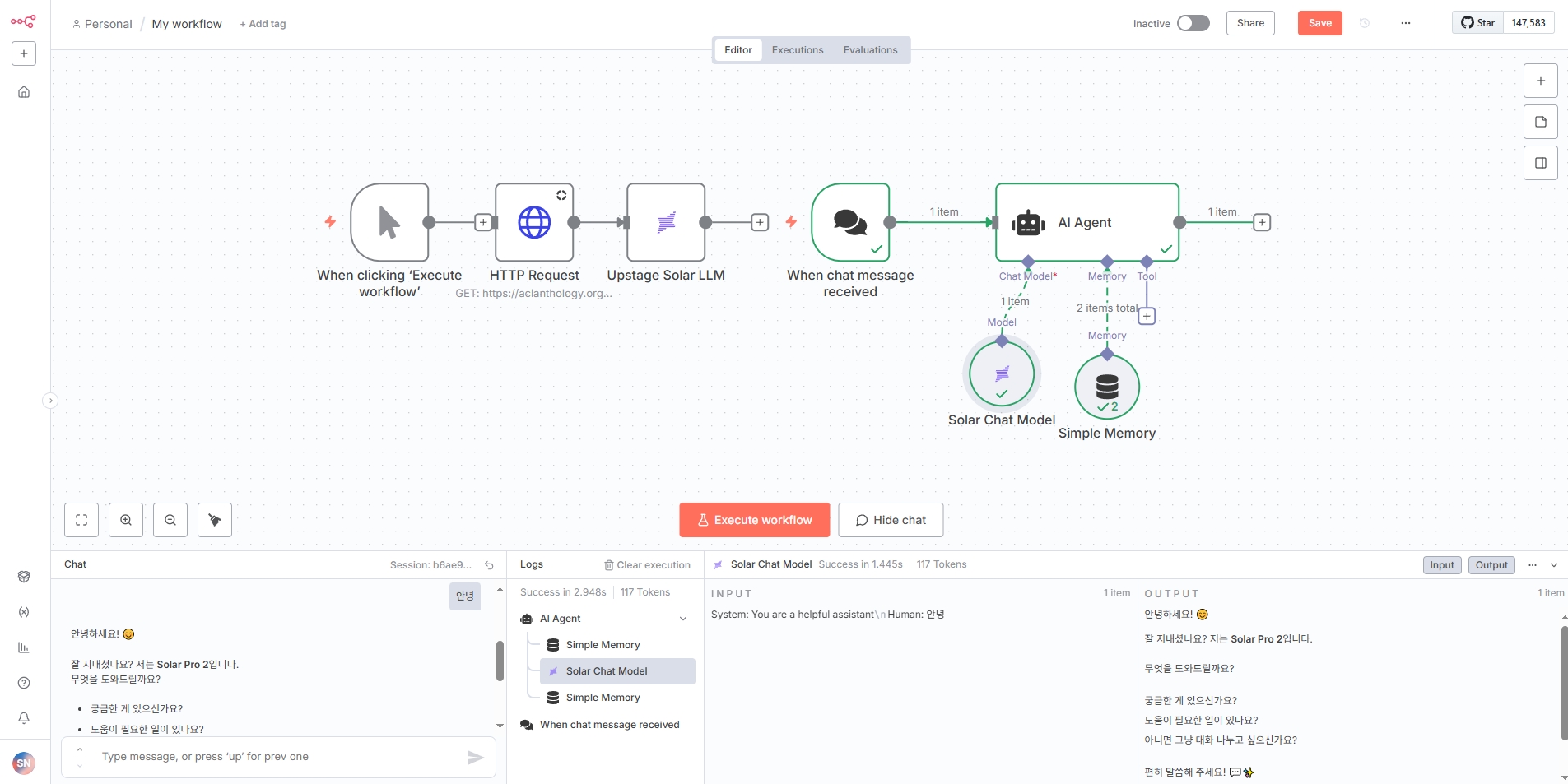

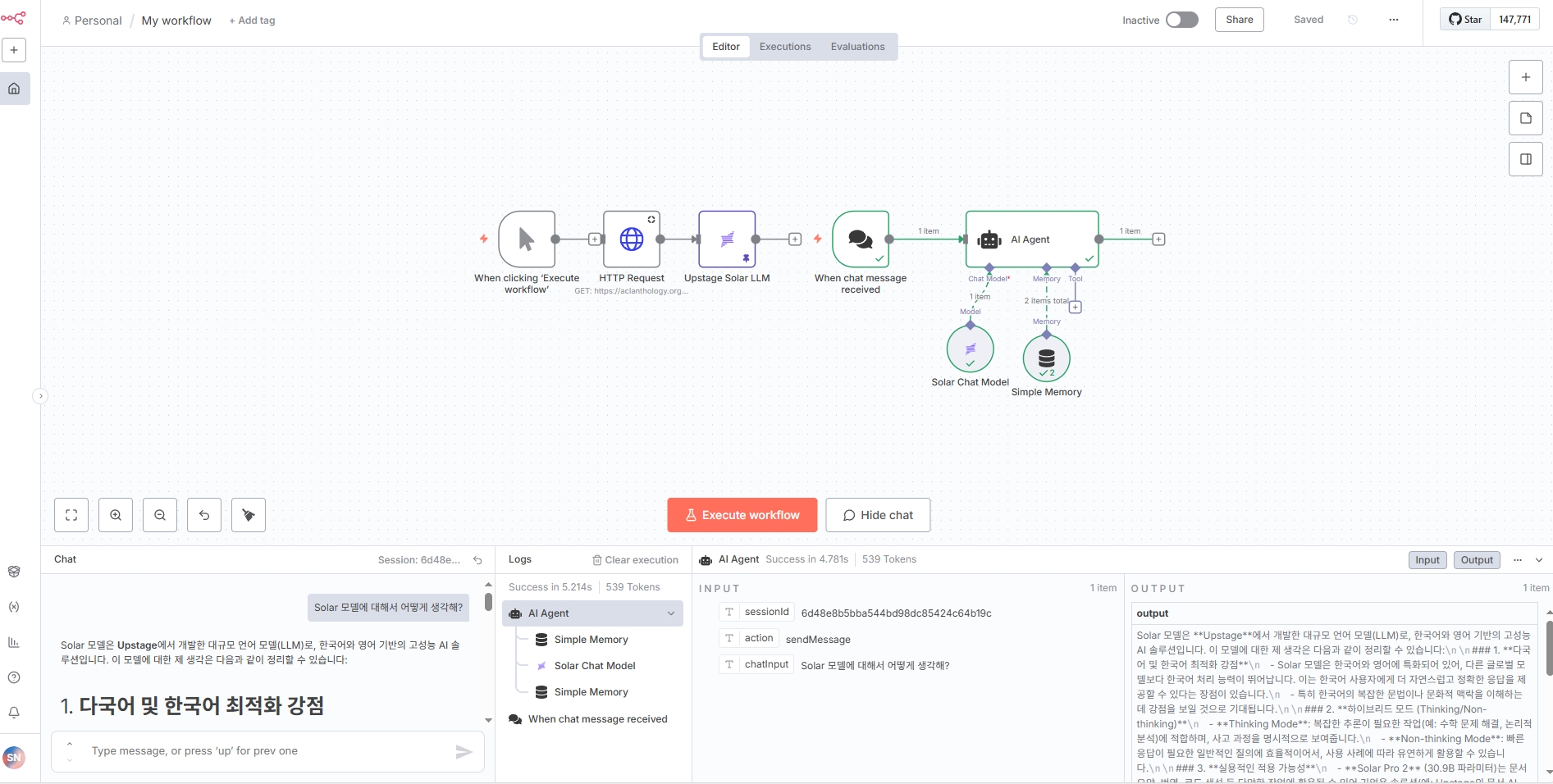

2. Chatting Agent Workflow

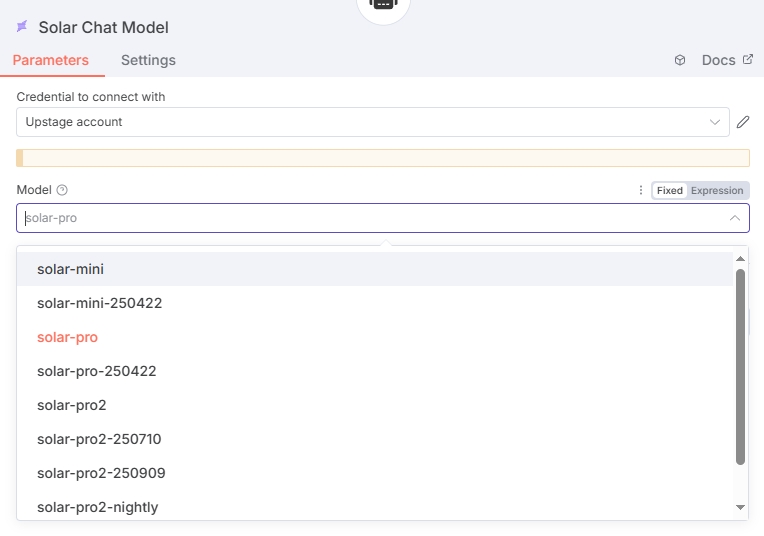

내가 제작한 두번째 Workflow는 Solar Chat Model을 활용한 AI Agent이다. Model들을 아래 처럼 8개의 모델 중 하나를 선택할 수 있다. 이번에는 solar-pro 모델을 선택하여 작업을 진행해 보았다.

아래 캡쳐화면 처럼, Solar model에 "안녕" 이라고 입력해보았다. 그림에서 확인할 수 있듯이, Logs에 process가 다 입력이 되고, Input, Output이 출력됨을 볼 수 있다.

더불어 Solar Chat Model 노드를 상세 클릭하여 Parameter와 setting창에 들어가면, 다시 아래 화면처럼, 입력과 출력값을 Schema, Table, JSON 형태로 출력가능하다는 것을 확인할 수 있다.

마지막으로, 아래 화면에서 Solar Model에게 직접 "Solar model에 대해서 어떻게 생각해?" 라는 질문을 던져보았다. 아래 화면에서 볼 수 있듯, 다국어 및 한국어 최적화에 강점이 있다고 답변하였다. 특히, Solar model은 한국어와 영어에 특화되어 있어서 다른 글로벌 모델보다 한국어 처리 능력이 뛰어나고, 이 때문에 한국어 사용자에게 더 자연스럽고 정확한 응답을 제공할 수 있다는 장점이 있다. 또한, 한국어의 복잡한 문법이나 문화적인 맥랑을 이해하는데에 강점을 보일 수 있다고 설명한다.

이번 실습을 통해 나의 개인적인 견해로는, n8n은 UI는 복잡한 코딩 없이 Node와 Edge만으로 간단한 AI Agent workflow를 만들 수 있는 훌륭한 플랫폼이라고 생각한다. 더불어 Upstage API를 활용해 Upstage 제품들을 사용해볼 수 있는 좋은 기회였다.