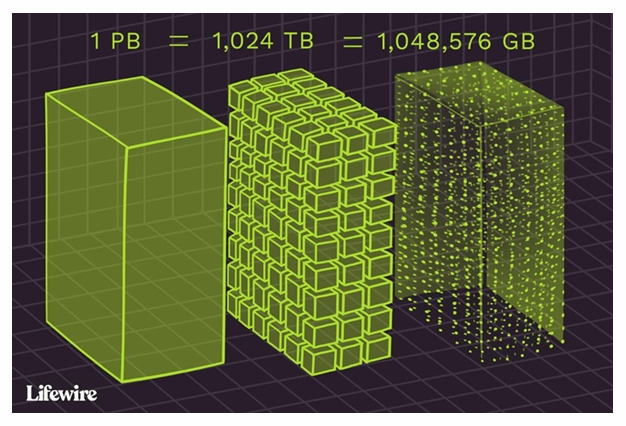

Big data: 기존의 도구로는 처리 불가능한 대규모의 복잡한 데이터

기존 방법: 수작업 (feature engineering) --> 현재 방법: 대량의 데이터를 통해 AI가 feature를 자동학습

단어표현 (sparse vs Dense Representation)

- sparse (희소 표현) : One-hot encoding --> 메모리 비효율, 의미적 거리 표현 불가

- Dense (밀집 표현): 의미 기반 벡터 표현 --> Word Embedding ex) word2vec

- CBOW: 주변 단어 --> 중심 단어 예측

- Skip-gram: 중심 단어 --> 주변단어 예측

RNN, LSTM, Seq2Seq

1.RNN: 시퀸스 처리 모델, 이전 상태 기억

- 문제: gradient vanishing / Explosion

- 최근 단어가 더 만히 반영됨

-

LSTM: RNN + Forget Gate --> 앞 단어의 정보보존 강화

-

Seq2Seq: Encoder-Decoder 구조로 입력/출력 길이 다른 시퀸스 처리

예: 번역 (한국어 --> 영어)

Attention & Transformer

Attention

- 단어간 상관관계를 고려하여 중요도 반영

Transformer

- Encoder: self-attention --> 문맥화된 벡터 출력

- Docoder:

masked self- attention (미래 단어 가리기)

cross-attention (encoder 출력 기반 번역)

Vision Transformer (ViT)

- 이미지를 patch로 나눈 후 각 패치를 임베딩하여 transformer에 입력

- Class Token: 전체 이미지의 대표 임베딩 역할

Class Activation Mapping (CAM)

- Gap (global average pooling)을 이용해 각 필터가 어떤 영역에 집중했는지 시각화 가능

특정 클래스가 이미지의 어디에 반응했는지 표시

Object Detection

- R-CNN: 후보 영역마다 CNN 적용이 느림

- Fast R-CNN: 전체 이미지에 CNN 후 후보영역 추출

- Faster R-CNN: RPN(Region Proposal Network)으로 후보 생성

- NMS (Non-Maximum Suppression): 겹치는 예측 제거

- DETR: Transformer 기반 object Detection

Hungarian algorithm: GT와 예측 1:1 매칭

GAN (Generative Adversarial Network)

- Generator vs Discriminator 구조

- Min-Max loss:

Discriminator: 진짜와 가짜를 구분하는 경계 생성

Generator: Discriminator를 속이도록 학습

Keyword: self-Attention / Cross-Attention / CAM / RPN / NMS