[2021.09.27] Object Detection Overview

💡 Object Detection Task에는 어떤 라이브러리가 쓰이는지, 학습된 모델들은 어떤 Metric을 통해 평가되는지 등

Task

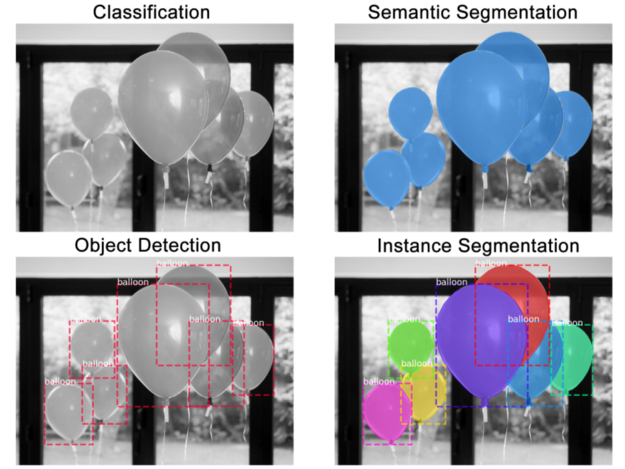

| Classification | Object Detection | Semantic Segmentation | Instance Segmentation | |

|---|---|---|---|---|

| Task | 해당 이미지 무엇인지 | 객체 식별 - 어디 있는지 - 무엇인지 | 객체의 영역 구분 | 객체 영역 구분 |

| 특징 | 이미지마다 정답 label 1개 | 한 이미지 당 여러개 객체 | 같은 class 객체끼리 구분 X | 객체마다 분리 |

Real world

- 자율주행 자동차

- OCR

- 의료 분야

History

- R-CNN (2013.11) - Fast R-CNN (ICCV 15) - Faster R-CNN (NIPS 15)

- YOLO v1 (CVPR 16)

- SSD (ECCV 16)

- YOLO v2 (CVPR 17)

- FPN (CVPR 17)

- RetinaNet (ICCV 17)

- YOLO v3 (arXiv 18)

- PANet (CVPR 18)

- EfficientDet (CVPR 20)

- Swin-T (CVPR 21)

Evaluation

성능: 얼마나 객체를 잘 검출하는가

mAP (mean average precision): 각 class 당 AP의 평균

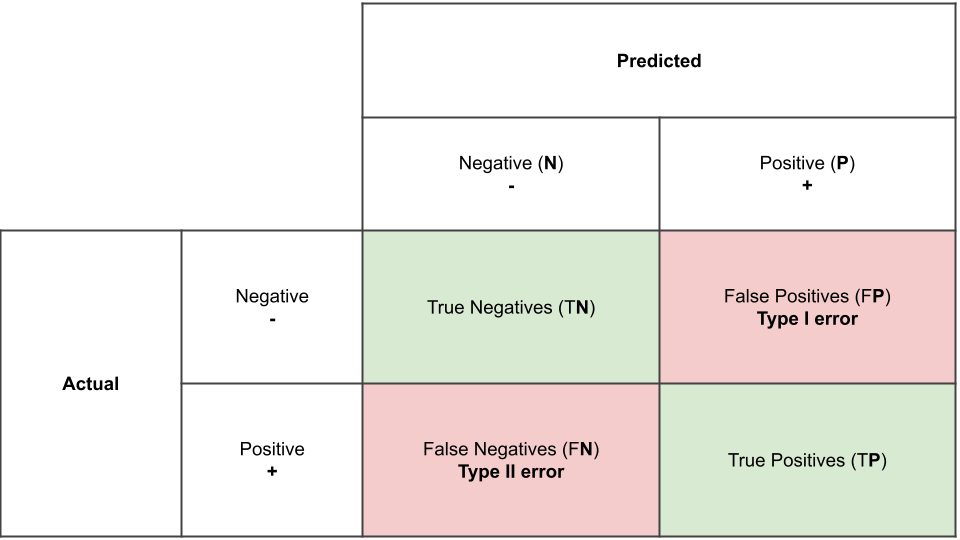

Confusion matrix

Precision

Recall

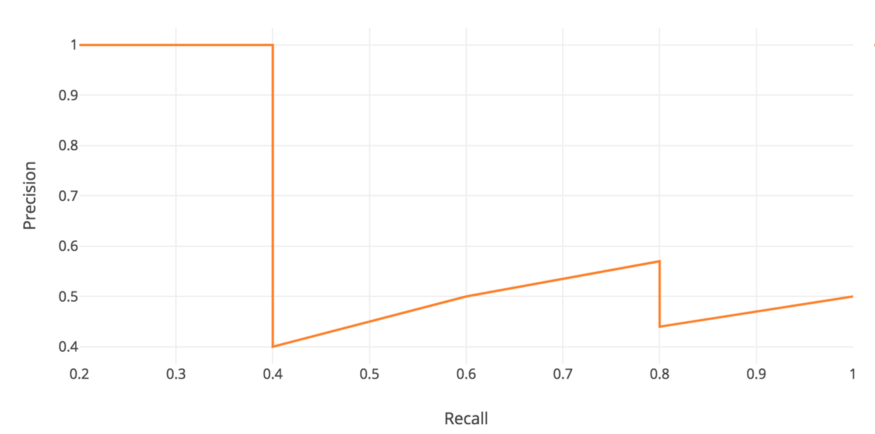

PR Curve

- Confidence 기준 내림차순 정렬한 Precision, Recall table

| Category | Confidence | TP/FP | 누적 TP | 누적 FP | Precision | Recall | |

|---|---|---|---|---|---|---|---|

| 8 | Plastic | 95% | TP | 1 | - | 1/1=1 | 1/10=0.1 |

| 9 | Plastic | 90% | TP | 2 | - | 2/2=1 | 2/10=0.2 |

| 7 | Plastic | 82% | FP | 2 | 1 | 2/3=0.66 | 2/10=0.2 |

| ... | |||||||

| 4 | Plastic | 10% | TP | 6 | 4 | 6/10=0.60 | 6/10=0.6 |

AP

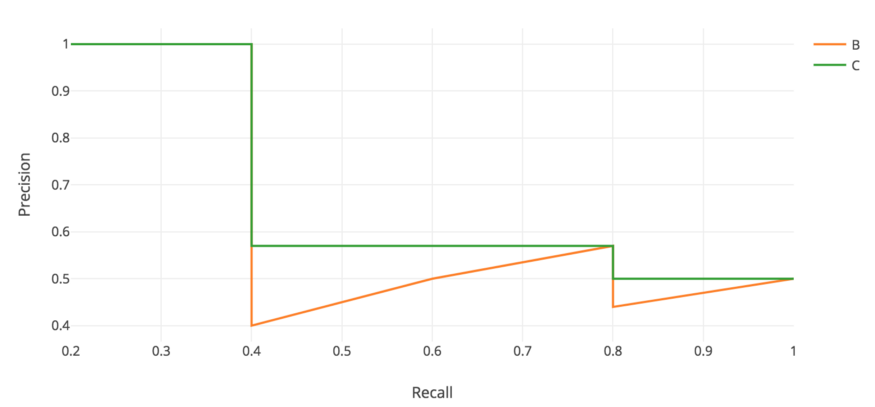

mAP (mean Average Precision)

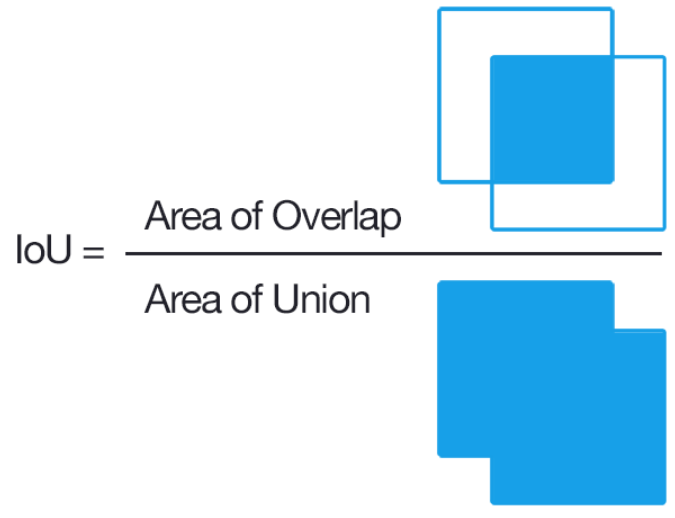

IOU (Intersection Over Union)

속도: 얼마나 빠르게 객체를 검출했는가

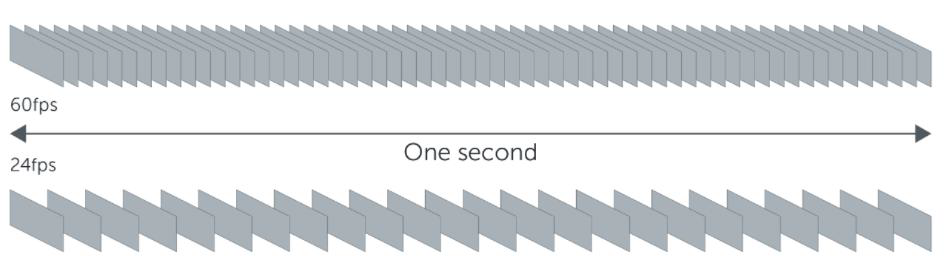

FPS (Frames Per Second)

FLOPs (Floating Point Operations)

- 연산량 횟수 (곱하기, 더하기, 빼기 등)

- Convolution layer Flops

- Stride, padding 고려한 결과

Library

- MMDetection

- Detectron2

- YOLOv5

- EfficientDet