BERT(Bidirectional Encoder Representations from Transformers)는 구글이 2018년에 발표한 혁신적인 자연어 처리(NLP) 모델이다. 이 모델은 텍스트의 문맥을 양방향으로 이해하는 능력을 갖추고 있어, 기존의 언어 모델보다 훨씬 더 정확하고 유연한 언어 이해가 가능하다. BERT의 등장은 자연어 처리 분야에서 큰 변화를 가져왔으며, 다양한 응용 분야에서 널리 사용되고 있다.

BERT의 핵심 개념

BERT의 핵심은 "양방향성"에 있습니다. 기존의 언어 모델들은 텍스트를 한 방향으로만 처리했기 때문에 문장의 전체적인 문맥을 이해하는 데 한계가 있었지만, BERT는 텍스트의 양쪽 방향에서 정보를 동시에 고려하여 문맥을 보다 깊이 이해할 수 있다. 이를 통해 BERT는 문장 내의 단어들이 서로 어떻게 관련되는지를 더 잘 파악할 수 있게 된다.

BERT의 훈련 방식

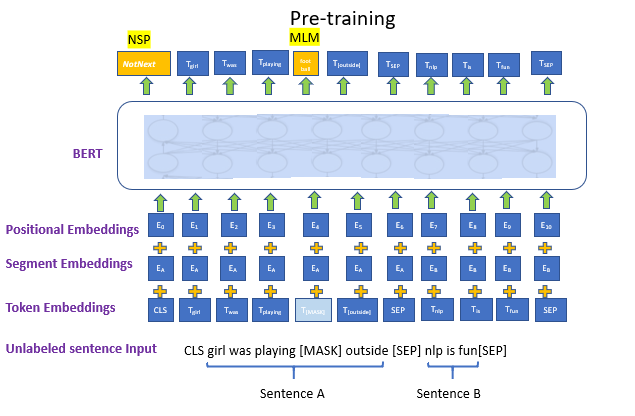

BERT는 두 가지 주요 과제로 사전 훈련된다: 마스킹 언어 모델링(Masked Language Modeling)과 다음 문장 예측(Next Sentence Prediction)이다.

마스킹 언어 모델링: 이 과정에서는 문장의 일부 단어를 무작위로 마스킹(masking)하고, 모델이 이 마스킹된 단어를 예측하도록 학습시키고, 이를 통해 BERT는 단어의 주변 문맥을 이해하는 능력을 키운다.

다음 문장 예측: BERT는 두 문장이 주어졌을 때, 두 번째 문장이 첫 번째 문장의 다음 문장인지 아닌지를 예측하는 과제를 수행한다. 이를 통해 BERT는 문장 간의 관계를 학습하게 된다.

이러한 과정을 통해 BERT는 다양한 NLP 작업에서 뛰어난 성능을 발휘할 수 있는 강력한 언어 모델로 성장하게 된다.

BERT의 응용

BERT는 자연어 처리 분야에서 여러 응용 분야에 사용된다. 대표적인 사례로는 질문 응답 시스템, 검색 엔진 최적화, 문서 분류, 감정 분석 등이 있다. 특히 구글은 자사 검색 엔진에 BERT를 도입하여 검색 질의의 문맥을 더 잘 이해하고, 사용자에게 더 정확한 검색 결과를 제공하고 있다.

또한, BERT는 오픈 소스로 공개되어, 연구자들과 개발자들이 자신의 필요에 맞게 모델을 수정하고 확장할 수 있게 되었다. 이를 통해 BERT는 학계와 산업계 모두에서 매우 중요한 도구로 자리잡고 있다.

결론

BERT는 자연어 처리 기술에 혁신을 가져온 모델로, 문맥을 양방향으로 이해하는 능력을 통해 다양한 NLP 작업에서 뛰어난 성능을 발휘한다. BERT의 등장 이후, 자연어 처리 분야는 더욱 정교하고 인간에 가까운 언어 이해를 목표로 빠르게 발전하고 있으며, BERT는 그 중심에 있다. 앞으로도 BERT와 같은 모델들이 NLP 기술의 진보를 이끌어 갈 것으로 기대된다.