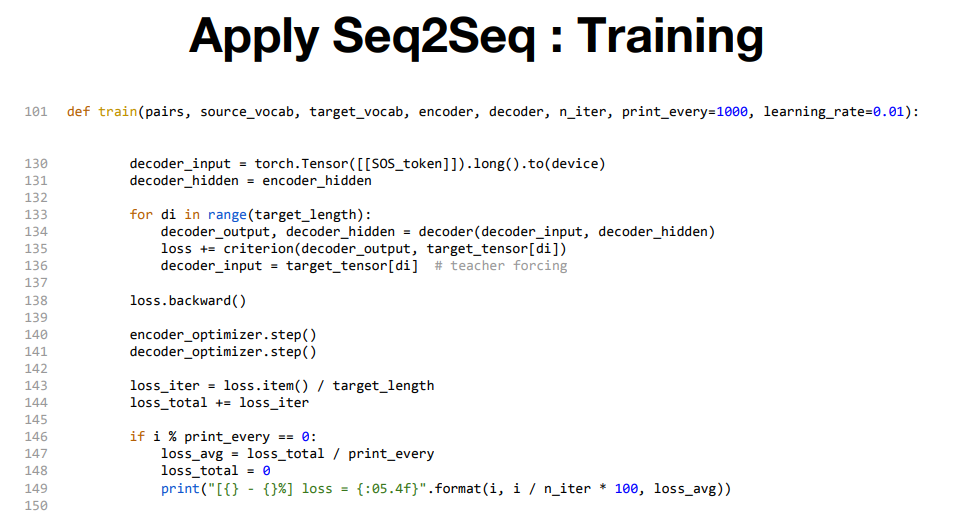

2개의 RNN을 사용하는 seq2seq라는 방법을 살펴보고자 한다.

seq2seq의 원리

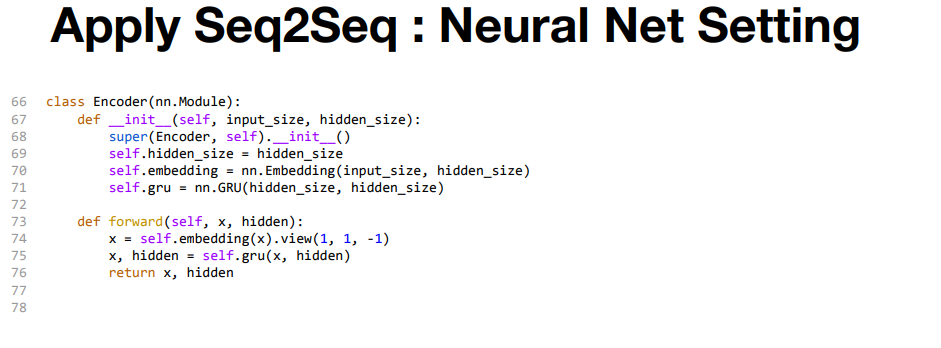

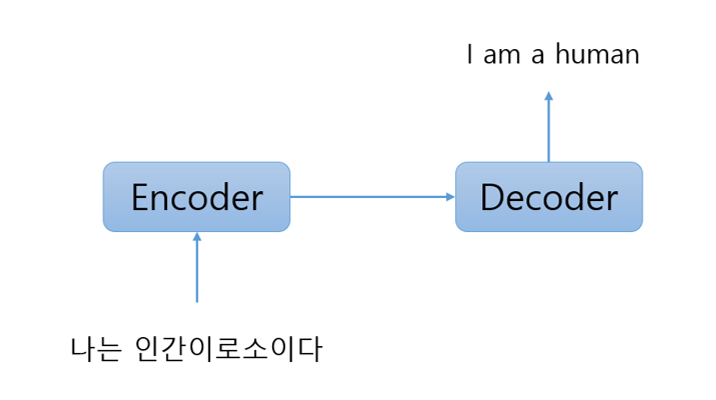

seq2seq를 Encoder-Deccoder 모델이라고도 한다.

Encoder는 입력 데이터를 인코딩(부호화)하고,

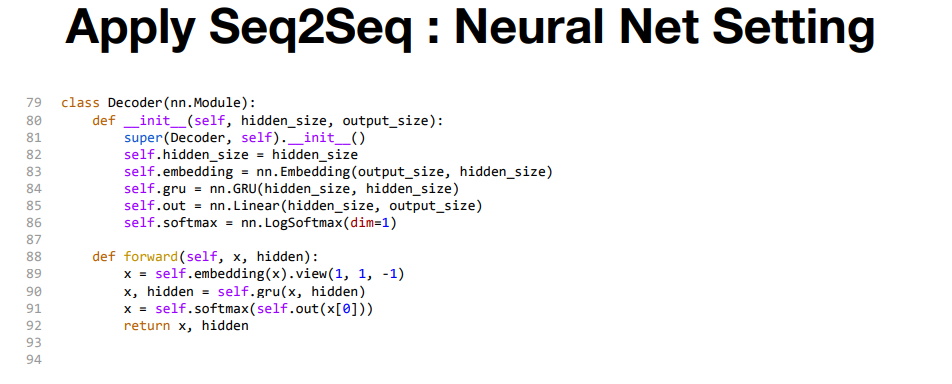

Decoder는 인코딩된 데이터를 디코딩(복호화)한다.

위의 그림처럼 Encoder가 "나는 인간이로소이다"라는 출발 문장을 인코딩 한다.

이어서 그 인코딩한 정보를 Decoder에 전달하고,

Decoder가 도작 문장을 생성한다.

이때 Encoder가 인코딩한 정보에는 번역에 필요한 정보가 조밀히 응축되어 있다.

Decoder는 조밀히 응축된 정보를 바탕으로 도착어 문장을 생성하는 것이다.

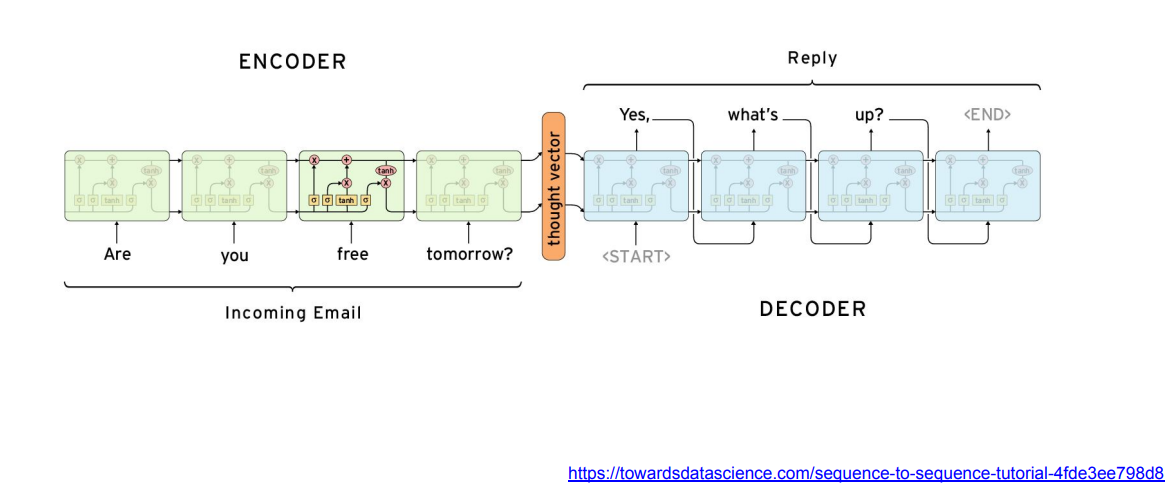

그리고 Encoder와 Decoder로는 RNN을 사용할 수 있다.

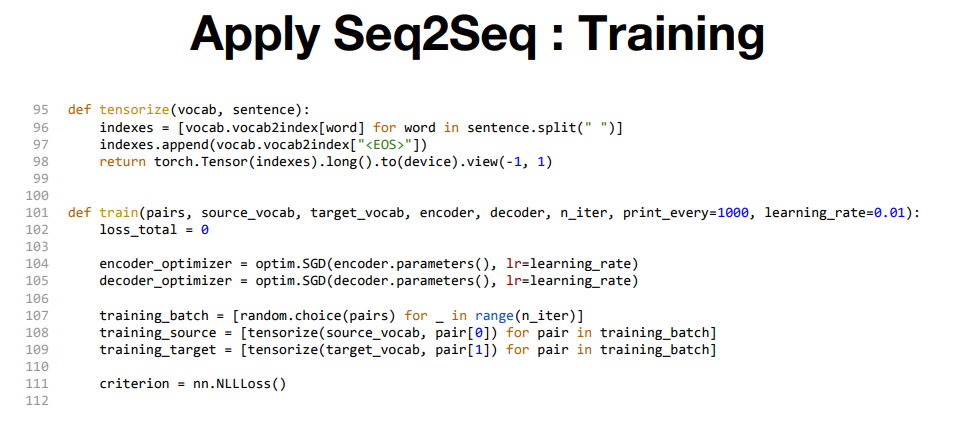

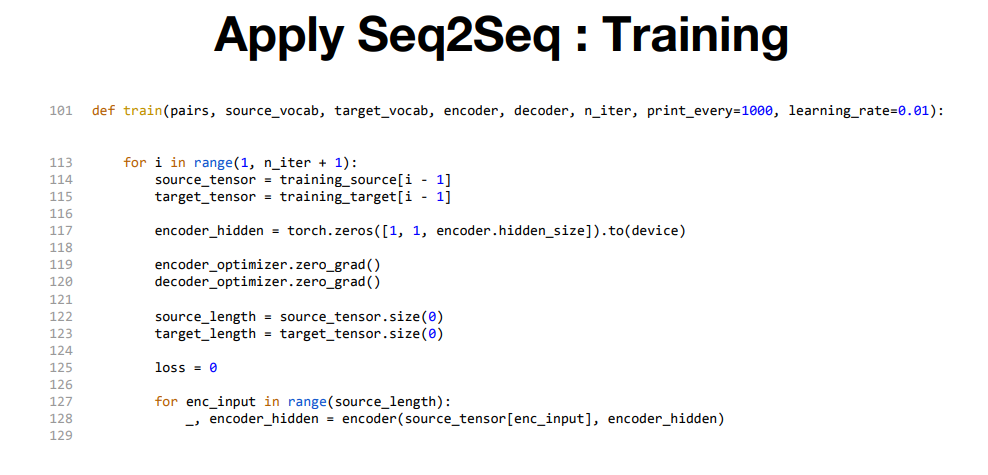

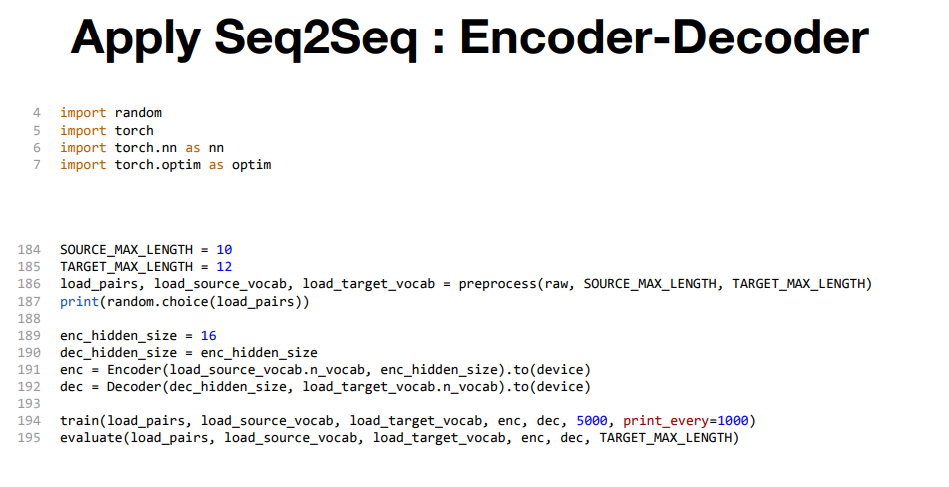

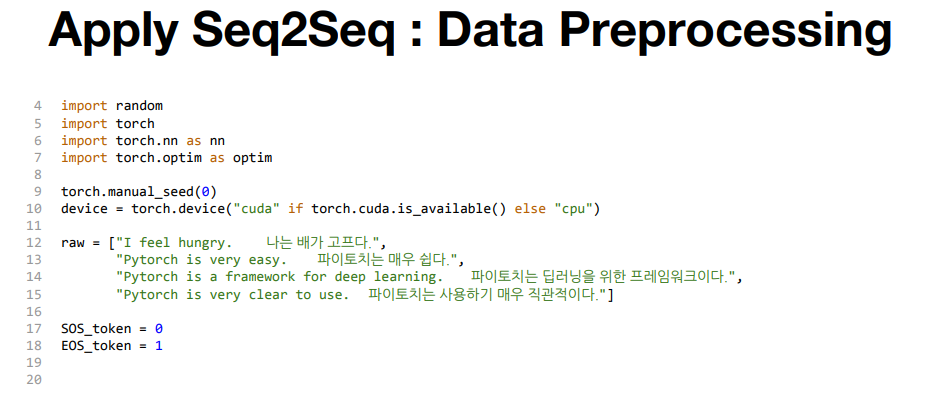

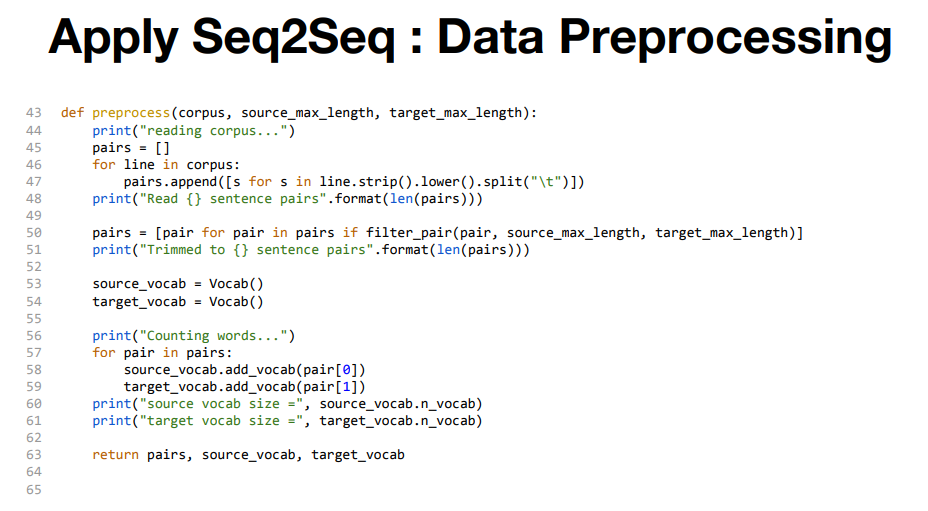

Preprocessing은 source text와 target text를 나눠서 어떤 단어로 구성되어있고, 단어수가 몇개인지를 측정한다.