Batch Normalization(배치 정규화)

Internal Coveriance Shift

각 Layer마다 Input분포가 달라짐에 따라 학습 속도가 느려지는 현상을 말한다.

Batch Normalization

Internal Coveriance Shift를 방지하기 위한 기법으로, 말 그대로 Layer의 Input분포를 정규화해 학습 속도를 빠르게 하겠다는 것이다.

Batch Normalization이 주목받는 이유

- 학습을 빨리 진행할 수 있다.(학습 속도 개선)

- 초깃값에 크게 의존하지 않는다

- 오버피팅을 억제한다(Dropout등의 필요성 감소)

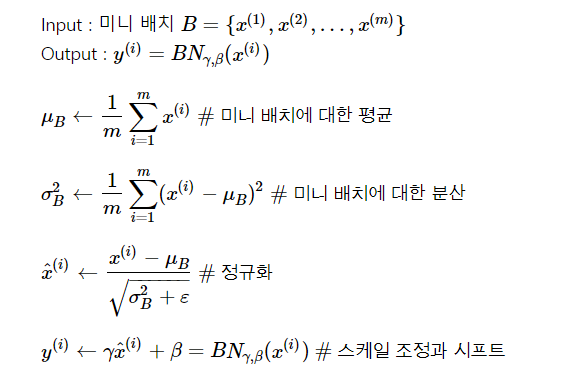

Batch Normalization 수식화

Batch Normalization의 한계

- 미니 배치 크기에 의존적인다

- RNN에 적용하기 어렵다.