Cost 함수

cost(W)를 그래프로 그려보면 다음과 같다.

cost가 최소가 되는 파란색으로 표시한 값을 찾는 것이 목표다

Gradient descent algorithm(경사 하강법)

❔ Gradient descent algorithm(경사 하강법)

① cost를 최소화 하기 위해 경사를 따라 내려가는 방법으로

② 최저 비용을 계산하는 함수이고,

③ 다양한 최소화 문제에 사용된다.

④ 주어진 비용함수 cost(W,b)에 대해서, 이 방법은 비용을 최소화 하는 W와 b를 찾는 것이다.

⑤ 일반적인 다른 경우에도 많이 사용한다.

Gradient descent algorithm(경사하강법) 작동 원리

① 아무지점에서 시작해서 경사를 따라 탐사를 시작한다.

② W와 b를 조금씩 바꿔보면서 cost를 줄여주는 gradient(경사)를 계산한다. (미분 사용)

③ 위의 방법을 반복한다.

④ 결국 극소점에서 수렴하게 된다. (항상 최소점에서 수렴하게 된다는 보장이 없으므로, 시작 지점이 어디냐에 따라 종료지점이 달라질 수 있다.)

수식

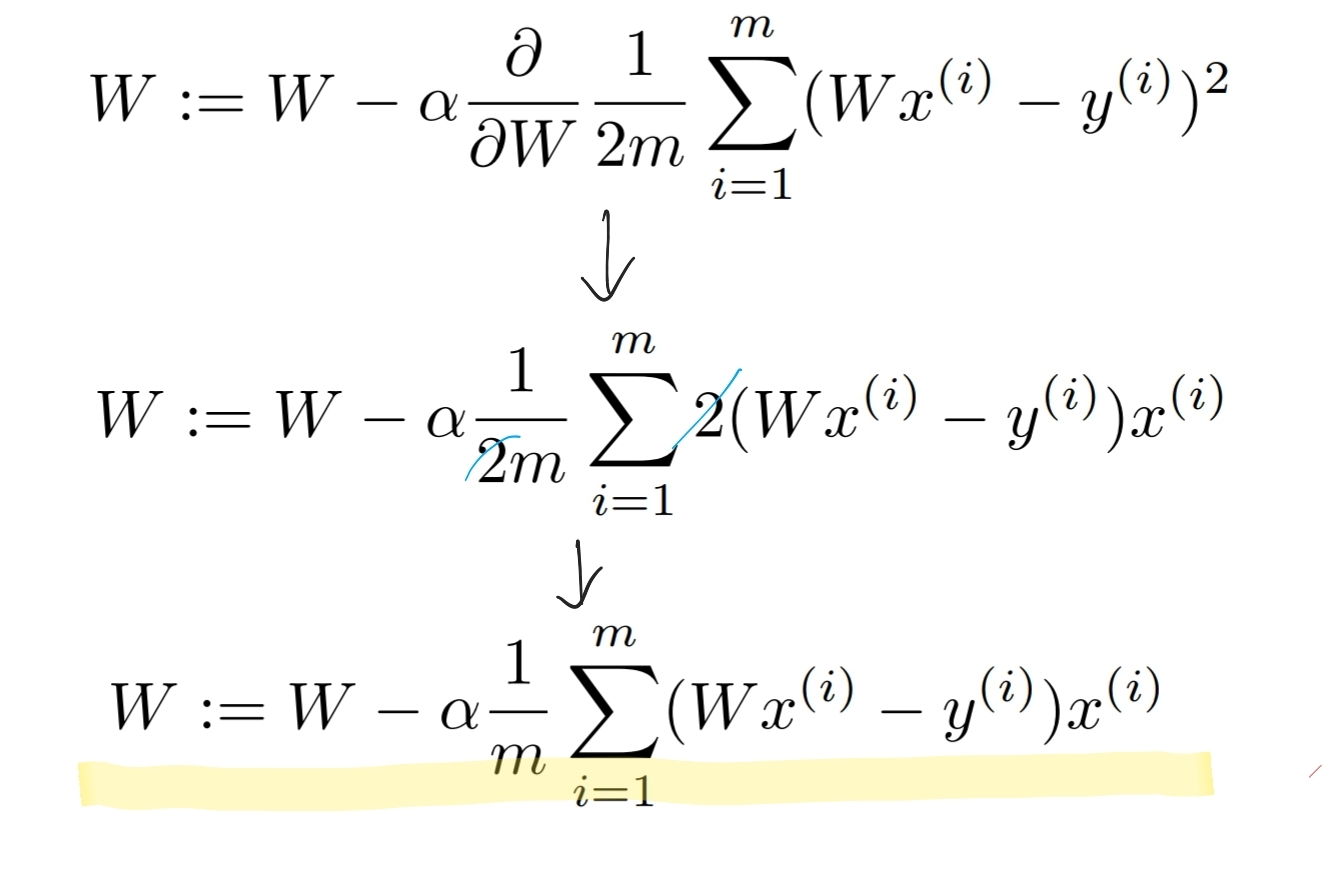

❔ 구하는 과정

①먼저 미분을 편하게 하기 위해 분모를 2m으로 해준다.

②

③

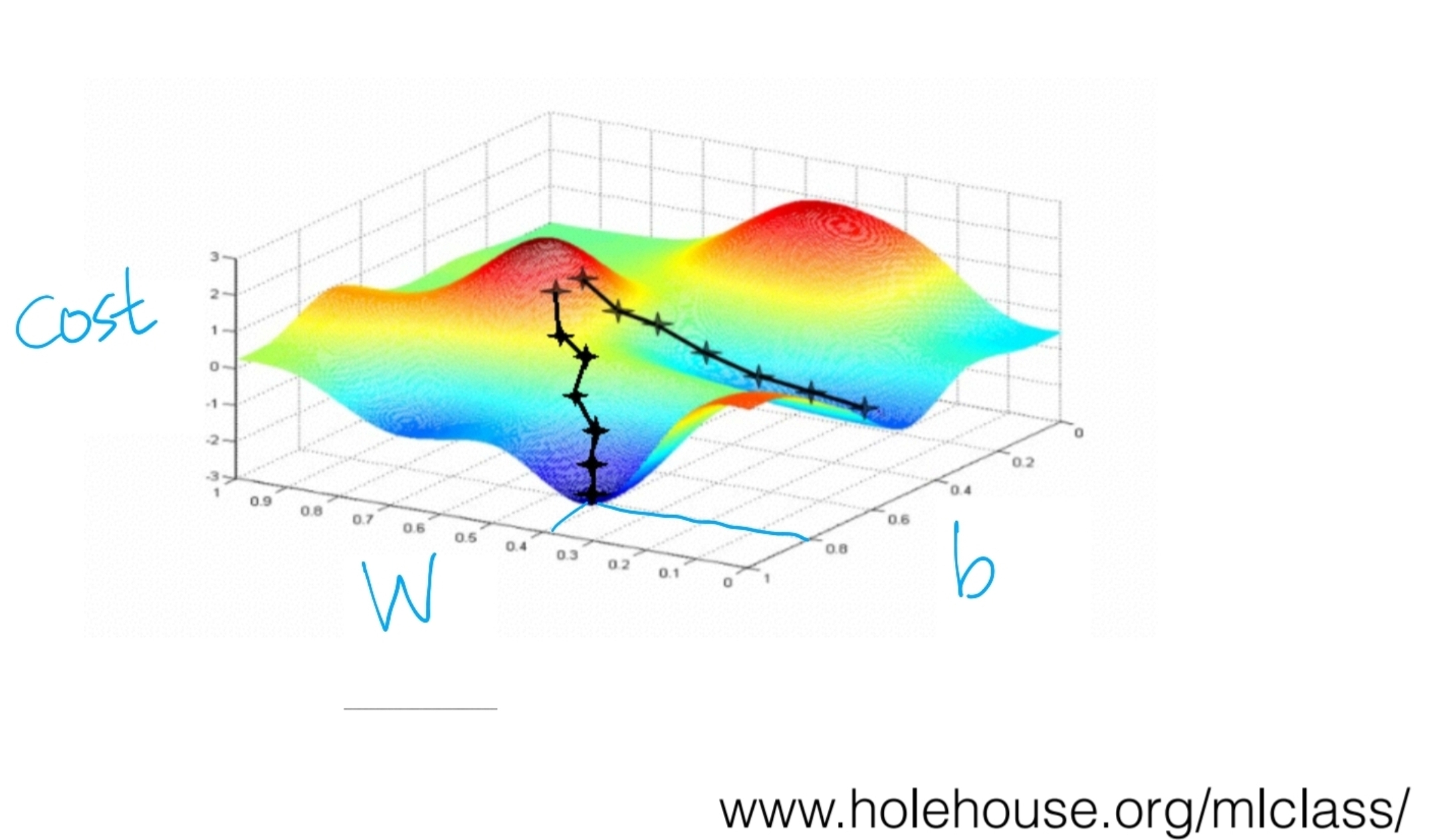

Gradient descent algorithm의 한계

위와 같은 형태의 그래프는 올록볼록한 형태의 그래프다. 이렇게 되면 두개의 서로 다른 점에서 시작해서 더 낮은 경사도를 따라갔을 뿐인데, 서로 다른 곳에 도착하게 된다.

다행히 Cost Function은 밥그릇 모양을 엎어놓은것과 같이 생긴 그래프로 그려지는데,

이러한 그래프를 Convex function이라고 한다.

이런 경우는 어느 지점에서 시작을 해도 항상 도착하는 곳이 우리가 원하는 지점이 된다.

이런 경우에는 Gradient descent algorithm이 항상 답을 찾는다는것을 보장해준다.

중요한 것은 cost function을 설계할 때, 반드시 cost function의 모양이 convex function이 되는지 확인해주어야 한다.