지도학습과 비지도 학습

지도학습 : 정답(타깃)이 있어서 알고리즘이 정답을 맞힐 수 있도록 학습하는 것.

- 훈련 데이터 : 데이터와 정답을 입력(input)과 타겟(target)이라 부르는데 이 두 가지를 합한 것.(training data)

비지도학습 : 타겟 없이 입력 데이터만 사용.

훈련 세트와 테스트 세트

테스트 세트

: test set, 평가에 사용하는 데이터

훈련 세트

: train set, 훈련에 사용되는 데이터

머신러닝의 정확한 평가 위해서는 테스트 세트와 훈련 세트가 따로 준비 되어야 한다.

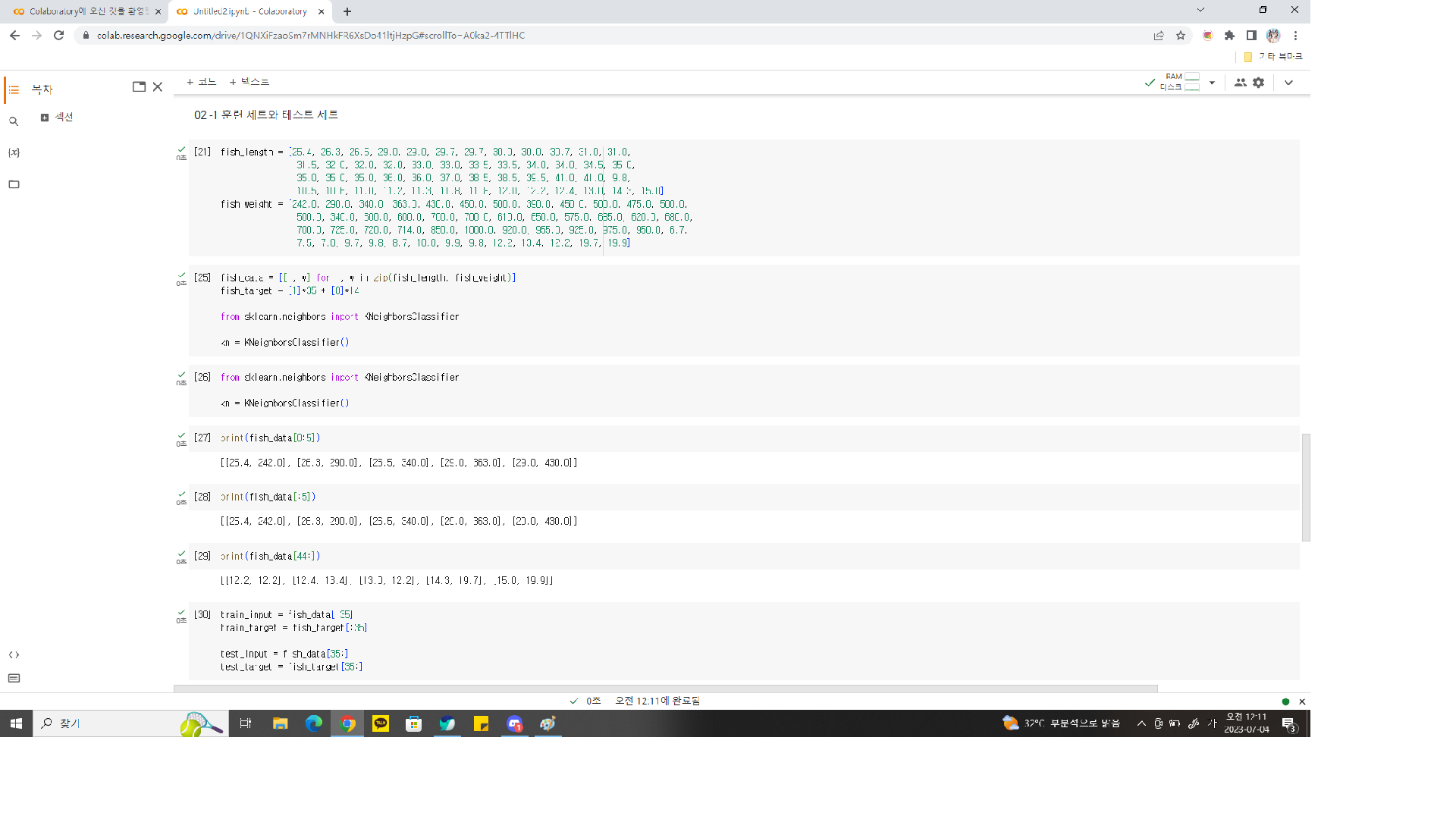

fish_length = [25.4, 26.3, 26.5, 29.0, 29.0, 29.7, 29.7, 30.0, 30.0, 30.7, 31.0, 31.0,

31.5, 32.0, 32.0, 32.0, 33.0, 33.0, 33.5, 33.5, 34.0, 34.0, 34.5, 35.0,

35.0, 35.0, 35.0, 36.0, 36.0, 37.0, 38.5, 38.5, 39.5, 41.0, 41.0, 9.8,

10.5, 10.6, 11.0, 11.2, 11.3, 11.8, 11.8, 12.0, 12.2, 12.4, 13.0, 14.3, 15.0]

fish_weight = [242.0, 290.0, 340.0, 363.0, 430.0, 450.0, 500.0, 390.0, 450.0, 500.0, 475.0, 500.0,

500.0, 340.0, 600.0, 600.0, 700.0, 700.0, 610.0, 650.0, 575.0, 685.0, 620.0, 680.0,

700.0, 725.0, 720.0, 714.0, 850.0, 1000.0, 920.0, 955.0, 925.0, 975.0, 950.0, 6.7,

7.5, 7.0, 9.7, 9.8, 8.7, 10.0, 9.9, 9.8, 12.2, 13.4, 12.2, 19.7, 19.9]두 파이썬 리스트를 순회하면서 각 생선의 길이와 무게를 하나의 리스트로 담은 2차원 리스트 생성.

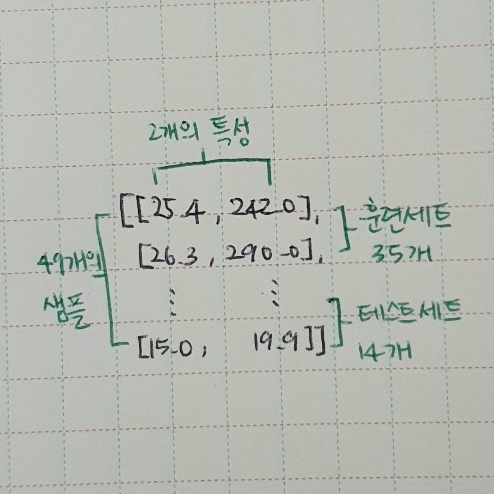

fish_data = [[l, w] for l, w in zip(fish_length, fish_weight)]

fish_target = [1] * 35 + [0] * 14

인덱스(index) : 배열의 위치를 지정해준다.

슬라이싱(slicing) : 콜론(:)을 두고 인덱스의 범위를 지정해준다.

마지막 인덱스의 원소는 포함 X.

슬라이싱을 이용하여 생선 데이터에서 35개, 14개 선택을 한다.

# 훈련 세트로 입력값 중 0부터 34번째 인덱스까지 사용

train_input = fish_data[:35]

# 훈련 세트로 타깃값 중 0부터 34번쨰 인덱스까지 사용

train_target = fish_data[:35]

# 테스트 세트로 입력값 중 35번째부터 마지막까지 사용

test_input = fish_data[35:]

# 테스트 세트로 타겟값 중 35번째부터 마지막까지 사용

test_target = fish_data[35:]훈련 세트로 fit() 메서트 사용하여 모델 훈련, 테스트 세트로 score() 메서드 사용하여 평가.

kn.fit(train_input, train_target)

kn.score(test_input, test_target)--> 정확도가 0.0이 나온다!!!!

샘플링 편향

샘플링 편향(sampling bias) : 훈련 세트와 테스트 세트에 샘플이 골고루 섞여 있지 않아 샘플링이 한 쪽으로 치우쳤다는 의미.

위에 정확도가 0.0이 나온 이유 : 처음 fish_data에 들어있는 35개의 도미와 14개의 빙어 샘플을 그대로 가져왔기 때문에!

특정 종류의 샘플이 과도하게 많은 샘플링 편향을 가지고 있으면 제대로 된 지도 학습 모델을 만들 수 없음.

그래서 이를 위해 데이터를 섞거나 샘플을 골고루 뽑아야 하는데 이를 간편하게 해주는 파이썬 라이브러리가 넘파이 이다!

넘파이

넘파이(numpy) : 파이썬의 대표적인 배열(array) 라이브러리. 넘파이로는 고차원의 배열을 손쉽게 만들고 조작할 수 있다!

- 라이브러리 임포트

import numpy as np- 파이썬 리스트를 넘파이 배열로 바꾸기

input_arr = np.array(fish_data)

target_arr = np.array(fish_target)print 해보면 49개의 행과 2개의 열로 원하는 형태로 출력해준다.

이제 랜덤하게 샘플을 선택해보자. 주의할 점은 input_arr와 target_arr에서 같은 위치는 함께 선택되어야 한다. 타깃과 샘플이 함께 이동하지 않으면 올바르게 훈련되지 않는다.

넘파이 arrnage()함수를 사용해서 0부터 48까지 1씩 증가하는 인덱스를 간단히 만들 수 있다. 그 후 인덱스를 랜덤하게 섞는다.

넘파이에서 무작위 결과 만드는 함수들은 실행할 때마다 다른 결과 만든다. 일정한 결과 얻기 위해선 초기 랜덤 시드(random seed)를 지정하면 된다.

np.random.seed(42)

index = np.arrange(49)

np.random.shuffle(index)넘파이 arrange()함수에 정수 N 전달하면 0부터 N-1까지 1씩 증가하는 배열 만들고 shuffle() 함수로 배열을 무작위로 섞어준다.

배열 인덱싱(array indexing) : 1개의 인덱스가 아닌 여러 개의 인덱스로 한 번에 여러 개의 원소를 선택할 수 있음.

이를 통해 랜덤하게 index 배열의 처음 35개를 input_arr와 target_arr에 전달하여 랜덤하게 35개의 샘플을 훈련 세트로 만든다.

train_input = input_arr[index[:35]]

tarin_target = target_arr[index[:35]]나머지 14개를 테스트 세트로 만든다.

test_input = intput_arr[index[35:]]

test_target = input_arr[index[35:]]이제 훈련 세트와 테스트 세트에 도미와 빙어가 잘 섞여 있는지 산점도를 그려본다.

import matplotlib.pyplot as plt

plt.scatter(train_input[:,0], train_input[:,1])

plt.scatter(test_input[:,0], test_input[:,1])

plt.xlabel('length')

plt.ylabel('weight')

plt.show()두 번째 머신러닝 프로그램

k-최근접 이웃 모델을 훈련시키자. fit() 매서드 실행할 때마다 KNeighborsClassifier 클래스의 객체는 이전에 학습한 모든 것을 잃어버린다. 이전 모델 그대로 두고 싶다면 KNeighborsClassifier 클래스 객체를 새로 만들어야한다.

train_input과 train_target으로 모델 훈련.

kn.fit(train_input, train_target)test_input과 test_target으로 모델을 테스트.

kn.score(test_input, test_target)predict() 메서드로 테스트 세트의, 예측 결과와 실제 타깃을 확인.

kn.predict(test_input)

test_target테스트 세트에 대한 예측 결과가 정답과 일치한다!! preduct() 메서드의 출력 결과가 test_target의 출력과 동일하게 array()로 감싸 있는 것을 눈여겨보자!

predict() 메서드가 반환하는 값은 단순한 파이썬 리스트가 아니라 넘파이 배열. (사이킷런 모델의 입력과 출력은 모두 넘파이 배열.)

전체소스코드

fish_length = [25.4, 26.3, 26.5, 29.0, 29.0, 29.7, 29.7, 30.0, 30.0, 30.7, 31.0, 31.0,

31.5, 32.0, 32.0, 32.0, 33.0, 33.0, 33.5, 33.5, 34.0, 34.0, 34.5, 35.0,

35.0, 35.0, 35.0, 36.0, 36.0, 37.0, 38.5, 38.5, 39.5, 41.0, 41.0, 9.8,

10.5, 10.6, 11.0, 11.2, 11.3, 11.8, 11.8, 12.0, 12.2, 12.4, 13.0, 14.3, 15.0]

fish_weight = [242.0, 290.0, 340.0, 363.0, 430.0, 450.0, 500.0, 390.0, 450.0, 500.0, 475.0, 500.0,

500.0, 340.0, 600.0, 600.0, 700.0, 700.0, 610.0, 650.0, 575.0, 685.0, 620.0, 680.0,

700.0, 725.0, 720.0, 714.0, 850.0, 1000.0, 920.0, 955.0, 925.0, 975.0, 950.0, 6.7,

7.5, 7.0, 9.7, 9.8, 8.7, 10.0, 9.9, 9.8, 12.2, 13.4, 12.2, 19.7, 19.9]

fish_data = [[l, w] for l, w in zip(fish_length, fish_weight)]

fish_target = [1]*35 + [0]*14

from sklearn.neighbors import KNeighborsClassifier

kn = KNeighborsClassifier()

print(fish_data[4])

print(fish_data[0:5])

print(fish_data[:5])

print(fish_data[44:])

train_input = fish_data[:35]

train_target = fish_target[:35]

test_input = fish_data[35:]

test_target = fish_target[35:]

kn.fit(train_input, train_target)

kn.score(test_input, test_target)

import numpy as np

input_arr = np.array(fish_data)

target_arr = np.array(fish_target)

print(input_arr)

print(input_arr.shape)

np.random.seed(42)

index = np.arange(49)

np.random.shuffle(index)

print(index)

print(input_arr[[1,3]])

train_input = input_arr[index[:35]]

train_target = target_arr[index[:35]]

print(input_arr[13], train_input[0])

test_input = input_arr[index[35:]]

test_target = target_arr[index[35:]]

import matplotlib.pyplot as plt

plt.scatter(train_input[:, 0], train_input[:, 1])

plt.scatter(test_input[:, 0], test_input[:, 1])

plt.xlabel('length')

plt.ylabel('weight')

plt.show()

kn.fit(train_input, train_target)

kn.score(test_input, test_target)

kn.predict(test_input)

test_target