CloudNet@에서 진행하는 Istio Study 3주차 5장 내용입니다.

📕 이번 Chapter에서 다루는 내용

- Traffic routing basics

- Shifting traffic during a new release

- Mirroring traffic to reduce the risk of a new release

- Controlling traffic as it leaves a cluster

5.1 Reducing the risk of deploying new code

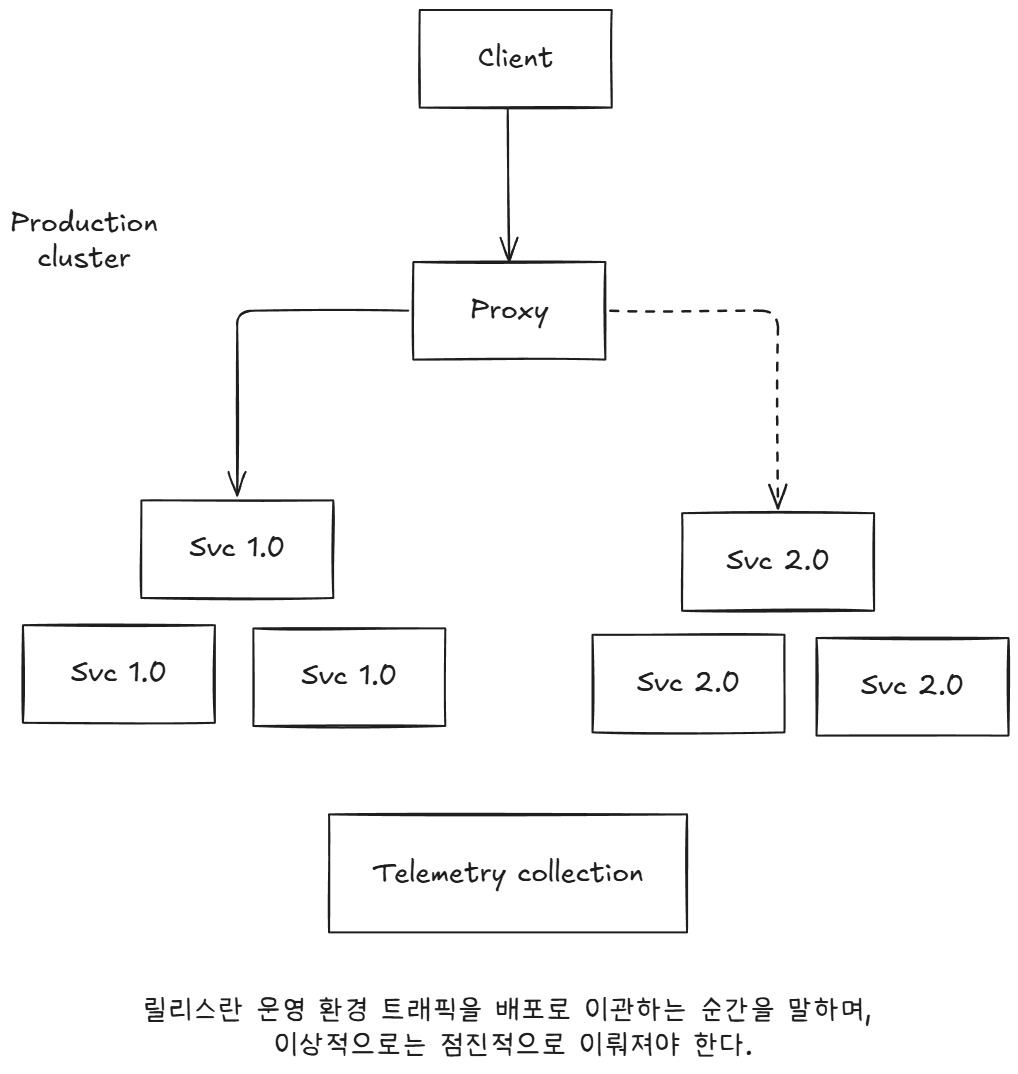

5.1.1 Deploymet vs Release

카탈로그 서비스를 사용하여 배포와 릴리스의 차이점 확인

- catalog 서비스의 v1이 현재 운영 중이라고 가정

- 새 버전(v1.1이라고 하자)으로 태그, Staging 환경에 배포하고 테스트

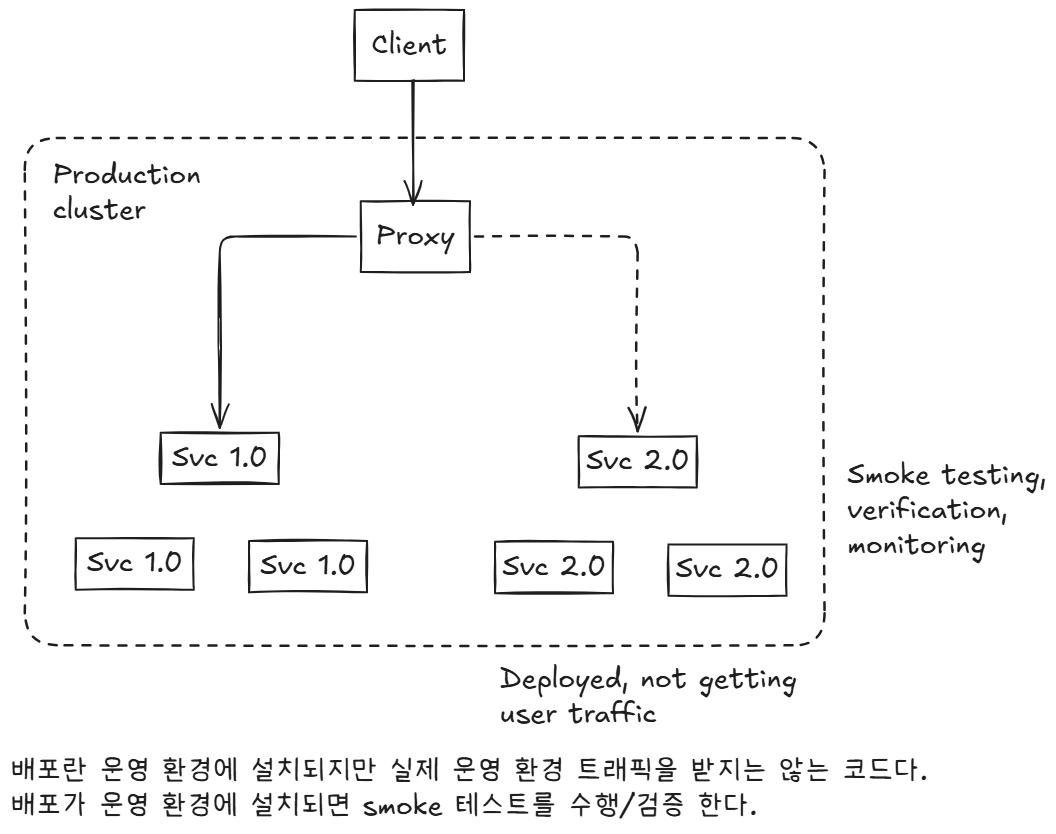

- 운영 환경에 배포할 때는 새 코드를 운영 환경 리소스(서버, 컨테이너 등)에 설치하지만, 트래픽은 보내지는 않는다.

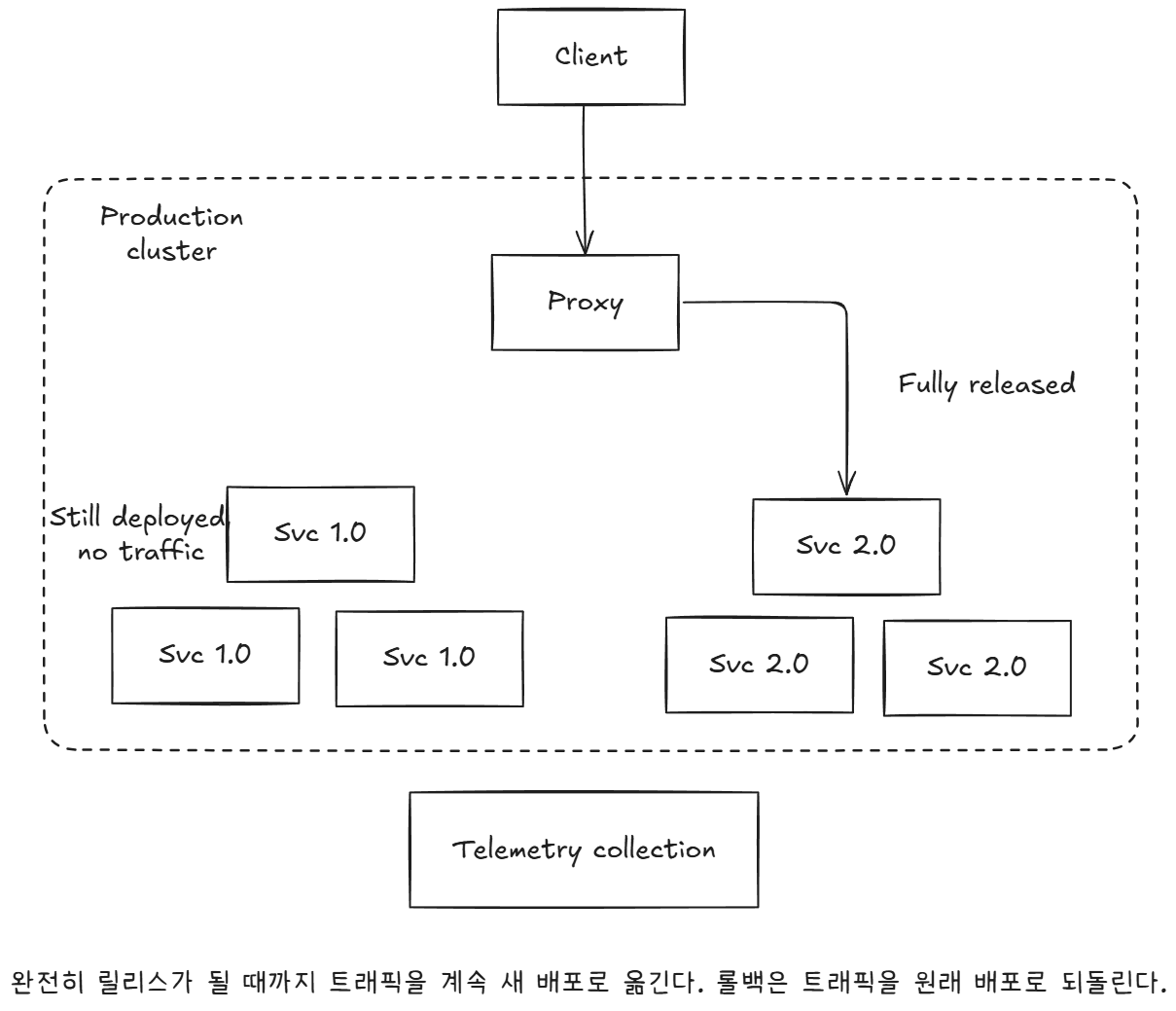

- 코드를 릴리즈한다는 말은 실제 트래픽을 새 배포로 가져오는 것을 의미한다. 단, 릴리스가 꼭 한 번에 전부 가야 하는 것은 아니다.

- 실 트래픽의 대부분은 소프트웨어의 구 버전이 받고, 신 버전은 일부만을 받는 것 을 ‘카나리한다 canarying’ 고 말하거나 ‘카나리 릴리스 canary release’라고 부른다.

- 동작과 성능이 이상할 시에 트래픽을 이전 버전으로 돌려 릴리스를 롤백할 수 있다.

5.2 Routing requests with Istio

VirtualService?

- 요청에 따라 헤더로 경로를 제어

- 다크 런치로 특정 사용자에게 배포를 제공

- 사용자에 따라 버전을 구별

5.2.2 Deploying v1 of the catalog service

# Let’s deploy v1 of our catalog service. From the root of the book’s source code, run the following command

kubectl apply -f services/catalog/kubernetes/catalog.yaml -n istioinaction

# 확인

kubectl get pod -n istioinaction -owide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

catalog-6cf4b97d-ftl77 2/2 Running 0 42s 10.10.0.14 myk8s-control-plane <none> <none>

# 도메인 질의를 위한 임시 설정 : 실습 완료 후에는 삭제 해둘 것

echo "127.0.0.1 catalog.istioinaction.io" | sudo tee -a /etc/hosts

cat /etc/hosts | tail -n 3

kubectl apply -f ch5/catalog-gateway.yaml -n istioinaction

kubectl apply -f ch5/catalog-vs.yaml -n istioinaction

# istio-ingressgateway Service(NodePort)에 포트 정보 확인

kubectl get svc -n istio-system istio-ingressgateway -o jsonpath="{.spec.ports}" | jq

[

{

"name": "status-port",

"nodePort": 31674,

"port": 15021,

"protocol": "TCP",

"targetPort": 15021

},

{

"name": "http2",

"nodePort": 30000, # 순서1

"port": 80,

"protocol": "TCP",

"targetPort": 8080 # 순서2

},

{

"name": "https",

"nodePort": 30005,

"port": 443,

"protocol": "TCP",

"targetPort": 8443

}

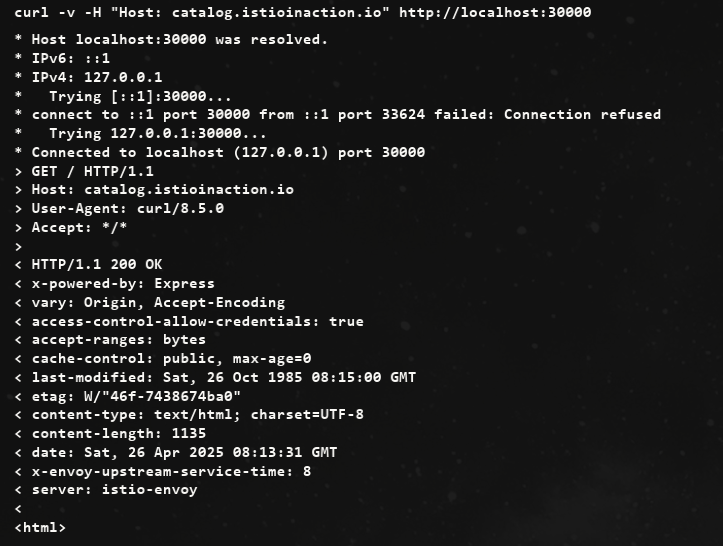

]- 접속 확인

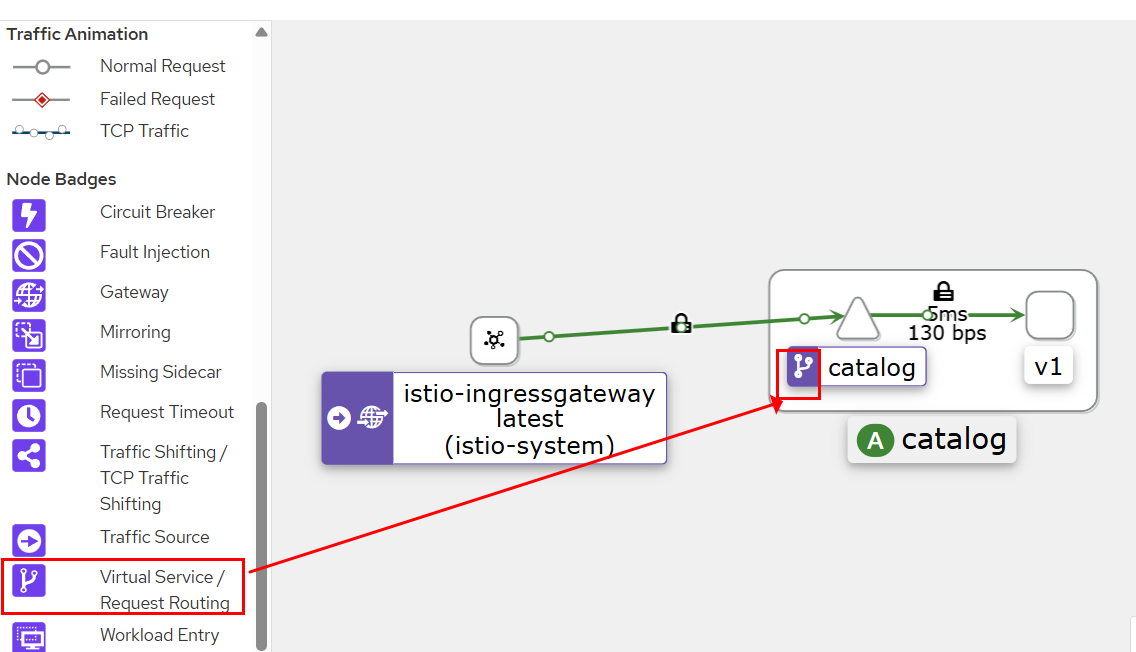

- Kiali에서 VirtualService 확인

5.2.3 Deploying v2 of the catalog service

- catalog 서비스 v2 를 배포해보자. ⇒ 버전1,2 호출 된다. v2 호출되지 않게 할 수 없을까?

# catalog 서비스 v2 를 배포 : v2에서는 imageUrl 필드가 추가

kubectl apply -f services/catalog/kubernetes/catalog-deployment-v2.yaml -n istioinaction

#

kubectl get deploy -n istioinaction --show-labels

NAME READY UP-TO-DATE AVAILABLE AGE LABELS

catalog 1/1 1 1 30m app=catalog,version=v1

catalog-v2 1/1 1 1 34s app=catalog,version=v2

kubectl get pod -n istioinaction -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

catalog-6cf4b97d-ftl77 2/2 Running 0 43m 10.10.0.14 myk8s-control-plane <none> <none>

catalog-v2-6df885b555-6hmcl 2/2 Running 0 13m 10.10.0.15 myk8s-control-plane <none> <none>

docker exec -it myk8s-control-plane istioctl proxy-status

NAME CLUSTER CDS LDS EDS RDS ECDS ISTIOD VERSION

catalog-6cf4b97d-ftl77.istioinaction Kubernetes SYNCED SYNCED SYNCED SYNCED NOT SENT istiod-7df6ffc78d-fl492 1.17.8

catalog-v2-6df885b555-6hmcl.istioinaction Kubernetes SYNCED SYNCED SYNCED SYNCED NOT SENT istiod-7df6ffc78d-fl492 1.17.8

istio-ingressgateway-996bc6bb6-zvtdc.istio-system Kubernetes SYNCED SYNCED SYNCED SYNCED NOT SENT istiod-7df6ffc78d-fl492 1.17.8

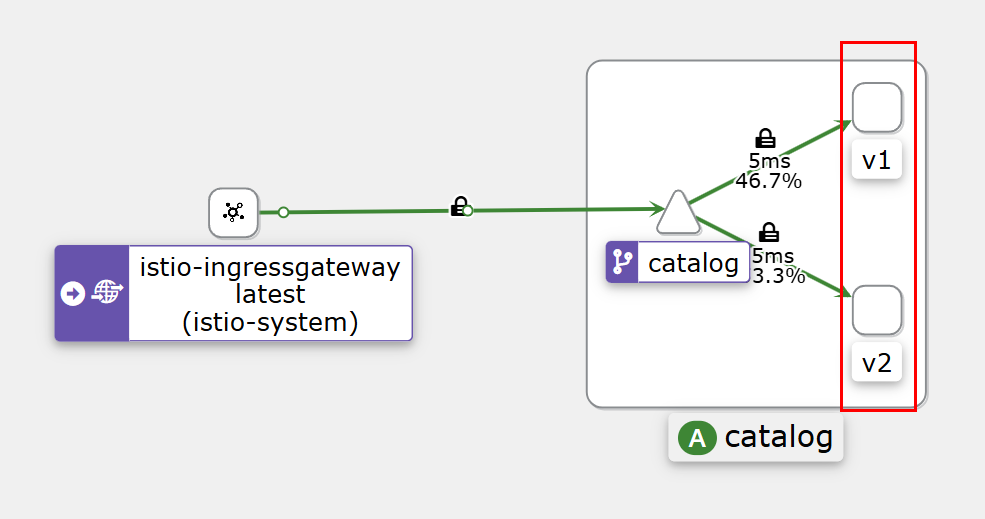

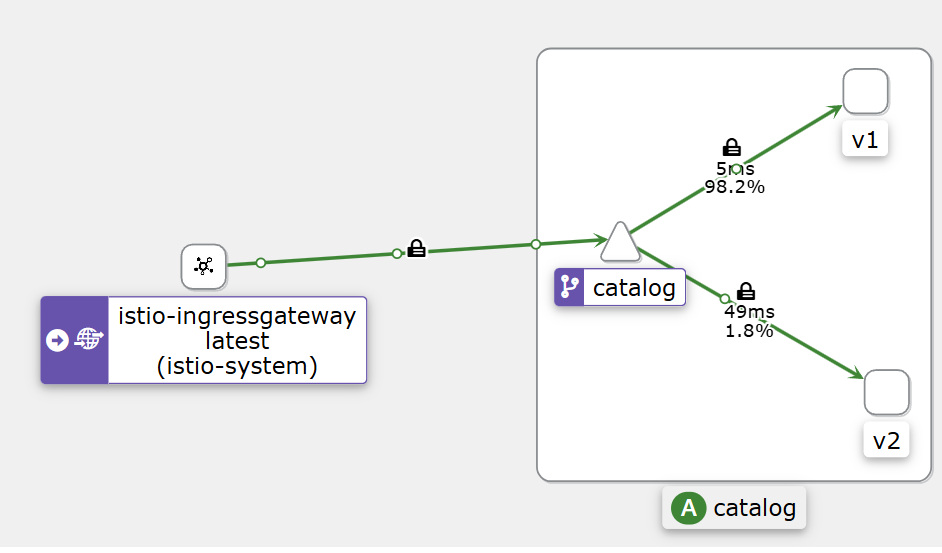

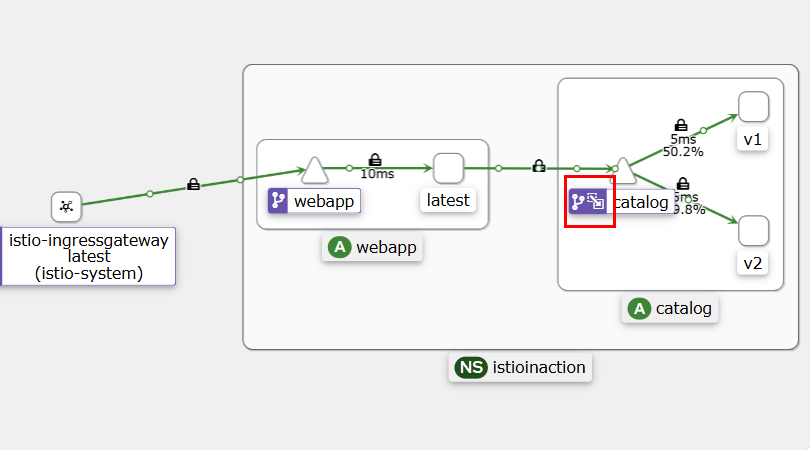

- Kiali에서 v1, v2 확인

5.2.4 Routing all traffic to v1 of the catalog service

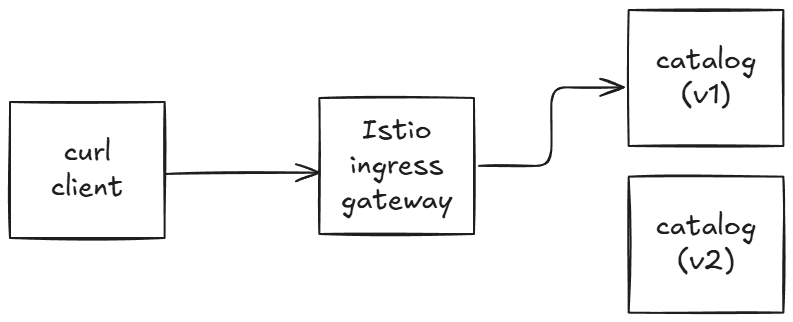

- 모든 트래픽을 catalog v1 으로 라우팅. 이것이 다크런치를 시작하기 전의 일반적인 트래픽 패턴이다.

- v1, v2가 어떤 워크로드인지 Istio에게 알려줘야한다.

- catalog v1은 deployment에서 레이블 app:catalog, version:v1을 사용

- catalog v2은 deployment에서 레이블 app:catalog, version:v2을 사용

- Istio 다른 버전들의 subset으로 지정하는 DestinationRule을 만들어준다.

cat ch5/catalog-dest-rule.yaml

apiVersion: networking.istio.io/v1alpha3

kind: DestinationRule

metadata:

name: catalog

spec:

host: catalog.istioinaction.svc.cluster.local

subsets:

- name: version-v1

labels:

version: v1

- name: version-v2

labels:

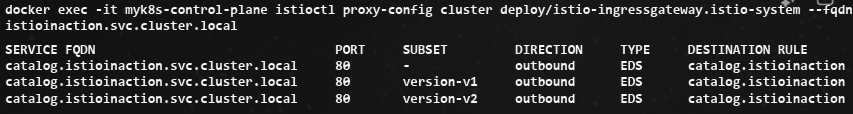

version: v2- Subset(v1, v2) 확인

-

2개의 v1, v2 Endpoint

-

v1으로 VirtualService 수정

apiVersion: networking.istio.io/v1alpha3

kind: VirtualService

metadata:

name: catalog-vs-from-gw

spec:

hosts:

- "catalog.istioinaction.io"

gateways:

- catalog-gateway

http:

- route:

- destination:

host: catalog

subset: version-v1

kubectl apply -f ch5/catalog-vs-v1.yaml -n istioinaction

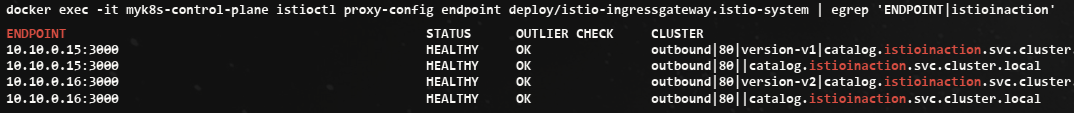

v2가 없어지고, v1만 살아있다.

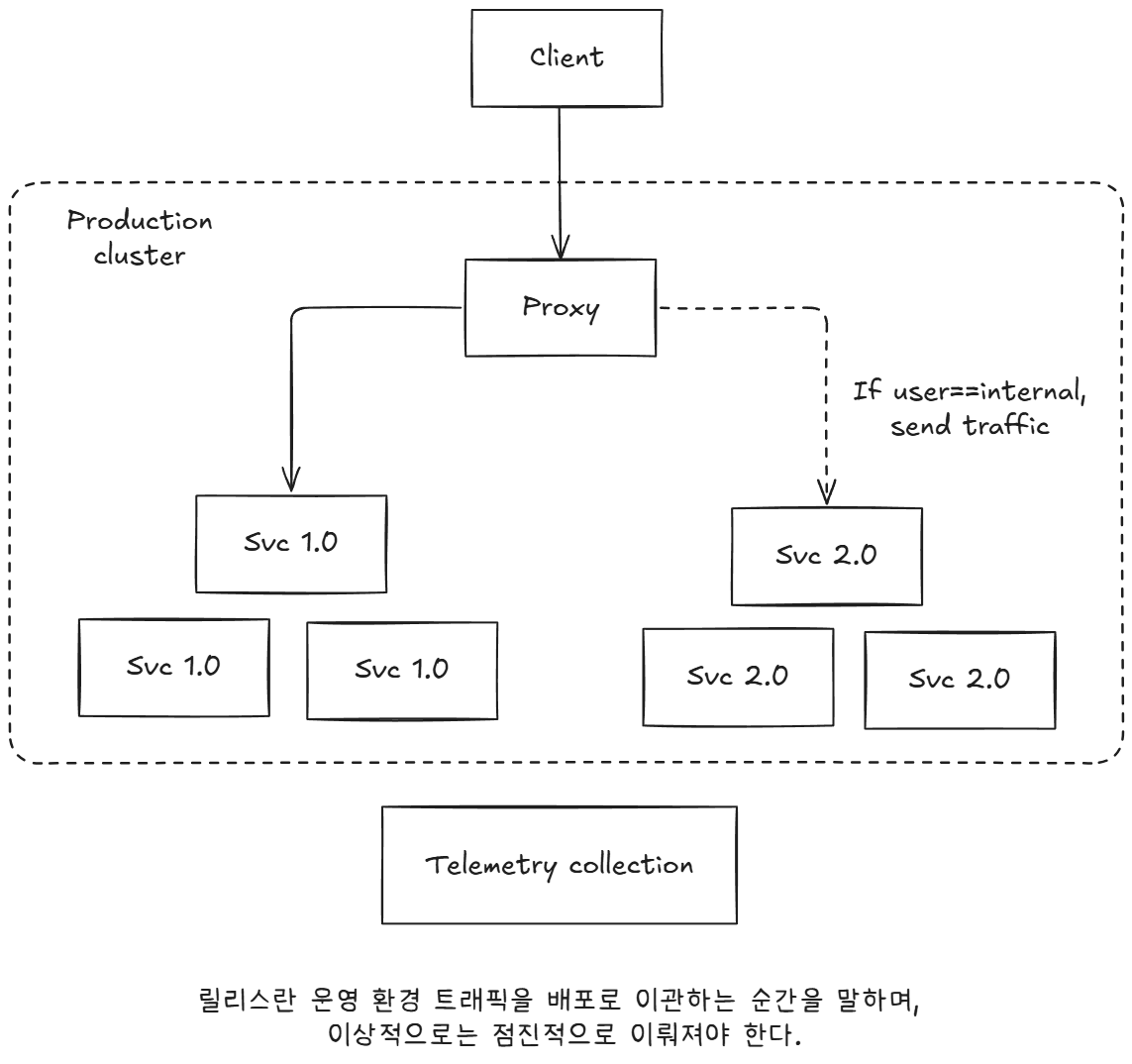

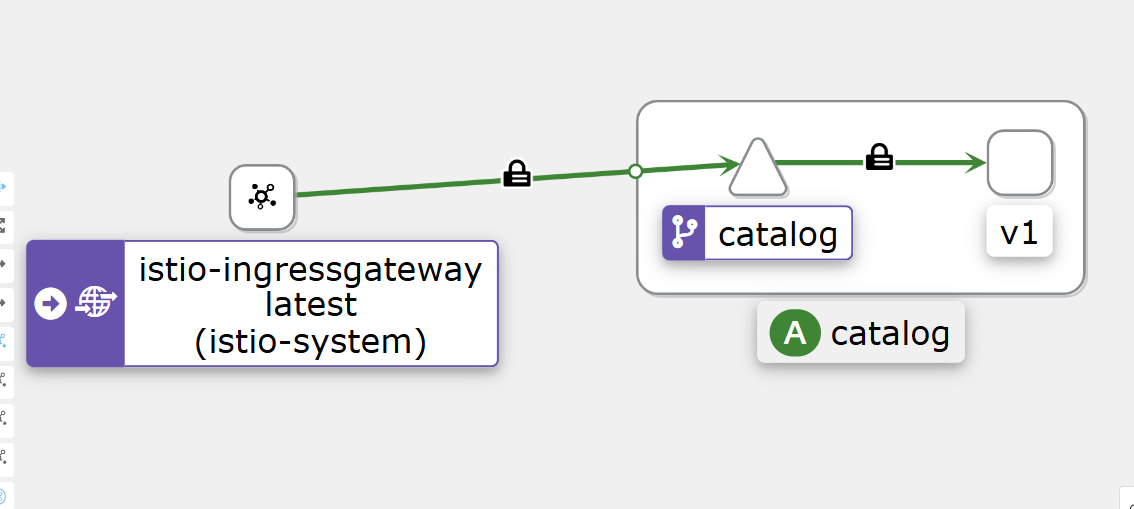

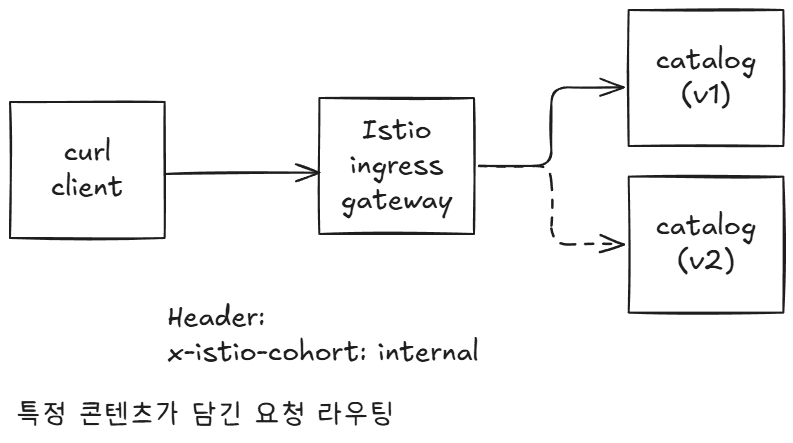

5.2.5 Routing specific requests to v2

- HTTP 요청 헤더 x-istio-cohort: internal 을 포함한 트래픽(통제된 방식)은 catalog v2로 보내기

apiVersion: networking.istio.io/v1alpha3

kind: VirtualService

metadata:

name: catalog-vs-from-gw

spec:

hosts:

- "catalog.istioinaction.io"

gateways:

- catalog-gateway

http:

- match:

- headers:

x-istio-cohort:

exact: "internal"

route:

- destination:

host: catalog

subset: version-v2

- route:

- destination:

host: catalog

subset: version-v1-

아래 Kiali에서 일부가 v2로 가는 것을 볼 수 있다.

-

동일한 2개의 route를 볼 수 있는데, 자세하게 출력하면 내용이 다르다.

-

위에서 적용되므로 순서가 중요하다.

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/istio-ingressgateway.istio-system --name http.8080

NAME DOMAINS MATCH VIRTUAL SERVICE

http.8080 catalog.istioinaction.io /* catalog-vs-from-gw.istioinaction

http.8080 catalog.istioinaction.io /* catalog-vs-from-gw.istioinaction

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/istio-ingressgateway.istio-system --name http.8080 -o json

...

"virtualHosts": [

{

"name": "catalog.istioinaction.io:80",

"domains": [

"catalog.istioinaction.io"

],

"routes": [

{

"match": {

"prefix": "/",

"caseSensitive": true,

"headers": [

{

"name": "x-istio-cohort",

"stringMatch": {

"exact": "internal"

}

}

]

},

"route": {

"cluster": "outbound|80|version-v2|catalog.istioinaction.svc.cluster.local",

"timeout": "0s",

...

{

"match": {

"prefix": "/"

},

"route": {

"cluster": "outbound|80|version-v1|catalog.istioinaction.svc.cluster.local",

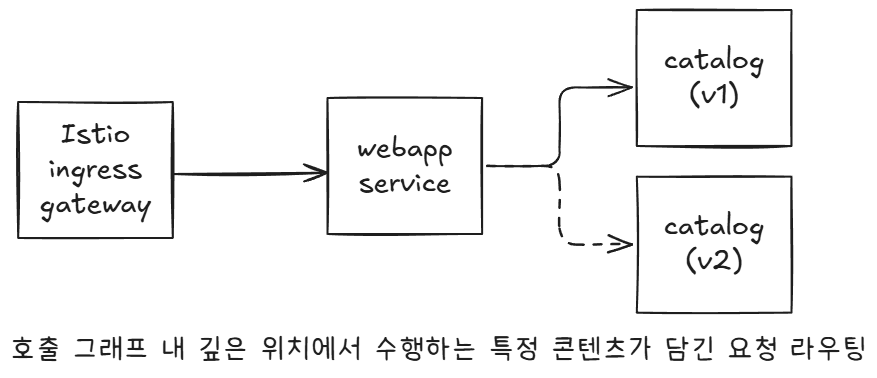

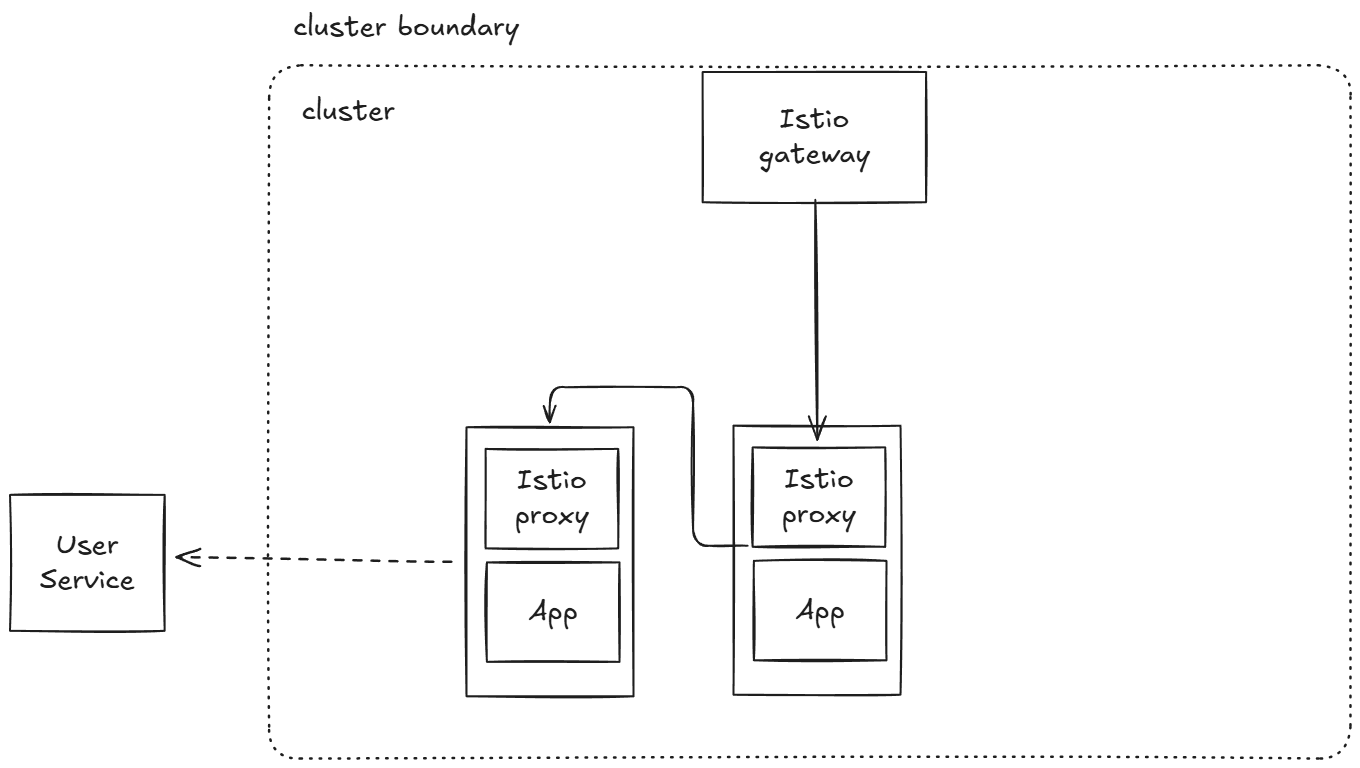

...5.2.6 Routing deep within a call graph Mesh(Gateway)

call graph

- 지금까지 라우팅 수행 위치가 Edge/Gateway였지만, call graph 내에서도 적용이 가능하다.

프로세스를 다시 만들고, 기대 동작을 확인

# 초기화

kubectl delete gateway,virtualservice,destinationrule --all -n istioinaction

# webapp 기동

kubectl apply -n istioinaction -f services/webapp/kubernetes/webapp.yaml

kubectl apply -f services/catalog/kubernetes/catalog.yaml -n istioinaction # 이미 배포 상태

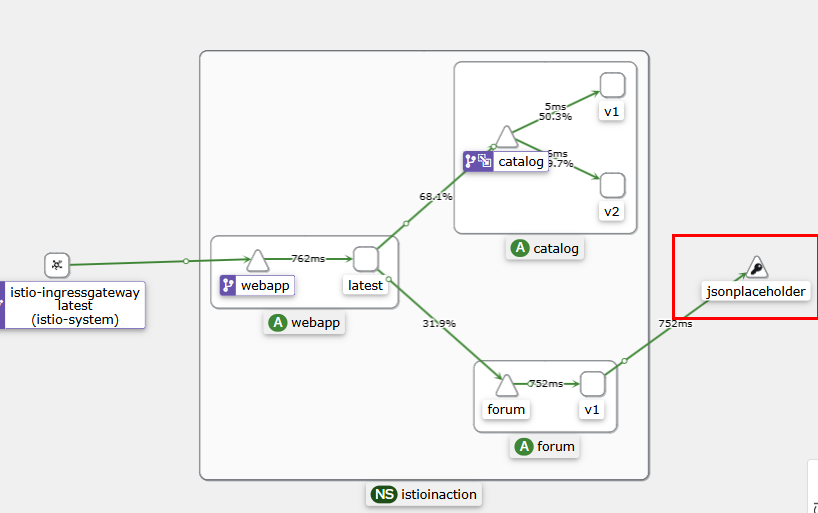

kubectl apply -f services/catalog/kubernetes/catalog-deployment-v2.yaml -n istioinaction # 이미 배포 상태- GW, VS 설정 후 호출 테스트 : webapp → catalog 는 k8s service(clusterIP) 라우팅 사용

# Now, set up the Istio ingress gateway to route to the webapp service

cat services/webapp/istio/webapp-catalog-gw-vs.yaml

---

apiVersion: networking.istio.io/v1alpha3

kind: Gateway

metadata:

name: coolstore-gateway

spec:

selector:

istio: ingressgateway # use istio default controller

servers:

- port:

number: 80

name: http

protocol: HTTP

hosts:

- "webapp.istioinaction.io"

---

apiVersion: networking.istio.io/v1alpha3

kind: VirtualService

metadata:

name: webapp-virtualservice

spec:

hosts:

- "webapp.istioinaction.io"

gateways:

- coolstore-gateway

http:

- route:

- destination:

host: webapp

port:

number: 80

kubectl apply -f services/webapp/istio/webapp-catalog-gw-vs.yaml -n istioinaction- 호출 테스트

# 호출테스트 : 외부(web, curl) → ingressgw → webapp → catalog (v1, v2)

curl -s http://webapp.istioinaction.io:30000/api/catalog | jq

# 반복 호출테스트 : 신규터미널 2개에 아래 각각 실행 해두기

while true; do curl -s http://webapp.istioinaction.io:30000/api/catalog -I | head -n 1 ; date "+%Y-%m-%d %H:%M:%S" ; sleep 1; echo; done

while true; do curl -s http://webapp.istioinaction.io:30000/api/catalog -H "x-istio-cohort: internal" -I | head -n 1 ; date "+%Y-%m-%d %H:%M:%S" ; sleep 2; echo; done- webapp istio-proxy 로그 활성화

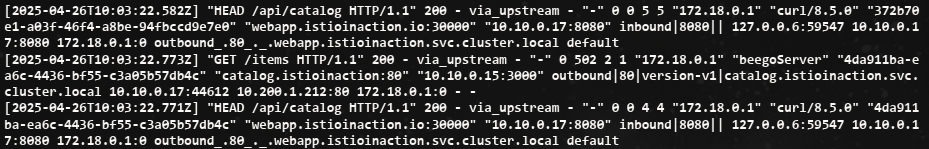

kubectl logs -n istioinaction -l app=webapp -c istio-proxy -f

# webapp istio-proxy 로그 활성화 적용

cat << EOF | kubectl apply -f -

apiVersion: telemetry.istio.io/v1alpha1

kind: Telemetry

metadata:

name: webapp

namespace: istioinaction

spec:

selector:

matchLabels:

app: webapp

accessLogging:

- providers:

- name: envoy #2 액세스 로그를 위한 프로바이더 설정

disabled: false #3 disable 를 false 로 설정해 활성화한다

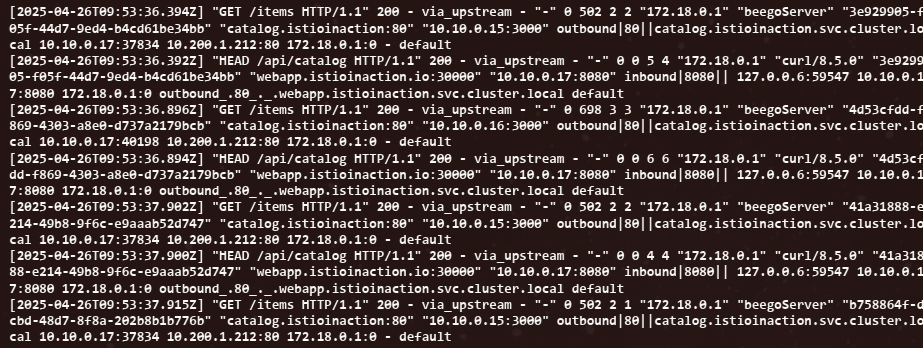

EOF-

로그 확인

webapp → catalog 는 k8s service(clusterIP) 라우팅 사용 확인

-

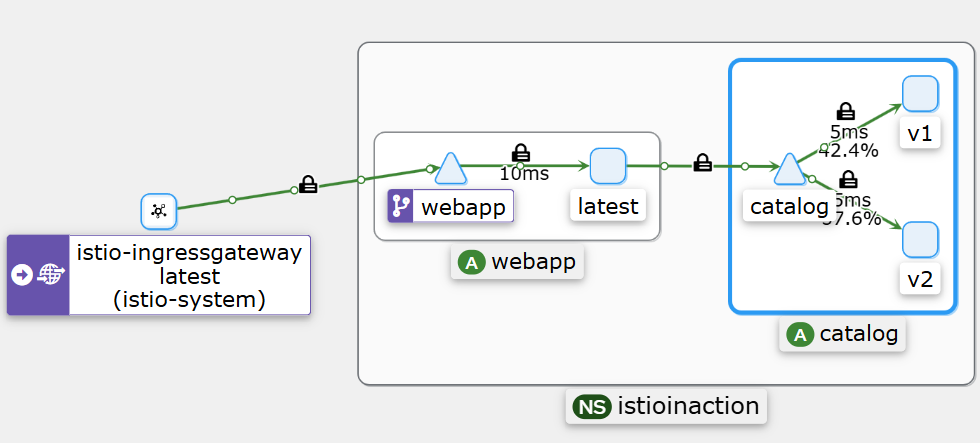

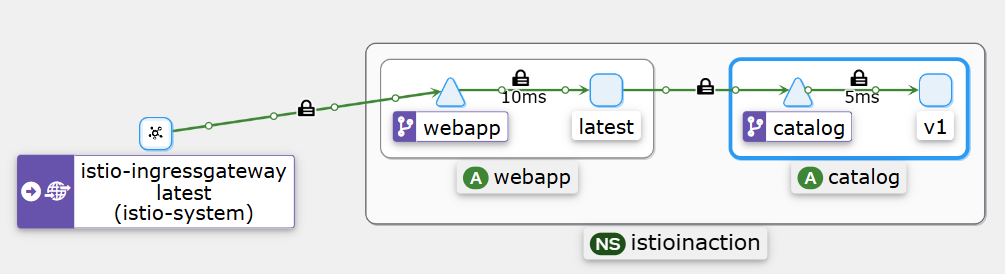

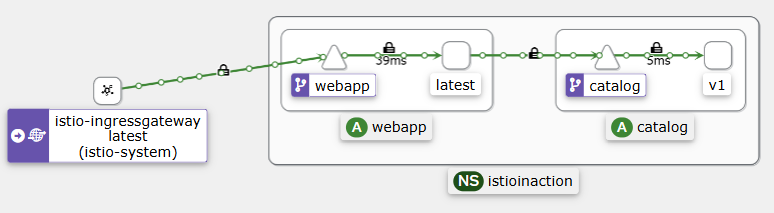

webapp을 통해 catalog로 가는 Kiali 확인

-

VirtualService와 DestinationRule 리소스로 v1으로 모든 트래픽을 보내자

ch5/catalog-dest-rule.yaml

apiVersion: networking.istio.io/v1alpha3

kind: DestinationRule

metadata:

name: catalog

spec:

host: catalog.istioinaction.svc.cluster.local

subsets:

- name: version-v1

labels:

version: v1

- name: version-v2

labels:

version: v2

kubectl apply -f ch5/catalog-dest-rule.yaml -n istioinaction

apiVersion: networking.istio.io/v1alpha3

kind: VirtualService

metadata:

name: catalog

spec:

hosts:

- catalog

gateways: # 만약, gateways 부분을 제외하고 배포하면 암묵적으로 mesh gateways가 적용됨.

- mesh # VirtualService는 메시 내의 모든 사이드카(현재 webapp, catalog)에 적용된다. edge는 제외.

http:

- route:

- destination:

host: catalog

subset: version-v1

kubectl apply -f ch5/catalog-vs-v1-mesh.yaml -n istioinaction-

로그 확인

-

모든 트래픽이 v1으로 가는 것을 Kiali에서 확인

5.3 Traffic shifting

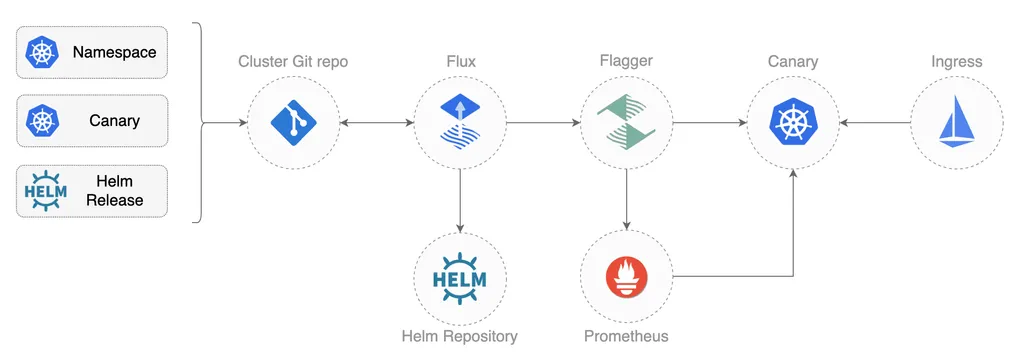

5.3.1 (Automating) Canary releasing with Flagger (Progressive Delivery Operator for Kubernetes)

- 수동 CLI로 작업하면, 휴먼 에러가 발생할 수 있다.

- Flagger는 카나리 자동화 도구로 실수를 방지할 수 있다.

-

Flagger는 서비스 상태를 판단할 때 메트릭에 의존하며, 카나리 릴리스를 사용할 때 특히 그렇다.

-

Flagger가 성공 메트릭을 사용하려면 프로메테우스를 설치해 이스티오 데이터 플레인을 수집해야 한다.

-

Flagger 설치

# CRD 설치

kubectl apply -f https://raw.githubusercontent.com/fluxcd/flagger/main/artifacts/flagger/crd.yaml

kubectl get crd | grep flagger

alertproviders.flagger.app 2025-04-19T03:11:50Z

canaries.flagger.app 2025-04-19T03:11:50Z

metrictemplates.flagger.app 2025-04-19T03:11:50Z

# Helm 설치

helm repo add flagger https://flagger.app

helm install flagger flagger/flagger \

--namespace=istio-system \

--set crd.create=false \

--set meshProvider=istio \

--set metricServer=http://prometheus:9090- catalog 서비스를 자동으로 v2로 카나리하는 절차

# 반복 호출테스트 : 신규터미널

while true; do curl -s http://webapp.istioinaction.io:30000/api/catalog -I | head -n 1 ; date "+%Y-%m-%d %H:%M:%S" ; sleep 1; echo; done

# flagger (operator) 가 catalog를 위한 canary 배포환경을 구성

kubectl apply -f ch5/flagger/catalog-release.yaml -n istioinaction

# flagger 로그 확인 : Service, Deployment, VirtualService 등을 설치하는 것을 확인할 수 있습니다.

kubectl logs -f deploy/flagger -n istio-system-

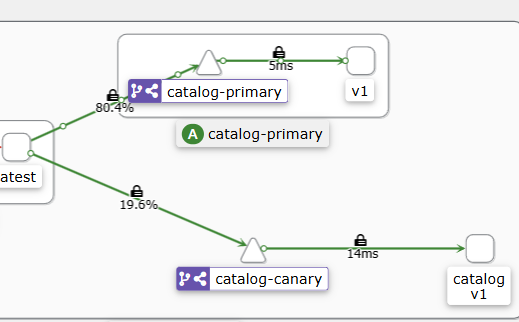

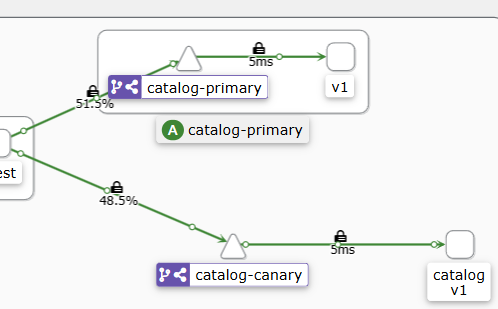

카나리를 수행하기 위해 카나리 디폴로이먼트(catalog-canary) 및 서비스(catalog-canary)를 생성하고, VirtualService 의 가중치를 조정합니다.

-

카나리는 Carary 오브젝트에 설정한 대로 45초마다 진행될 것이다.

-

트래픽의 50%가 카나리로 이동할 때까지는 단계별로 10%씩 증가한다.

-

imageUrl 출력 (v2)을 포함하는 catalog deployment v2 배포

apiVersion: apps/v1

kind: Deployment

metadata:

labels:

app: catalog

version: v1

name: catalog

spec:

replicas: 1

selector:

matchLabels:

app: catalog

version: v1

template:

metadata:

labels:

app: catalog

version: v1

spec:

containers:

- env:

- name: KUBERNETES_NAMESPACE

valueFrom:

fieldRef:

fieldPath: metadata.namespace

- name: SHOW_IMAGE

value: "true"

image: istioinaction/catalog:latest

imagePullPolicy: IfNotPresent

name: catalog

ports:

- containerPort: 3000

name: http

protocol: TCP

securityContext:

privileged: false

kubectl apply -f ch5/flagger/catalog-deployment-v2.yaml -n istioinaction-

트래픽 라우팅 가중치가 점점 변경된다.

-

프로메테우스의 카나리 가중치

Flagger를 사용해 이스티오의 API로 카나리 릴리스를 자동 제어함으로써, 리소스를 직접 설정하는 등 설정 오류를 일으킬 수 있는 수작업의 필요성을 없앴다. 또한 Flagger는 다크 런치 테스트, 트래픽 미러링(다음 절에서 설명한다) 등도 할 수 있다.

5.4 Reducing risk even further: Traffic mirroring

트래픽 미러링

- 앞서 살펴본 요청 수준 라우팅과 트래픽 전환이라는 두 가지 기술을 사용하면 릴리스의 위험성을 낮출 수 있다.

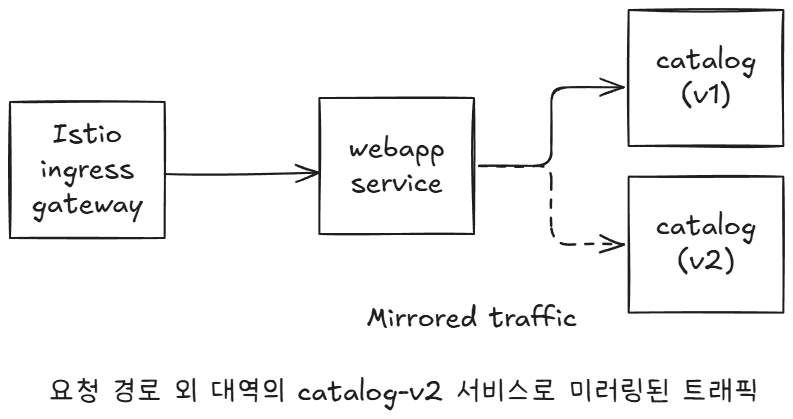

- 또 다른 방법은 운영 환경 트래픽을 새 디플로이먼트로 미러링하는 것인데, 운영 환경 트래픽을 복사해 고객 트래픽 범위 외부의 새 디플로이먼트로 보내는 것이다. (아래 그림 참조)

미러링 방식을 사용하면, 실제 운영 환경 트래픽을 배포로 보냄으로써 사용자에게 영향을 주지 않고 새 코드가 어떻게 동작할지에 대한 실제 피드백을 얻을 수 있다.

미러링 실습

kubectl apply -f services/catalog/kubernetes/catalog-svc.yaml -n istioinaction

kubectl apply -f services/catalog/kubernetes/catalog-deployment.yaml -n istioinaction

kubectl apply -f services/catalog/kubernetes/catalog-deployment-v2.yaml -n istioinaction

kubectl apply -f ch5/catalog-dest-rule.yaml -n istioinaction

kubectl apply -f ch5/catalog-vs-v1-mesh.yaml -n istioinaction

# 반복 접속

while true; do curl -s http://webapp.istioinaction.io:30000/api/catalog -I | head -n 1 ; date "+%Y-%m-%d %H:%M:%S" ; sleep 1; echo; done

# catalog v1 으로만 접속 확인

for i in {1..100}; do curl -s http://webapp.istioinaction.io:30000/api/catalog | grep -i imageUrl ; done | wc -l

apiVersion: networking.istio.io/v1alpha3

kind: VirtualService

metadata:

name: catalog

spec:

hosts:

- catalog

gateways:

- mesh

http:

- route:

- destination:

host: catalog

subset: version-v1

weight: 100

mirror:

host: catalog

subset: version-v2-

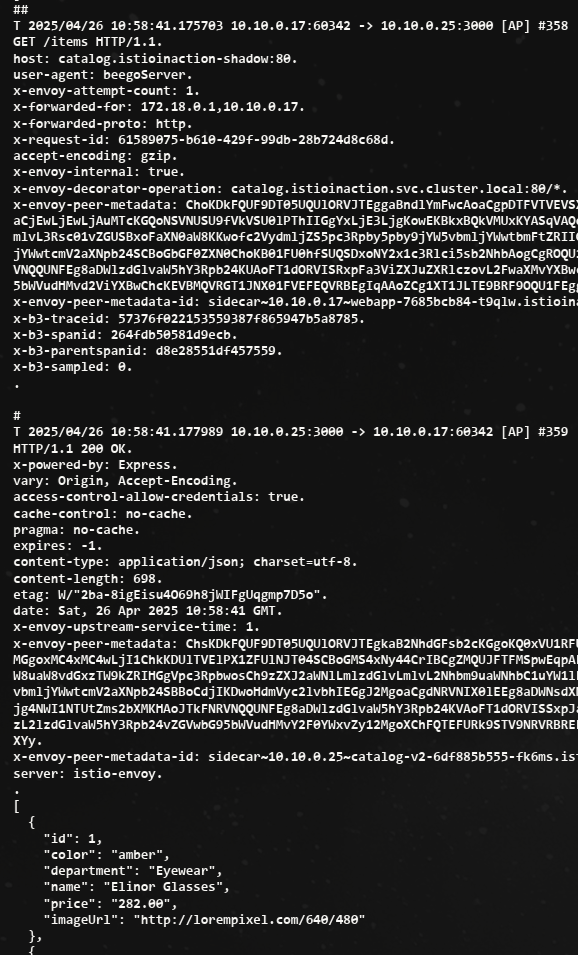

이 VS는 라이브 트래픽을 전부 catalog(v1)으로 보내지만, 동시에 v2로도 미러링한다.

-

미러링은 요청의 복사복을 만들어 미러링된 클러스터(여기서는 catalog-v2)로 전송하는 이른바 ‘보내고 잊는 방식’으로 수행된다.

-

미러링된 요청은 실제 요청에는 영향을 줄 수 없는데, 미러링을 수행하는 이스티오 프록시가 미러링된 클러스터에서 오는 응답을 모두(성공인든, 실패든) 무시해버리기 때문이다.

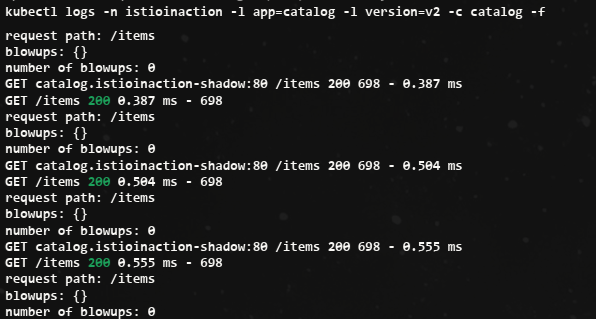

-

v2 app의 로그를 보면 -shadow 접미사 요청이 확인된다.

- 요청과 응답 결과

미러링 대상 서버는 응답을 안하는게 좋지만, 만약 응답을 webapp 파드에 한다 해도, webapp은 받고 나서 무시(drop?) 처리함.

- 트래픽 미러링은 릴리스의 위험성을 낮추는 방법 중 하나다.

- 요청 라우팅 및 트래픽 전환과 마찬가지로 애플리케이션은 상황을 인지해 실제와 미러링 모드 모두로 동작하거나, 여러 버전으로 동작하거나, 혹은 둘 다 모두 할 수 있어야 한다.

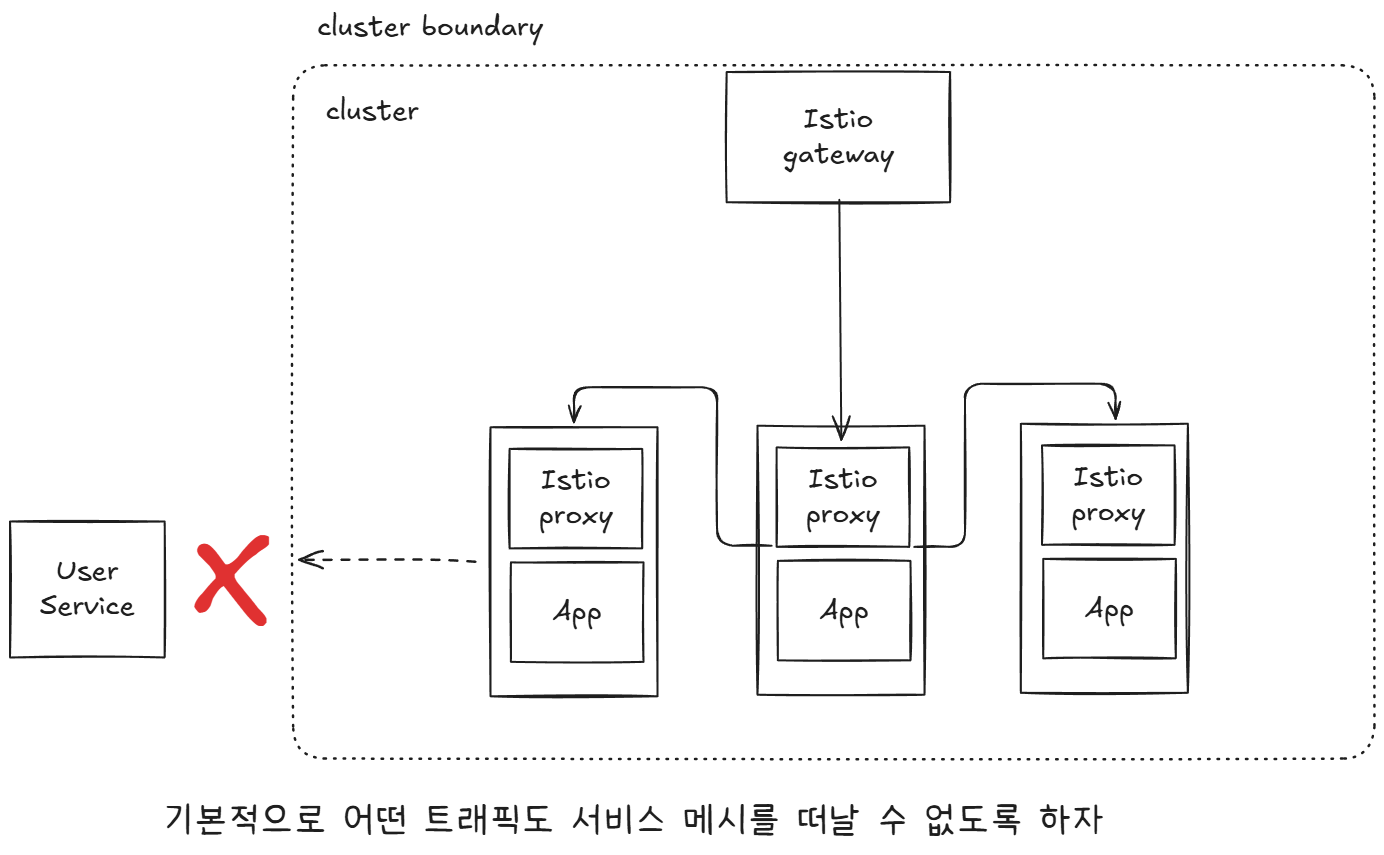

5.5 Routing to services outside your cluster by using Istio’s service discovery

실습

외부 트래픽을 차단하도록 이스티오를 설정해 메시에 간단한 보호 계층을 더해보자

# 현재 istiooperators meshConfig 설정 확인

kubectl get istiooperators -n istio-system -o json

...

"meshConfig": {

"defaultConfig": {

"proxyMetadata": {}

},

"enablePrometheusMerge": true

},

...

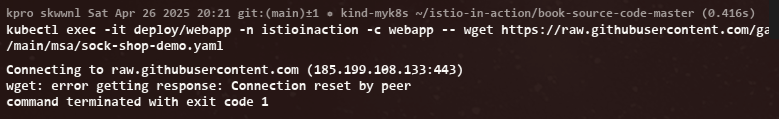

# webapp 파드에서 외부 다운로드

kubectl exec -it deploy/webapp -n istioinaction -c webapp -- wget https://raw.githubusercontent.com/gasida/KANS/refs/heads/main/msa/sock-shop-demo.yaml

# webapp 로그 : 신규 터미널

kubectl logs -n istioinaction -l app=webapp -c istio-proxy -f

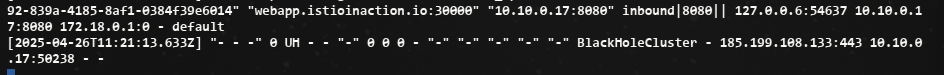

[2025-04-19T09:55:34.851Z] "- - -" 0 UH - - "-" 0 0 0 - "-" "-" "-" "-" "-" BlackHoleCluster - 185.199.109.133:443 10.10.0.19:34868 - -

# 다음 명령을 실행해 이스티오의 기본값을 ALLOW_ANY 에서 REGISTRY_ONLY 로 바꾸자.

# 이느 서비스 메시 저장소에 명시적으로 허용된 경우(화이트 리스트)에만 트래픽이 메시를 떠나도록 허용하겠다는 의미다.

# 아래 설정 방법 이외에도 IstioOperator 로 설정을 변경하거나, istio-system 의 istio configmap 을 변경해도 됨.

# outboundTrafficPolicy 3가지 모드 : ALLOW_ANY (default) , REGISTRY_ONLY , ALLOW_LIST

docker exec -it myk8s-control-plane bash

----------------------------------------

istioctl install --set profile=default --set meshConfig.outboundTrafficPolicy.mode=REGISTRY_ONLY

y - 차단 로그

외부 다운로드와 차단 로그

BlackHoleCluster 차단을 볼 수 있다.

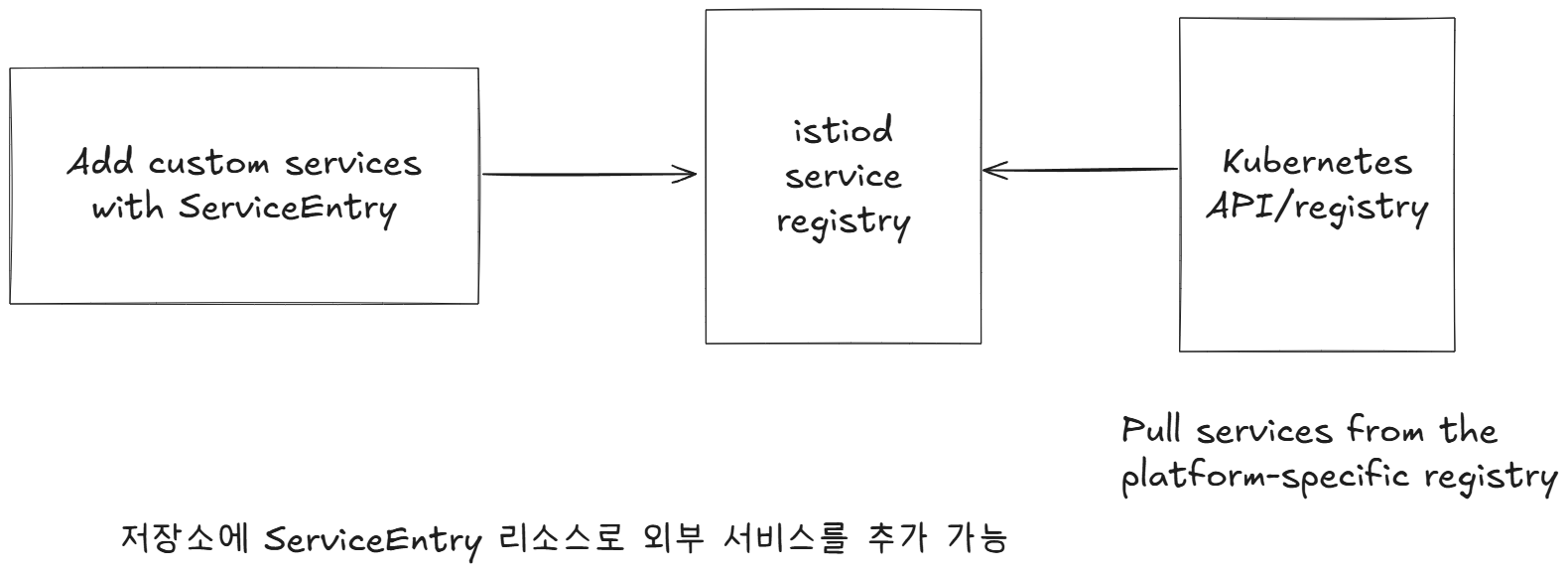

ServiceEntry

Istio의 서비스 디스커버리 기능을 사용해 클러스터 외부의 서비스로 라우팅하기

Istio 외부에 위치한 서비스에 대해서도 정교한 라우팅을 구현할 수 있다.

- Istio는 내부 서비스 저장소 internal service registry 를 구축하는데, 여기에는 메시에서 인지하고 접근할 수 있는 모든 서비스가 들어 있다.

- 이 저장소가 메시 내 서비스가 다른 서비스를 찾는 데 사용 할 수 있는 서비스 디스커버리 저장소의 공식적인 표현이라고 생각해도 좋다.

- 기본 쿠버네티스 API를 사용해 자신의 서비스 카탈로그를 구축한다.

istiod는 k8s api (Service 리소스)를 통해서 서비스/엔드포인트 정보를 동적으로 발견/획득

실습

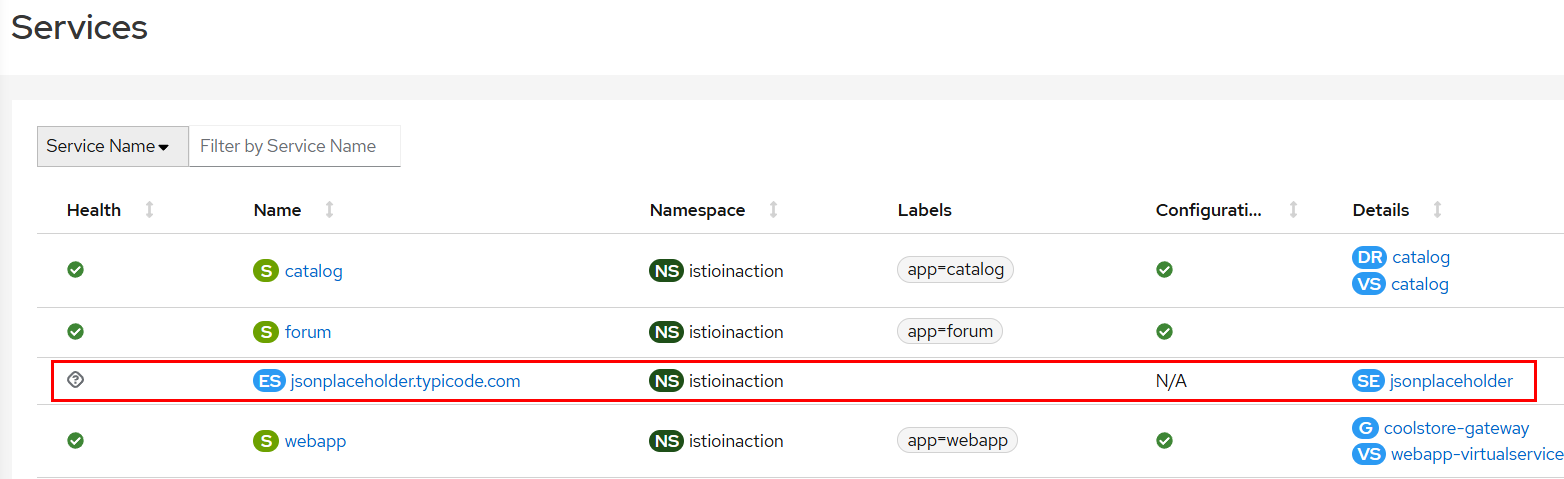

- jsonplaceholder.typicode.com 을 사용하는 예시 포럼 애플리케이션을 설치하자.

# forum 설치

cat services/forum/kubernetes/forum-all.yaml

kubectl apply -f services/forum/kubernetes/forum-all.yaml -n istioinaction

# 확인

kubectl get deploy,svc -n istioinaction -l app=webapp

docker exec -it myk8s-control-plane istioctl proxy-status

- Forum 서비스 호출

# 메시 안에서 새로운 포럼 서비스를 호출

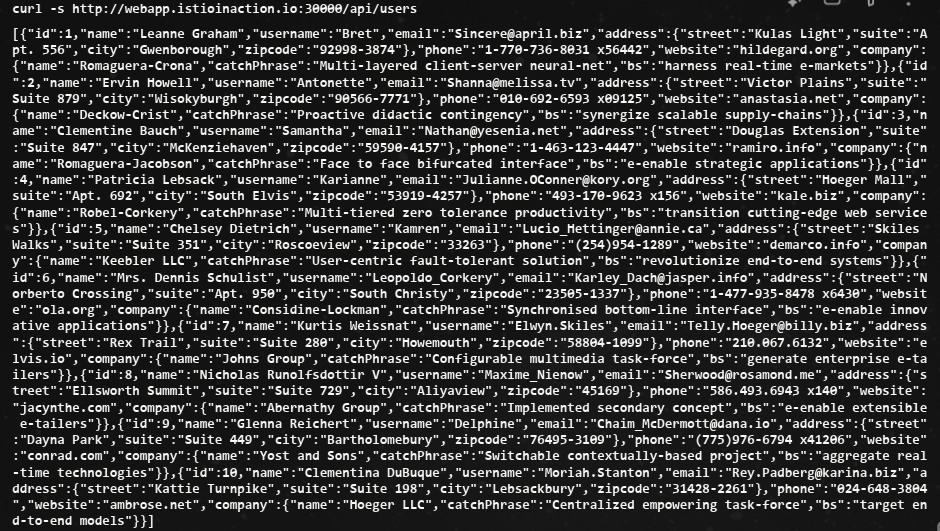

curl -s http://webapp.istioinaction.io:30000/api/users

error calling Forum service

# forum 로그 확인

kubectl logs -n istioinaction -l app=forum -c istio-proxy -f"GET /users HTTP/1.1" 502 - direct_response - "-" 0 0 0 - "172.18.0.1" "Go-http-client/1.1" "04bef923-b182-94e9-a58d-e2d9f957693b" "jsonplaceholder.typicode.com" "-" - - 104.21.48.1:80 172.18.0.1:0 - block_all

# 클러스터 내부 서비스에서 외부 도메인(jsonplaceholder.typicode.com) 으로 나가려 했지만, Istio가 요청을 막아서 502 오류와 함께 직접 응답 처리한 상황

## direct_response : Envoy가 요청을 외부로 보내지 않고 자체적으로 차단 응답을 반환했음을 의미

## block_all : Istio에서 egress(외부) 요청이 전면 차단됨을 나타내는 메시지"GET /api/users HTTP/1.1" 500 - via_upstream - "-" 0 28 0 0 "172.18.0.1" "beegoServer" "04bef923-b182-94e9-a58d-e2d9f957693b" "forum.istioinaction:80" "10.10.0.31:8080" inbound|8080|| 127.0.0.6:60487 10.10.0.31:8080 172.18.0.1:0 - default- 호출 허용을 위해 jsonplaceholder.typicode.com 호스트에 이스티오 ServiceEntry 리소스를 만들 수 있다.

아래처럼 호출 결과를 볼 수 있다.

Summary

- DestinationRule 로 워크로드를 v1, v2 버전과 같이 더 작은 부분집합들로 분리할 수 있다.

- VirtualService는 이런 부분집합들을 사용해 트래픽을 세밀하게 라우팅한다.

- VirtualService는 HTTP 헤더 같은 애플리케이션 계층 정보를 기반으로 라우팅 결정을 설정한다.

- 이 덕분에 베타 테스터 같은 특정 사용자 집합을 서비스의 신 버전으로 보내 테스트하는 다크 런치 기법을 사용할 수 있다.

- 가중치 라우팅(VirtualService 리소스로 설정)을 사용하는 서비스 프록시는 트래픽을 점진적으로 새 배포로 라우팅할 수 있는데, 덕분에 카나리 배포(트래픽 전환이라고도 함) 같은 방법을 사용할 수 있다.

- 트래픽 전환은 Flagger를 사용해 자동화할 수 있다. Flagger는 수집한 메트릭을 사용해 새 배포로 라우팅되는 트래픽을 점진적으로 늘리는 오픈소스 솔루션이다.

- outboundTrafficPolicy 를 REGISTER_ONLY로 설정하면 어떤 트래픽도 클러스터를 떠나지 못하게 함으로써 악의적인 사용자가 외부로 정보를 전송하는 것을 방지할 수 있다.

- outboundTrafficPolicy 를 REGISTER_ONLY로 설정했을 때는 ServiceEntry로 외부로 향하는 트래픽을 허용할 수 있다.