LangChain을 활용한 AI/LLM 서비스 개발 학습하기.

LangChain을 활용한 AI/LLM 서비스 개발에서 유지보수성과 성능을 최적화하는 실전에서 반드시 고려해야 할 핵심 요소들입니다.

아래는 실무에서 바로 적용할 수 있는 구조적 설계, 코드 품질, 성능 개선 전략을 정리한 가이드입니다.

유지보수 가능한 LangChain 코드 작성

모듈화와 체인/에이전트 분리

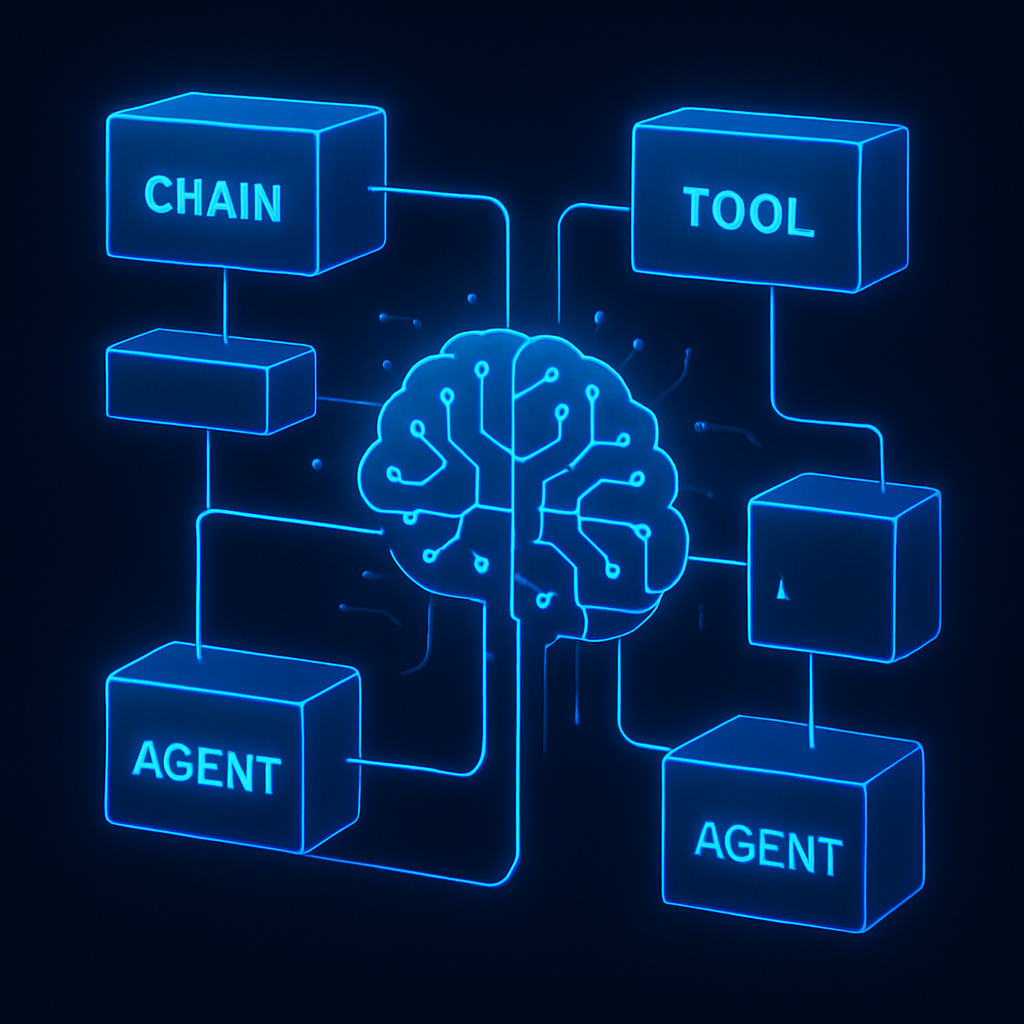

- 기능별로 체인(Chain), 도구(Tool), 에이전트(Agent) 분리

- 예: 데이터 전처리, 검색, LLM 프롬프트, 결과 해석을 각 단계별로 별도 모듈화

- 클린 구조 예시

/chains

/preprocessing_chain.py

/retrieval_chain.py

/reasoning_chain.py

/tools

/embedding_tool.py

/db_tool.py

/agents

/recommendation_agent.py

/utils

/logger.py

/config.py

main.py명확한 타입 힌트와 추상화

- 장점: 각 모듈 독립적 테스트, 교체, 확장 용이

- 타입 힌트 예시

def recommend(user_id: str, items: List[dict]) -> List[dict]:- 주요 체인/에이전트는 사용 예시, 입력/출력 포맷, 예외 처리 등 상세 주석 작성

성정값과 하드코딩 분리

- API 키, 임베딩 모델명, DB 주소 등은 config.py 또는 환경변수로 관리

- 하드코딩 대신 설정 파일/클래스 사용

테스트 코드와 예제 작성

- 각 체인/에이전트별 단위 테스트, 통합 테스트 작성

- example/ 폴더에 실제 사용 예시 코드 제공

로깅 및 예외 처리

- 표준 로깅(logging 모듈)으로 주요 이벤트, 오류, 성능 메트릭 기록

- try-except로 LLM 호출, DB 연결 등 외부 의존성 예외 처리

LangChain 성능 최적화

임베딩/검색 최적화

- 벡터 DB(Chroma, Pinecone 등) 활용: 대량 데이터에서 빠른 유사도 검색

- 임베딩 캐싱: 동일 쿼리/문서에 대한 임베딩 재사용

from langchain.cache import SQLiteCache

import langchain

langchain.llm_cache = SQLiteCache("llm_cache.db")- Batch 처리: 임베딩, 검색, LLM 호출을 일괄 처리해 네트워크/연산 병목 최소화

LLM 호출 비용/속도 관리

- 스트리밍 응답: 대용량 텍스트는 스트리밍으로 부분 응답 처리

- 프롬프트 최적화: 불필요한 부작, 어이각 줄이기(프롬프트 엔지니어링)

- 적절한 모델 선택: gpt-4o, gpt-3.5 등 용도 성능/비용 모델 사용

- 비동기 호출: async/await로 LLM, DB, API 호출 동시 처리

체인/에이전트 병렬화 및 분산처리

- 업무프로세스/스케줄: 대량 요청 처리 시 Python concurrent.futures 등 활용

- 분산 에이전트: Celery, Ray, FastAPI 등으로 분산 아키텍처 설계

모니터링 및 자동화

- 성능 모니터링: 응답 시간, 오류율, LLM 토큰 사용량 등 실시간 추적

- 자동화된 테스트/배포(CI/CD): GitHub Actions, pytest 등으로 품질 유지

실전 베스트 프랙티스

체인/에이전트 재사용성

- 공통 로직은 별도 모듈로 추출, 다양한 워크플로우에서 재활용

- 프롬프트 엔지니어링 자동화: 프롬프트 템플릿화, 변수 치환, 버전 관리

- 피드백 루프: 사용자 피드백/실제 사례 자동 수집 → 체인 개선에 반영

- 문서화: README, docstring, 예제 코드 등으로 팀/커뮤니티 협업 강화

예시 코드 구조

chains/recommendation_chain.py

from langchain.chains import LLMChain

from langchain.prompts import PromptTemplate

recommend_prompt = PromptTemplate(

input_variables=["profile", "candidates"],

template="""

사용자 프로필: {profile}

추천 아이템: {candidates}

가장 적합한 추천 개와 이유를 설명해주세요.

"""

)

recommend_chain = LLMChain(prompt=recommend_prompt, llm=llm)main.py

from chains.recommendation_chain import recommend_chain

def main():

profile = "SF, 스릴러, 복잡한 스토리 선호"

candidates = ["인셉션", "인터스텔라", "라라랜드"]

result = recommend_chain.run(profile=profile, candidates=", ".join(candidates))

print(result)마무리

LangChain 프로젝트의 유지보수성과 성능을 모두 잡으려면 모듈화, 명확한 타입/주석, 테스트, 설정 분리, 캐싱, 병렬화, 모니터링 등 실전 개발 원칙을 반드시 지켜야 합니다.

이런 구조적 설계가 장기적으로 빠른 개선, 비용 절감, 고품질 서비스로 이어집니다.