SEMI-SUPERVISED CLASSIFICATION WITH GRAPH CONVOLUTIONAL NETWORKS

https://arxiv.org/pdf/1609.02907v4.pdf

Propagation

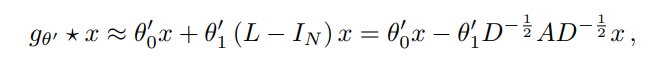

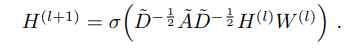

GCN에는 다음과 같은 propagation rule(layer-wise)이 존재한다.

= : undirected graph G에 self-connection을 추가한 것

: adjacency matrix

: activation function

: degree matrix

: layer-specific learnable weight matrix

=

해당 propagation rule은 first-order approximation of localized spectral filters on graph에 의해 motivated 되었다.

https://arxiv.org/pdf/1606.09375.pdf

SPECTRAL GRAPH CONVOLUTIONS

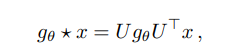

논문에서 말하는 convolution 연산은 다음과 같은 eigen decompostion을 말한다 : 푸리에 변환

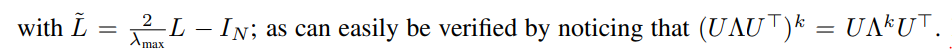

위의 propagation rule을 고려하면, 라고 표현할 수 있다.

: normalized된 Laplacian의 eigenvector들로 구성된 matrix

Laplacian matrix = Degree matrix - Adjacency matrix

를 구하는 computational cost =

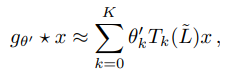

의 cost도 비싸기 때문에 아래와 같은 근사법이 제시됨.

[-1,1] 범위의 Orthogonal basis인 K번째 chebyshev polnomial 까지만 고려해서 근사한다.

= 0 (n != m)

: k번째 basis 방향으로 내적 coefficient

예를들어, &