오늘의 주요 내용

- 활성화 기능과 신경망에서 사용할 수 있는 활성화 기능의 예시

- 예시 중 어느 기능이 신경망에서 가장 흔하게 사용되는지

- 입력 값의 가중 합계를 계산하는 데 활설화 함수를 적용하고 다음 뉴런에 신호를 전달하는데, 이때 사용되는 함수에 대해 알아봅시다.

활성화 함수의 네 가지 유형

➡️ 네 가지보다 더 많은 유형의 함수가 있지만, 가장 많이 사용되는 것들 위주로 알아봅시다.

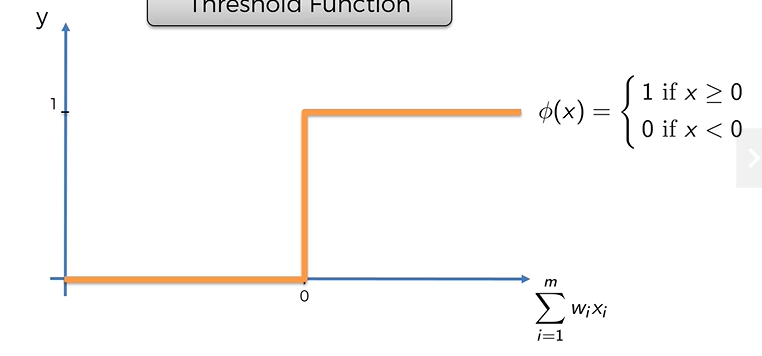

1. Threshold Function

- x축 : 입력값의 가중 합계

- y축 : 0 ~ 1 사이의 값

Threshold Function은 값이 0보다 작으면 0을 전달하고, 0보다 크거나 같으면 1을 전달한다.

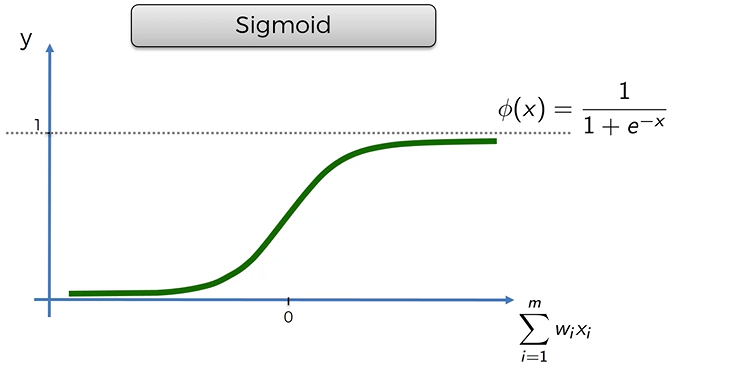

2. Sigmoid

- x축 : 가중 합계의 값

- y축 : 0 ~ 1 사이의 값

- 로지스틱 회귀에서 사용하는 함수다.

< 특징 >

- 매끄럽다. 곡선에 꼬임이 없어서 매끄럽고 점진적으로 진행된다.

- 0 아래면 무조건 없는 셈 치고 0이상이면 1에 가까워진다.

- 마지막 층인 출력층에 아주 유용하다. 특히 확률을 예측할 때 유용함.

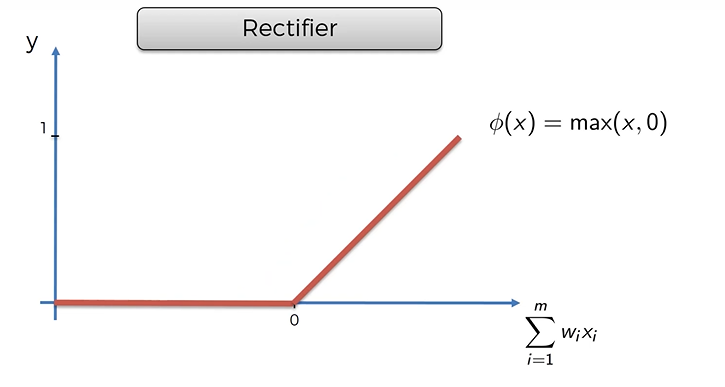

3. Rectifier

- 꼬임이 있긴 하지만 인공 신경망에서 가장 유명한 함수 중 하나이다.

- x축 값이 0이 되면 거기서부터 입력값이 증가하면서 서서히 진행된다.

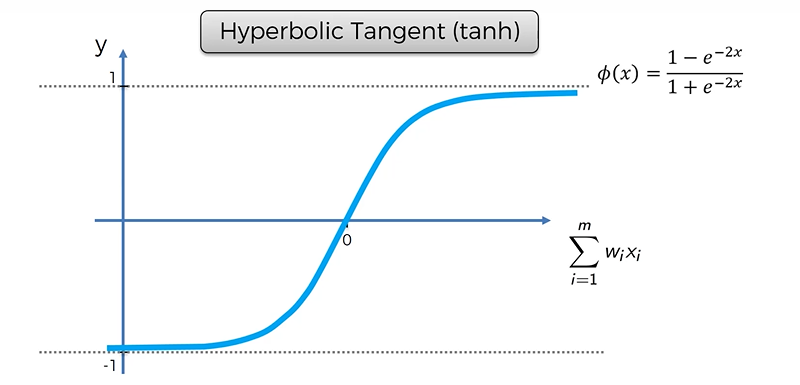

4. Hyperbolic Tangent (tanh)

- 시그모이드 함수와 아주 비슷하게 생겼다 ! 하지만 값이 0 아래로 내려간다는 차이가 있다.

- x값이 양수이면 0 ~ 1 사이 값을, 음수이면 0 ~ -1 사이의 값을 갖는다.

- 특정 응용 프로그램에서 유용하게 사용된다.

Rectifier 관련 추가 내용

2011년에 발표된 "Deep sparse rectifier neural networks" 논문 참고