Fine-tuning의 트레이드오프 및 일반화 성능 저하 현상

Fine-tuning은 사전 훈련된 모델을 특정 데이터셋에 맞춰 추가적으로 훈련하는 과정으로, 특정 도메인 또는 태스크에 대한 적합성(domain adaptation) 을 극대화할 수 있다. 그러나, 훈련 데이터에 대한 가중치를 높이는 과정에서 모델의 일반화 성능(generalization performance)이 저하될 위험이 존재한다.

Fine-tuning 시, 훈련 데이터의 분포에 과적합(overfitting)하거나, 사전 학습(pretrained)된 모델이 갖고 있던 범용적인 지식이 희석되는(knowledge forgetting, catastrophic forgetting) 현상이 발생할 수 있다. 이는 다음과 같은 원인으로 설명할 수 있다:

-

데이터 편향(Data Bias) 증가

- 특정 도메인에 맞춰 최적화되면서, 원래 모델이 학습했던 다양한 데이터 분포를 일반화하는 능력이 감소할 수 있음.

-

모델 가중치 업데이트의 불균형

- Fine-tuning 과정에서 특정 피처(feature)나 패턴에 대한 가중치가 급격히 변화하면서, 원래 모델이 보유하던 범용적인 표현 학습 능력이 상실될 수 있음.

-

표현 학습(Expression Learning) 손실

- 사전 훈련된 모델은 다양한 자연어 패턴을 학습한 상태이나, fine-tuning이 진행될수록 특정 태스크에 특화된 표현만 남고, 다른 태스크에서의 성능이 저하될 가능성이 있음.

-

파라미터 업데이트 범위 및 전략

- Fine-tuning 시 전이 학습(transfer learning) 방식에 따라 성능 저하를 방지할 수 있음.

- Full fine-tuning: 모든 가중치를 업데이트 → 성능 저하 위험 증가

- Layer-wise unfreezing: 특정 레이어만 업데이트 → 일부 일반화 유지 가능

- Adapters (LoRA, Prefix-tuning 등): 기존 가중치는 유지하면서 작은 네트워크 추가 → 범용성과 특화성 균형 유지 가능

- Fine-tuning 시 전이 학습(transfer learning) 방식에 따라 성능 저하를 방지할 수 있음.

✅ 결론

Fine-tuning을 진행할 경우, 도메인 적합성(domain specificity)과 범용성(generalization)의 균형을 고려한 전략적 접근이 필수적이다.

- 특정 도메인 특화 모델을 만들 때는 fine-tuning이 유용하지만,

- 범용적인 성능을 유지하고자 할 경우, few-shot learning, parameter-efficient tuning(LoRA, adapters) 등을 활용하는 것이 효과적일 수 있다.

👉 핵심 요약

Fine-tuning은 특정 데이터셋에서의 성능을 극대화하지만, 모델이 갖고 있던 원래의 범용적 지식이 희석될 위험이 있다. 따라서, 과적합을 방지하고 범용성을 유지하기 위한 정교한 전략(Layer-wise tuning, LoRA, Adapters 등)이 필요하다. 🚀

Fine-tuning과 RAG의 트레이드오프

Fine-tuning은 특정 태스크 또는 도메인에 대한 적합성을 높이는 강력한 방법이지만, Retrieval-Augmented Generation (RAG) 같은 정보 검색 기반 생성 모델과의 조합에서는 신중한 접근이 필요하다. Fine-tuning이 가져올 수 있는 모델의 과적합 문제와 범용성 저하는 RAG 시스템의 핵심 가치인 최신 정보 활용과 유연한 지식 확장성에 영향을 미칠 수 있기 때문이다.

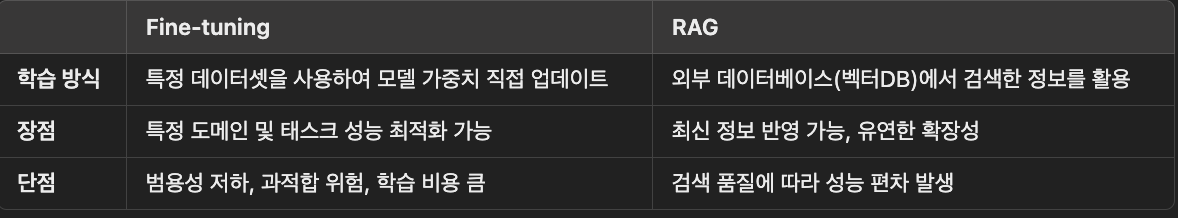

📌 1️⃣ Fine-tuning과 RAG의 역할 비교

Fine-tuning은 모델이 특정 태스크에 최적화되는 대신, 원래 모델이 보유하던 범용적인 언어 이해 능력(General Knowledge) 이 희석될 수 있음.

RAG는 Fine-tuning 없이도 외부 데이터베이스를 검색하여 최신 정보를 반영할 수 있어, 지속적인 업데이트가 필요한 경우 더욱 적합함.

📌 2️⃣ Fine-tuning을 적용한 RAG의 문제점

Fine-tuning이 RAG에 적용될 때 다음과 같은 문제점이 발생할 수 있다.

1️⃣ Knowledge Forgetting (지식 소실)

Fine-tuning을 통해 모델이 특정 데이터셋에 최적화되면,

📉 사전 학습(pretrained)된 모델이 보유하던 다양한 지식이 희석될 가능성이 있음.

👉 이는 RAG의 검색 없이도 특정 도메인에서 정답을 생성할 확률을 높이지만, 범용적인 질의 응답 성능은 떨어지는 결과를 초래할 수 있음.

2️⃣ Retrieval 의존도 감소 → Outdated Knowledge 문제 발생

Fine-tuning된 모델이 특정 도메인에 특화되면,

📉 검색 없이 학습된 데이터만을 활용하려는 경향이 커지면서,

📉 RAG의 핵심 기능인 "최신 정보 검색 및 활용"이 비효율적으로 작동할 가능성이 있음.

❗ 예시:

Fine-tuning 없이 RAG를 사용하면?

🔎 "최신 AI 논문 요약해줘" → 벡터DB에서 검색 후, 최신 정보를 기반으로 답변 생성

Fine-tuning을 과하게 하면?

🔎 "최신 AI 논문 요약해줘" → 훈련된 데이터만 참조하여, 최신 논문 정보를 무시한 채 응답할 가능성 증가

3️⃣ Overfitting to Training Data (과적합 문제)

Fine-tuning을 지나치게 수행하면,

📉 훈련 데이터에 포함된 정보만 활용하려는 경향이 증가 → 다양한 질문에 대한 대응력이 감소

📉 정확하지만 다양한 방식으로 표현된 문서 검색 성능이 저하될 수 있음

❗ 예시:

Fine-tuning 없이 RAG를 사용하면?

🔎 "Python과 Java의 차이점?" → 다양한 문서를 검색하여 균형 잡힌 정보를 제공

Fine-tuning을 과하게 하면?

🔎 "Python과 Java의 차이점?" → 훈련 데이터에 있던 특정 내용만 복사하여 생성

📌 3️⃣ Fine-tuning과 RAG의 최적 조합 (Best Practices)

1️⃣ Minimal Fine-tuning + RAG 활용

👉 모델은 범용성을 유지하되, 도메인 특화된 정보를 RAG의 검색 단계에서 해결하는 방식

👉 RAG가 최신 정보를 검색할 수 있도록 유지하면서, 모델 자체의 성능 저하를 방지

2️⃣ Parameter-Efficient Fine-tuning (PEFT) 활용

👉 LoRA, Adapter-Tuning 등을 활용하여 모델 전체를 업데이트하지 않고,

👉 특정 도메인에 필요한 정보만 추가 학습 → Knowledge Forgetting 방지

3️⃣ Hybrid Approach (Fine-tuning + Retrieval Optimization)

👉 Fine-tuning은 모델의 표현력 향상(특정 문체, 포맷, 스타일 최적화) 에만 적용

👉 검색 단계에서 Ranking 알고리즘 최적화(BM25, Hybrid Search) 를 함께 조정하여 검색 품질 개선

✅ 4️⃣ 결론

Fine-tuning은 특정 도메인에서 RAG의 성능을 보완할 수 있지만, 검색 기반 아키텍처의 강점을 해치지 않는 범위 내에서 신중하게 적용해야 한다.

✅ 최신 정보를 지속적으로 반영해야 하는 경우 → Fine-tuning보다 검색 성능 최적화(Retrieval Ranking, Hybrid Search) 가 더 효과적

✅ 특정 도메인 또는 스타일을 보강해야 하는 경우 → LoRA 같은 PEFT 방식으로 Fine-tuning을 최소화

Fine-tuning을 과하게 적용하면 RAG의 장점인 유연성과 최신성을 잃을 수 있으므로,

✔ Fine-tuning의 목적을 명확히 정의하고,

✔ 필요할 때만 부분적으로 수행하는 것이 가장 바람직한 접근 방식이다. 🚀