⚙️ SE(검색 엔진)란?

검색어(키워드)가 입력되면 그에 따른 결과물(정보)를 만들어내는 것이다.

- 검색 엔진은 스마트폰이나 컴퓨터에 저장된 정보 중 우리가 원하는 것을 빠르고 정확하게 찾을 수 있도록 해주는 정보 검색 시스템이다.

- 검색 결과를 보통 목록 형태로 보여준다.

- 최근 검색 엔진은 하나의 키워드에 대해 통합검색, 뉴스, 사전, 이미지 등 여러 가지 카테고리별로 다른 검색 결과를 보여주는 기능을 갖고 있어서 편리하게 이용할 수 있다.

검색 엔진 종류

데스크톱 검색 엔진

컴퓨터 내부의 정보를 검색하는 것이다.

검색 엔진

인터넷(월드 와이드 웹, World Wide Web)에서 정보를 찾아주는 것이다.

✔️ 우리가 흔히 쓰는 네이버나 구글 같은 앱/사이트라고 생각하면 된다.

❗️일반적으로 검색 엔진이라고 하면 "웹 검색 엔진"을 말한다.

검색 엔진 작동 원리

알고리즘에 따라 정보의 순위나 순서를 조정

검색 엔진 특징

검색 엔진은 평소에 인터넷 속에서 계속 정보를 수집한다.

→ 이렇게 정보를 업데이트하는 존재가 "검색 로봇(search robot)"이다. 즉 크롤러이다.

크롤러 = 스파이더 = 검색 엔진 봇 = 검색 로봇(search robot)

- 팔다리가 있는 로봇은 아니고, 자동화된 정보 수집 프로그램이다.

- 전체 인터넷에서 콘텐츠를 다운로드하고 색인을 생성

- 매일 여러 사이트를 살펴보면서 새로운 정보가 있는지, 삭제된 정보는 없는지, 어떤 정보가 다르게 변화했다면 무엇이 바뀌었는지를 계속 조사하고, 그중 가치 있는 정보를 수집한다.

- 각 검색 엔진은 자신의 알고리즘에 따라 키워드가 입력되면 검색 결과를 만들게 되는데, 알고리즘에는 각 검색 엔진이 우선시하는 가치와 기준이 반영된다.

- "웹 크롤러"라고 부르는 것은, 소프트웨어 프로그램을 통해 자동으로 웹사이트에 액세스하여 데이터를 얻는 일을 기술 용어로 "크롤링"이라고 한다.

→ 즉, 같은 키워드라 하더라도 검색 엔진에 따라 다른 결과가 나오게 된다.

이러한 봇은 대부분 검색 엔진이 운영한다. 검색엔진은 웹 크롤러가 수집한 데이터에 검색 알고리즘을 적용함으로써, 사용자의 검색 질의에 대한 응답으로 관련 링크를 제공한다.

이를 통해, Google 또는 Bing 등의 검색 엔진에 검색을 입력하고 나면, 웹페이지 목록이 표시되는 것이다.

브라우저마다 크롤러를 부르는 별명도 있다

Google → Googlebot Naver → Yeti

비유)

웹 크롤러 봇은, 정리되지 않은 도서관의 모든 책을 검토하고 카드 카탈로그를 구성함으로써, 도서관을 찾는 사용자가 필요한 정보를 빠르고 쉽게 찾을 수 있도록 도와주는 사람과 유사하다. 이 사람은 도서관의 책을 주제별로 분류하고 정렬할 수 있도록, 책의 제목, 요약, 본문 중 일부를 읽어 무엇에 대한 책인지 파악한다.

그러나, 인터넷은 도서관과 달리, 물리적인 책 더미로 구성되지 않기 때문에, 필요한 정보를 모두 적절히 색화화하였는지, 상당한 부분을 간과했는지 판단하는 것이 쉽지 않다.

웹 크롤러 봇은 인터넷이 제공하는 관련 정보를 모두 찾기 위해, 알려진 일련의 웹 페이지에서 시작해 다른 페이지로 연결된 하이퍼링크를 따라가고,또 거기에 다른 페이지로 하이퍼링크를 따라가는 식으로 작동한다.

❗️공개된 인터넷 중 얼마나 많은 부분을 검색 엔진 봇이 실제로 크롤링하는지는 알려져 있지 않다. 정보원의 추정에 따르면, 인터넷의 40-70%만을 검색용으로 색인화한다고 한다. 이것만으로도 수십억 개의 웹 페이지에 해당한다.

if)

크롤러가 마구잡이로 모든 사이트의 정보를 수집하게 되면 특정 사이트에는 검색 엔진에 나오고 싶지 않은 숨기고 싶은 정보가 있을건데 다 공개가 되어버린다.

solution)

검색 엔진은 특별한 약속(robots.txt)이 있다.

크롤러는 웹 사이트를 방문하면서 가장 우선 robots.txt 파일을 읽는다.

- robots.txt 에서 "로봇을 허용한다!"라고 되어 있으면 크롤러가 접근하여 정보를 가져온다.

- robots.txt 에서 "크롤러를 거부한다!"라고 되어 있으면 이 사이트에 접근하지 못한다.

❗️추가적으로) sitemap.xml이라는 파일을 제공할 수 있는데 이는 크롤러가 사이트에 접근했을 때 sitemap이라는 지도를 보고 우리 사이트를 더 정확하고 효율적으로 탐색할 수 있게 만들어 준다.

❗️검색 엔진은 많은 사람이 동시에 이용해도 문제없이 돌아가야 한다.

❗️현재 우리나라에서 대표적으로 서비스 되고 있는 검색 엔진은 네이버가 있다.

검색 색인화

검색 색인화는 정보를 필요로 하는 사람에게 인터넷의 어디에서 그 정보를 찾을 수 있는지 알려주기 위해 검색 엔진이 만드는 인터넷의 도서관 카드 카탈로그 같은 것이다.

ex) 책의 뒤에 있어서, 특정 항목 또는 문구가 책의 어디에 있는지 알려주는 색인과도 유사하다.

색인화는 주로 페이지에 나타나는 텍스트와 사용

웹 크롤러가 SEO에 영향을 미치는 방식

SEO는 검색 엔진 최적화를 의미하며, 웹 사이트가 검색 엔진 결과의 상단에 표시되도록 콘텐츠를 검색 색인화에 맞게 준비하는 방식을 말한다.

스파이더 봇이 웹 크롤러가 웹사이트를 크롤링하지 않으면, 해당 사이트는 색인화되지 않고, 검색 결과에 표시되지 않는다. 그러므로, 웹사이트 소유자 검색 결과를 통한 자연스러운 트래픽을 얻으려면 웹 크롤러 봇을 차단하지 않아야 한다.

트래픽(traffic)이란?

- 트래픽은 전송량이라고 하며 어떤 통신장치나 시스템에 걸리는 부하를 말한다.

- 트래픽 양이 지나치게 많으면 서버에 과부하가 걸려 전체적인 시스템 기능에 장애를 일으킨다.

- 무제한 트래픽은 html, jpg, gif 등의 웹문서 파일에 대한 트래픽을 무제한으로 제공하고 mp3 등 동영상은 별도 트래픽으로 과금된다.

<트래픽 용량 계산 방법>

ex) 텍스트와 이미지로 이루어진 1MB용량의 웹페이지를 하루에 1000명이 접속하여 보았다면?

1MB X 1000(명) = 1000MB 의 트래픽이 발생

참고 블로그

SEO(검색엔진최적화)란?

검색엔진이 이해하기 쉽도록 홈페이지의 구조와 페이지를 개발해 검색 결과 상위에 노출될 수 있도록 하는 작업을 말한다.

예시)

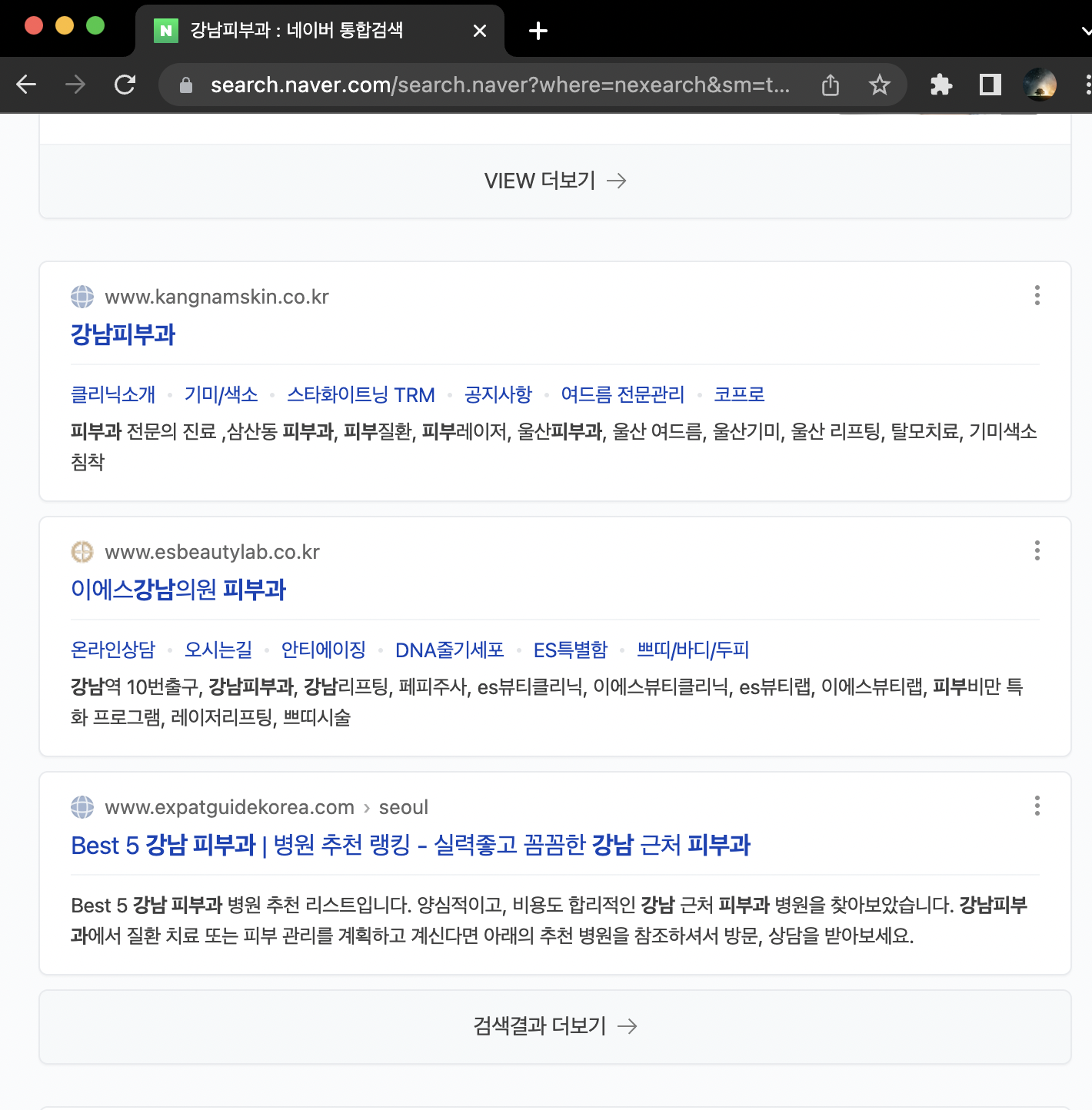

네이버에 강남 피부과라 검색하면 파워링크, VIEW 등 다양한 영역이 나온다.

여러 영역 중에서 이름이 안 붙어져 있고 홈페이지만 나와있는 영역

이 영역 첫 페지에 띄울 수 있게끔 하는게 SEO이다.

검색엔진최적화(SEO)로 구글 상위에 랭크되는 10가지 방법

1. 문법에 맞는 HTML 작성하기

<title>태그에는 사이트 제목을 기재하고, <div>태그를 사용해 줄을 바꾸고, <strong>과<em>태그를 활용해 강조하고 싶은 키워드에 붙이는 등 적절한 HTML 소스로 홈페이지를 구성하는 것은 결과적으로 검색엔진에게도 이해하기 쉬운 웹 문서가 되고, 유사한 내용의 웹 문서가 있을 경우 상대적으로 이러한 문서의 순위가 높아진다.

2. 구체적인 페이지 제목 만들기

HTML 문서의 헤더에 들어가는 페이지 제목(title)은 구체적이고 간결하게 구성해, 검색 결과 화면에서 텍스트가 잘리지 않도록 한다.

- 유인 키워드 반복 삼가(예) caf'e,ca fe,카페,카 페

- 반복적이고 틀에 박힌 제목 삼가

- 제목의 시작이나 끝에 사이트 이름을 포함하고 나머지 제목은 하이픈(-),콜론(:),막대(|)

ex)가비아 - 도메인등록,도메인연장,도메인이전,도메인예약,부가서비스