-

cross validation : 데이터 수가 적을 때 모델의 overfitting을 예방하기 위해 사용됨

ex) K-fold cross validation- 의문 : 'Out-Of-Fold'와 'K-fold CV'에서의 'fold'는 같은 것?

- 답 : 비슷하다. 그러나 OOF 예측은 K-fold cv의 일부로서, 각 fold가 validation set로 사용될 때 얻어지는 예측을 의미함. (OOF 예측은 교차 검증의 각 반복(fold)에서 얻은 validation set에 대한 에측을 모아 전체 데이터셋에 대한 예측으로 볼 수 있음)

- 의문 : 'Out-Of-Fold'와 'K-fold CV'에서의 'fold'는 같은 것?

-

OOF 방식으로 예측하는 방식 (Kaggle 대회에서 사용하지 실무에서는 잘 사용하지 않는다고 함)

-

validation set의 성적

-

OOF = 누가 누가 더 잘하나

-

두 가지 유형의 OOF 예측

- Stacking : 5-fold라면 모델이 5회 번갈아가면서 4/5 학습데이터로 학습, 1/5 학습데이터로 예측해 별도의 학습 데이터를 만든 후, 이걸 다시 메타 모델로 학습해 최종 예측

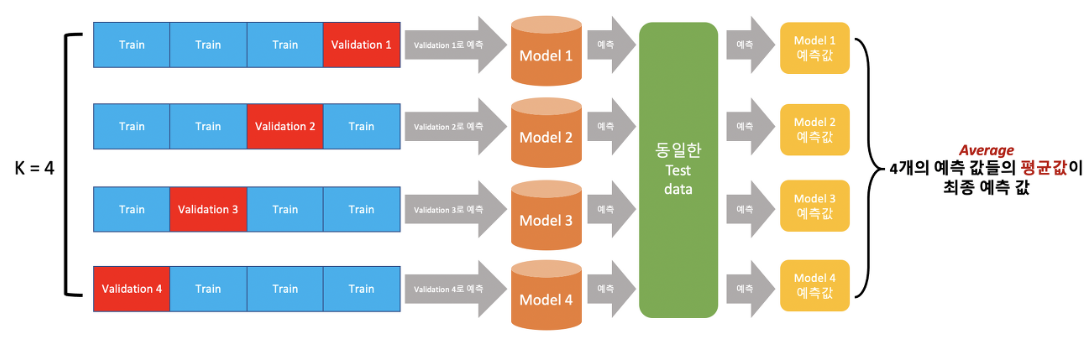

- k-fold cv : K-fold로 학습한 후 예측을 테스트 셋에 k번 만큼 수행 뒤, 개별 예측값을 평균해 최종 예측 (아래의 예시임)

-

4-fold cv의 예시

- 4번의 교차 검증

- 각 fold마다 최적화된 파라미터 값은 다 다름 (fold 개수만큼 모델 개수도 생김)

- 각 모델이 학습한 데이터가 서로 다르기 때문

- 각 fold(model)를 동일한 test set에 대해 예측하도록 한 후, 이 예측값들의 평균값을 취해 test set에 대한 최종 예측값 산출함 (이 최종 예측값을 OOF 예측이라고 함)

-