다양한 하이퍼파라미터 튜닝 방법 중 베이지안 최적화에 대해 정리해본다.

Grid search: 시간이 너무 오래 걸림

Random search: Random하므로 최적값을 모름

베이지안 최적화는 사전정보를 활용해 미지의 함수를 찾아가는 과정이다.

사전정보는 surrogate model을 학습하며 acquisition fuction의 최대값을 찾아 그 포인트의 surrogate model을 업데이트한다.

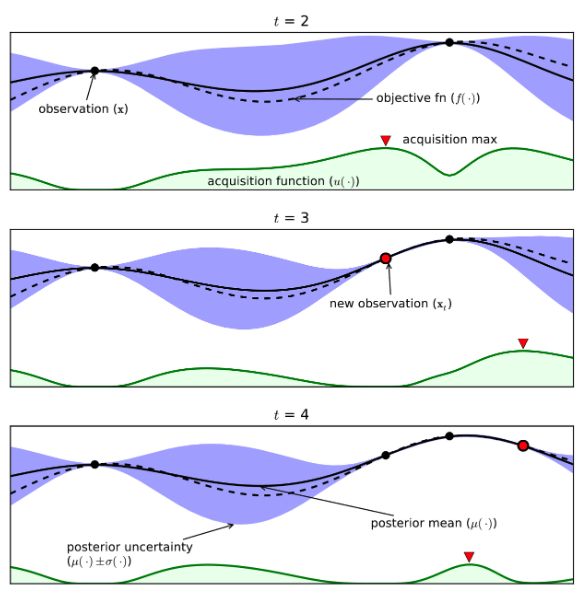

위 그림의 설명을 더하면,

- t = 2일 때의 Acquisition Function이 최대화 되는 값은 t = 3 시점에서 새로 관찰할 점으로 들어가게 된다.

- 이에 따라, t = 3에서 새로 관찰한 함수값 주변의 파란 영역이 크게 줄어들며, 동시에 Acquisition Function 또한 업데이트 된다.

- 마찬가지로 t = 3의 Acquisition Function이 최대가 된 지점에서 t = 4의 새로운 관찰값이 생성되고, 그 주변의 파란 영역이 줄어들며 Acquisition Function이 다시 업데이트된다.

4.이러한 과정이 계속 반복되면서 추정값이 실제 목적 함수에 근사하게 되고, 근사한 함수에서 최종 최적값을 찾을 수 있다.