Gradient Boosting Machine

GBM = Gradient Descent(경사하강법) + Boosting

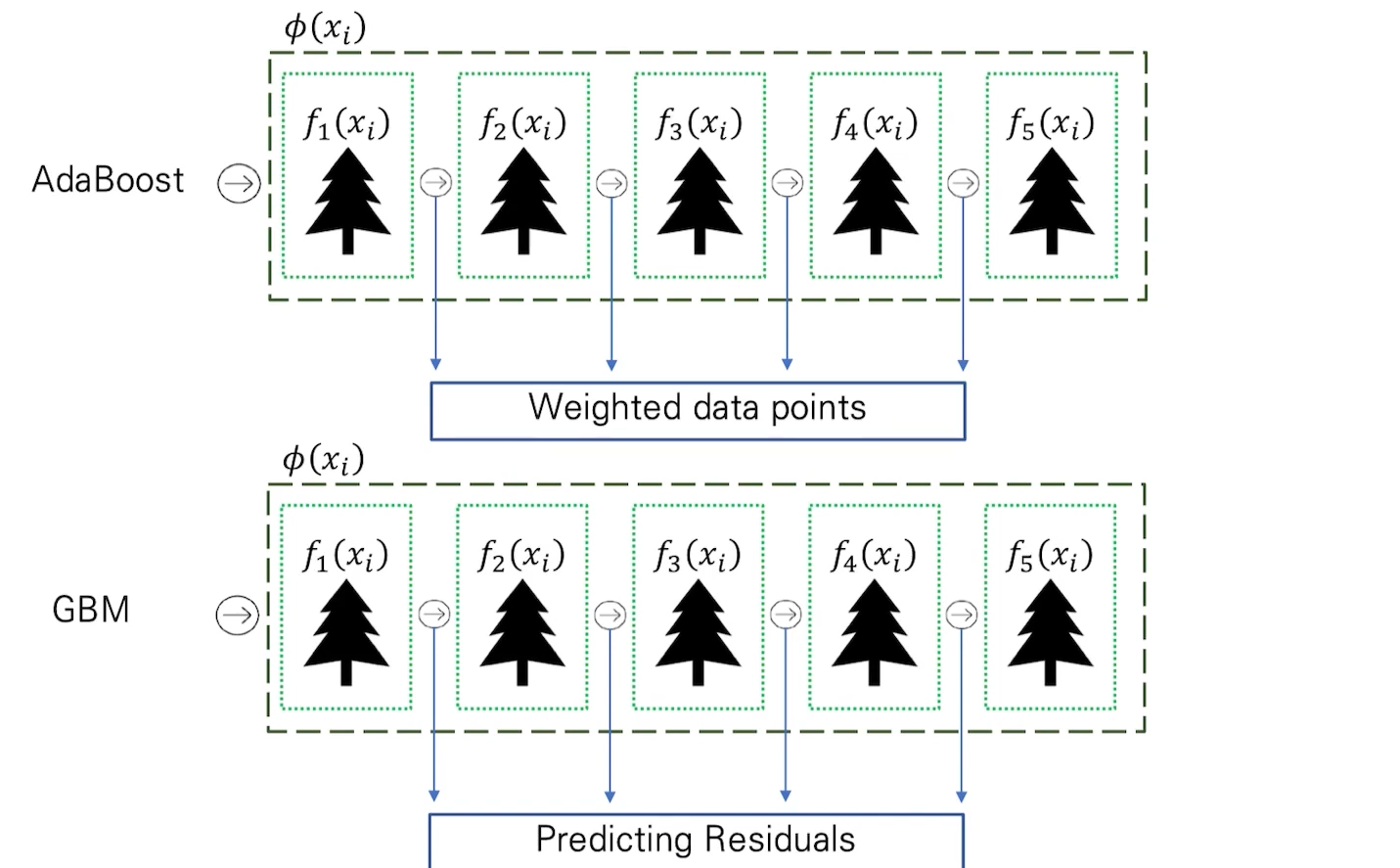

AdaBoost에서는 이전 모델의 단점을 다음 모델에서는 데이터마다 가중치를 부여하여 즉 더 잘 샘플링될 수 있게 하여 예측률을 높였다.

GBM에서는 오류를 경사하강법을 이용하여 해결해 나간다. (잔차 이용)

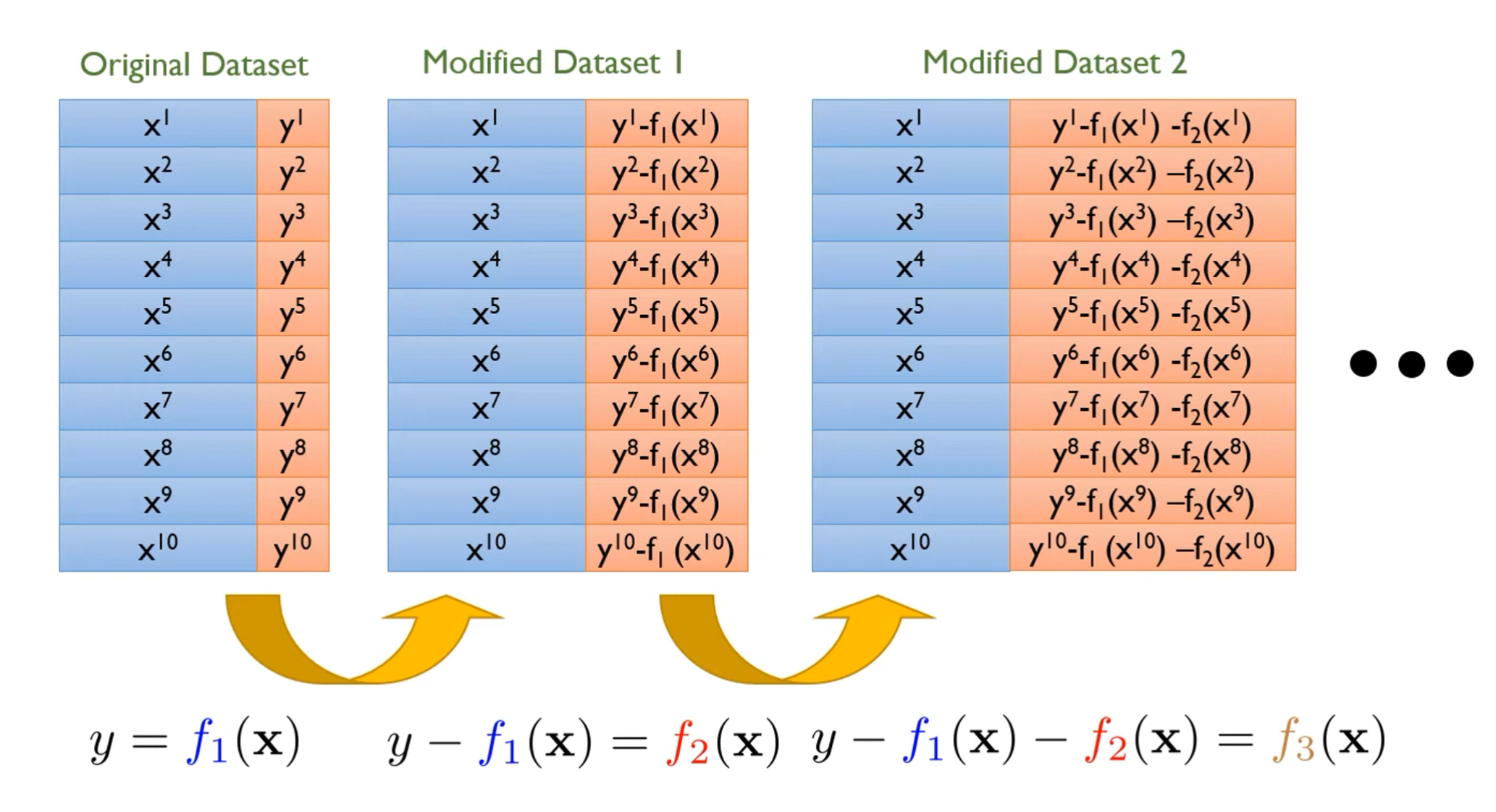

그림을 보면 (실제값)와 (예측값)의 차이를 라는 새로운 값으로 정의하여 두번째 모델이 이 차이만큼만(즉, ) 예측을 진행하게 된다. 그 다음 모델에서는 이전 모델이 예측하지 못한 부분에 대해서만 예측을 진행하고 다시 차이가 나는 만큼을 롤 정의하여 예측을 진행하게 된다.

GBM은 데이터에 가중치를 주지 않고 경사하강 방식으로 오류를 최소화해 나간다.

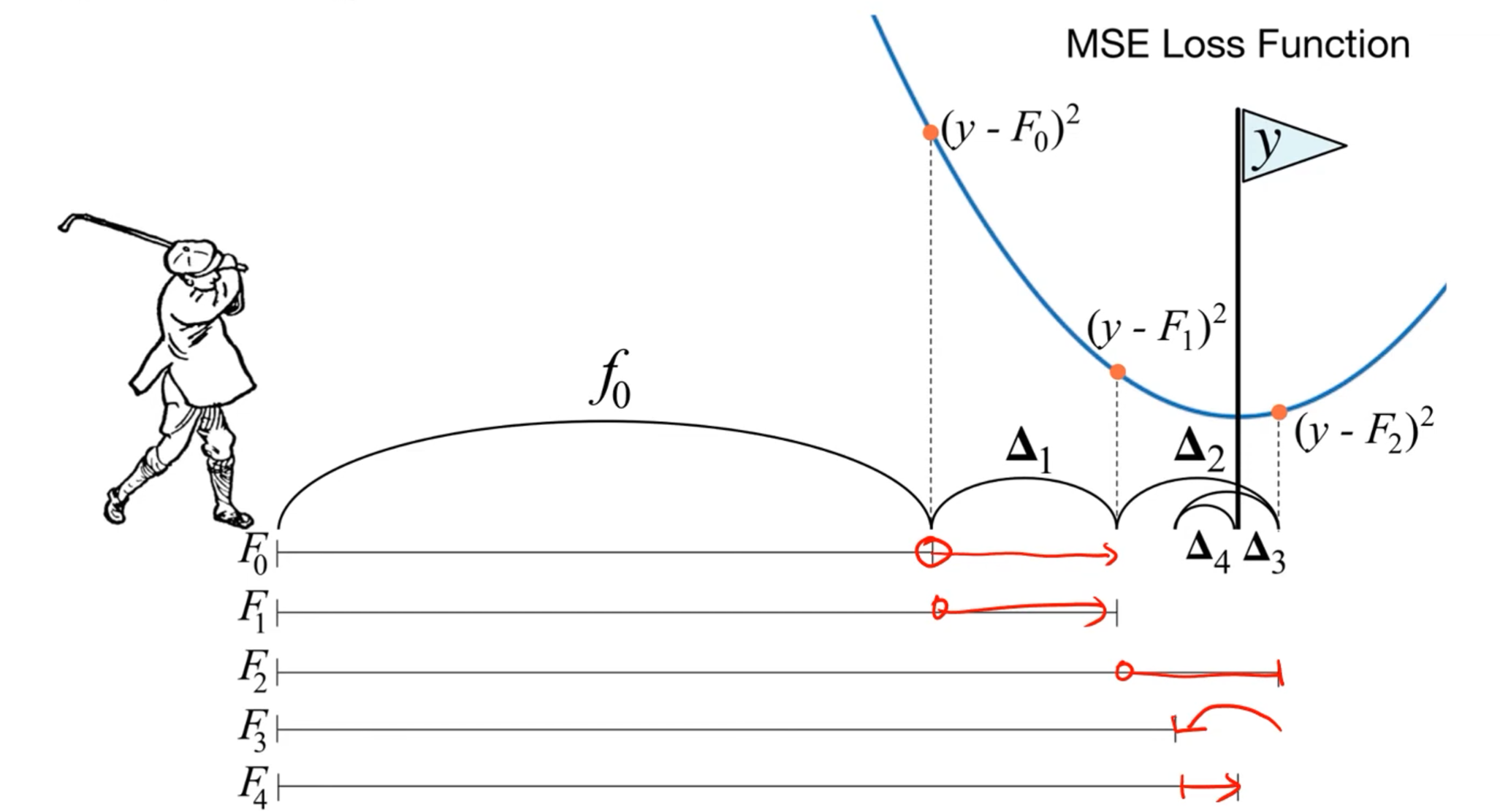

다음 골프 그림을 통해 확실히 이해할 수 있다.

골프공을 구멍에 넣기 위해 부족한만큼 더 쳐야 하고 넘어간 만큼 다시 돌아오는 과정이 GBM의 학습 방식과 유사하다.

- GBM은 분류, 회귀, 랭킹 문제에 모두 적용가능하다.

(랭킹: 데이터를 관련성 순서대로 정렬하는 머신러닝 기법) - 이 기법에서 파생된 것이 XGBoost, LightGBM, CatBoost가 있다.