목차

- 손실 함수

- 정규화 손실

- softmax

- 최적화

손실함수 (Loss function)

- 역할

- 모델이 나타내는 확률 분포와 데이터가 따르는 실제 확률 분포 사이의 차이를 계산

- 즉, 모델의 예측값이 얼마나 구린지 측정한다

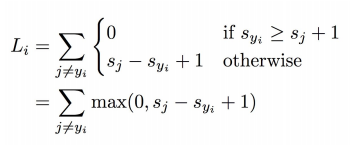

Multiclass SVM loss

hinge loss의 수식

hinge loss의 그래프

SVM은 hinge 손실 함수를 사용한다.

손실 함수의 기본형이라고 할 수 있다. 이미지 분류에 성능이 좋다.

sj - syi + 1 식의 각 항 설명

s: 분류 모델이 분류한 카테고리의 예측 score

sj: 오답 category의 score (multiclass 분류인 경우는 오답 중 제일 큰 값)

syi: 정답 category의 score

+1: safty margin

일정 여유공간을 설정해서, 모델이 결정 경계에서 일정 거리 이상 떨어진 샘플들을 분류하기 위함이다.

모델이 좀 더 일반화된 결정 경계를 학습하고, 잡음 이상치에 민감하지 않도록 한다.

계산 방법 예시

고양이 사진: 정답이 cat인데 오답인 car 점수가 5.1로 더 높음

sj: 5.1

syi: - 3.2 (정분류 값)

5.1 - 3.2 + 1 = 2.9

차 사진: 정답 레이블인 car 점수가 제일 높음 따라서 loss = 0

s_1: 고양이 점수, s_2: 개 점수

Y_i: 이미지의 실제 정답 카테고리 (정수 값)

s_y_i: train set의 i번째 이미지의 정답 클래스 스코어

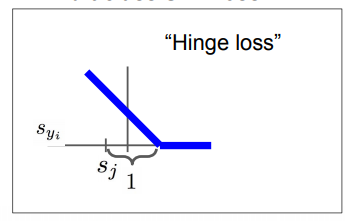

정규화 손실(Regularization loss)

파란 선보다 초록선이 더 좋은 모델

정규화(regularizaiton)

복잡해진 모델에 페널티를 줘서 최대한 심플하게 만드는 과정.

loss가 작으면 작을수록 좋은 것 만은 아니다.(과대적합) 함수가 단순해야(즉, 직선에 가까워야) test data에 적합할 가능성 커진다.

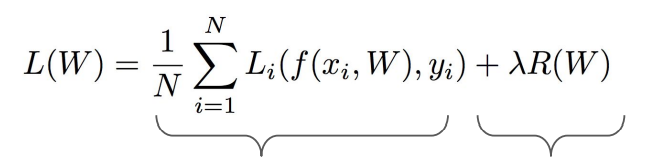

모델의 복잡함, 단순함을 통제하기 위해 손실 함수에 regularization term을 추가

Data Loss 와 Regularization loss의 합으로 변하고, 하이퍼파라미터인 람다로 두 항간의 트레이드오프를 조절

L1 정규화, L2 정규화

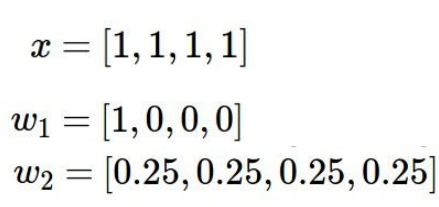

x: 이미지 픽셀 값이 [1,1,1,1] 이라고 가정해보자.

가중치가 각각 w1, w2일 때 L1과 L2는 각각 어떤 가중치를 선호할까?

L1: w1을 선호

sparse한걸 고름

0이 많으면 좋다고 판단

L2: w2를 선호

w2가 norm이 더 작기 때문.

모든 요소가 골고루 영향을 미치길 바람

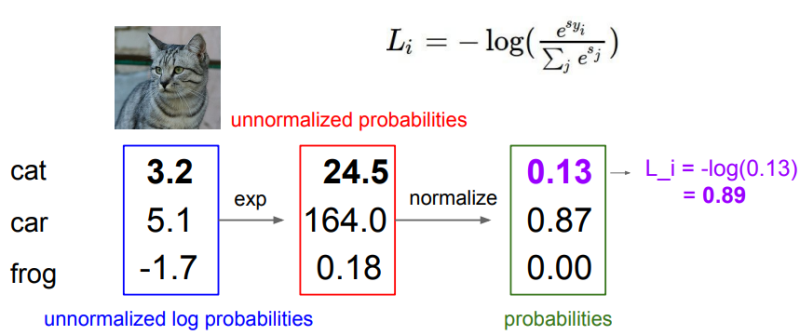

Multinomial logistic regression(softmax)

딥러닝에서 자주 사용됨.

Multi-class SVM loss에서는 score 자체에 대한 해석보다는 정답 class와 정답이 아닌 class들을 비교하는 형식이었다.

softmax는 그 차이를 모두 수치화하여 score 자체에 추가적인 의미 부여한다.

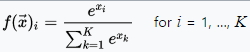

softmax 계산

클래스별 확률 분포를 계산하고 이를 이용해서 loss를 계산함.

지수화 → 정규화 → -log

정답 클래스에 가까우면 확률이 1에 가까움.

최적화(Optimization)

딥러닝이란 최종 손실 함수가 최소가 되게 하는 가중치 행렬이자 파라미터인 행렬 W를 구하는 것인데, 실제로 어떻게 loss를 줄이는 w를 찾을 수 있을까?

최적화는 산속 골짜기를 내려가는 것과 같다. loss가 낮은 상태인 낮은 지대를 향해..

Gradient Descent

낮은 곳을 향해 나아가기 위해 경사를 따라 내려가며 학습하는 방법

현재 위치와 이동한 위치의 미분 값을 계산하며 미분 값의 반대 방향으로 이동하면 아래를 향해 나아가게 된다.

- 미분이 한 점의 기울기라는 걸 잊지 말자

numerical 방법으로 미분 값을 계산할 수 있음 근데 W가 너무 많아서 하나하나 계산하기에 시간이 오래걸림. 따라서 미분식을 이용해 더 빠르고 쉽게 계산할 수 있다.

SGD(Stochastic Gradient Descent) 확률적 경사 하강법

학습 데이터의 일부(mini-batch)를 사용하여 파라미터를 업데이트

거의 모든 DNN 알고리즘에 사용됨

# Vanilla Minibatch Gradient Descent

while True:

weights_grad = evaluate_gradient(loss_fun, data, weights)

weights += -step_size * weights_grad # perform parameter update

# step_size : learning rate. 한번에 이동하는 정도learning rate가 너무 크면 overshooting, 너무 작으면 시간 오래 걸림, global minimum이 아닌 local minimum에 빠질 수 있음.

웹데모 사이트 Linear Classifier와 Gradient descent:

Multiclass SVM optimization demo (stanford.edu)

Aside: 이미지 특성 추출

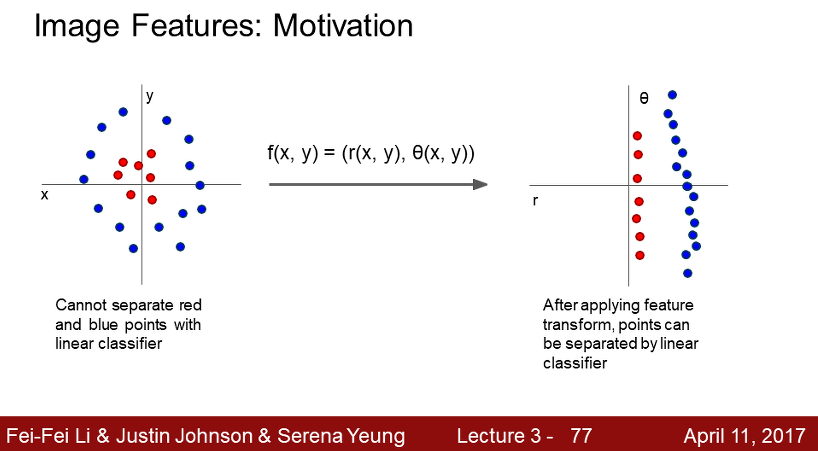

왼쪽 좌표의 이미지 특성은 선형 분리 할 수 없다.

오른쪽 좌표는 각 점들을 극좌표계로 변환한 것이다. 이러면 선형 분리가 가능해진다. 이것을 모티브로하여 각 특징들을 이용해 이미지를 구분하는 아이디어가 도출된다.

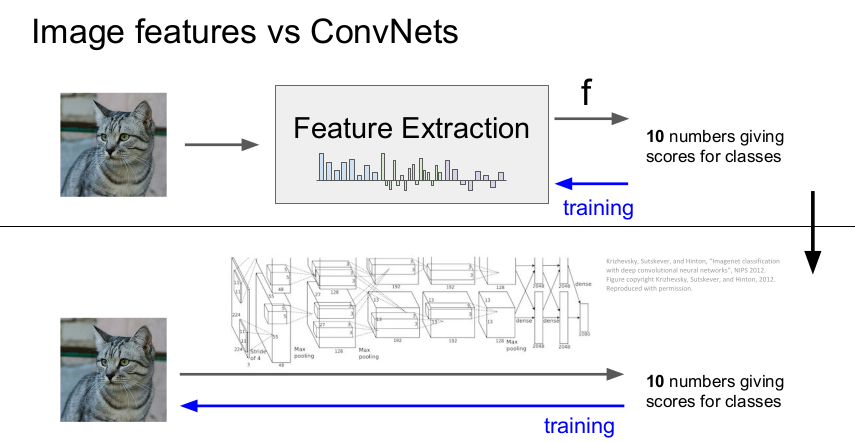

2012년 이전까지는 이미지 특징 추출이 많이 연구되었다. 2012년 alexnet이 나온 이후엔 layer를 쌓으면서 cnn이나 dnn이 사용되었다. 따라서 데이터로부터 특징을 직접 추출하여 학습하는 방식이 잘 사용되지 않게 되었다.

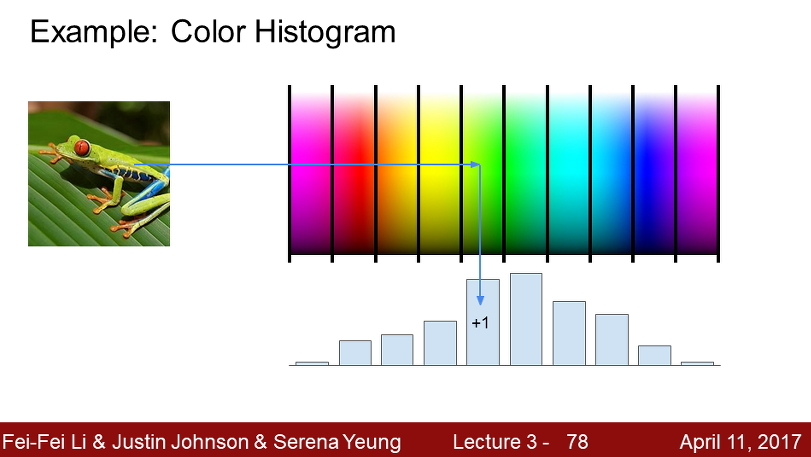

컬러 히스토그램

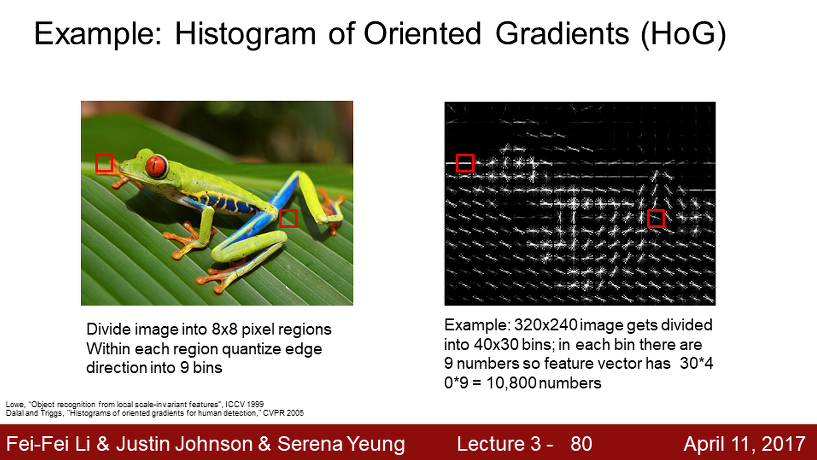

Histogram of Oriented Gradients (Hog)

이미지를 8x8의 작은 조각으로 나누어 그 조각 내 가장 지배적인 edge(값이 급격하게 변하는 지점)를 찾는다. 그 edge를 양자화하여 방향 히스토그램으로 표현한다. 예전의 영상 인식에서 많이 사용되었다.

Bag of Words

1단계: 이미지를 작게 잘라 시각 단어로 표현한 후(?) codebook에 붙인다. k means 알고리즘으로 1천개의 중심점을 갖도록 학습한다. (색에 따라 군집화한다)

2단계: 이미지의 시각 단어의 발생 빈도를 인코딩하여 이미지의 특징을 추출한다.