데이터 및 라이브러리 로드

import numpy as np

import matplotlib.pyplot as plt

from tensorflow.keras.datasets import imdb

(X_train, y_train), (X_test, y_test)=imdb.load_data()

print('훈련용 리뷰 개수 : {}'.format(len(X_train)))

print('테스트용 리뷰 개수 : {}'.format(len(X_test)))

num_classes = len(set(y_train))

print('카테고리 : {}'.format(num_classes))

훈련용 리뷰 개수 : 25000

테스트용 리뷰 개수 : 25000

카테고리 : 2이 데이터는 토큰화, 정수 인코딩이 끝난 상태

데이터 탐색

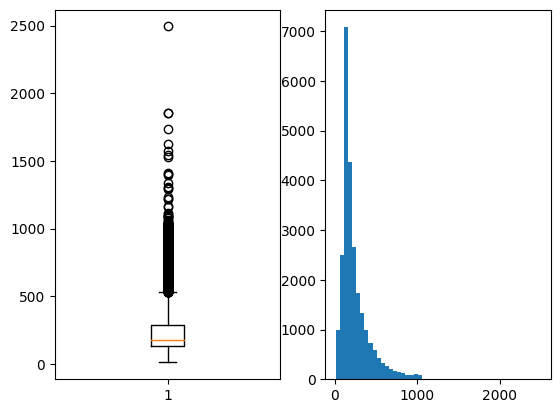

레이블은 긍정:1, 부정:0을 가진다. 리뷰의 길이 분포를 시각화

reviews_length = [len(review) for review in X_train]

print('리뷰의 최대 길이 : {}'.format(np.max(reviews_length)))

print('리뷰의 평균 길이 : {}'.format(np.mean(reviews_length)))

plt.subplot(1,2,1)

plt.boxplot(reviews_length)

plt.subplot(1,2,2)

plt.hist(reviews_length, bins=50)

plt.show()

각 레이블별 개수 확인

unique_elements, counts_elements = np.unique(y_train, return_counts=True)

print("각 레이블에 대한 빈도수:")

print(np.asarray((unique_elements, counts_elements)))

각 레이블에 대한 빈도수:

[[ 0 1]

[12500 12500]]인덱스를 넣을 때 어떤 단어인지 확인하기 위해 key, value 바꾸기

word_to_index=imdb.get_word_index()

index_to_word={}

for key, value in word_to_index.items():

index_to_word[value+3]=key가장 높은 빈도수 단어 확인

print('빈도수 상위 1등 단어 : {}'.format(index_to_word[4]))

빈도수 상위 1등 단어 : theGRU 모델 설계

단어 집합의 크기 10000개로 제한

최대 길이 500으로 제한

한 후 패딩

import re

from tensorflow.keras.datasets import imdb

from tensorflow.keras.preprocessing.sequence import pad_sequences

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Dense, GRU, Embedding

from tensorflow.keras.callbacks import EarlyStopping, ModelCheckpoint

from tensorflow.keras.models import load_model

vocab_size=10000

max_len=500

(X_train, y_train), (X_test, y_test)=imdb.load_data(num_words=vocab_size)

X_train=pad_sequences(X_train, maxlen=max_len)

X_test=pad_sequences(X_test, maxlen=max_len)임베딩벡터의 차원: 100

은닉 상태 크기: 128

다 대 일 구조의 GRU

embedding_dim=100

hidden_units=128

model=Sequential()

model.add(Embedding(vocab_size, embedding_dim))

model.add(GRU(hidden_units))

model.add(Dense(1, activation='sigmoid'))

es=EarlyStopping(monitor='val_loss', mode='min', verbose=1, patience=4)

mc=ModelCheckpoint('GRU_model.keras', monitor='val_acc', mode='max', verbose=1, save_best_only=True)

model.compile(loss='binary_crossentropy', optimizer='rmsprop', metrics=['acc'])

history=model.fit(X_train, y_train, epochs=15, batch_size=64, callbacks=[es, mc], validation_split=0.2)테스트 데이터 성능 확인

loaded_model=load_model('GRU_model.keras')

loaded_model.evaluate(X_test, y_test)정확도: 0.8911

테스트 데이터가 아닌 다른 문장에 대한 예측

입력 문장에 대한 전처리, 정수 인코딩, 패딩한 후 모델에 입력하는 함수

def sentiment_predict(new_sentence):

# 알파벳과 숫자를 제외하고 모두 제거 및 알파벳 소문자화

new_sentence = re.sub('[^0-9a-zA-Z ]', '', new_sentence).lower()

encoded = []

# 띄어쓰기 단위 토큰화 후 정수 인코딩

for word in new_sentence.split():

try :

# 단어 집합의 크기를 10,000으로 제한.

if word_to_index[word] <= 10000:

encoded.append(word_to_index[word]+3)

else:

# 10,000 이상의 숫자는 <unk> 토큰으로 변환.

encoded.append(2)

# 단어 집합에 없는 단어는 <unk> 토큰으로 변환.

except KeyError:

encoded.append(2)

pad_sequence = pad_sequences([encoded], maxlen=max_len)

score = float(loaded_model.predict(pad_sequence)) # 예측

if(score > 0.5):

print("{:.2f}% 확률로 긍정 리뷰입니다.".format(score * 100))

else:

print("{:.2f}% 확률로 부정 리뷰입니다.".format((1 - score) * 100))test_input = "This movie was just way too overrated. The fighting was not professional and in slow motion. I was expecting more from a 200 million budget movie. The little sister of T.Challa was just trying too hard to be funny. The story was really dumb as well. Don't watch this movie if you are going because others say its great unless you are a Black Panther fan or Marvels fan."

sentiment_predict(test_input)

98.48% 확률로 부정 리뷰입니다.