1.강의 내용

[NLP]Sequence to Sequence with Attention

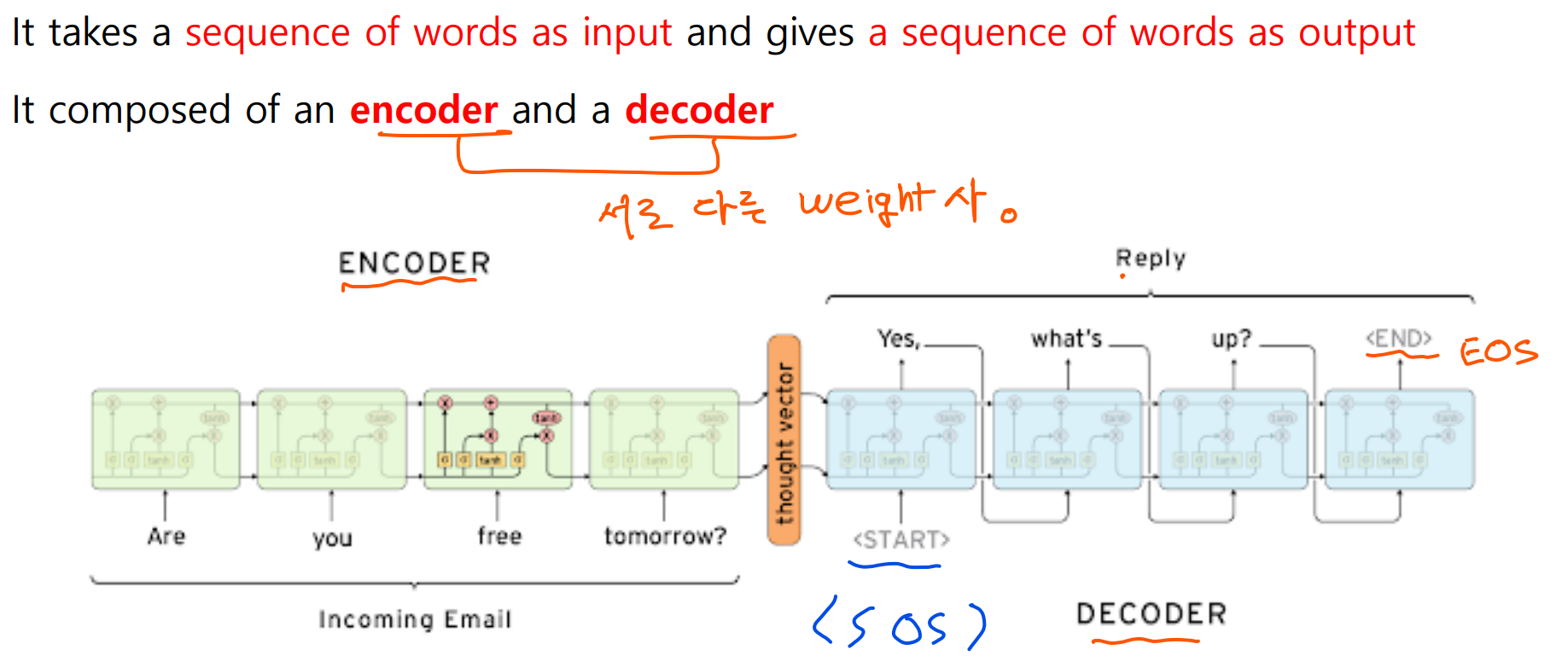

Seq2Seq Model

-

나온 배경: Attention provides a solution to the bottleneck problem

-

Core Idea: At each time step of the decoder, focus on a particular part of the source sequence

-

Attention의 장점:

1)Attention significantly improves NMT performance

It is useful to allow the decoder to focus on particular parts of the source

2)Attention solves the bottleneck problem

Attention allows the decoder to look directly at source; bypass the bottleneck

3)Attention helps with vanishing gradient problem

Provides a shortcut to far-away states

4)Attention provides some interpretability

By inspecting attention distribution, we can see what the decoder was focusing on

The network just learned alignment by itself

[NLP]Beam Search and BLEU

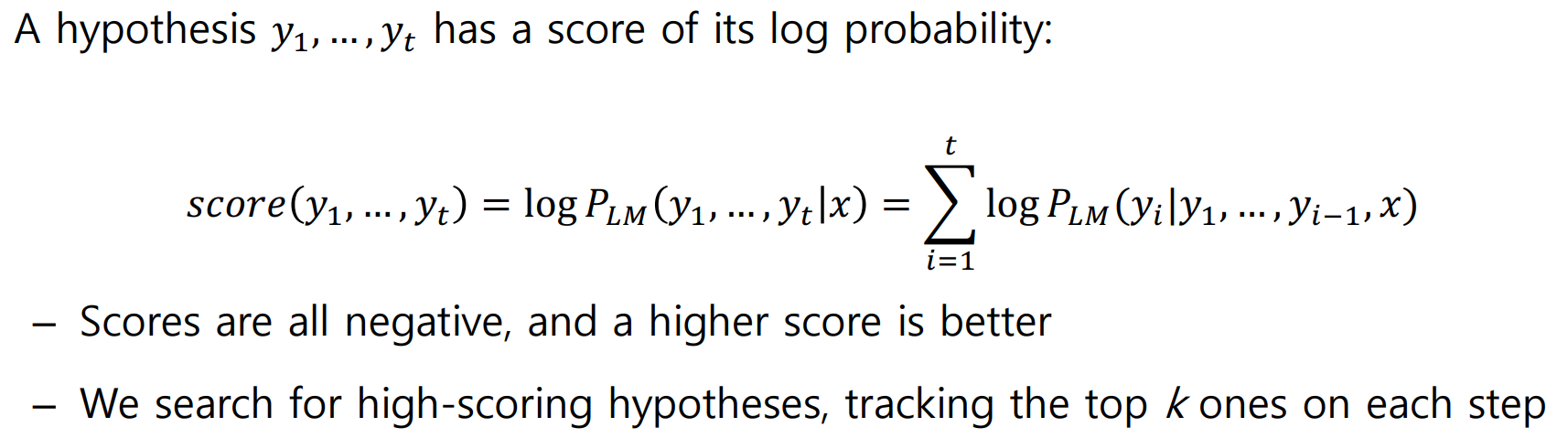

Beam search

- Core Idea: on each time step of the decoder, we keep track of the k most probable partial translations (which we call hypothese) where k is the beam size

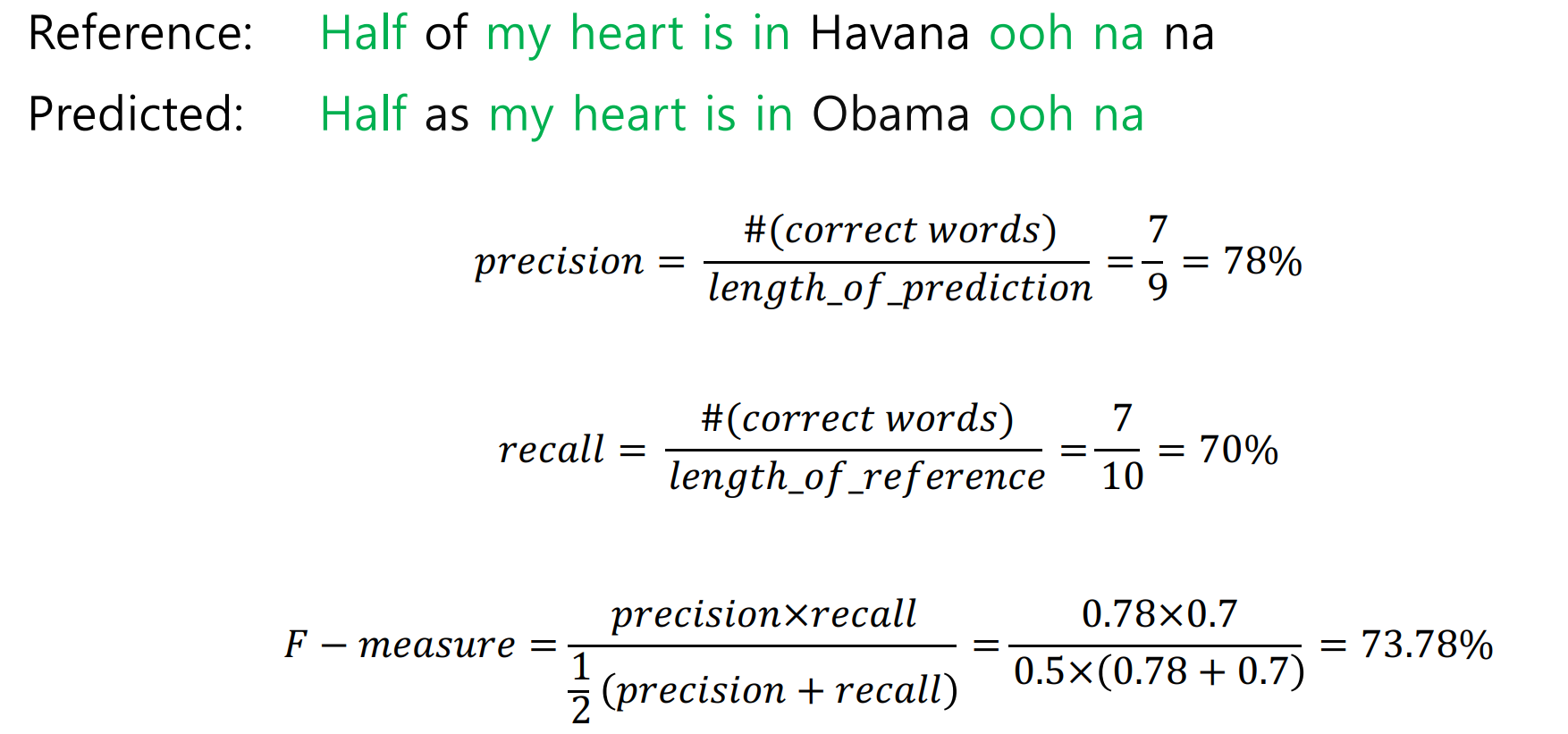

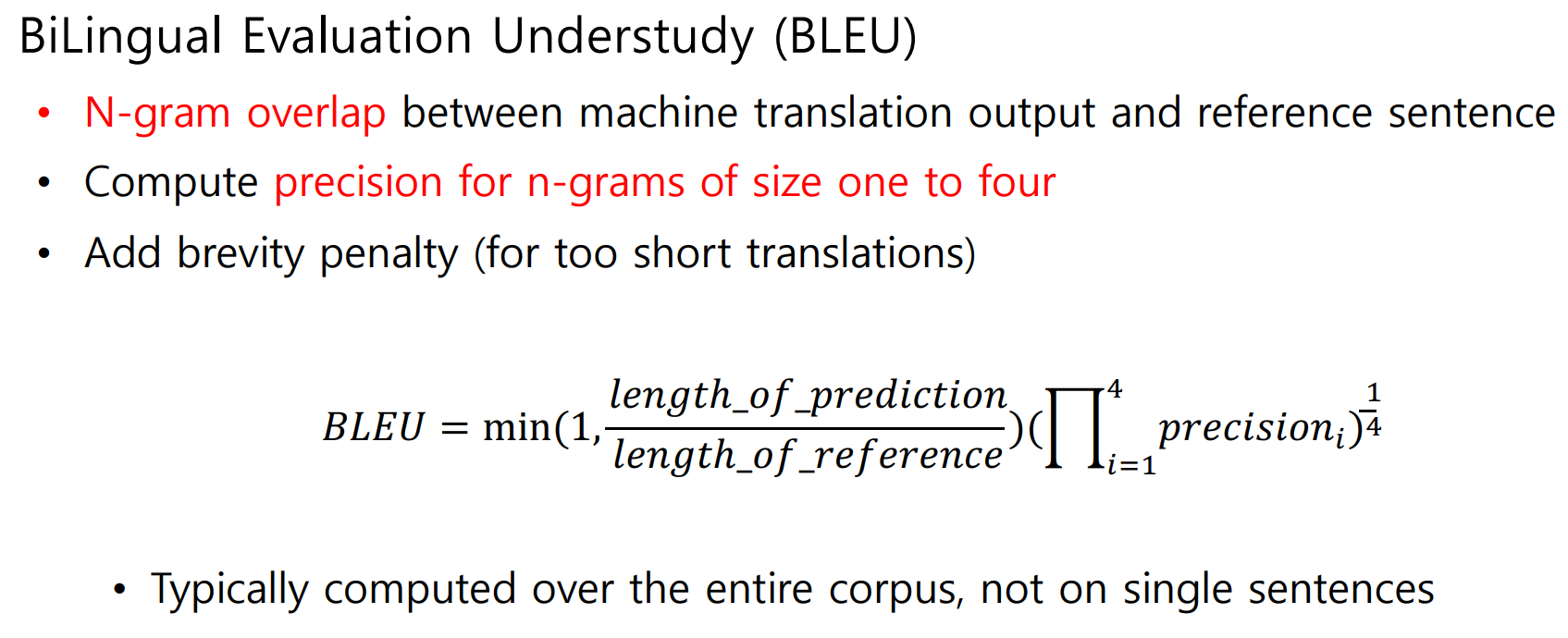

BLEU Score

2.과제 수행 과정/결과물 정리

[필수과제 2,3] 완료

3.피어 세션

학습 내용 공유

1.강의 내용 및 심화내용 토론

좀 더 학습 후, 공유 예정

2.과제 내용 및 심화내용 토론

필수과제 2 중

Q1)문장 생성이라서 decoder의 out_features = 33278 일까요? 사전 개수만큼,,,?

Q2)최종적으로 만들어진 generate.txt 에는 왜 50개의 문장이 생긴걸까요?

A1)맞음. 전체 단어 사전에서 다음 단어로 올 단어 하나를 찾음.

A2)마지막 generate 만드는 코드에서 1000개의 단어로 한 문장에 단어 20개씩 넣으니까 문장 50개 생성됨!

4.학습회고

금일 강의 내용은 다소 어려웠습니다. 금주 강의는 모두 들었기에 남은 이틀 간 좀더 내용을 학습해야할 것 같습니다. 멘토링을 진행하며 학습과정의 방향성을 얻었습니다.

멘토님께서 추천해주신 도서

Dive in to DL

Sutton RL