1.강의 내용

[NLP]Transformer 1

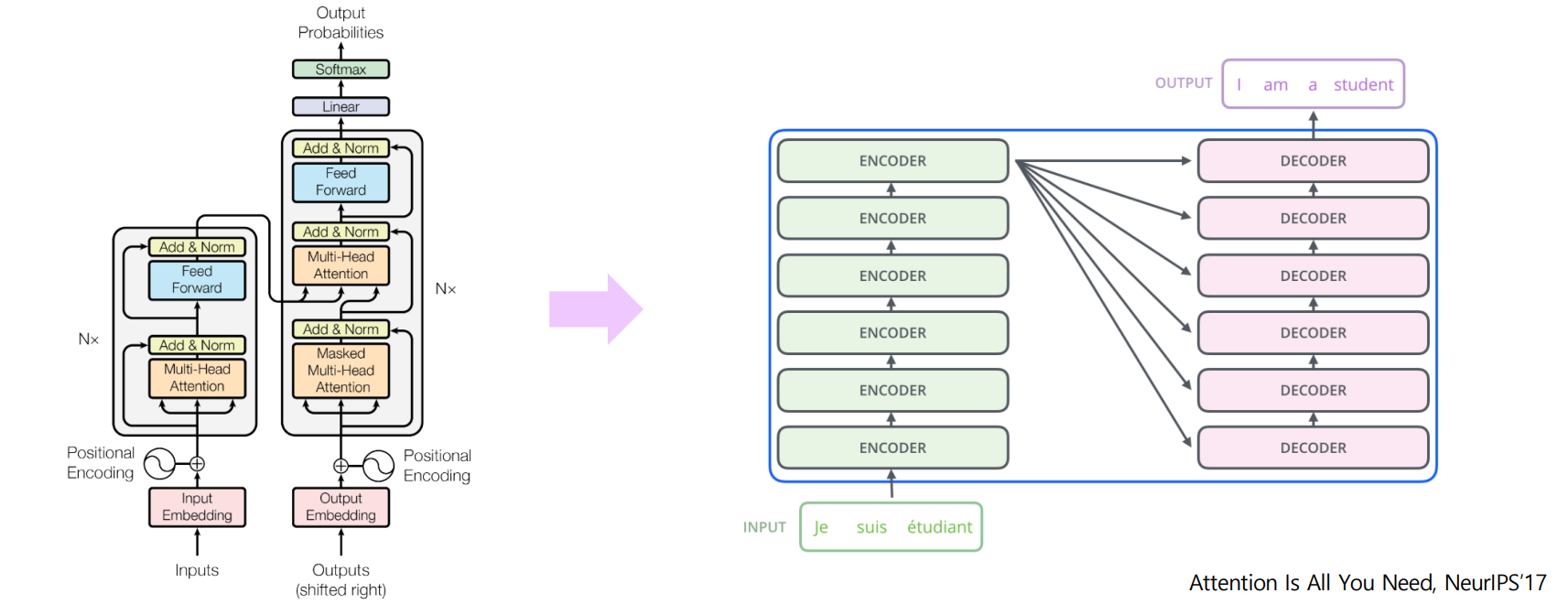

Transformer

-

Transformer: High-Level View

Attention is all you need

-

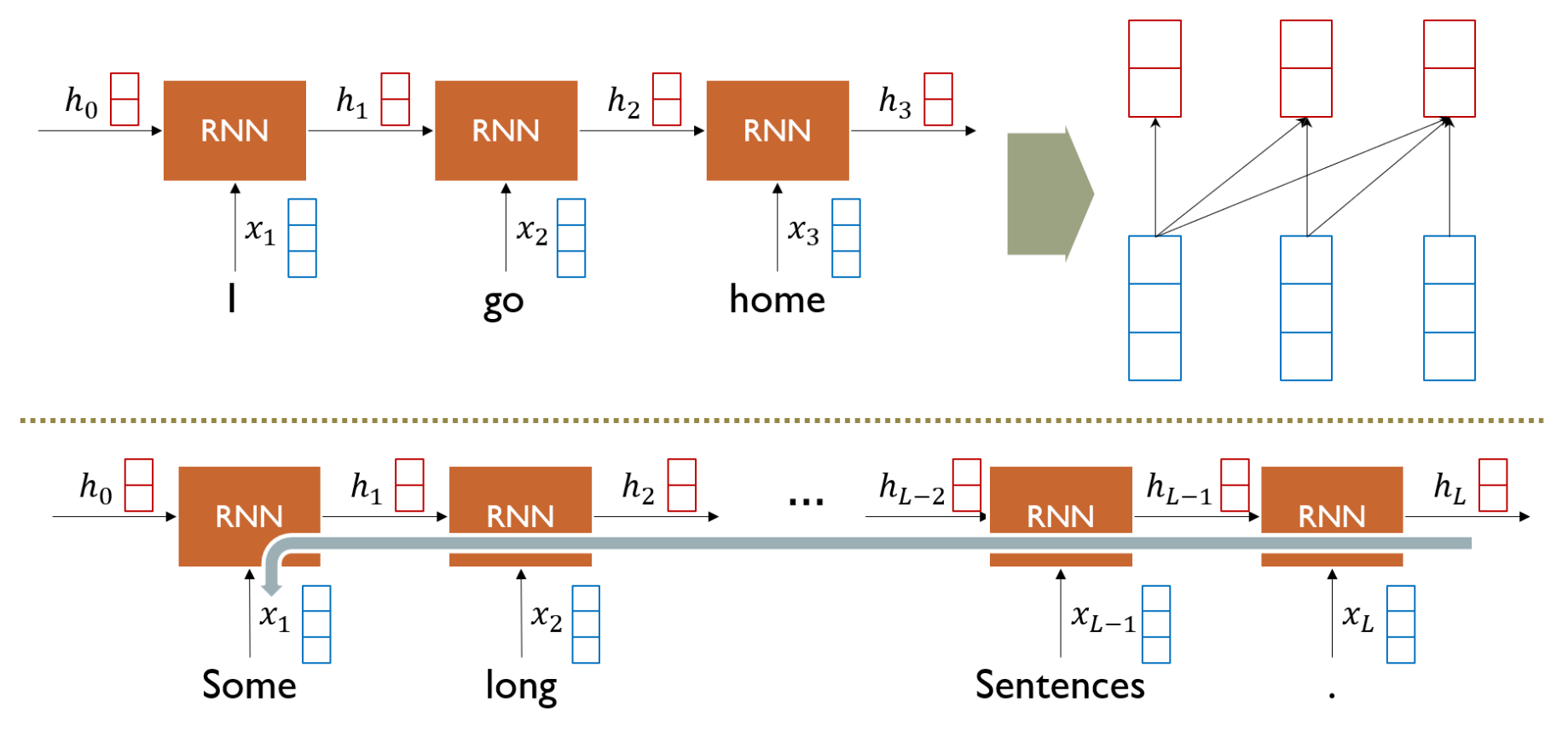

RNN: Long-Term Dependency

-

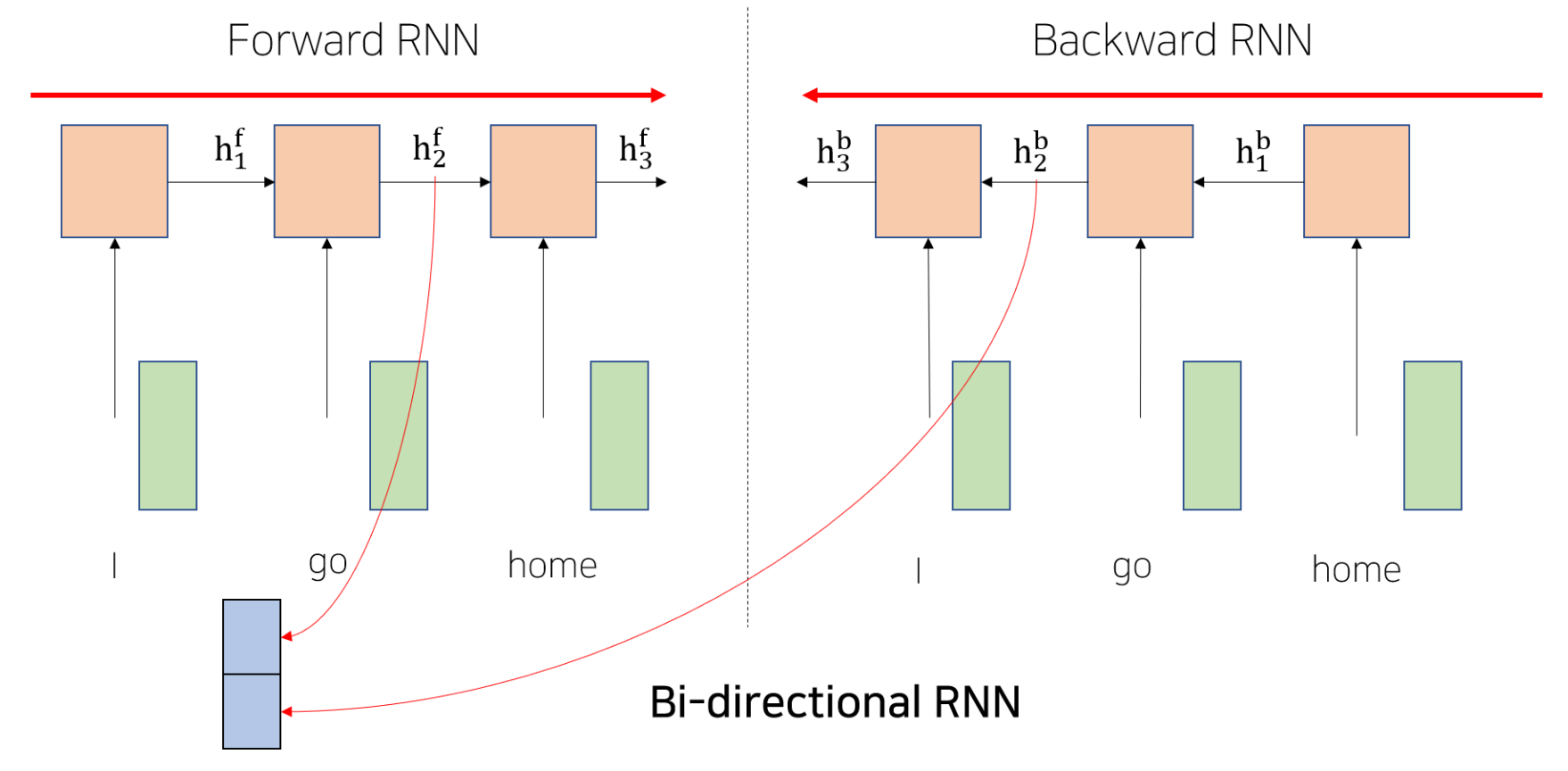

Bi-Directional RNNs

-

Transformer: Long-Term Dependency

-

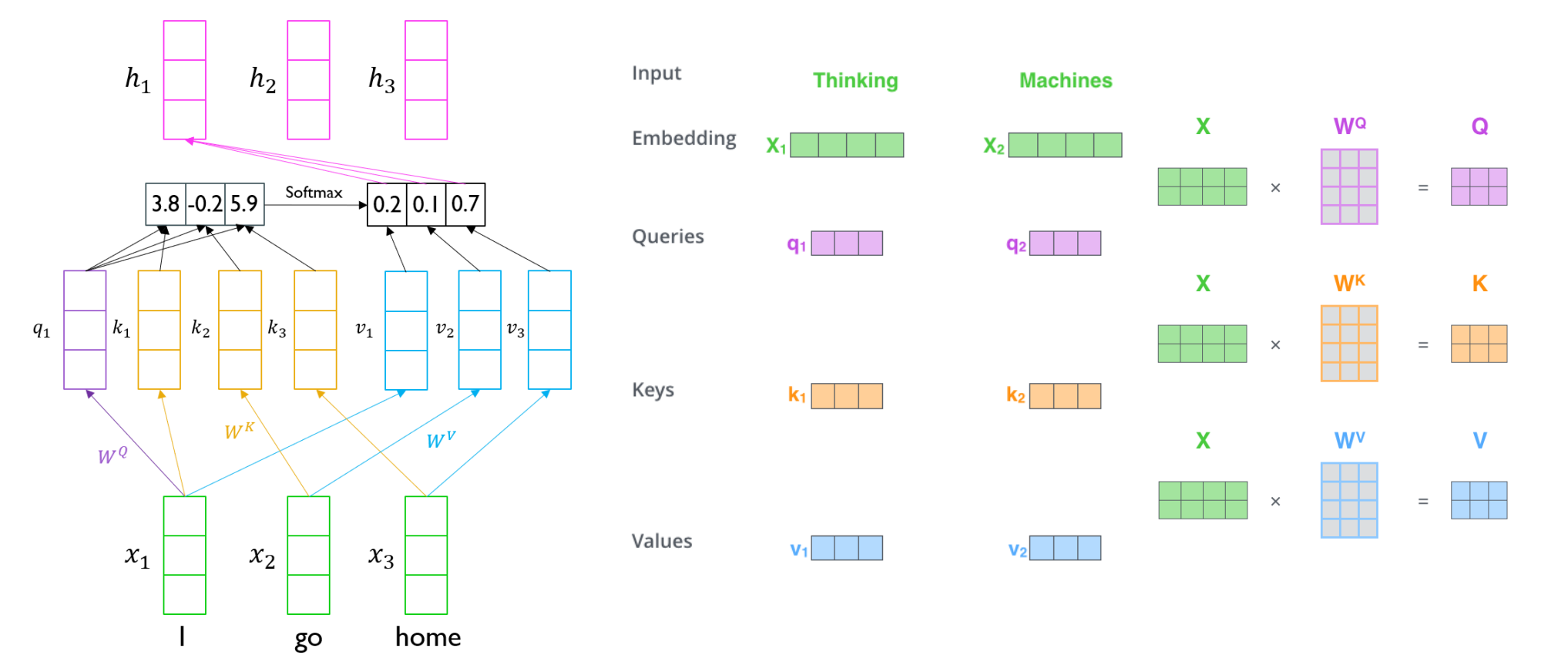

Transformer: Scaled Dot-Product Attention

1.Inputs: a query 𝑞 and a set of key-value (𝑘, 𝑣) pairs to an output

2.Query, key, value, and output is all vectors

3.Output is weighted sum of values

4.Weight of each value is computed by an inner product of query and corresponding key

5.Queries and keys have same dimensionality 𝑑𝑘, and dimensionality of value is 𝑑𝑣

[NLP]Transformer 2

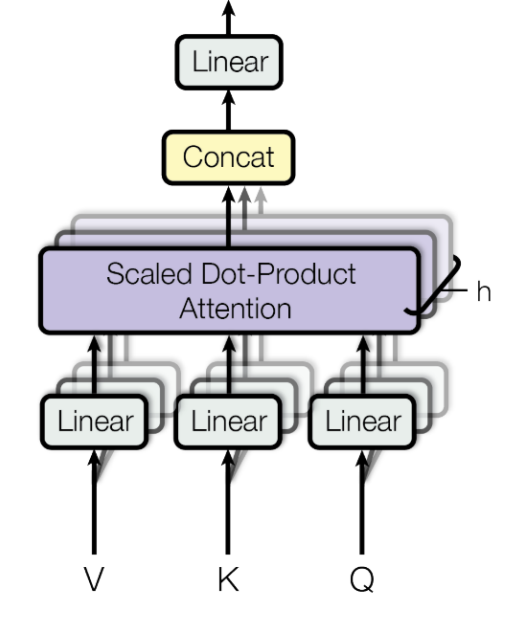

Transformer: Multi-Head Attention

1.The input word vectors are the queries, keys and values

2.In other words, the word vectors themselves select each other

3.Problem of single attention

4.Only one way for words to interact with one another

5.Solution

Multi-head attention maps Q, K, V into

the ℎ number of lower-dimensional spaces via � matrices

6.Then apply attention, then concatenate outputs

and pipe through linear layer

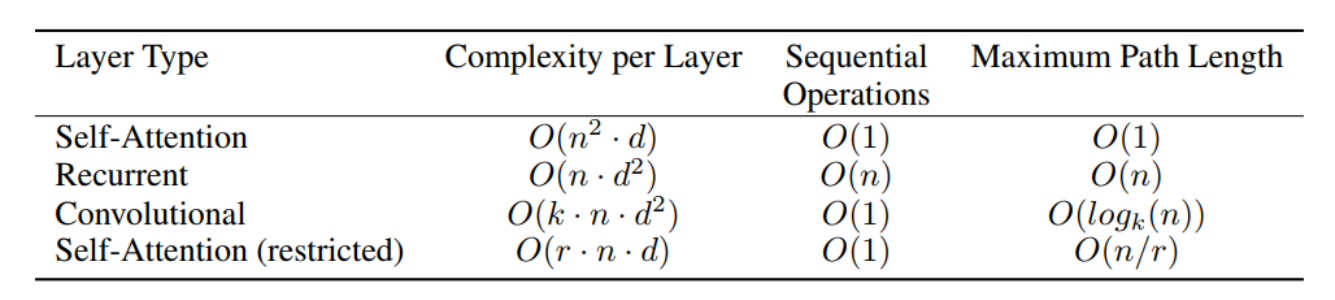

8.Maximum path lengths, per-layer complexity and minimum number of sequential operations for different layer types

• n is the sequence length

• d is the dimension of representation

• k is the kernel size of convolutions

• r is the size of the neighborhood in restricted self-attention

Transformer: Block-Based Model

- Each block has two sub-layers

1.Multi-head attention

2.Two-layer feed-forward NN (with RELU)

- Each of these two steps also has

1.Residual connection and layer normalization:

2.LayerNorm(x+sublayer(x))

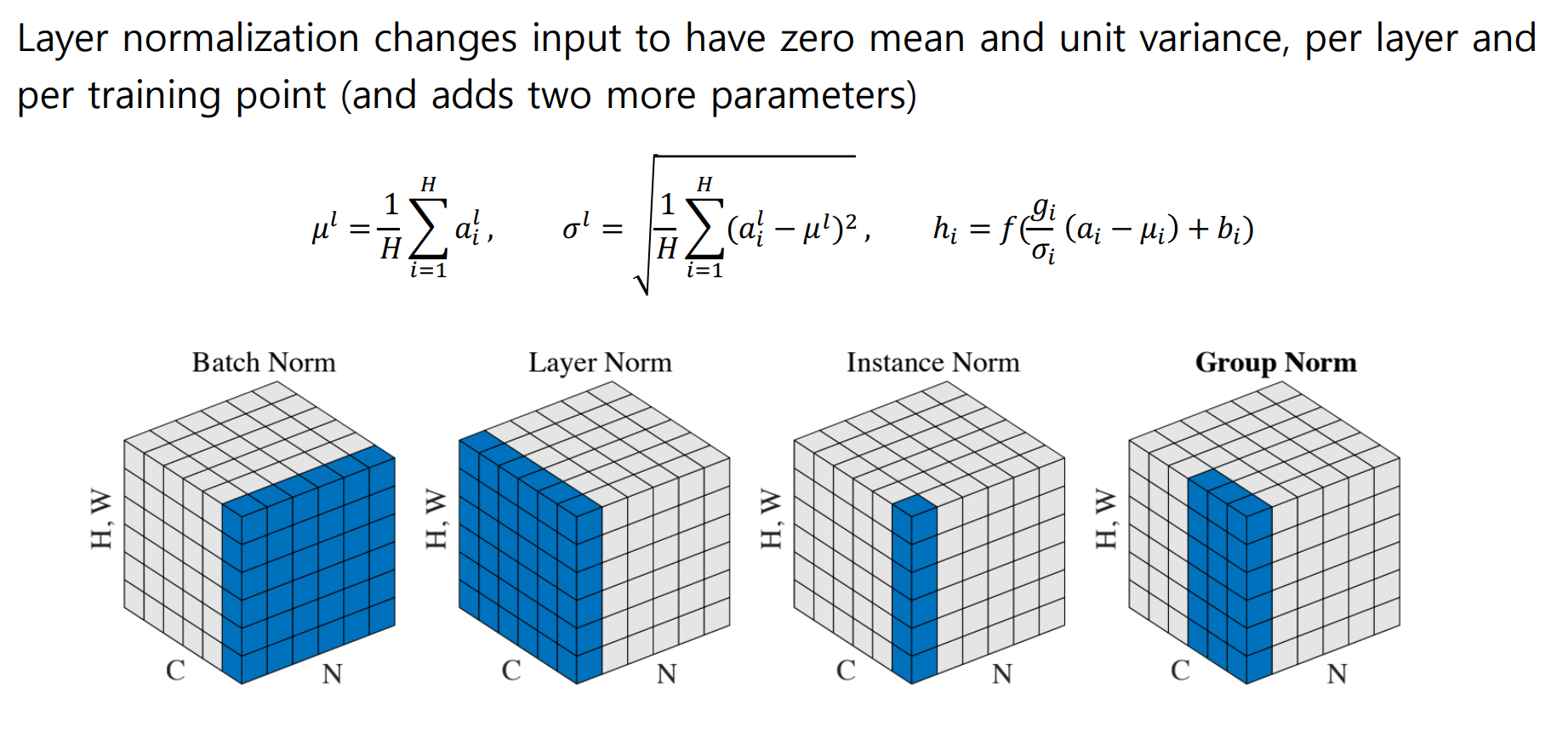

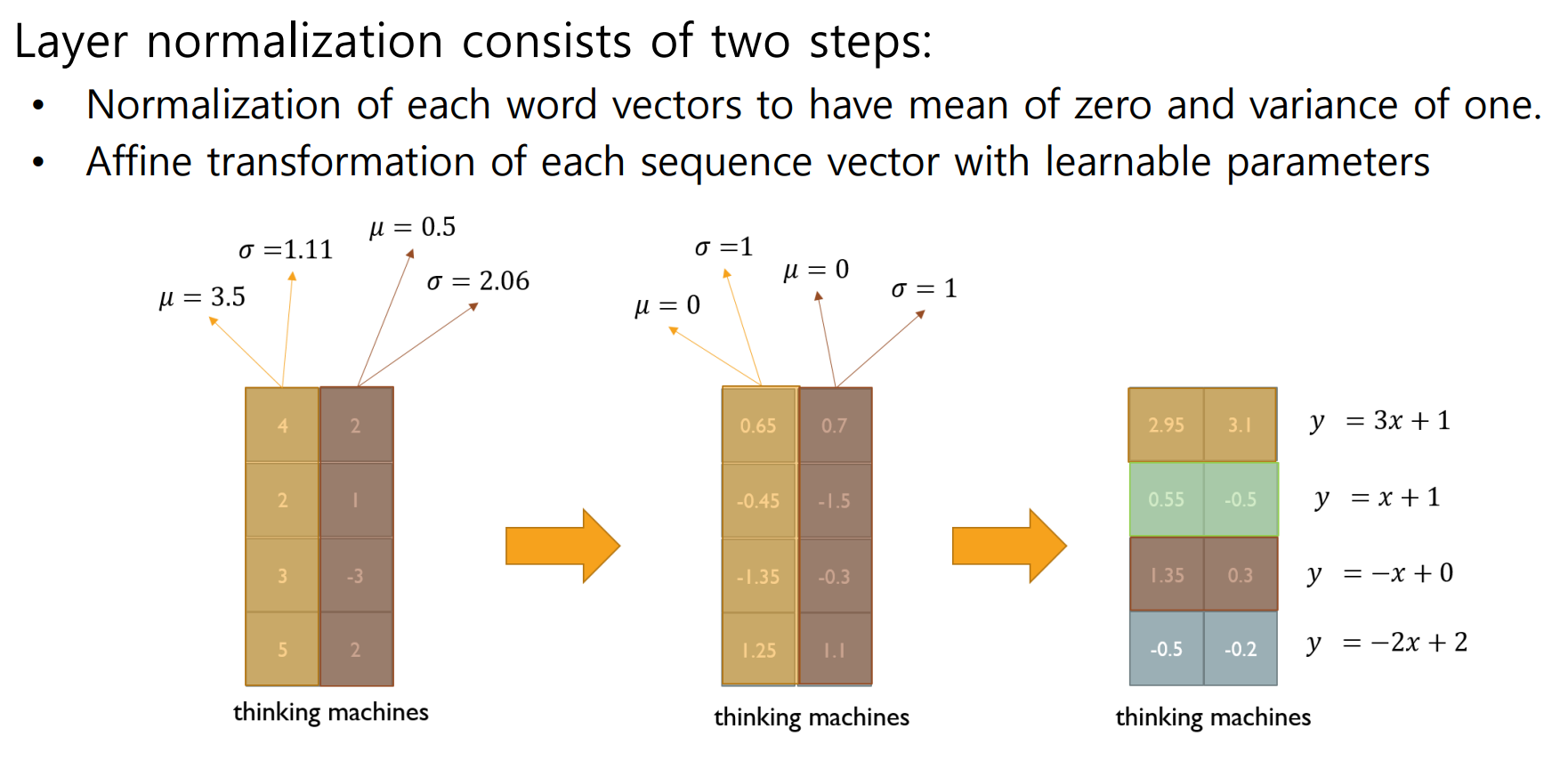

Transformer: Layer Normalization

2.과제 수행 과정/결과물 정리

[선택과제1] 완료

3.피어 세션

학습 내용 공유

1.강의 내용 및 심화내용 토론

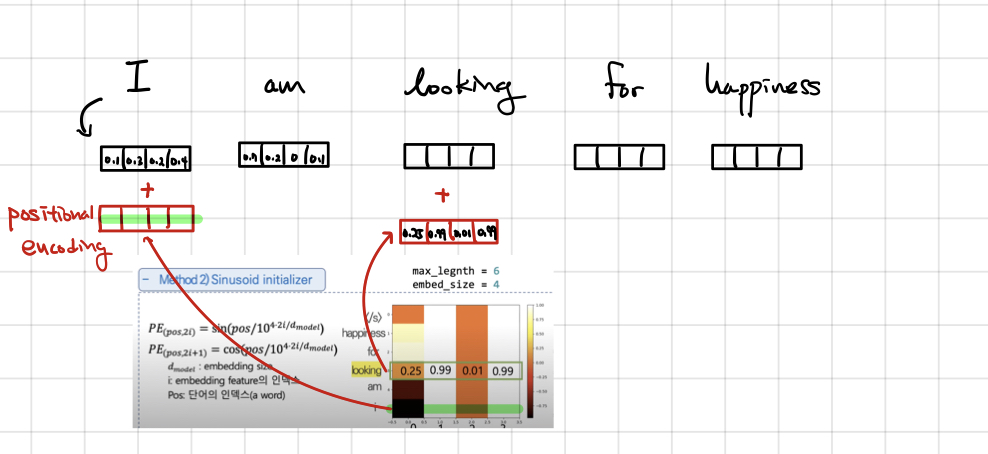

Q1)Positional Encoding

index 0의 임베딩 벡터가 7차원이라고하면, 첫번째 벡터부터 일곱번째 벡터 각각에 미리 구해둔 사인함수 값을 더해주는 걸로 이해했는데 맞나요?

(4, -2, 0, 3, -5, 8, 1)

→ (4+0.1, -2+1.0, 0-0.5, 3+0.25, -5+0.5, 8-0.12, 1+0.67)

이런 형식이 맞을까요? 확실하게 하고싶어서 질문 남깁니다!

A1-1)생각하신게 맞는 것 같습니다. 위 경우에서는

(+0.1, +1.0, -0.5, +0.25, +0.5, -0.12, +0.67) 이라는 벡터가 첫번째 position을 나타내는 positional encoding vector가 되겠네요.

혹시 몰라서 예시를 더 들자면 I am looking for happiness 라는 문장이 있고, 각 단어들을 4 dimension으로 임베딩 한 다음, 각 단어를 임베딩한 차원과 동일한 차원의 positional encoding vector를 sinusoidal 함수로 생성하여 각 단어의 임베딩 벡터에 더해준다고 생각하면 될 것 같습니다.

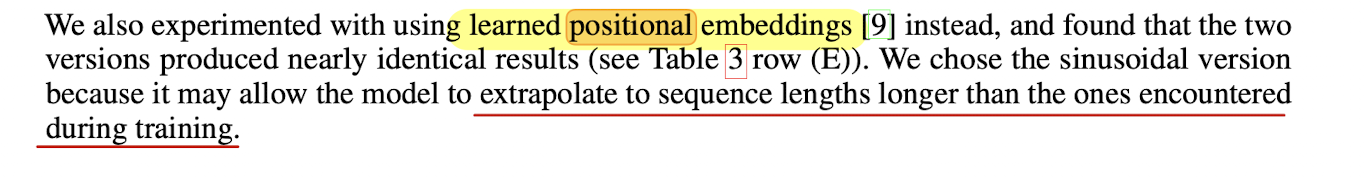

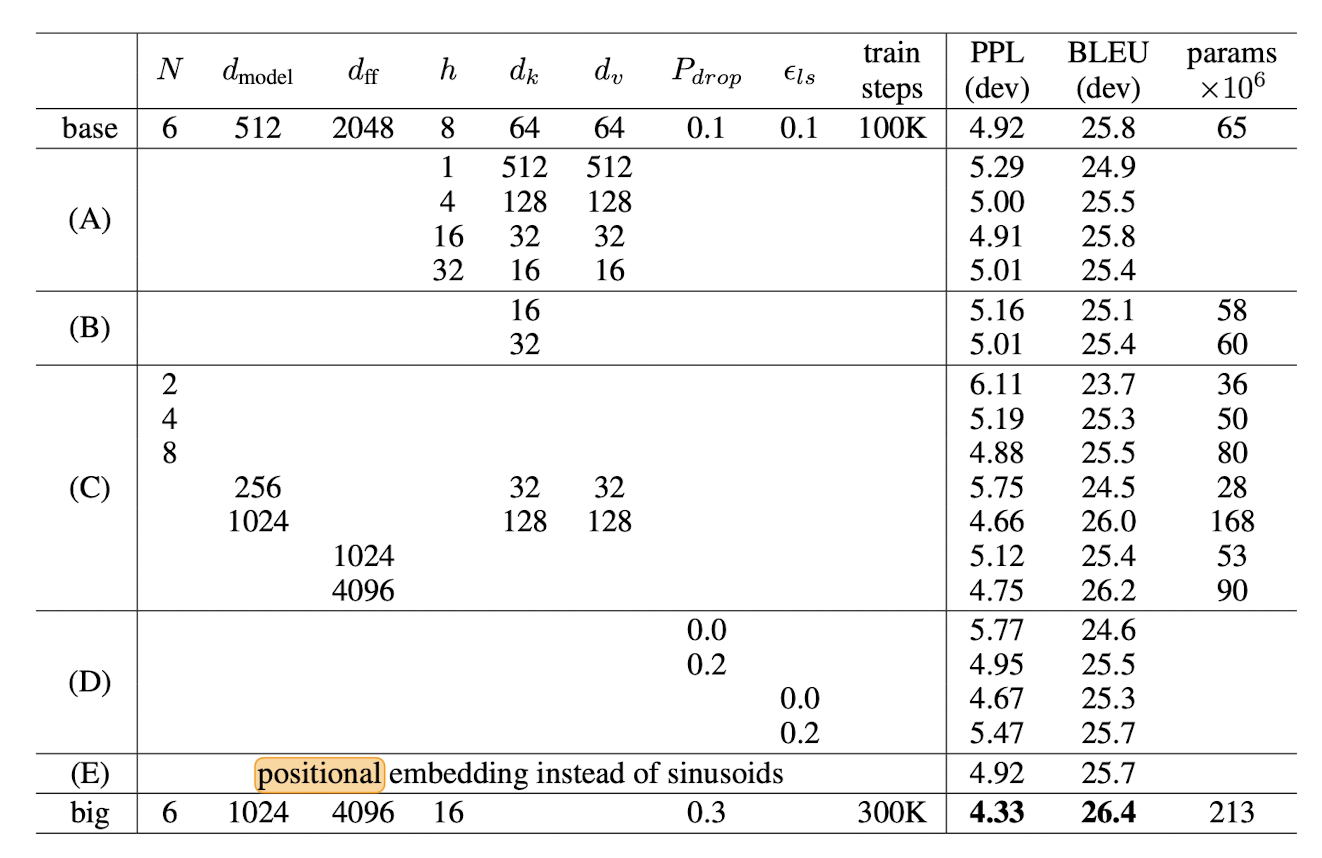

A1-2)positional encoding을 사용하지 않고, 이를 학습시켜도 비슷한 결과가 나온다고 합니다.

2.과제 내용 및 심화내용 토론

진행 X

4.학습회고

Transformer 모델은 계속해서 봐야할 것 같습니다. 백신 접종 후 아직까진 컨디션이 완전 회복되지 않아서 너무 무리하지 않고 계속 공부에 임할 생각입니다. 다행히 12주간 함께할 좋은 팀원분들을 만나 다행입니다. 금주 남은 이틀 간은 마저 강의 위주 학습하며 새로운 팀원들과 얘기를 나눌 것 같습니다.