머신러닝 종류에는 지도학습과 비지도학습 그리고 강화학습이 있다.

이 포스트에서는 지도학습과 비지도학습의 loss function을 다룬다.

1. 지도학습

지도학습 문제는 회귀 문제와 분류 문제로 나눌 수 있다.

회귀 (regression)

만약 예측값이 연속적인 값을 가진다면 그건 회귀문제이다.

회귀에서는 정답값과 예측값의 차이를 통해 학습하는데, 이때 그 차이를 어떻게 계산할 것인지에 따라 loss 함수의 종류가 나뉜다.

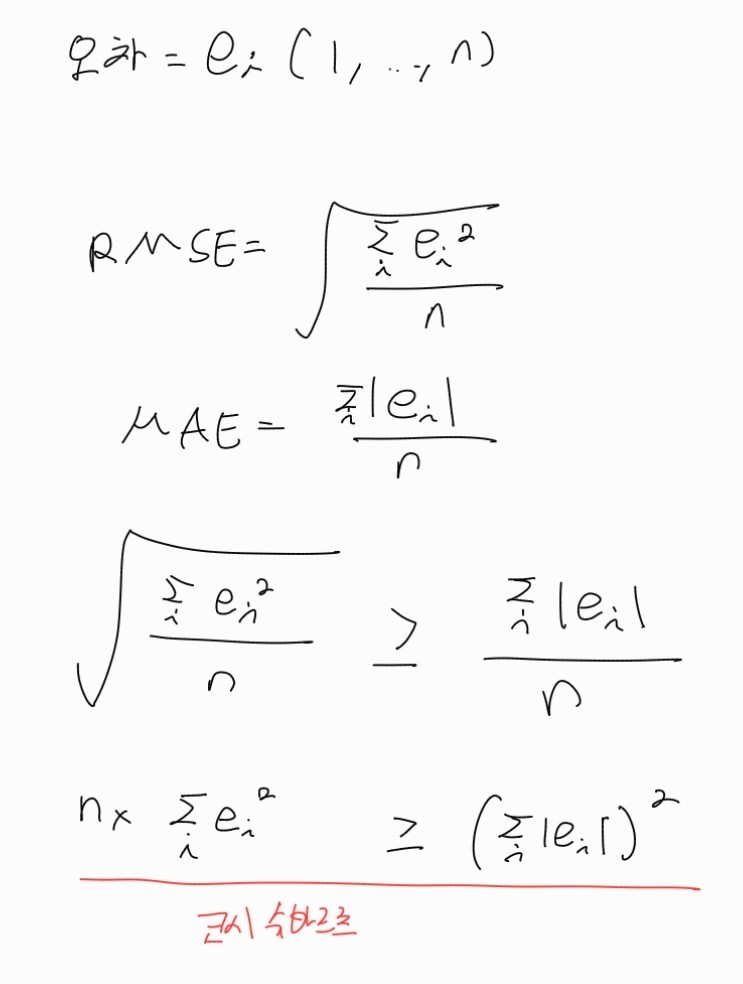

MSE (Mean Squared Error)

- MSE 같은 경우엔 오차의 제곱의 합으로 계산되므로, 이상치에 크게 영향을 받는다.

이러한 특성으로 인해 훈련 데이터에 overftting 될 가능성이 있다.

이런 걸 방지하기 위해서 쓸만한게 MAE다.

MAE (Mean Absolute Error)

- MSE와 달리 오차의 절댓값의 합이므로 이상치에 덜 민감하다.

RMSE (Root Mean Squared Error)

- MSE보다 이상치에 덜 민감하다.

- 이는 y=x 와 y=x^{1/2} 그래프를 생각해보면 알 수 있듯, x>1에서는 항상 x가 작다.

- MAE보다 이상치에 민감하다.

- MAE보다 RMSE가 항상 큰 건 코시-슈바르츠 부등식을 이용하면 증명할 수 있다.

- MAE보다 RMSE가 항상 큰 건 코시-슈바르츠 부등식을 이용하면 증명할 수 있다.

- 만약 MAE 보다는 이상치 학습에 조금 더 가중치를 두고 싶을 때 사용할만한 loss이다.