CS231N

1.👩🏻💻Standford CS231N Deep Learning -6

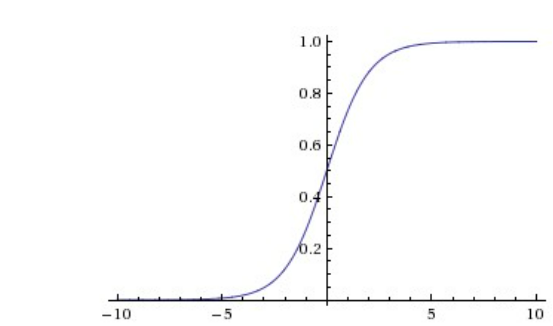

Sigmoid 함수는 모든 수를 0,1 사이의 수로 squash 한다. 가장 간단한 activation function이지만, 문제점이 있다. 1\. satured neurons "kill" the gradients backpropagation에서 local grad

2.👩🏻💻Standford CS231N Deep Learning -5

2020/09/20 깃헙 블로그 기록Neural Network와 기본적으로 동일Input이 Image기존의 NN에서 이미지를 학습하면 파라미터의 수가 너무 많기 때문에 빠르게 overfitting 됨width, height, depth 로 3D layer를 이용 역사랑

3.👩🏻💻Standford CS231N Deep Learning -4

2020/09/13 깃헙 블로그 기록복잡한 수식을 나눠서 간단하게 image여러 layer를 거쳐 결과를 낸다image예시는 간단하지만, 실제 neural network는 복잡함식을 하나씩 나눠서 미분과 chain rule을 이용해 각각의 편미분 값 구함derivati

4.👩🏻💻Standford CS231N Deep Learning -3

2020/09/12 깃헙 블로그 기록imageW의 각 행은 class의 classifier로 생각하거나 각 class의 template (prototype)으로 생각할 수 있다Wx+b 에서 (W,b)쌍을 기억하기 보단, x의 첫 col에 1을 추가하고, W와 b를 한

5.👩🏻💻Standford CS231N Deep Learning -2

2020/09/05 깃헙 블로그 기록semantic gap : 사진을 이미지로 보는게 아니라 픽셀의 숫자로 봄viewpoint variation background clutterIllumination : 밝기나 음영occlusion : 다른 사물에 가려져 구분이 힘든

6.👩🏻💻Standford CS231N Deep Learning -1

2020/09/05 깃헙 블로그 기록큐시즘 스터디로 스탠포드의 CS231n 강의를 듣게 되었다. 학과 커리큘럼 상 AI 가 4학년 2학기 과목인데, 요즘 가장 관심가는 분야가 인공지능, 딥러닝, 머신러닝이라서 나의 빠른 진로 선택을 위해 딥러닝 공부를 해보고 싶었던 차