서론

AI는 1950년대부터 시작되어, 최근에는 바둑에서 기계가 인간을 이긴

2016년을 후로 AI 기술은 더더욱 많은 관심을 받았다.

전세계의 주목을 받던 AI 기술은 나날이 발전했으나,

최근에는 AI에 대한 기술적 한계와 관련된 이야기가 많이 나오고 있다.

도대체 AI에게 어떤 기술적 한계가 있으며,

이를 고치거나 혹은 대체할 수 있는 방안에 대해 짧게 알아볼 것이다.

AI는 어떻게 동작할까?

먼저 기술적 한계가 어디에서 발생하는지 알아보기 위해,

AI가 어떻게 동작하는지를 물리적인 측면에서 짧게 알아보자.

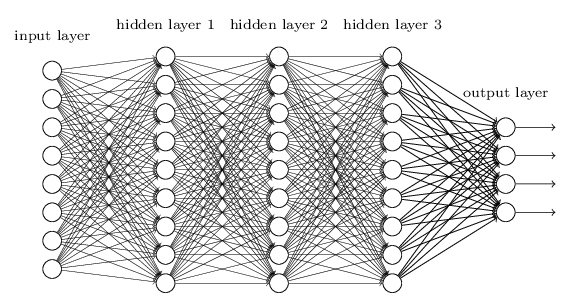

AI는 데이터를 처리하도록 컴퓨터에게 학습시키는 '딥러닝' 기술을

핵심적인 기술로 사용한다.

이는 대규모 데이터를 처리하고, 복잡한 계산을 수행하는 능력을 필요로 한다.

그렇다면 딥러닝을 어떻게 효율적으로 처리할 수 있을까?

바로 GPU, 즉 그래픽카드를 사용하는 것이다.

GPU는 그래픽 처리에 최적화된 반도체 칩으로, 병렬 처리에 효율적이다.

이는 많은 양의 데이터를 동시에 처리할 수 있다는 의미로,

딥러닝에서 수많은 가중치를 동시에 계산할 때 GPU를 사용하면

이를 빠르고 효율적으로 처리할 수 있다.

GPU를 사용하면 학습 시간을 단축시키고, 더 복잡하고 정교한 AI 모델을

구현할 수 있다.

따라서 거의 모든 딥러닝 분야의 AI가 GPU를 필수 도구로 인식한다.

그렇다면 무슨 문제가 있는거야?

결론부터 말하면, AI의 성능적 한계는 GPU 때문이다.

딥러닝은 특히 대량의 데이터를 처리하는 데 많은 컴퓨팅 능력을 필요로 한다.

GPU는 이런 작업에 효율적이지만, 최근에 GPU의 성능에 한계가 왔기에

AI의 계산 능력에도 제약이 생기는 것이다.

그렇다면 GPU는 왜 성능에 한계가 온걸까?

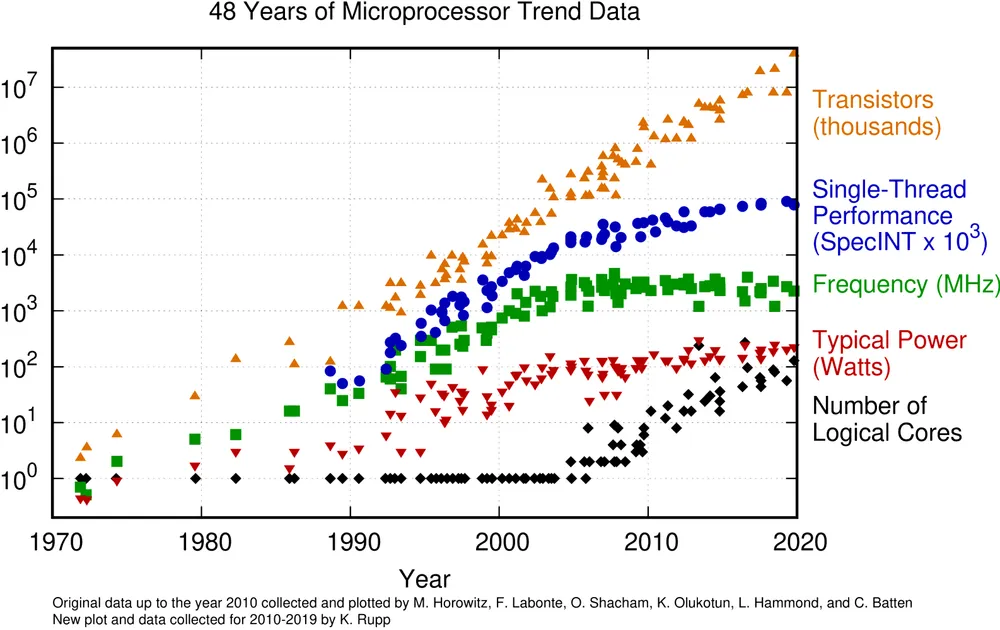

깨져버린 무어의 법칙

무어의 법칙이란 약 2년마다 비용은 최소한으로 증가하며,

반도체 집적회로에 집적할 수 있는 트랜지스터가 두 배씩 증가한다는 관측이다.

무어의 법칙이 깨져버린 이유는 설명하자면, 음...

가장 근본적인 물리법칙상 란다우어의 원리에 따르면 정보를 지울 때 발생하는

열 에너지는 열역학 제2법칙에 의해 25℃의 실온에서 22.8262J/ZB(=26.9484J/ZiB)보다 작을 수 없다.

라고 한다.....응... 대충 물리법칙에 의해서

저 22.8262J/ZB라는 값보다 기기가 더 작아질 수 없다는 의미이다.

그래픽카드 공정 또한 세밀해져서, 2019년 기준 최신 CPU인 ADM 기준

7nm의 공정까지 왔다고 한다.

하지만 5nm쯤 되면,

기존 불화아르곤 공법으로는 생산이 불가능할 정도로 미세할 뿐만 아니라 양자터널링 현상으로 인해 회로를 구성하는 원자의 전자가 다른 곳으로 워프하는 양자역학적인 문제가 생기기 때문에 근접 회로에 합선이 일어날 수 있다.

음... 라고 한다.. 대충 너무 작아지면 합선이 발생하여 GPU가 엉킨다는 의미이다.

결론

이렇게 GPU의 성능 발전을 보장하는 무어의 법칙이 깨짐으로,

하드웨어가 AI가 필요로 하는 성능을 버틸 수 없기에 더 이상 AI의 기술적 발전에는

무리가 왔다고 볼 수 있는 것이다.

따라서 AI를 사용한 서비스만이 더 발전할 뿐,

AI 자체에 대한 성능은 더 발전할 수 없게 되었다.

유행의 변화

꾸준히 인기있던 기술인 AI가 기술적 한계에 봉착함에 따라

이에 따른 열기도 식으며 또 다른 기술이 요즘 대두되고 있다.

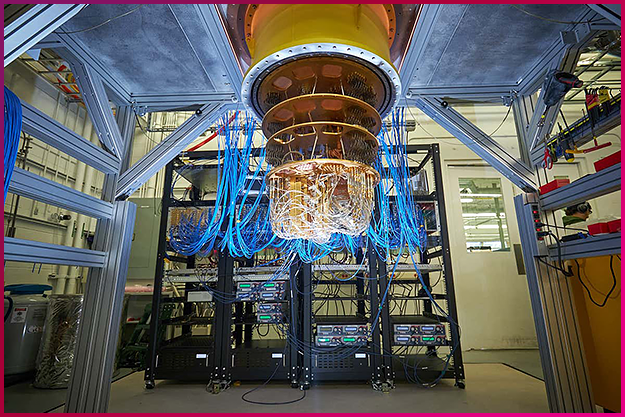

양자컴퓨터?

바로 양자컴퓨터이다. 우리가 살고 있는 세계가 양자로 이루어져있는데,

이를 기본 컴퓨터처럼 0과 1로 처리하는 것이 아니라,

우리 세계와 똑같은 단위인 양자로 처리를 하는 컴퓨터가 양자 컴퓨터이다.

예를 들어, 상자 100개가 있고 그 중 한 곳에만 무작위로 구슬이 들어있다 가정해보자.

일반적인 컴퓨터는 첫 번째 상자부터, 백 번째 상자까지 하나 하나씩 전부 열어본 후

어디에 구슬이 들어있는지를 알려준다.

하지만 양자 컴퓨터는 양자 중첩 상태로 인해 100개의 상자를 동시에 열어본 후

어디에 구술이 들어있는지를 알려준다.

이런 정신나간 성능은 현재 존재하는 슈퍼 컴퓨터가 수백 년이 걸려도

풀기 힘든 문제를 단 몇 초 내의 속도로 풀 수 있을 것으로 전망된다고 한다.

현재 양자 컴퓨터계가 해결해야 하는 가장 큰 이슈는 정확률이다.

현재 양자 컴퓨터의 정확률이 99.9% 정도라고 하는데,

99.9%의 확률로 백 번만 연산을 돌린다고 가정하고 계산해도

99.9%였던 정확률은 확연히 훅 떨어질 것이다.

이런 정확률 이슈를 해결한다면, 곧 양자 컴퓨터의 시대가 도래할 것이다.

양자 컴퓨터가 상용화된다면

양자 컴퓨터가 상용화되면, 우리의 일상도 지금과는 많이 다르게 바뀔 것이다.

양자 컴퓨터를 베이스로 둔 현실 세계와 똑같은 가상 세계를 만드는 '디지털 트윈'이라는 기술도 상용화될 것이며,

이 기술은 의학 뿐만이 아니라 온갖 모든 분야에서 유용하게 사용될 것이다.

그 외에도 현재 존재하는 모든 암호가 양자 컴퓨터에 의해 해독될 것이기에,

양자 컴퓨터도 풀지 못하는 양자 암호가 개발되는 등 다양한 기술적인

변화도 생길 것으로 예상된다.

마무리

필자는 이런 양자컴퓨터에 관한 소식을 듣고 처음에는 거부감을 느꼈다.

하지만 미래 개발자로, 새로운 기술에 대해 수용하고 이에 학문적인

호기심을 느껴보려는 노력을 더욱 해야겠다고 생각했다.

언제나 양자 컴퓨터와 관련된 내용을 공부하는 것은 흥미롭고 재밌는 일 같다.

현재 양자 컴퓨터와 AI 기술에 종사하고 계시는 여러 개발자분들에게

존경을 보내며... 나도 혁신 기술을 추구하는 개발자가 되려고 노력해야겠다.

화이팅!

ㅋ

ㅋ3개의 댓글

https://www.chambers.com.au/forum/view_post.php?frm=3&pstid=107038

https://zybuluo.com/bothbest/note/2621656

https://qualityherb.livepositively.com/how-high-quality-bamboo-flooring-is-made

https://qualityherb.livepositively.com/top-5-reasons-bamboo-flooring-outshines-traditional-hardwood/

https://qualityherb.livepositively.com/the-science-behind-bamboo-flooring/

https://www.hentai-foundry.com/user/chinabamboo/blogs/20367/Ecofusion-Bamboo-Flooring-A-Sustainable-Choice

https://www.hentai-foundry.com/user/bothbest/blogs/20366/Bamboo-Flooring-vs.-Laminate-Flooring

https://www.hentai-foundry.com/user/bothbest/blogs/20360/Hidden-Benefits-of-Bamboo-Flooring

https://www.hentai-foundry.com/user/bothbest/blogs/20357/The-Unique-Journey-of-Bamboo-Flooring

https://www.hentai-foundry.com/user/bothbest/blogs/20372/Bamboo-Flooring-Maintenance-Made-Easy

https://www.hentai-foundry.com/user/bothbest/blogs/20375/From-Harvest-to-Floorboard-Bamboo-Flooring-Production

잘 읽었습니다 ! 혹시 관련 정보 출처를 알 수 있을까요 ?