궁극적인 목표 : Neural Network + Deep learning 에 대한 이해

-> Logistic Classification은 선행개념이자 기초 지식

Logistic Classification

배경 지식:

- 모델 함수 : f(x) = W * x + b

- 학습을 한다는 것 : 최소화 하는 W를 찾아가는 것

- learning rate : 경사하강법때 내려가는 발자국의 크기

회귀와 다른 점 : Binary Classification으로 역할을 하게 된다

-

EX) Spam mail / Ham E-mail : 스팸 메일과 햄 메일 구분

Spam / Ham = 1 / 0 으로 구분 -

EX) Facebook 게시글 추천/숨김 기능 : 유저가 관심만 있을 만한 피드만 추천하는 기능

Show / Hide = 1 / 0 으로 구분 -

EX) Credit Card Fraudulent Transaction detection : 사용자 신용카드 소비 패턴을 파악 한후 카드가 가짜인지 진짜인지 구분

Fraud / Legitimate = 1 / 0 으로 구분 -

EX) 주식투자를 할 것인가 말 것인가, 암인가 아닌가

-

이와 같이 어떠한 값을 예측하는 것이 아니라 확률값을 이용하여 한가지 기준에 의한 두 분류집단으로 분류를 함

가설함수

-

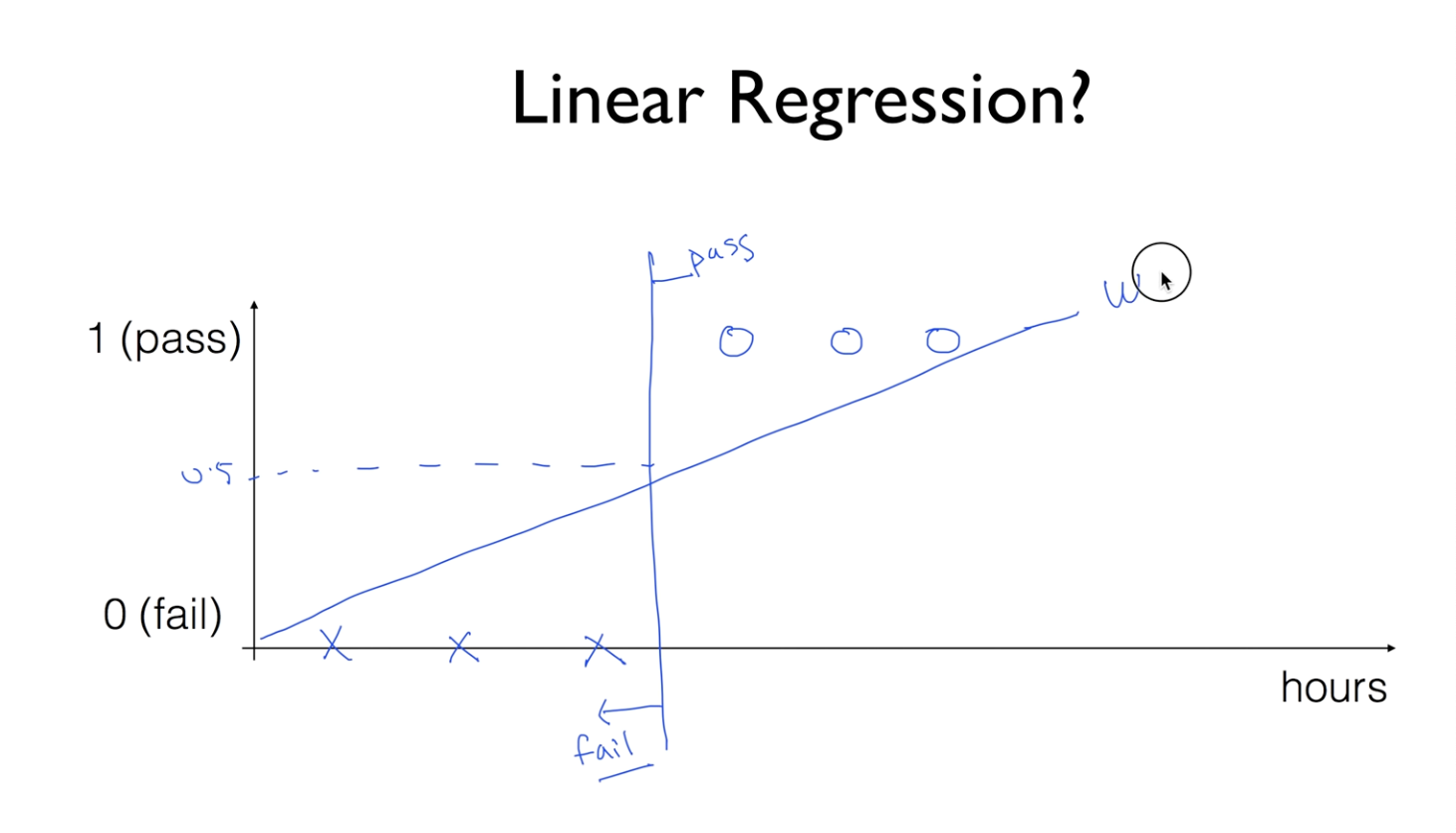

아래 그림과 같은 방법으로 Linear Regression을 이용해서 0과 1의 기준을 정해줌.

-

회귀 함수를 그대로 사용할 경우 문제점 : Linear Regression 을 사용하면 0과 1로 정해지는 함수가 아님. classification활용에 사용하기 어려움

-

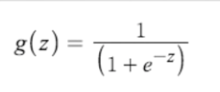

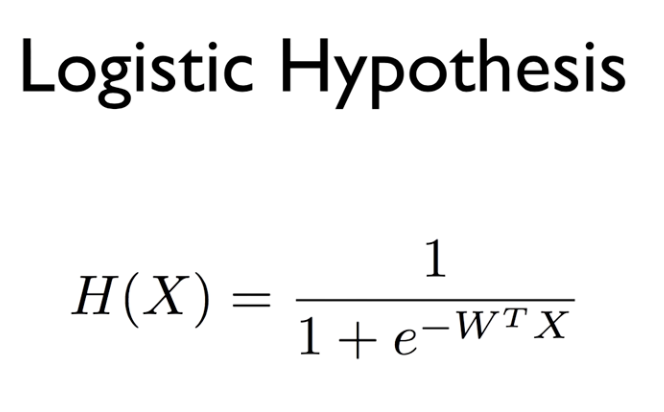

sigmoid 함수 : 어떤 X값이 주어져도 0~1값이 나오도록 되어있음. 따라서 기존 Linear Regression에서 쓰였던 가설함수를 sigmoid 함수에 합성함으로서 문제점을 해결 할 수 있음

-

최종 Logistic Hypothesis (가설 함수)

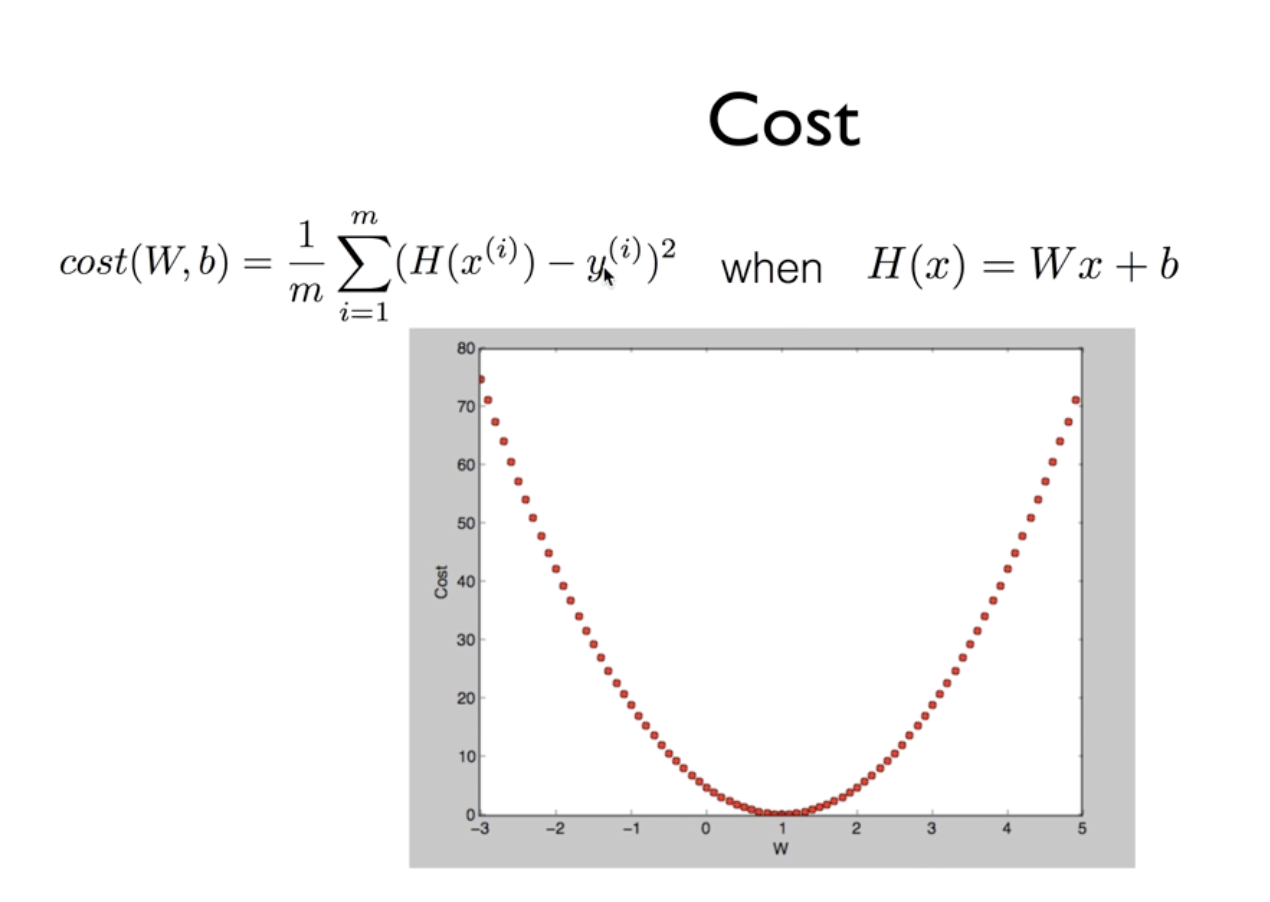

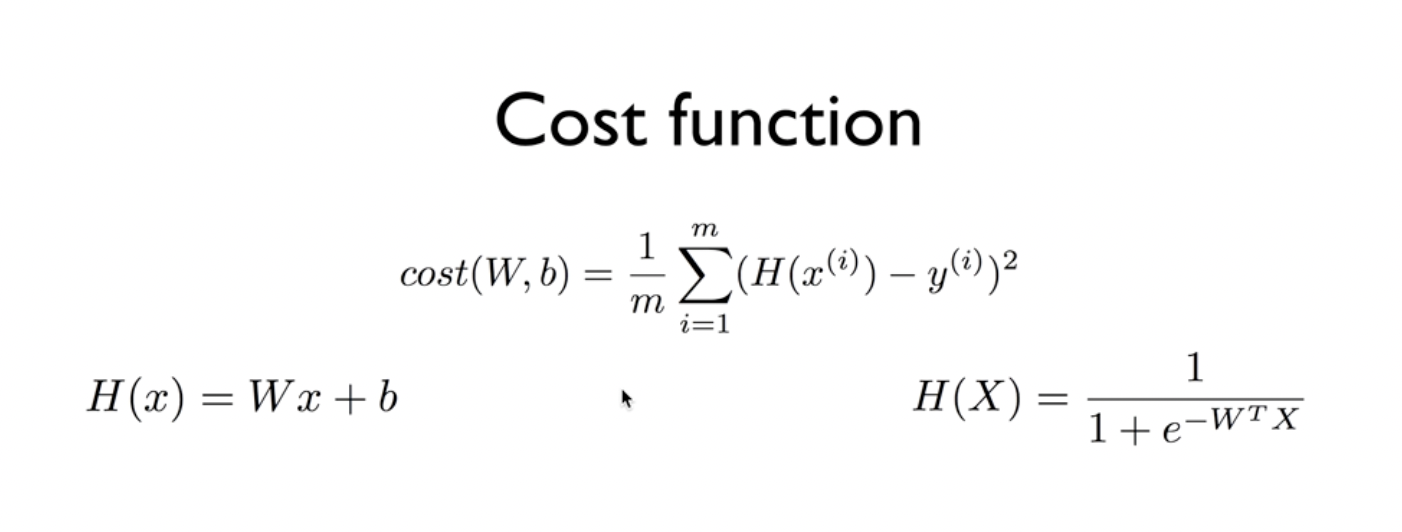

Cost Function

-

기존 가설 함수

-

바뀐 가설 함수

-

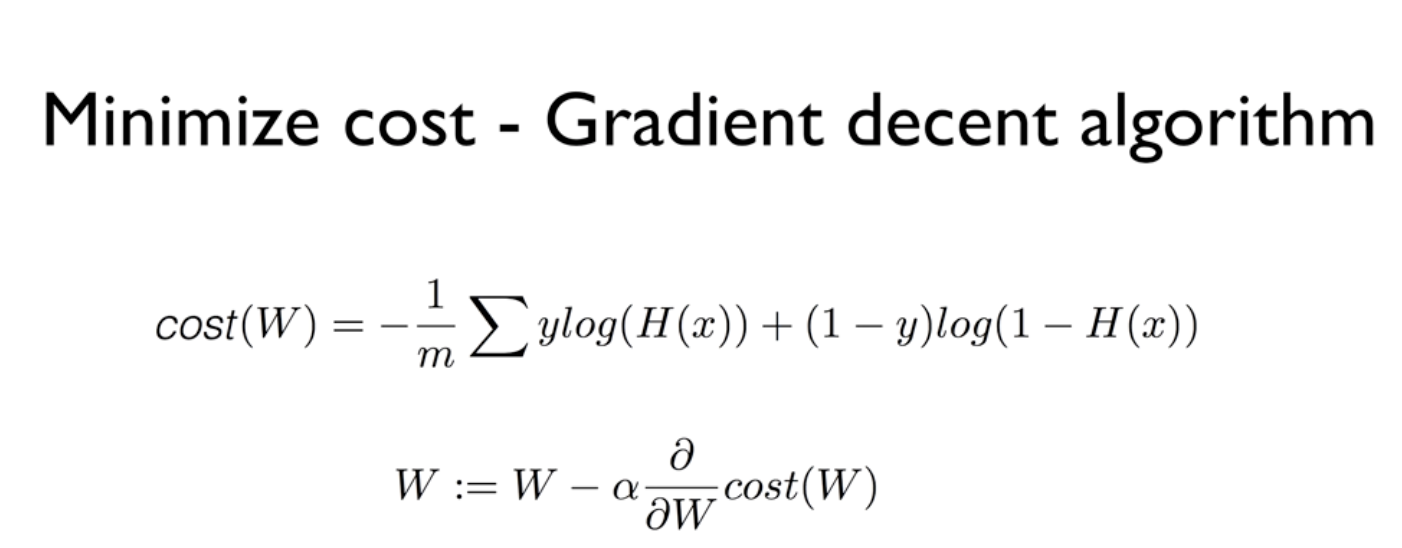

문제점 : 기존 Linear Regression에서는 Cost function의 모형에 굴곡이 없으나, 현재 Logistic Classification의 함수는 경사가 굴곡이 있어 경사하강법을 적용할 경우 시작점에 따른 Local Minimum값이 달라짐.

즉, Global Minimum이 아닌 Local Minimum을 구하게 되서 최소값을 구할 수 없게 됨. 따라서 경사하강법 적용을 위해 다른 Cost Function을 구해줘야 됨. -

바뀐 Cost Function : Log 함수를 활용한 cost function을 만들어줘서, 기존 가설함수에 있는 지수로 생기는 굴곡 문제를 해결함. 또한 값을 다르게 인식 했을 때, log 함수 특정상 Cost Function의 값이 비약적으로 커지기 때문에 Cost Function으로 적합함

Gradient Descent