모두를 위한 딥러닝 1 :: Lecture 3 How to minimize cost

Linear Regression의 Cost함수 최소화 방법 : Gradient descent Algorithm 경사하강법

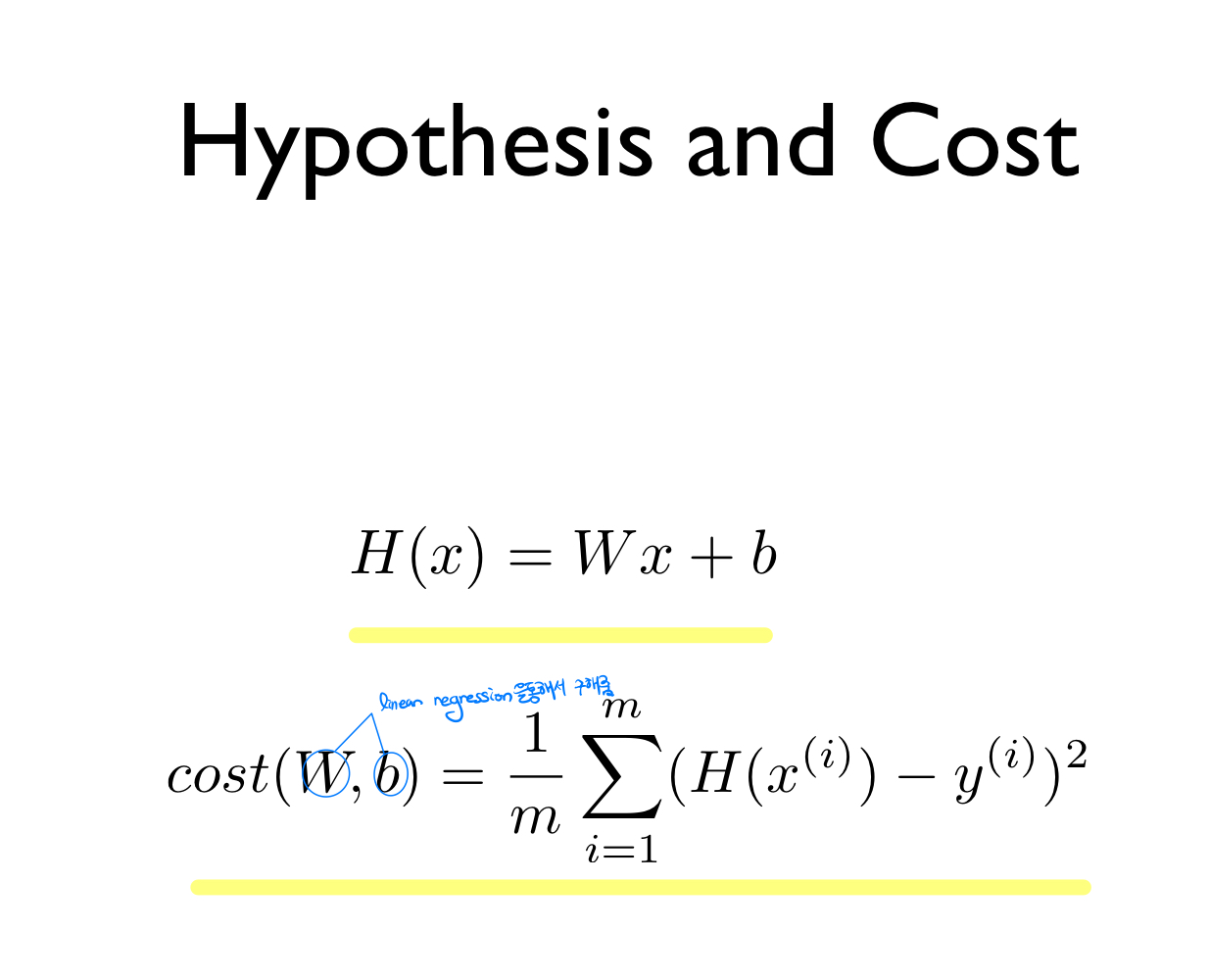

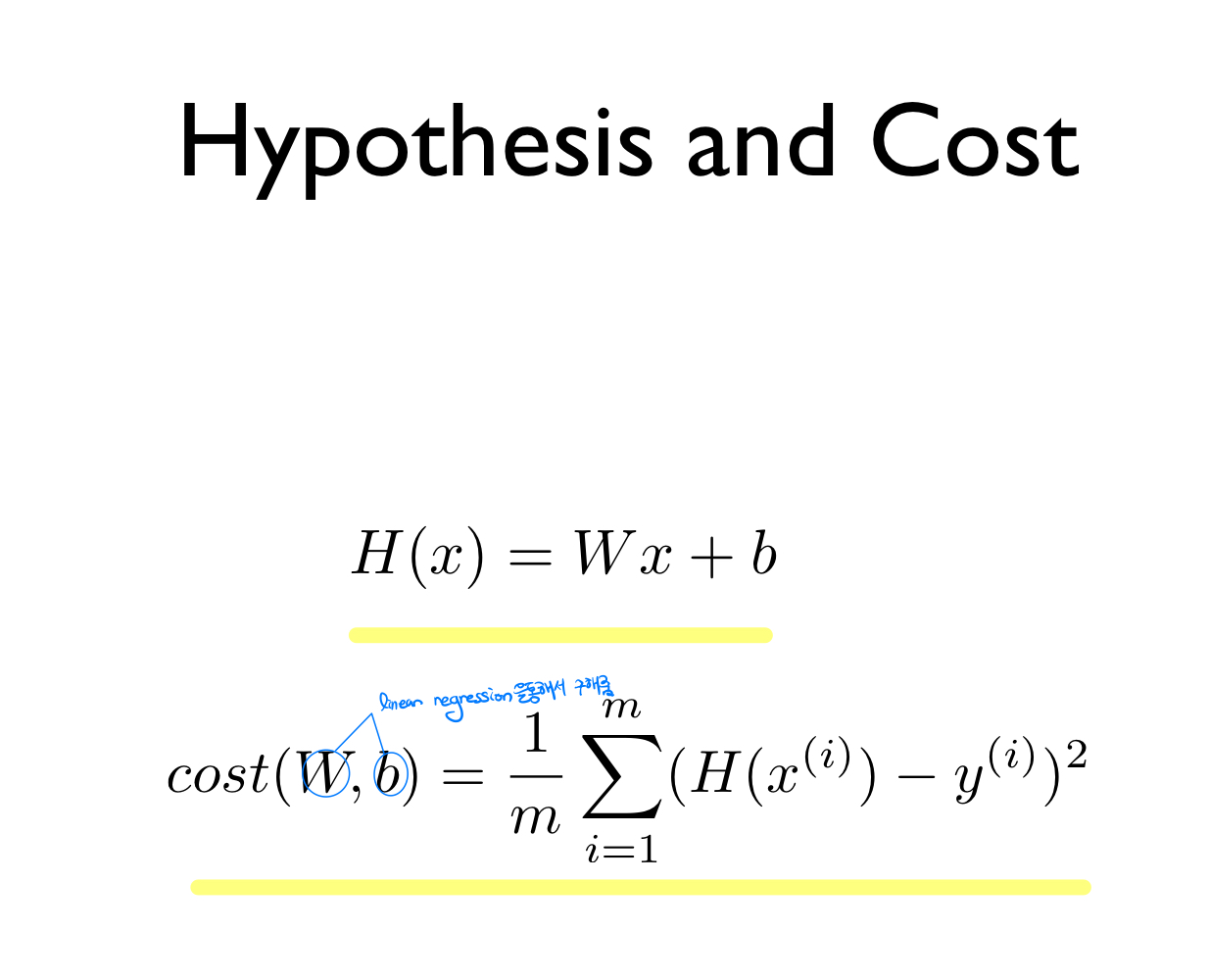

- Linear Regression의 모델링 함수 H(x)와 손실함수 cost(x)의 복습: H(x)가 주어졌을 때, 실제의 y값과의 차를 이용한 손실함수를 이용해서, W, b의 값을 구해준다. 이 때, 어떠한 방식으로 값을 구할 수 있을까?

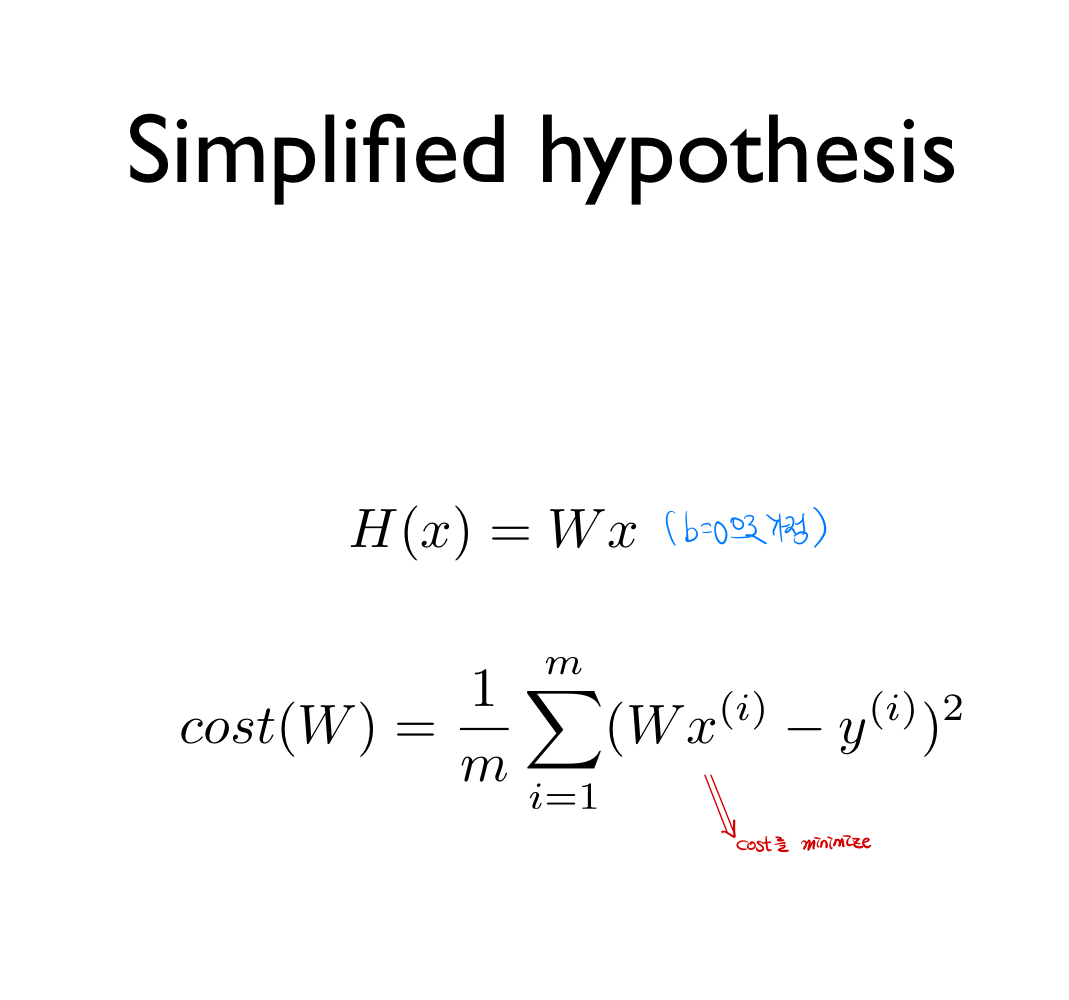

- b= 0으로 가정한, y=x라는 linear Regression을 추정하는 예시)

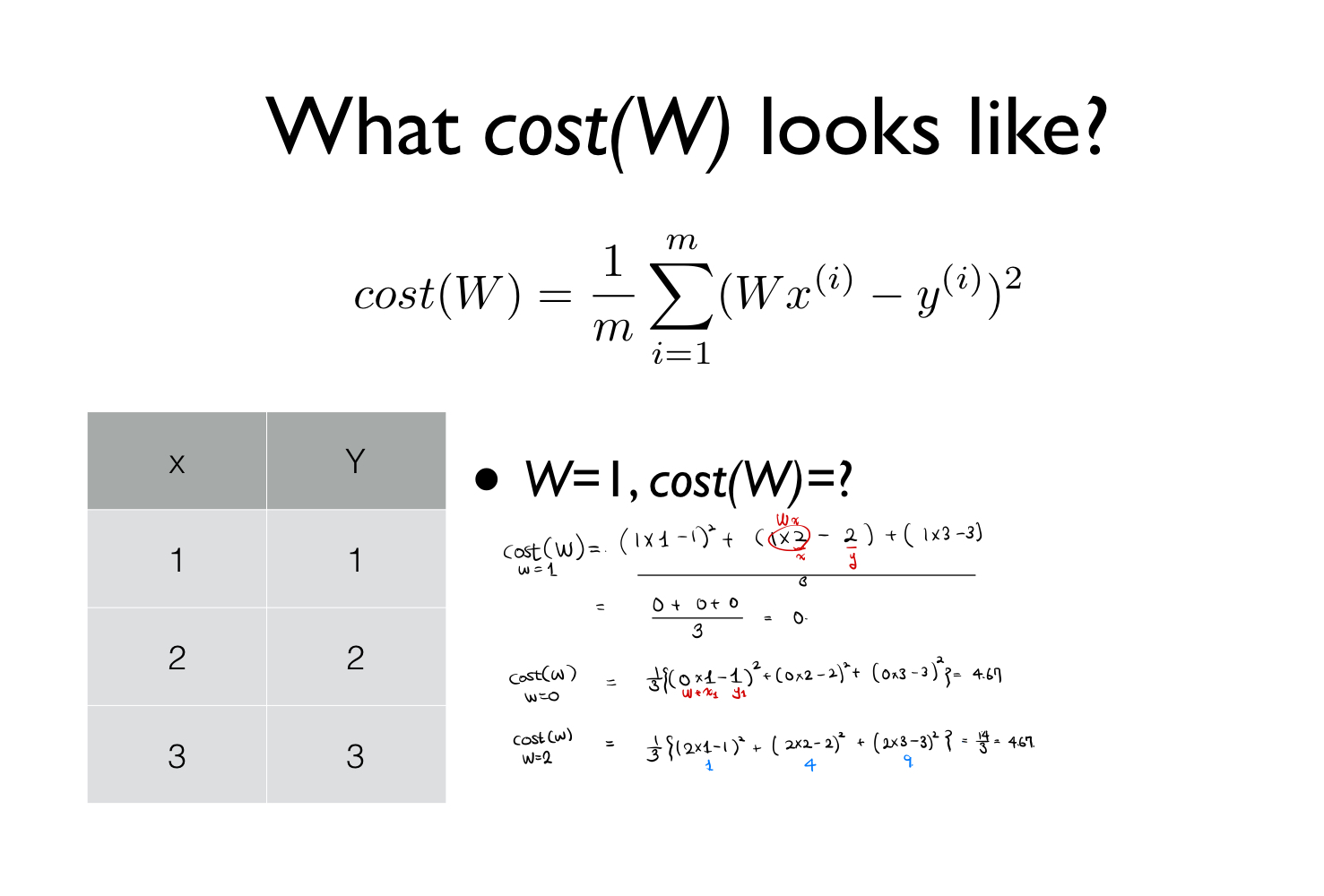

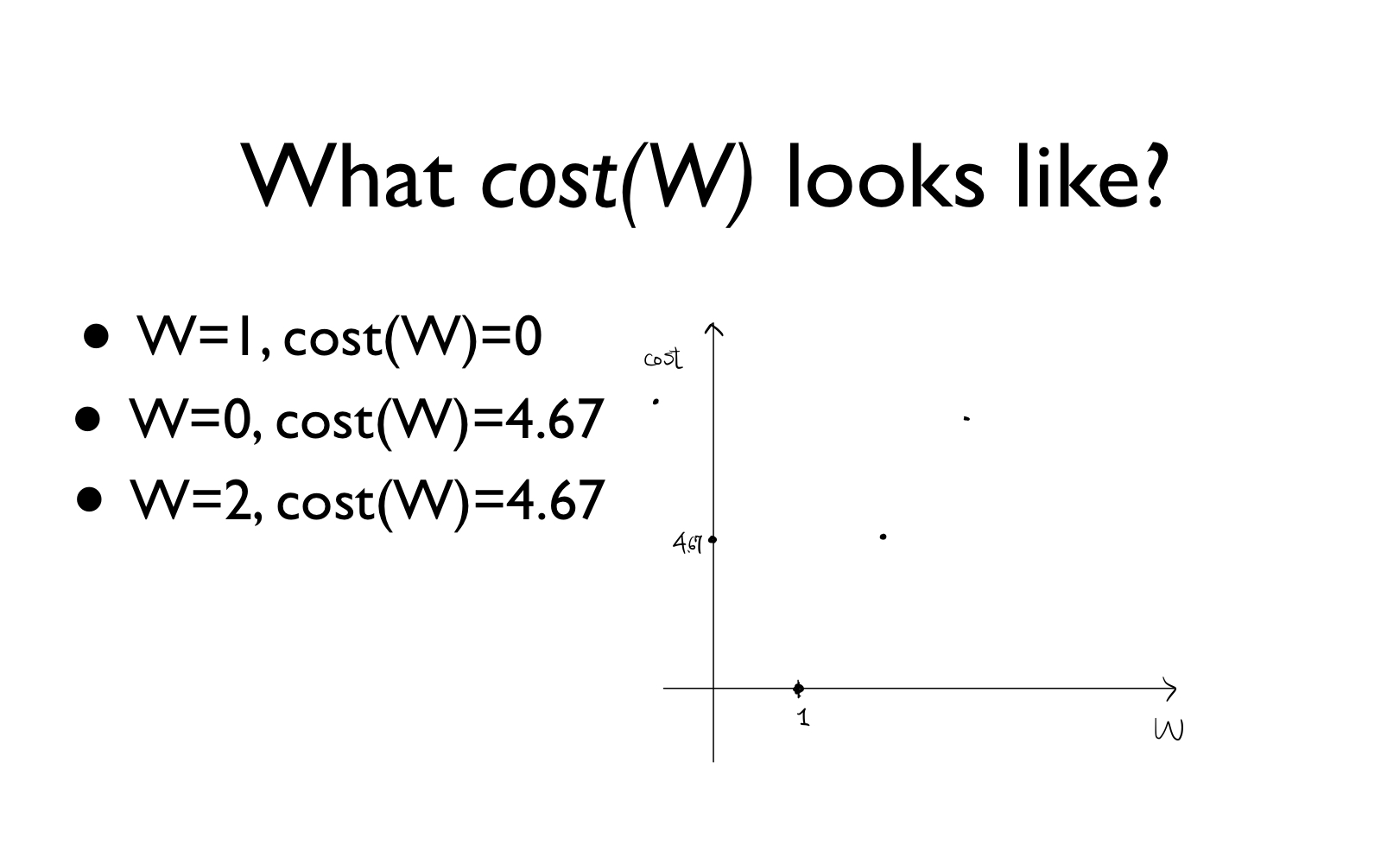

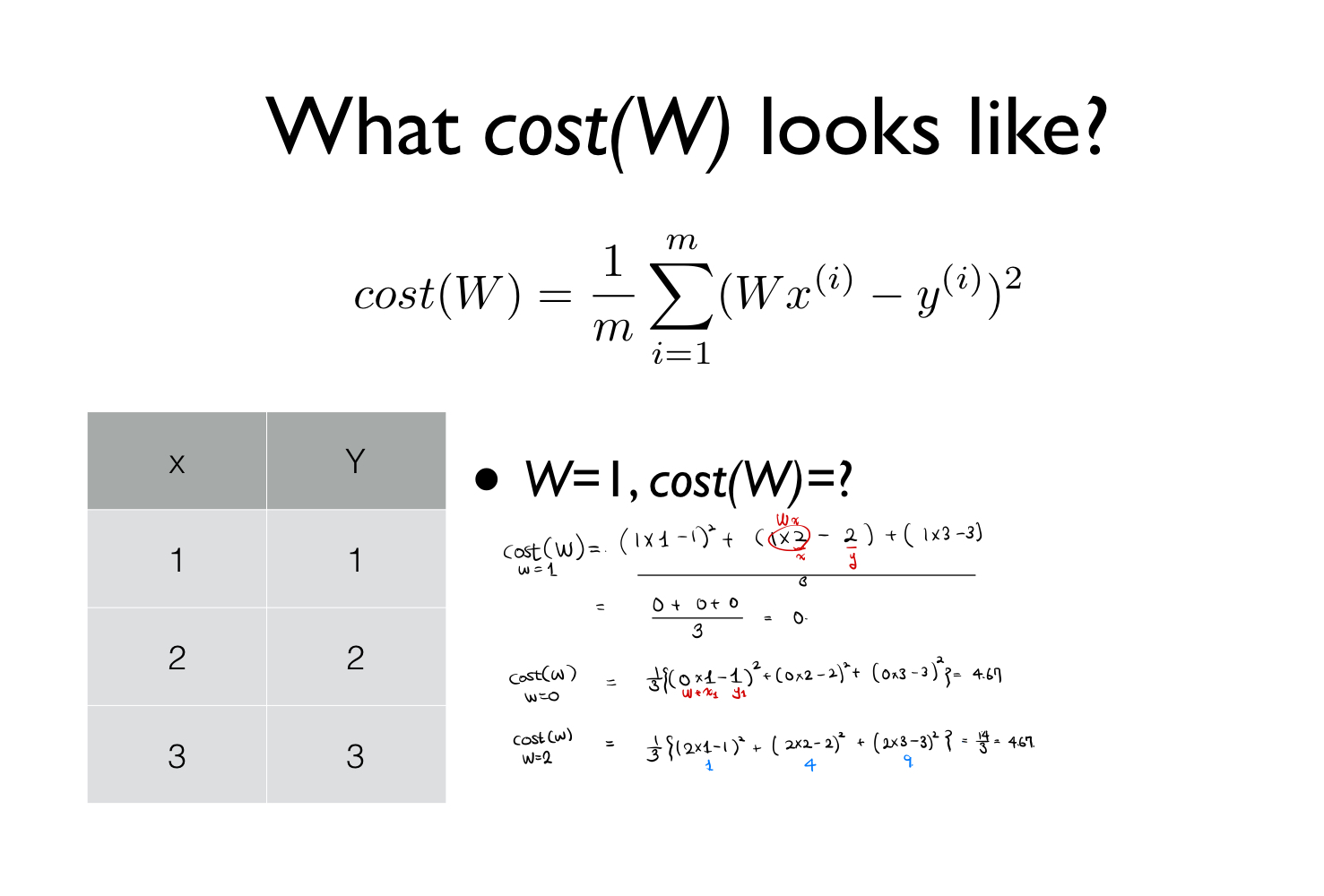

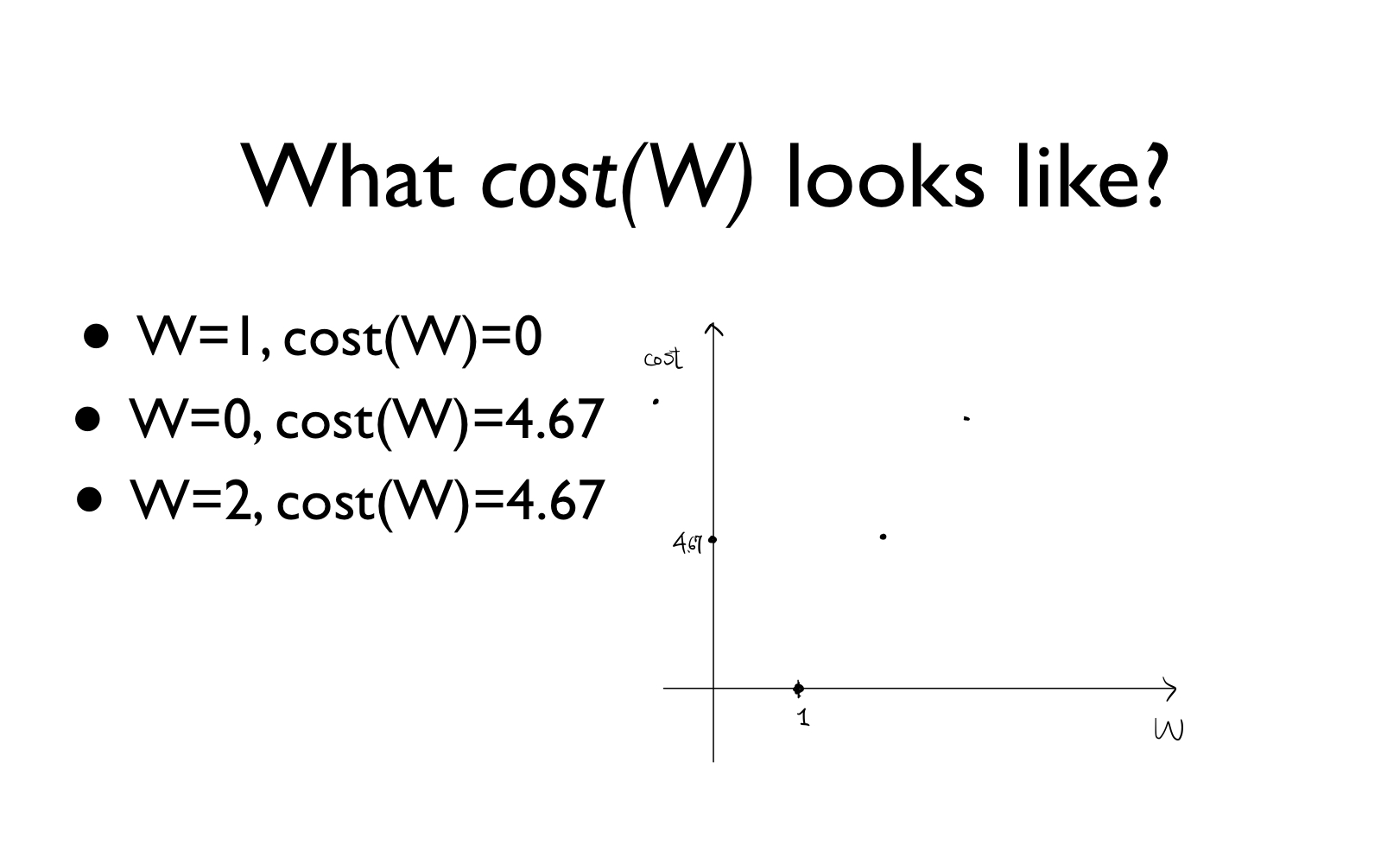

- 다음과 같은 테이블의 변수가 주어졌을 때, 손실함수의 정의를 이용해서 w=0,1,2일때 cost값을 구해줌.

- cost(w=0): 4.67

cost(w=1): 0

cost(w=2): 4.67

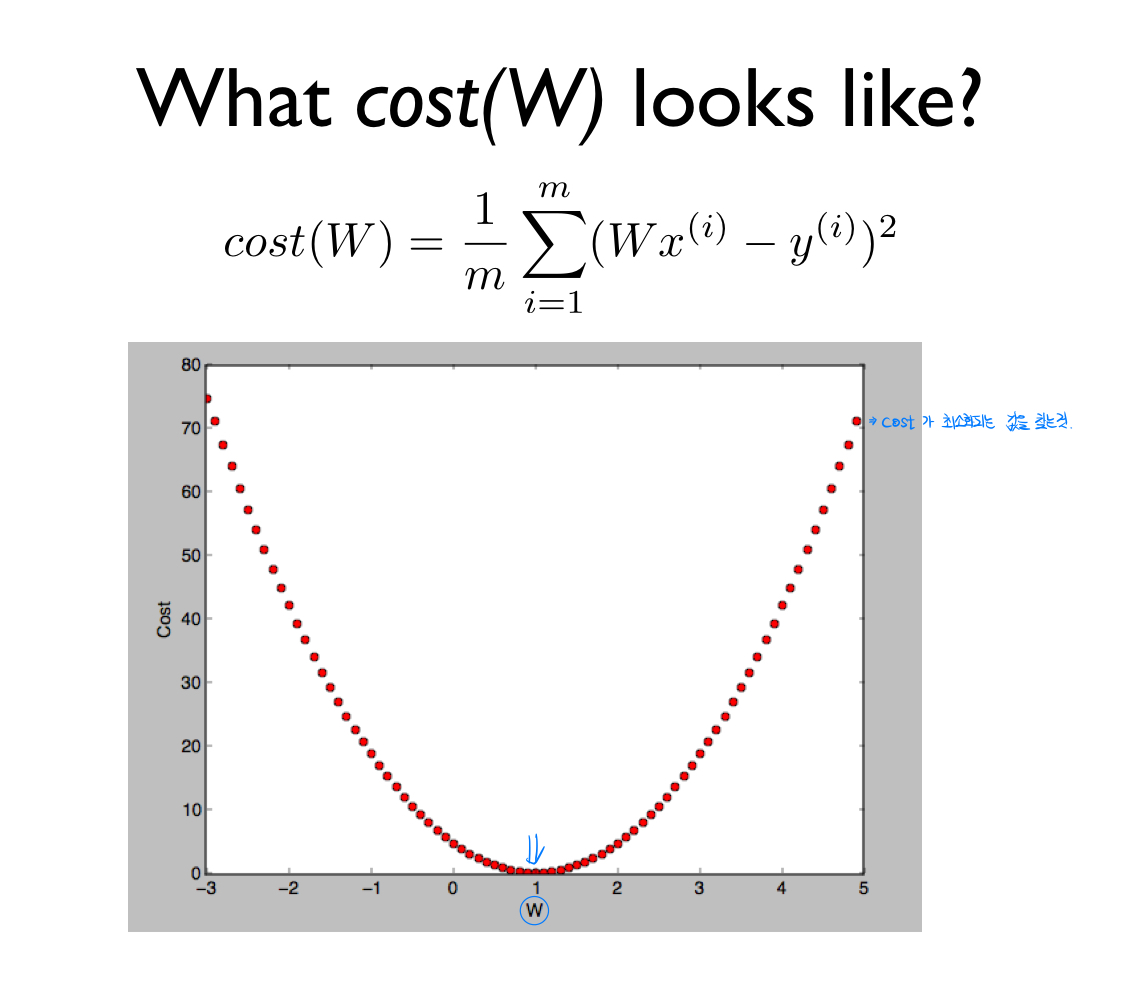

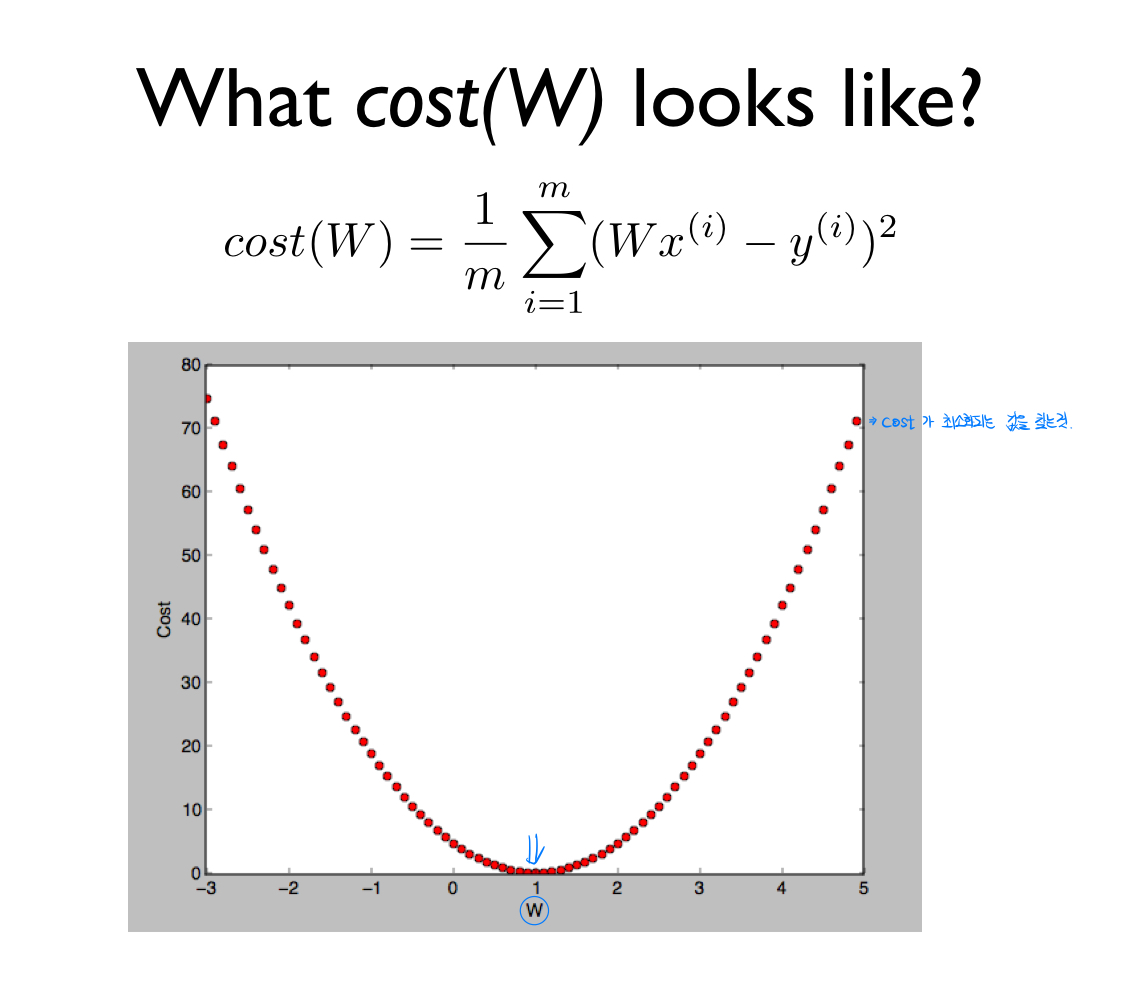

이 값을 w를 x축으로 cost(w)를 y축으로 하는 그래프에 표현

- 이와 같이 2차 함수 그래프로 나타남!

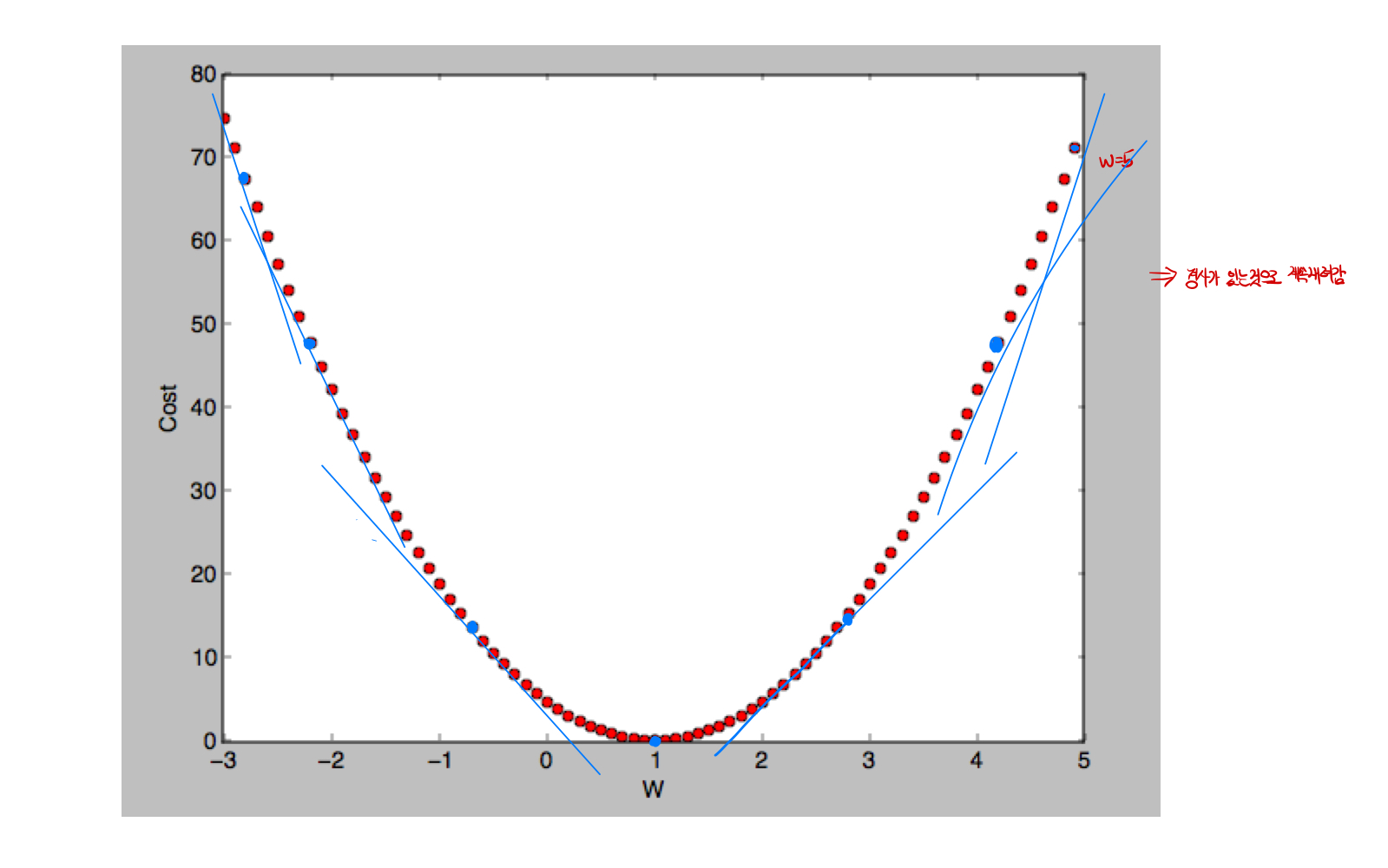

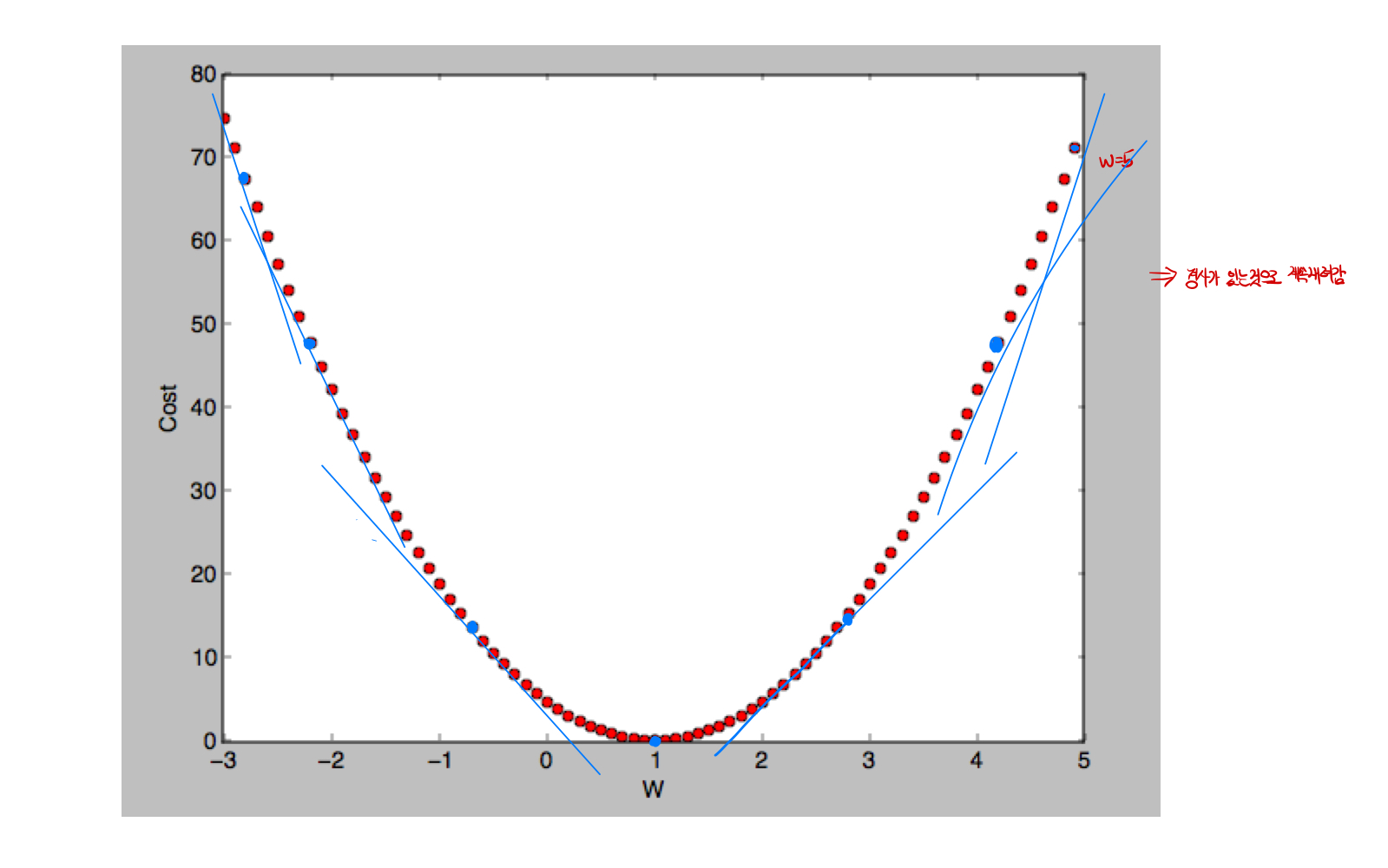

- 이 때 이 함수의 최솟값을 구해주는 방법을 Gradient descent Algorithm(경사하강법) 이라고 부름. 말 그대로 경사가 있는 쪽으로 내려가는 방식으로, 함숫 값의 미분을 통해서 경사를 찾고, learning rate와 미분 값의 곱만큼 내려가는 방식으로 찾아감.

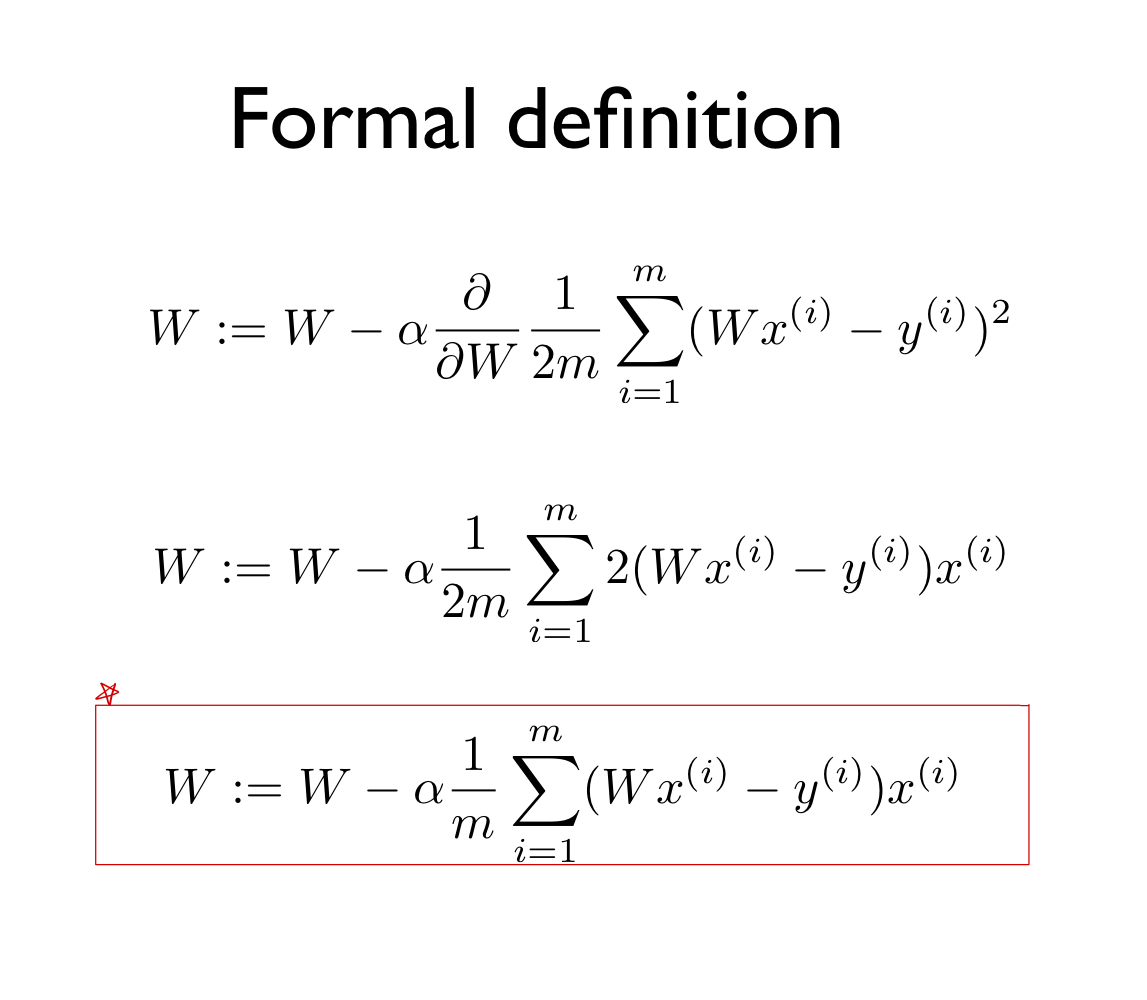

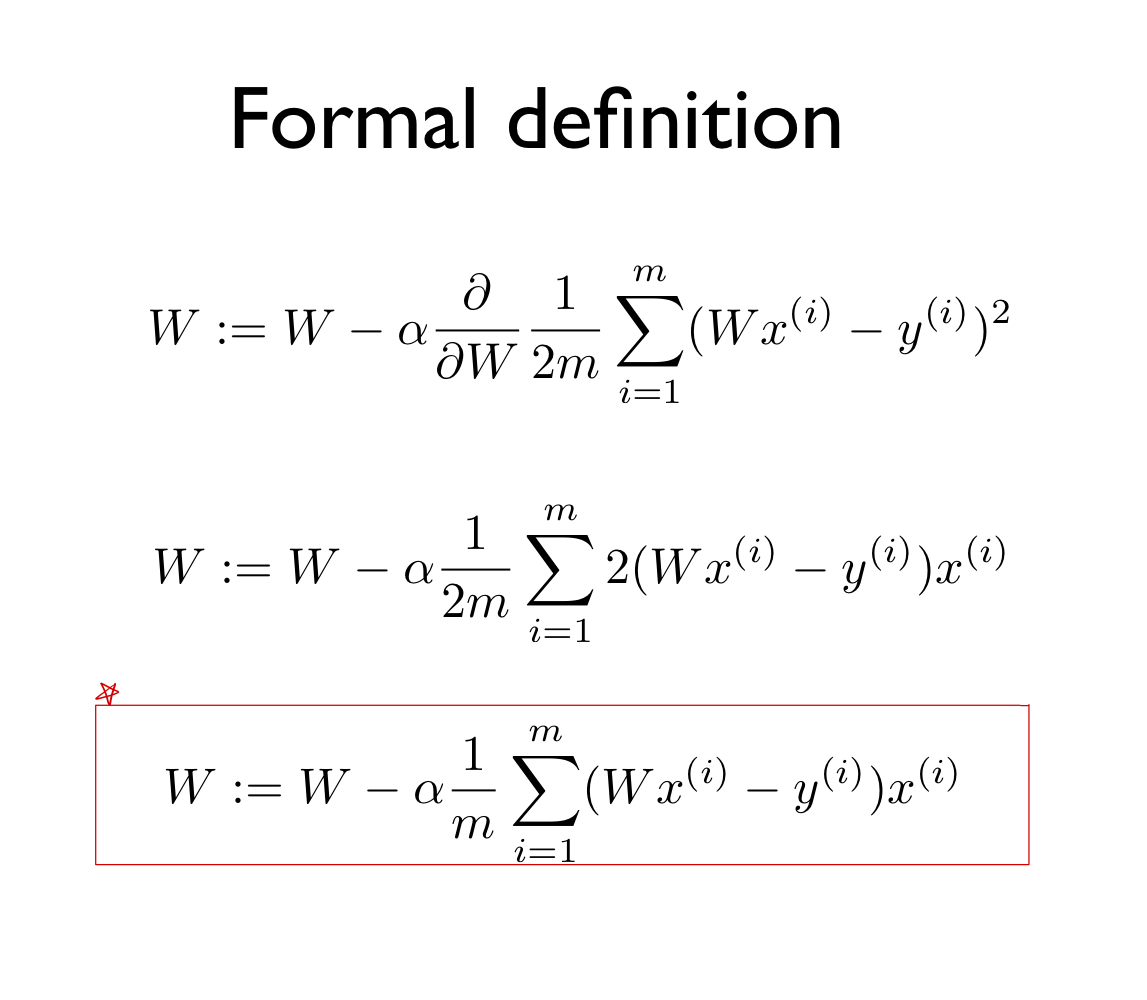

- 미분식을 통해서 아래와 같이 표현해줄 수 있음.

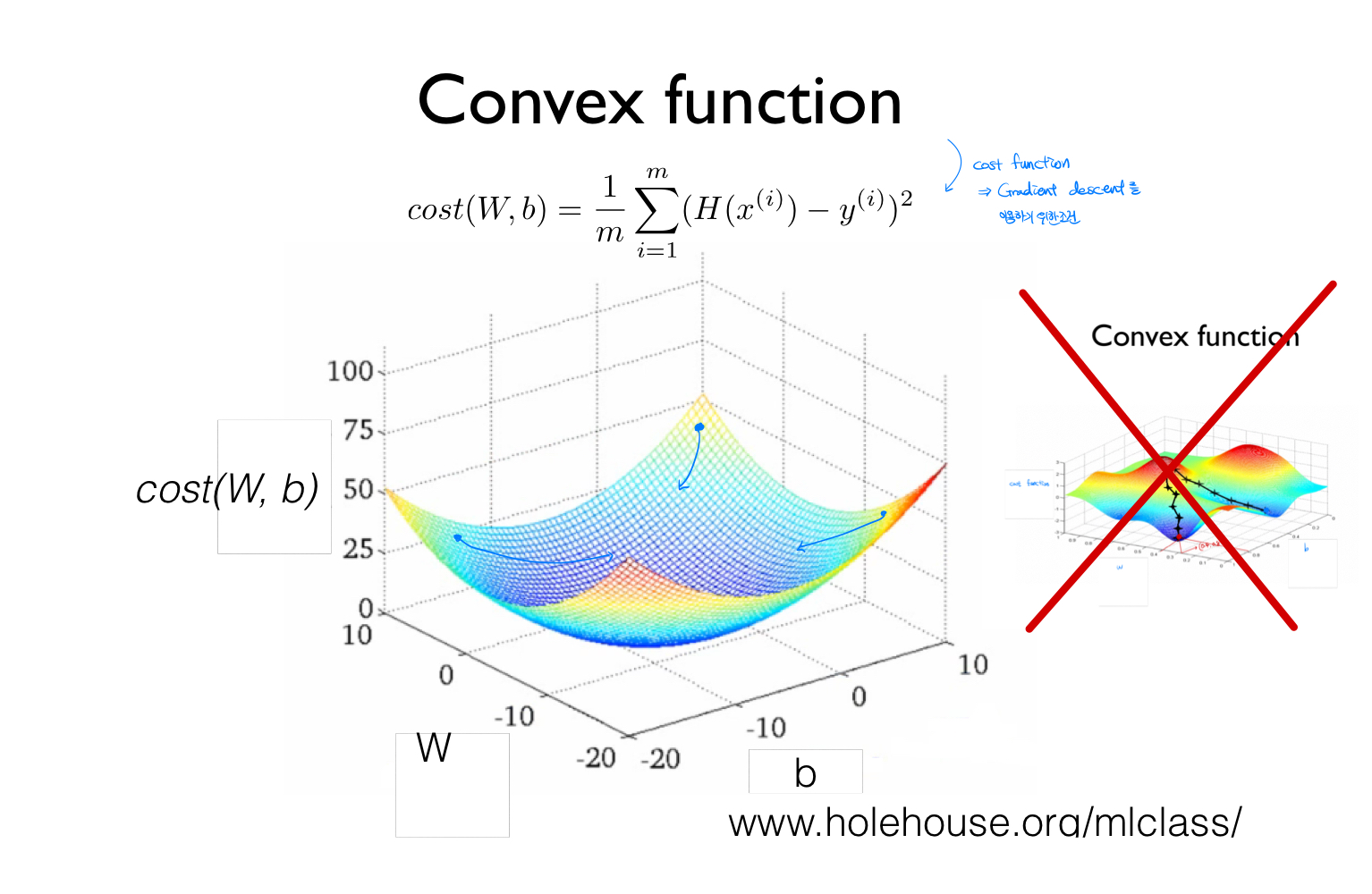

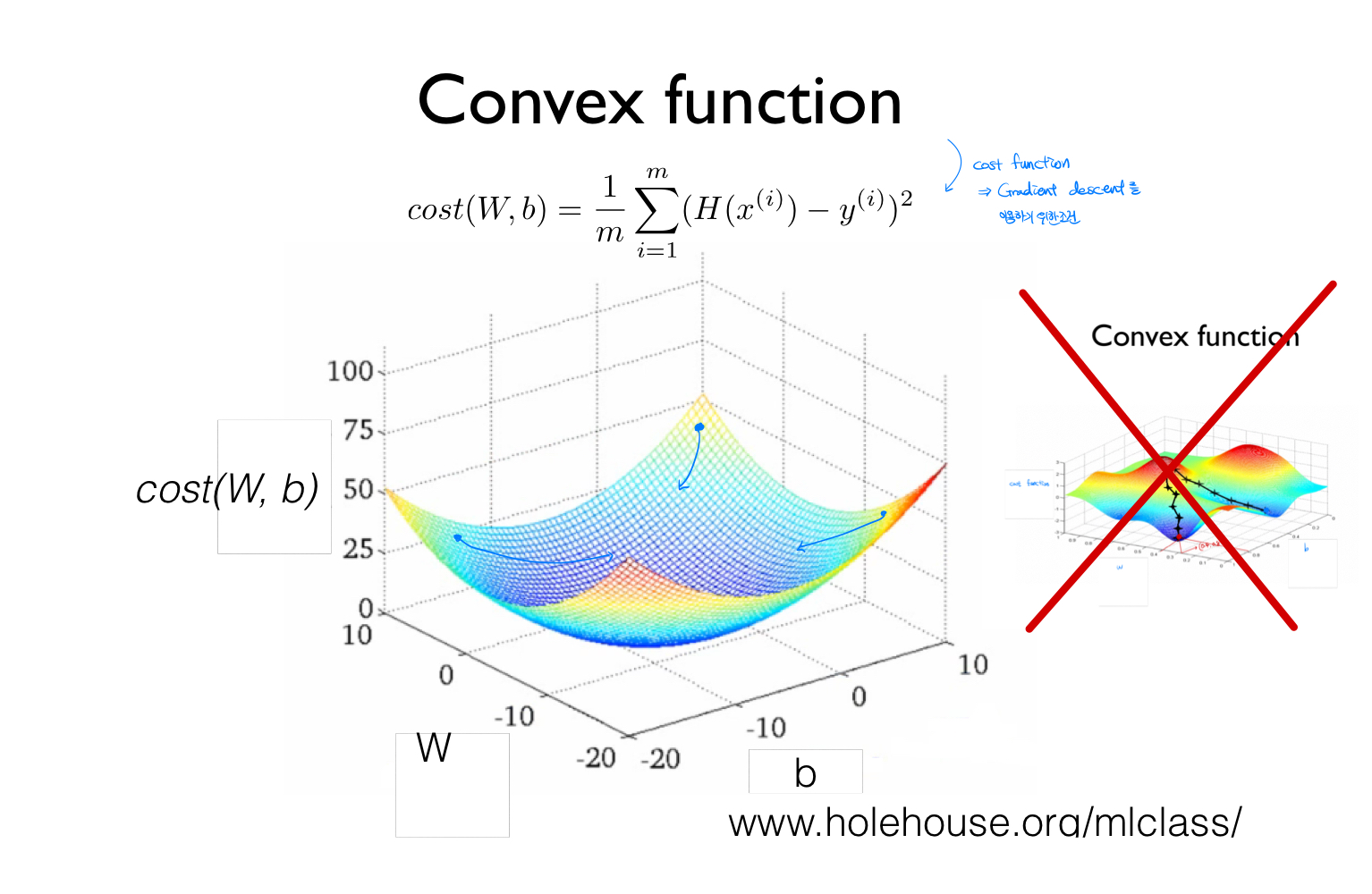

- 경사하강법은 아래와 같이 3차원 평면으로 나타냈을 때, 오목한 그릇의 형태이면 찾기 쉬우나, 아래의 오른쪽그림같은 경우 가장 작은 값을 찾을 수 없을 가능성이 크다. 이 때에는 global minimum이 아닌 local minimum을 구하게 된다.