Generation for NLP

1.Encoder / Decoder Model

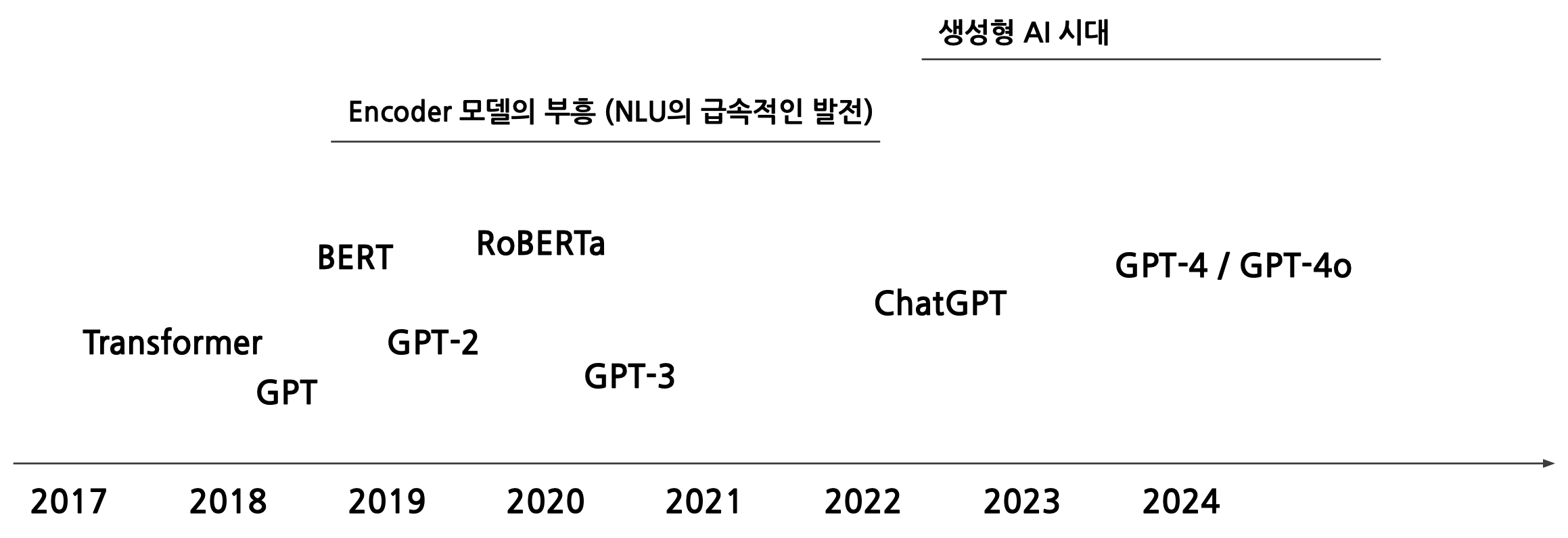

Transformer의 등장에서, 학습된 모델들은 기본적으로 완전히 weight, parameter가 random initialized부터 학습을 시작.Transformer의 등장까지만 해도, Encoder-Decoder이라는 구조에 대한 변화만 있었을 뿐, 모델 성능

2024년 11월 11일

2.Decoder Model: 코드레벨로 파헤치기

Decoder-only Model Review Decoder-only 모델의 대표적인 예시로 GPT가 있다. GPT은 다음 토큰을 예측하는 모델인데, 이것이 생성 task와 완전히 동일하기 때문에 이 강점들이 generative AI의 목적에 부합한다. Decoder-

2024년 11월 18일

3.Airflow를 활용한 Batch Serving

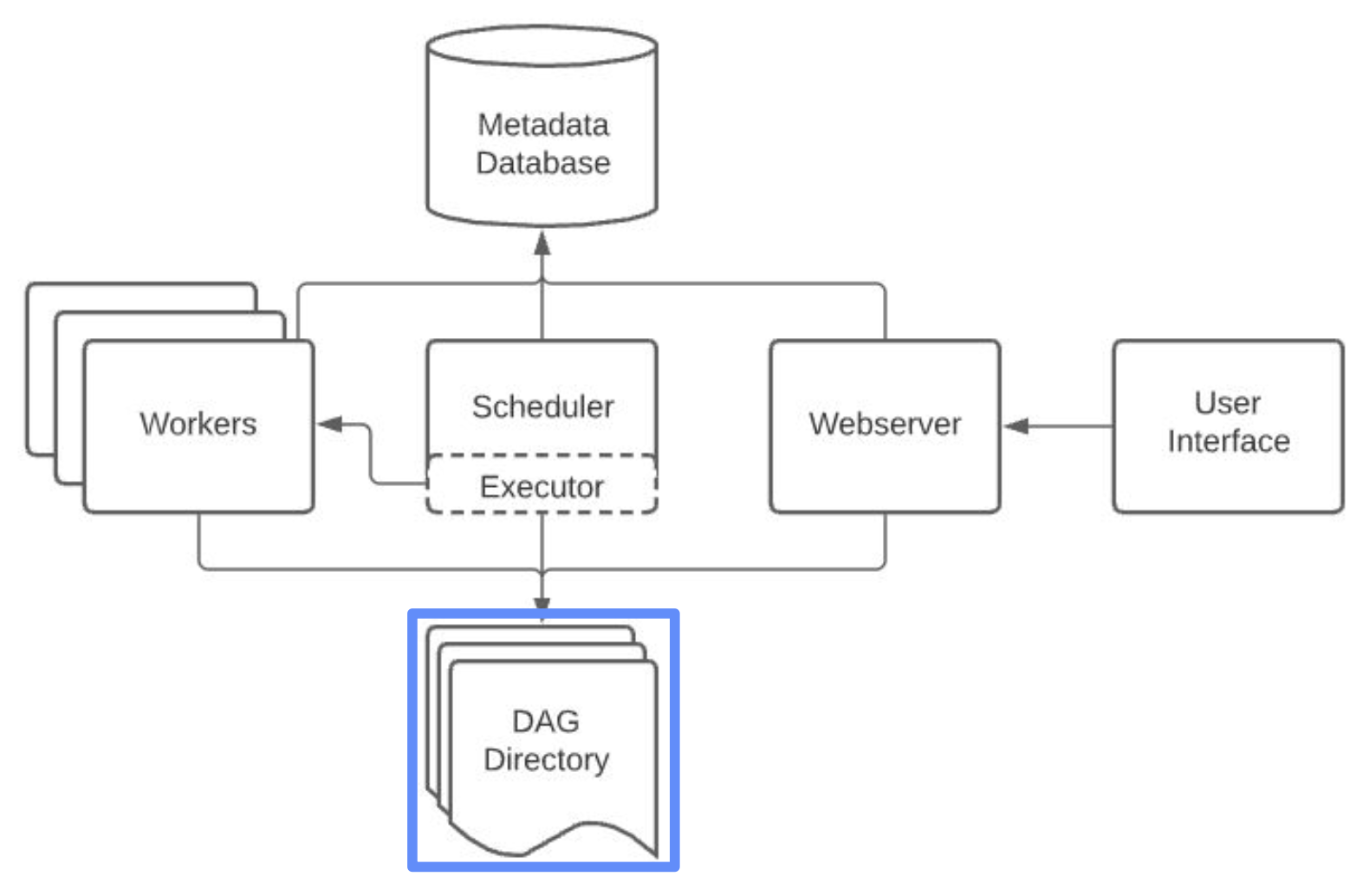

Batch Processing이 조금 더 큰 개념이며, Batch으로 진행하는 작업에 Airflow을 사용할 수 있다.Batch Serving은 대량의 데이터를 효율적으로 처리할 수 있으며, 주로 다음과 같은 상황에서 활용됩니다:모델의 주기적인 학습 (e.g., 1주일

2024년 12월 19일