layer와 layer 사이에 activation function을 넣어주지 않으면, MLP가 아니라 하나의 layer가 된다. 따라서 activation function을 layer에 추가한다.

이때, ReLU인 max(0, Wx)를 acitvation function으로 사용할 수 있다. Wx가 0보다 작으면 0을 return하고, 0보다 크면 input을 그대로 출력하는 것이다. Wx가 음수가 될 수 있는 이유는 weight가 평균적으로 0에 되도록 샘플링 하기 때문이다.

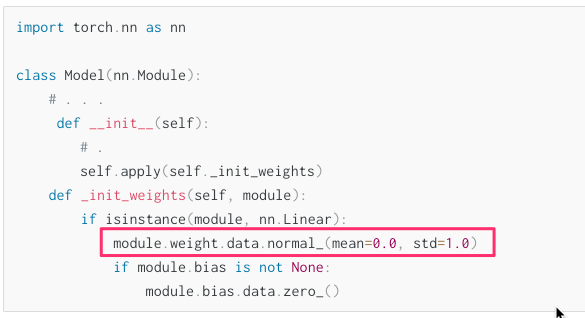

module.weight.data.normal_(mean=0.0, std=1.0)