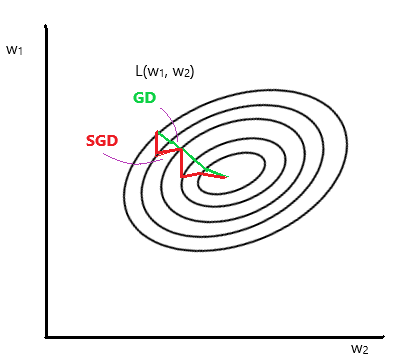

Stochastic Gradient Descent는 각 반복에 대한 전체 데이터셋 대신 무작위로 임의의 샘플(mini-batch)를 선택한다. 실제 SGD 구현시, 매번 임의로 샘플을 뽑는 것이 비효율적이기 때문에 매 epoch마다 데이서셋을 섞는 shuffling 과정을 거친 후, 여러개의 mini-batch 묶음으로 나눠서 mini-batch 단위로 model을 학습시킨다.

전체 dataset에 대한 loss function을 구하는 Batch Gradient Descent에 비하여 Local Minima에 빠지는 것을 막고, global minima로 converge 할 가능성을 높힌다.