- 분류: Language Model

- 저자: IIya Sutskever, Oriol Vinyals, Quoc V.Le

- 소속: Google

- paper: Sequence to Sequence Learning with Neural Networks

- 키워드: Seq2Seq, Reversed Input Sequence, Machine Translation

Attention 기반 모델(특히, Transformer)의 초석이 된 연구

1. 연구 배경

기존의 심층 신경망

- 고정된 크기의 입력/출력 -> 우수한 성능

- 가변 크기의 입력/출력(시퀀스 간 변환 문제) -> 성능의 한계

-> Long Short-Term Memory(LSTM) 기반 모델 활용을 통한 NLP 영역 시퀀스 변환 문제 해결

2. 핵심 아이디어 및 방법론

1) 제안 구성

- 인코더(Encoder): LSTM을 사용하여 입력 시퀀스를 읽고, 고정 크기의 벡터로 변환

- 디코더(Decoder): 변환된 벡터 기반, 다시 LSTM을 사용하여 출력 시퀀스 생성

- 입력 시퀀스 반전 -> 최적화 문제를 더 쉽게 만들어 긴 문장에서도 우수한 성능을 보임

-> 기계 번역(Machine Translation) 등의 시퀀스 변환 문제에 효과적으로 적용, 입력 시퀀스의 의미를 내포하는 벡터 표현 학습

3. 실험 및 핵심 작업

1) 데이터 셋

- WMT’14 영어-프랑스어 기계 번역 데이터셋

(약 1200만 문장, 영어 3억 4000만 단어, 프랑스어 3억 4800만 단어) - 사전 크기: 영어 16만 개, 프랑스어 8만 개로 제한(사전에 없는 단어는 UNK(Unknown Token) 처리)

2) 학습 방법

- 4개의 LSTM layer: 각 게층은 1000개 유닛 포함

- 최적화

- 확률적 경사 하강법(SGD) 적용

- learning rate: 0.7 시작, 5 epoch 이후 매 절반 epoch마다 감소

- 배치 정렬(batch sorting): 문장 길이 고려, 연산 속도 2배 향상

- 모델 병렬화(model parallelization): 8개의 GPU 활용, 최적화된 학습 속도 확보

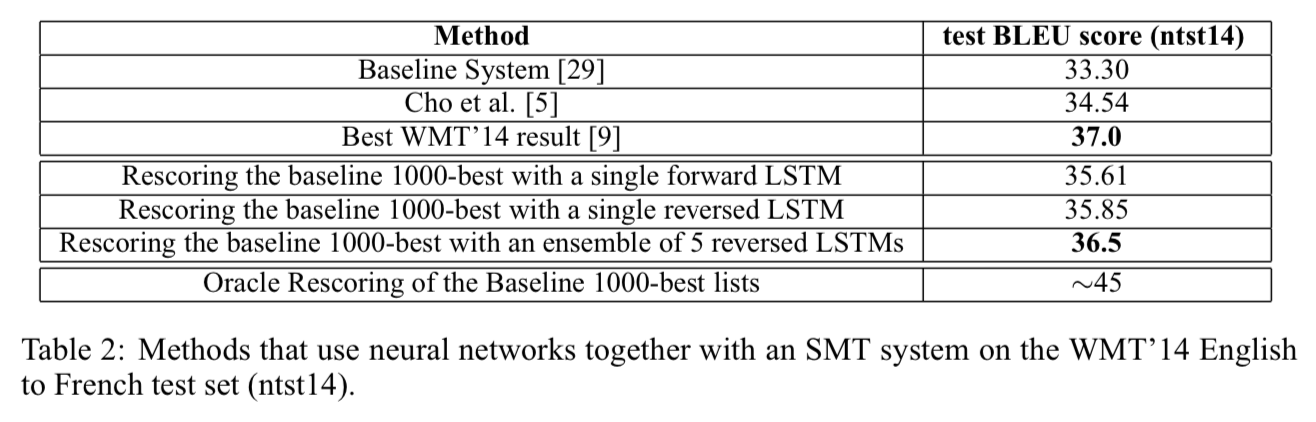

3) 디코딩 및 순위 재조정(Rescoring)

- 빔 서치(Beam Search): 다양한 후보 문장 생성, 가장 확률 높은 문장 선택

- 기존의 통계적 기계 번역(SMT) 시스템의 1000-Best 리스트를 LSTM로 재평가 -> 성능 개선

4) 입력 시퀀스 반전(Reversing the Source Sentences)

- 입력 문장의 단어 순서를 반전시키는 기법 -> 성능 향상

- 단기 의존성(short-term dependencies) 증가 -> 최적화 문제 쉽게 해결

4. 결과 및 분석

1) 기계 번역 성능 평가(BLEU score)

2) 긴 문장에서의 성능 유지

기존 연구에서는 LSTM이 긴 문장에서 성능이 떨어진다고 했으나, 본 연구에서는 입력 시퀀스 버전 기법을 적용함으로써 긴 문장에서도 우수한 번역 성능을 보임

3) LSTM 문장 표현 학습

- 단어 순서에 민감

- 비교적 불변한 의미 표현(능동태/수동태 변환 등) 학습 가능

5. 결론 및 향후 연구 방향

1) 의미

- 시퀀스 간 변환 문제에서 LSTM 기반 end-to-end 학습 가능성 입증

- SMT와 비교하여 딥러닝 기반 번역 모델이 경쟁력 있는 성능을 보임을 확인

- 입력 시퀀스 반전 기법으로 긴 문장에서의 성능 저하 문제 해결

2) 한계점 및 향후 연구 방향

- 어휘 제한 문제: LSTM의 어휘 크기가 제한되어 있어 UNK 처리 방식이 BLEU 점수에 영향을 미침

-> 서브워드 토큰화와 같은 방법을 활용하면 어휘 커버리지 개선 가능 - 대규모 병렬화 및 최적화 가능성

-> 더 나은 구조 탐색 가능