[핵심][24.ICLR] RETHINKING CHANNEL DIMENSIONS TO ISOLATE OUTLIERS FOR LOW-BIT WEIGHT QUANTIZATION OF LARGE LANGUAGE MODELS

Quantization[논문핵심]

목록 보기

10/11

-

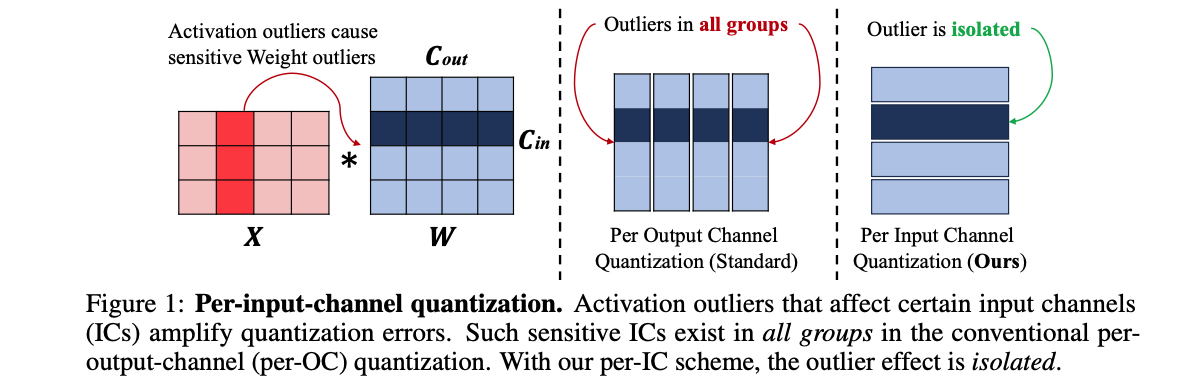

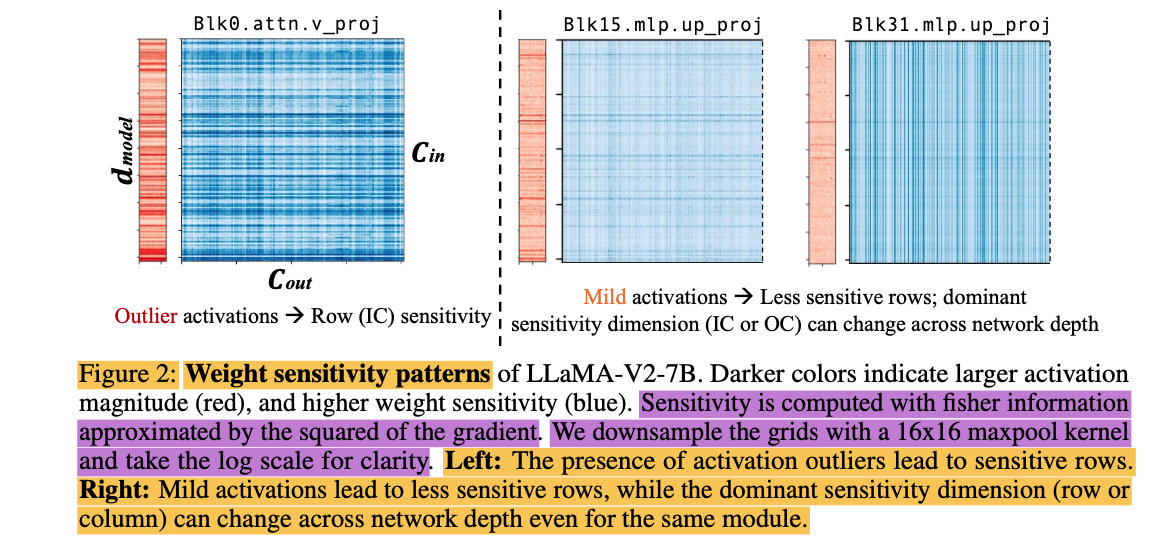

"activation outlier들을 다루는 방법으로, 기존의 output-channel(OC) 방향 대신, input-channel(IC) 방향으로 weight를 grouping해서, outlier들을 효과적으로 isolation 할 수 있다."

-

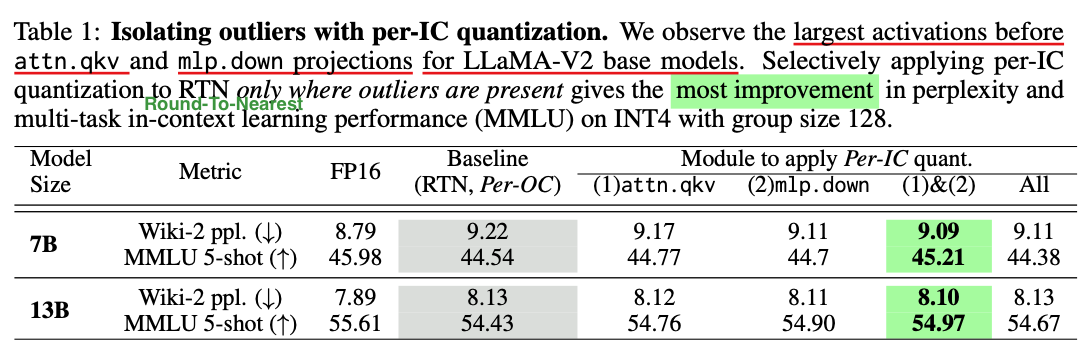

"최종적으로, 각 layer에서 per-IC를 쓸지 또는 per-OC Quantization을 쓸지 결정하는, AdaDim(Adaptive Dimension) 방법 제안"

Motivation

-

observation

activation outliers affect the input dimension of the weight matrix,

so similarly grouping the weights in the IC direction can isolate outliers within a group. -

idea

기존의 output-channel 방향 대신, input-channel 방향으로 weight를 grouping해서, outlier들을 효과적으로 isolation 할 수 있다 -

kernel

이 방법은 weight-only quantization에서 feasible한데, per-OC grouping contraint를 갖는 specialized INT8 GEMM kernels에 의존하지 않기 때문이다.