🏃♀️ 선형 회귀란?

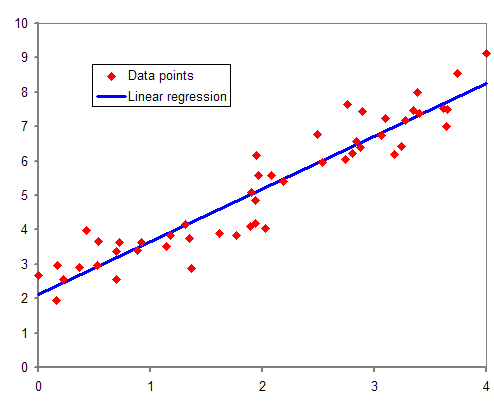

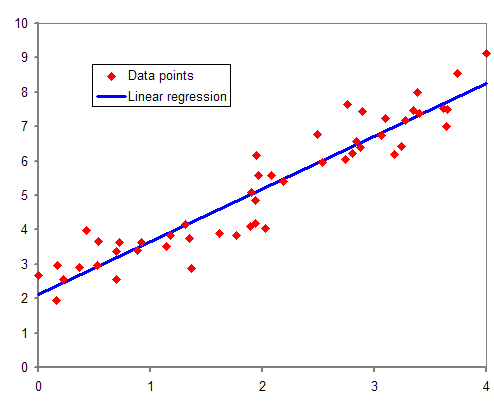

각 1개의 독립변수와 종속변수를 가진 데이터셋을 가정할 때, Data points의 중심을 통과하는 하나의 직선을 상상할 수 있다.

최적의 직선을 찾는 과정이 선형회귀이다.

📈 회귀선

잔차(residuals)들의 거리가 가장 작은 직선.

* (실제값) - (추정치)

잔차제곱합(RSS: Residual Sum of Square)을 최소로 하는 선

선형회귀모델

y^=βx+α

잔차제곱합

RSS=i=1∑n(Yi−Yi^)2=i=1∑n(Yi−(βXi+α))2

🌠 보통최소제곱(OLS: Ordinary Least Squares)

- 잔차제곱합을 최소로 만드는 β, α를 찾기 위한 대표적인 최소제곱법.

- 위 식을 β, α에 대해 편미분한 값이 0일 때 RSS가 최솟값이 된다는 미적분학 이론(페르마의 정리)에 의해, 연립방정식을 풀어 최적의 β, α 값을 찾을 수 있다.

β=∑i=1n(Xi−Xˉ)2∑i=1n(Yi−Yˉ)(Xi−Xi^)

α=Yˉ−bi^Xˉ

👩🏫 회귀 모형의 적합성 판정

- 잔차들이 정규분포를 따르는지 살펴보기

- t검정을 통해 회귀 계수들이 유의미한 값을 갖는지 살펴보기

- 결정계수 R2와 ESS(error sum of square)를 살펴보는 방법

📚 References

최소제곱법 | 네이버캐스트

Simple Linear Regression | Wikipedia