Boosting 아이디어

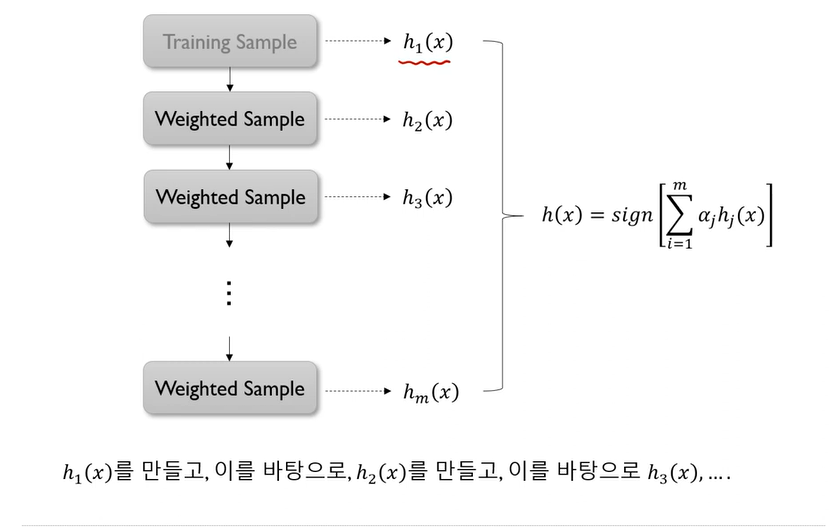

- 여러 개의 learning 모델을 순차적으로 구축하여 최종적으로 합침

- 여기서 사용하는 learning 모델은 매우 단순한 모델

- 단순한 모델: Model that slightly better than chance: 정확도가 0.5보다 조금 더 좋음 - 순차적 -> 모델 구축에 순서를 고려

- 각 단계에서 새로운 base learner를 학습하여 이전 단계의 base learner의 단점을 보완

- 각 단계를 거치면서 모델이 점차 강해짐 -> boosting

Boosting 알고리즘 종류

- Adaptive boosting(Adaboost)

- Gradinet boosting machines(GBM)

- XGboost

- Light gradient boost machines(Light GBM)

- Catboost

Adaptive Boosting(Adaboost)

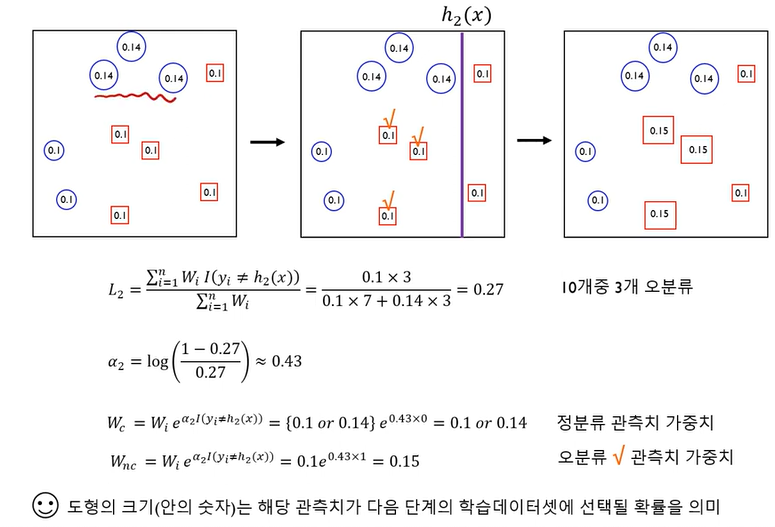

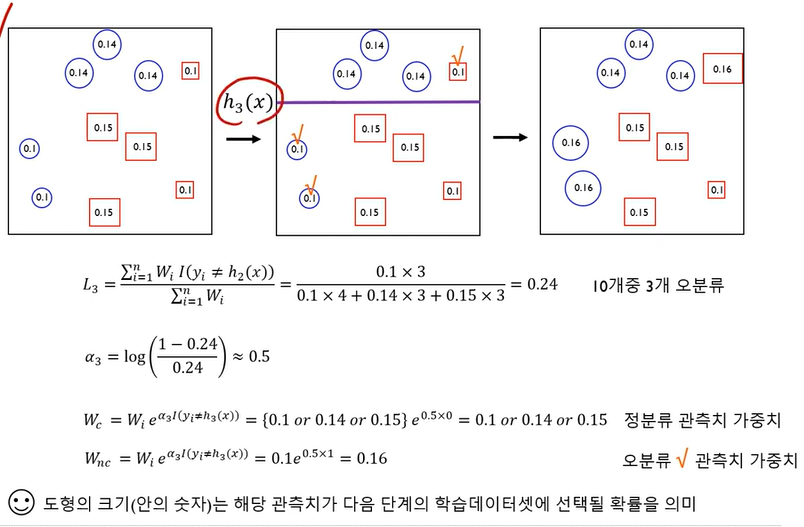

- 각 단계에서 새로운 base learner를 학습하여 이전 단계의 base learner의 단점을 보완

- Training error가 큰 관측치의 선택 확률(가중치)을 높이고, training error가 작은 관측치의 선택 확률을 낮춤

- 오분류한 관측치에 보다 집중

-앞 단계에서 조정된 확률(가중치)을 기반으로 다음 단계에서 사용될 training dataset를 구성 - 다시 첫 단계로 감

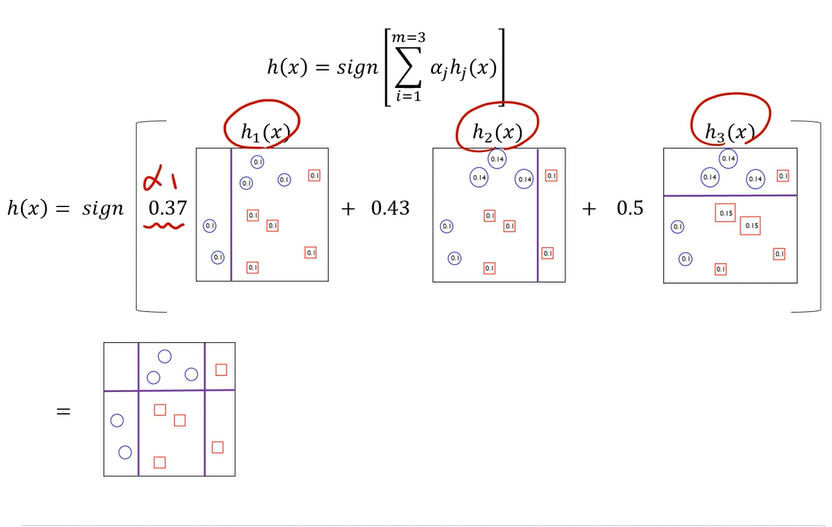

- 최종 결과물은 각 모델의 성능 지표를 가중치로 하여 결합(앙상블)

-

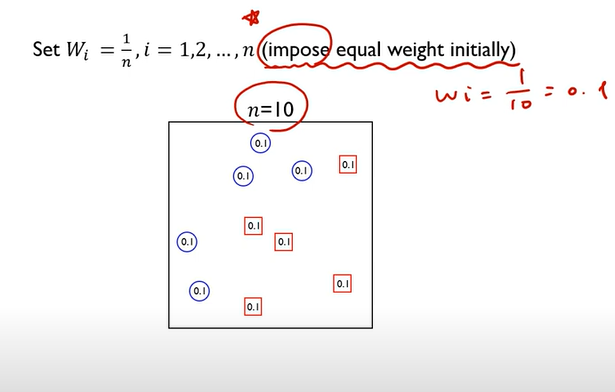

impose equal weight initially

초기 가중치를 모두 똑같이 0.1로 부여

-

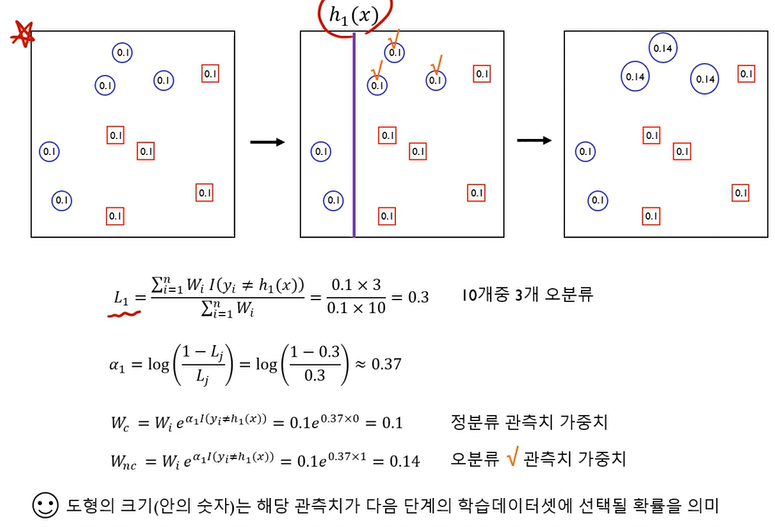

weighted loss function을 최소화하는 base model 찾기

- 보라색 선이 첫번째 decision tree의 결과

- 3개의 동그라미가 네모로 분류됨: 오분류

- 오분류 된것의 가중치를 높임

-

가중합을 취해서 새로운 모델 완성

- 정리

순차적으로 모델 구축

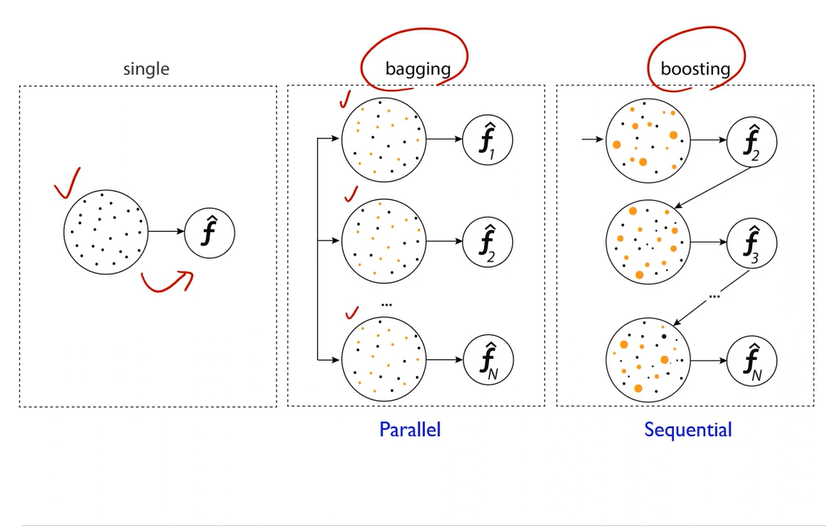

Bagging vs Boosting

Bagging 하나의 training sample로부터 여러개의 sample을 만들고 그로부터 각각 모델을 만들어 가중합

Boosting 하나의 training sample로부터 모델을 만들고 거기서부터 나오는 어떤 정보로 traing sample의 가중치를 업데이트하고 새로운 모델 만들어서 각각의 모델을 가중합

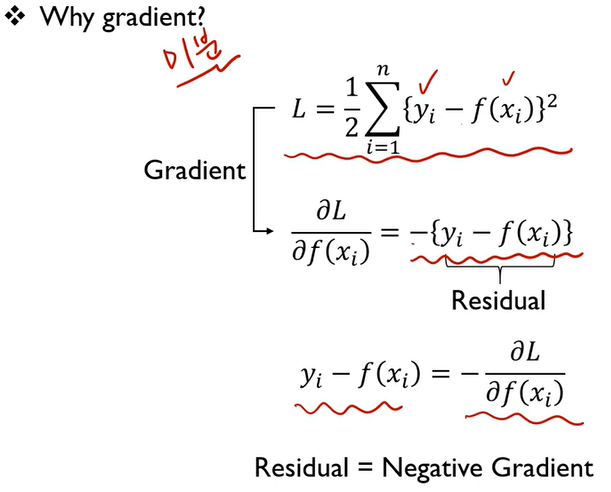

Gradient Boosting Machines(GBM)

- Boosting with gradient descent

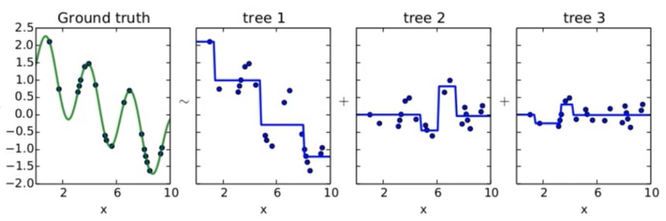

- 첫번째 단계의 모델 tree 1을 통해 Y를 예측하고, Residual을 다시 두번째 단계 모델 tree2를 통해 예측하고, 여기서 발생한 Residual을 모델 tree3로 예측

- residual: 실제 y와 예측값 y의 차이

- 점차 residual 작아짐

- Gradient boosted model = tree1 + tree2 + tree3

- Gradient에 마이너스 취하면 residual이 됨