1. LLM이란 무엇인가요?

대부분 transformer 구조에서 파생된 AI모델로, 인간의 언어와 코드등을 이해하고 생성하기 위해 설계되었습니다. 방대한 양의 텍스트 데이터 (Large Language)로 학습되어, 사람 언어의 복잡성과 뉘앙스를 캐치하고 여러 작업을 수행할 수 있습니다.

2. 토큰과 임베딩이란 무엇인가요?

-

토큰: LLM의 가장 작은 이해 단위입니다. 다양한 tokenizing 방법들을 통해 단어, 형태소, 특수문자, 혹은 bert의 [CLS] 같은 예약어등이 토큰이 될 수 있습니다.

-

임베딩: 기계가 이해할 수 있도록 수학적으로 표현된 고차원 공간에서의 단어, 구절, 또는 토큰입니다. 토큰의 의미를 인코딩하는 토큰 인코딩, 위치를 임베딩하는 위치 임베딩등이 있습니다.

추가+) 전통적인 NLP의 불용어 제거, 어간 추출 등의 전처리 방법은 LLM에서 오히려 성능 저하요인입니다. pretraining data 자체가 인간 언어의 본질적인 오타, 복잡성, 다양성등을 처리하기 때문에 이러한 토크나이징이 오히려 성능을 저하시킨다고 합니다.

2-1. 아시는 tokenizing이나 embedding 방법이 있나요?

- GPT와 요즘 많은 LLM은 BPE알고리즘을 차용한 BPE tokenizing을 기용한다고 합니다. 텍스트를 특정 크기의 바이트로 분할하고, 그 바이트들의 빈도를 계산하여 자주 등장하는 바이트 쌍을 하나의 바이트로 결합합니다. 이 과정을 여러 번 반복하여 단어 또는 서브워드의 집합을 생성합니다.

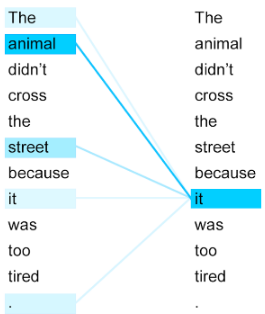

3. Attention에 대해서 설명해주세요.

입력시퀀스와 관련있는 다른 각 부분들의 중요성(attention score)을 동적으로 계산하는 매커니즘입니다. Transformer 아키텍쳐들의 핵심구성요소입니다.

어텐션 매커니즘 ⬅ 이 글 뿐만 아니라 seq2seq 모델부터 BERT까지 발전단계 따라서 쉽고 차근차근 설명해주시는 좋은 위키독스입니다! 시간나실때 꼭 읽어보시길 추천드립니다.

Self-attention에 대해서 설명해주세요.

입력 문장 내의 단어들끼리 attention score를 구해서, 단어끼리의 연관도나 단어의 중요도를 알 수 있습니다. Transformer의 encoder와 decoder의 첫번째 서브층에 multi-head attention이 들어갑니다.

4. RLHF에 대해서 설명해주세요.

사전훈련된 LLM을 인간 피드백을 강화학습을 통해 학습하여 성능을 향상시키는 방법입니다. 강화학습 특성 상 전통적인 지도학습의 일부 한계를 극복합니다. 요즘은 사람의 피드백이 아닌 AI 피드백을 하는 등 다양한 접근법들이 등장하고 있습니다.

5. Transfer learning과 Fine-tuning의 차이에 대해 설명해주세요.

-

Transfer Learning: 특정 분야에서 학습된 신경망의 일부 능력을 비슷하거나 새로운 분야에서 사용되는 신경망의 학습에 이용. 학습된 모델의 전체, 또는 일부 레이어만 남기고 freeze시킨 뒤, 새로운 레이어를 쌓아 새로운 태스크(데이터셋)에 학습시키는 것.ex) 100가지 동물 분류 모델에 없던 새로운 카피바라, 웜벳 라벨을 훈련시킴

-

Fine tuning: 작업에 특화된 상대적으로 작은 크기의 데이터셋에서 기존 모든 레이어를 매우 작은 lr로 훈련시켜 특정 작업을 위한 파라미터를 조정하는 것. ex) 금융 도메인 특화 챗봇, 과학 도메인 특화 등

여러 글을 읽어보니 ML전반에서는 fine-tuning을 transfer learning의 하위집합으로 생각하는 반면, LLM쪽에서는 둘을 완전 구분하여 쓰는 것 같습니다. (이 답변부분은 저도 정확하지 않으니, 참고만 하시길 바랍니다!)

transfer learning과 fine-tuning ⬅ 꼭 읽어보시길 추천드립니다!

Transfer learning과 Fine tuning의 차이점