기술면접

1.토스 계열사 면접 - ML Engineer

중요한 질문들이 몇 가지 있었는데, 잘 전달할 수 있었을 내용이었지만 충분히 제대로 전달을 못했다.앞으로 면접에서 이야기할 주제들에 대해서 조금 더 짜임새 있게 이야기를 완성시키고 몇 번 연습해 보아야겠다. 모델을 만들고 난 후 더 개선이 이루어졌다는 것을 PM에게 어

2.데브시스터즈 탈락 후기

데비시스터즈 라이브 코딩 테스트에서 탈락했다. 쉽다고 생각한 문제였지만 코드의 완성도 그리고 요구조건의 구현역 모두 부족했던 모양이다. 코드가 부족해서 탈락했다는 뜻에 마음이 쓰인다. 어떤 것 하나도 탁월하게 되지 못한 상황에서 가장 자신있다고 생각하는 코드가 부족하다

3.면접 후기- 중고거래플랫폼

1:1 화상 면접 진행. 경험 소개 추천 서비스에 대한 간략한 설명. 어떤 툴을 사용해서 서빙하였는지, 어떤 툴을 이용해서 학습하였는지. Sagemaker Inference를 이용했음. Sagemaker Train을 사용하였으며 알고리즘을 Docker 이미지에 올려서

4.면접 후기 - 2

추천 모델을 만들 때 implicit data를 활용하는 것을 보완하기 위한 연구 논문을 찾아 본 적이 있는가?알고리즘을 직접 구현해서 사용해본 적이 있는가?

5.서류 전형 후기

이번주에는 여러 곳에서 불합격 통보가 왔다.면접을 봤던 중고거래 플랫폼은 진행한 직후 예감이 좋지 않았고,서류만 보냈던 글로벌 e커머스 C사, 국내 기업으로 A/B테스트 플랫폼을 제공하는 H사, 국내 통신사 S사 로부터는 모두 서류 단계에서 탈락했다.H사의 경우에는 3

6.좋은 면접 경험이란.

질문의 목록을 정해놓고 물어보거나 의문을 제기하는 방식으로 진행되는 면접은 좋지 않은 면접니다. 왜냐면 면접을 받는 입장에서 정해놓은 질문에 대해 답변이 잘 떠오르지 않거나 자신이 이야기 한 내용에 공격을 받는다고 심리적으로 받아들여서 위축될 수도 있기 때문이다.좋은

7.면접 준비할 내용.

gradient based algorithm 에 대해서 좀 알아보자.back-proparation through time (BPTT) 가 뭐지?real-time recurrent learning algorihtm (RTRL) 이뭐지?cost function 과 loss

8.면접 회고 - 토스

토스 면접 (8월 15일)퇴사하고 처음으로 면접을 본 경험이었다. 나는 A사의 ML팀의 위치나 실력에 대해서 사전에 명확히 알 수 없었기 때문에 면접을 보면 무난히 이야기가 될 것 같다는 생각을 했다. 그래서 면접에 대한 준비를 따로 하지 않았다.리드를 포함하여 세 사

9.말로 설명하는 베이지안 기초

베이지안은 통계학이다. 통계학이라는 점에 변함은 없지만 베이지안 통계학은 믿음에 대한 사고체계라는 점을 절대 잊어서는 안된다. 전통적 통계학은 진실이 존재한다는 가정하에 진실을 이야기하겠다는 것이고, 베이지안 통계학은 진실을 알 수 없으므로 내가 진실에 대한 가설을

10.경력직 머신러닝 엔지니어 전형 리뷰

우선 나는 개발자 경험이 없는 현재 머신러닝 엔지니어로써 대학원 수준의 통계학을 전공한 5년차 엔지니어임을 미리 알고 이 글을 참조하면 좋겠다. 직무 타이틀이 크게 의미 없다고 생각하지만, 그 전에 3년 이상은 데이터 사이언티스트 직무를 달고 있었다. 내 경험상 크게

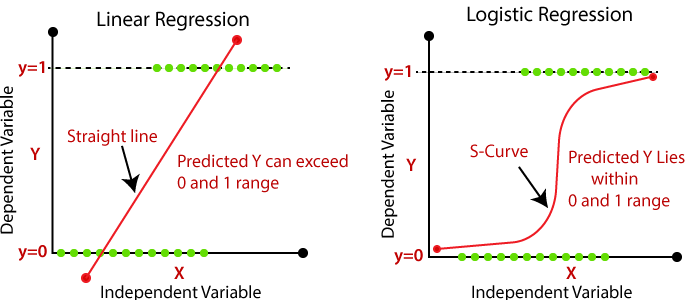

11.logistic regression 을 헷갈리게 하는 머신러닝

logistic regression을 기술면접에서 자주 물어본다. 비교적 간단하면서도 머신러닝 교재의 실전 알고리즘 1번에 등장하기 때문이 아닐까? 그런데 기술면접에서 이 질문에 대한 내 답변은 늘 부정적인 피드백을 받았다. 나는 통계학에서 배운대로 일반선형회귀(Ge

12.MLE를 위한 pytest

요즘 들어 많이 생각하는 주제는 머신러닝 또는 DS 프로젝트에서 테스팅을 어떻게 해야하는지에 관한 것이다. 프로그래밍을 하기 때문에 테스트를 당연히 해야하지만 뭔가 ML/DS 영역에서의 테스팅은 기존의 프로그래밍 테스트와 다른 부분이 있는 것 같다. 자세한 이야기는

13.OOP 면접 질문 - 다형성

ByteDance 면접 때, interviewer가 내게 다형성이 무엇인지 물었다.당황한 나의 대답은 "부모 클래스를 가지는 자식 클래스 각각에서 메써드의 구현을 다르게 할 수 있다" 였다. 당황해서 다형성에 대한 설명은 할 수 없었고 다형성이 표현된 방식을 설명한 것

14.[leetcode] 22. Generate Parentheses

오랫만에 코테 연습. 올 해 들어서 몇 문제 풀지 않았지만 그래도 10번째 문제 정도 되는 것 같다. 지난 번에 승지니어 강의 들으면서 외워둔 코드를 혼자서 다시 풀어봤다. 하루밖에 안지났는데도 처음엔기억이 안나더라..

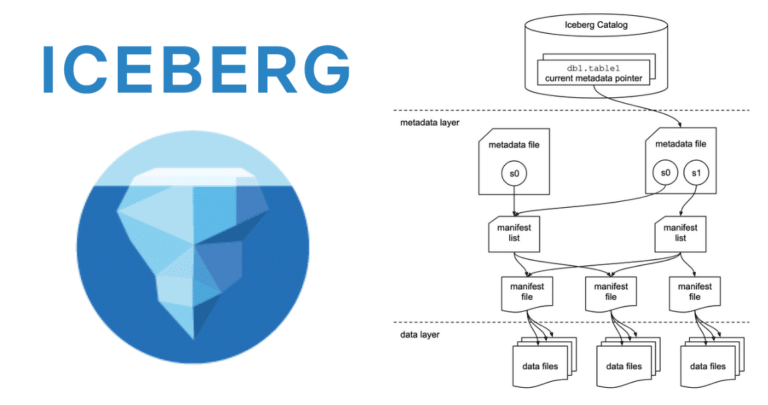

15.Hive 대신 Iceberg를 써보자 (maybe Delta?)

Amazon Athena가 나왔을 때 Hive Metastore와 s3 조합은 매력적이었다. 2010년대 말 AWS Partner로써 일했을 무렵 국내에서는 비싼 DW 시스템(Oracle, IBM, Teradata 등)에 대한 Cloud Migration이 한창이었다

16.자주 등장하는 머신러닝의 기본 개념들

자주 등장하는 머신러닝의 기본 개념들 (스스로 소화해 보기, 추가로 20~30개 정도 더 준비) TransformerEncoder와 Decoder 구조를 가지고 문장 전체의 의미와 순서를 학습할 수 있는 아키텍처임. 인코더에서는 문장 속 각 단어를 Vector로 이해하

17.쿠팡 면접 후기 - Staff Machne Learning Engineer

자주 이야기 하지 않는 어떤 이야기여기서는 소위 개조식, 즉 일목요연한 스타일로 작성하겠음. 목표는 잠재 구직자들에게 정보를 제공하고 싶어서임. 단, 채용 기밀은 유출하지 않는 것이 원칙.8월 초 쿠팡 recruiter에게서 inbound 연락이 왔음Senior/Sta