공부 내용

- DL Introduction

- DL Historical Review

DL Introduction

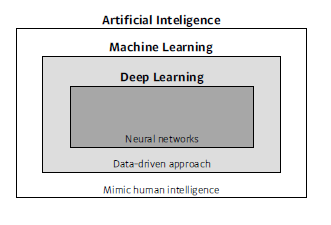

인공지능, 머신러닝, 딥러닝

- Artifical Inteligence : 인간의 지능을 모방

- Machine Learning : 데이터 기반 접근법

- Deep Learning : 인공신경망

딥러닝의 주 구성 요소

Data

모델이 학습할 수 있는 것 -> 해결해야 할 문제 타입에 따라 사용 data가 달라진다.

Model

데이터를 어떻게 결과로 변형시키는가

Loss

모델의 badness를 수치화하는 지표

- loss 종류

- Regression Task : MSE(Mean Square Error)

- Classification : CE(Cross Entropy)

- Probablistic : MLE(Maximum Likelihood Estimation)

Optimization Algorithm

loss를 최소화하기 위해 parameter를 조정

- 알고리즘 종류

- Dropout

- Early stopping

- K-fold validation

- Weight decay

- Batch normalization

- Mixup

- Ensemble

- Bayesian Optimization

Historical Review

각 연도별 주요 논문

- 2012 : AlexNet

- 224 * 224 이미지 분류

- 딥러닝이 성능을 발휘하기 시작

- 2013 : DQN

- 아타리 게임 강화학습 알고리즘

- 2014 : Encoder / Decoder

- Neural Machine Translation(기계번역) 문제를 풀기 위한 알고리즘

- 2014 : Adam Optimizer

- learning rate scheduling을 적용한 optimizer

- 2015 : Generative Adversarial Network(GAN)

- 이미지나 텍스트를 만들기 위한 모델

- Generator와 Discriminator를 학습시킴

- 2015 : Residual Networks(ResNet)

- 네트워크를 깊게 쌓을 수 있도록 만들어 준 모델

- 2017 : Transformer

- Attention만을 사용해서 기존 RNN 모델을 대체

- 2018 : BERT(fine-tuned NLP models)

- Transformer 구조 활용(Bidirectional Encoder 활용)

- 많은 말뭉치를 활용해 pretrain하고 Fine-Tuning해서 각 task에 활용

- 2019 : BIG Language Models(GPT3)

- Fine-Tuning을 활용해서 문장이나 프로그램, sequential model 등 만든다.

- 파라미터 수가 엄청나게 많은 것이 특징

- 2020 : Self Supervised Learning

- 라벨을 모르는 데이터도 학습에 활용