말평 과제란?

국립국어원의 인공지능 말평(Korean Language Intelligence Benchmark)은 한국어 인공지능 기술의 성능을 객관적으로 평가하기 위해 마련된 국가 공인 벤치마크입니다.

형태소 분석, 품사 태깅, 개체명 인식, 문장 관계 추론, 감정 분석, 질의응답, 문서 요약 등 언어 이해·생성 전반을 포괄하는 20여 개의 과제로 구성되어 있으며, 모든 과제는 국립국어원 세종 말뭉치와 인공지능 학습용 말뭉치를 비롯해 AI Hub·공공기관 협력 데이터 등 다양한 출처의 한국어 자료를 기반으로 구축되었습니다. 참가자는 모델의 결과를 시스템에 제출하여 정확도, F1-score, BLEU, ROUGE 등의 지표로 평가받으며, 이를 통해 학계·산업계의 한국어 AI 모델을 공정하게 비교할 수 있다. 인공지능 말평은 한국어 처리 기술의 품질 향상과 표준화된 연구 생태계 조성을 목표로 하는 대표적인 공공 AI 평가 프로젝트입니다.

다들 AI 허브는 많이 아는데 여기는 몰라서 좀 속상했는데 데이터가 많이 겹침 ㅋㅋ... 암튼 그래도 우리 멋진 쿠다 NLP 8기는 개빡세게 6주동안 스터디하고, 3주, 3주 과제를 하게 되었습니다.

첫 과제는 일단 '한국어' 특화 LLM 프로젝트를 해보자! 라는 의견에서 시작했고, 팀원마다 지식과 경험의 벡터값이 다 제각각이라 서로를 파악하면서 공부하고자 준비한 태스크이고 세 팀으로 구성해서 프로젝트를 하고 3주간 진행과정을 발표하면서 서로 질문하고 제안하면서 공부하는 시간을 갖는 것이다.

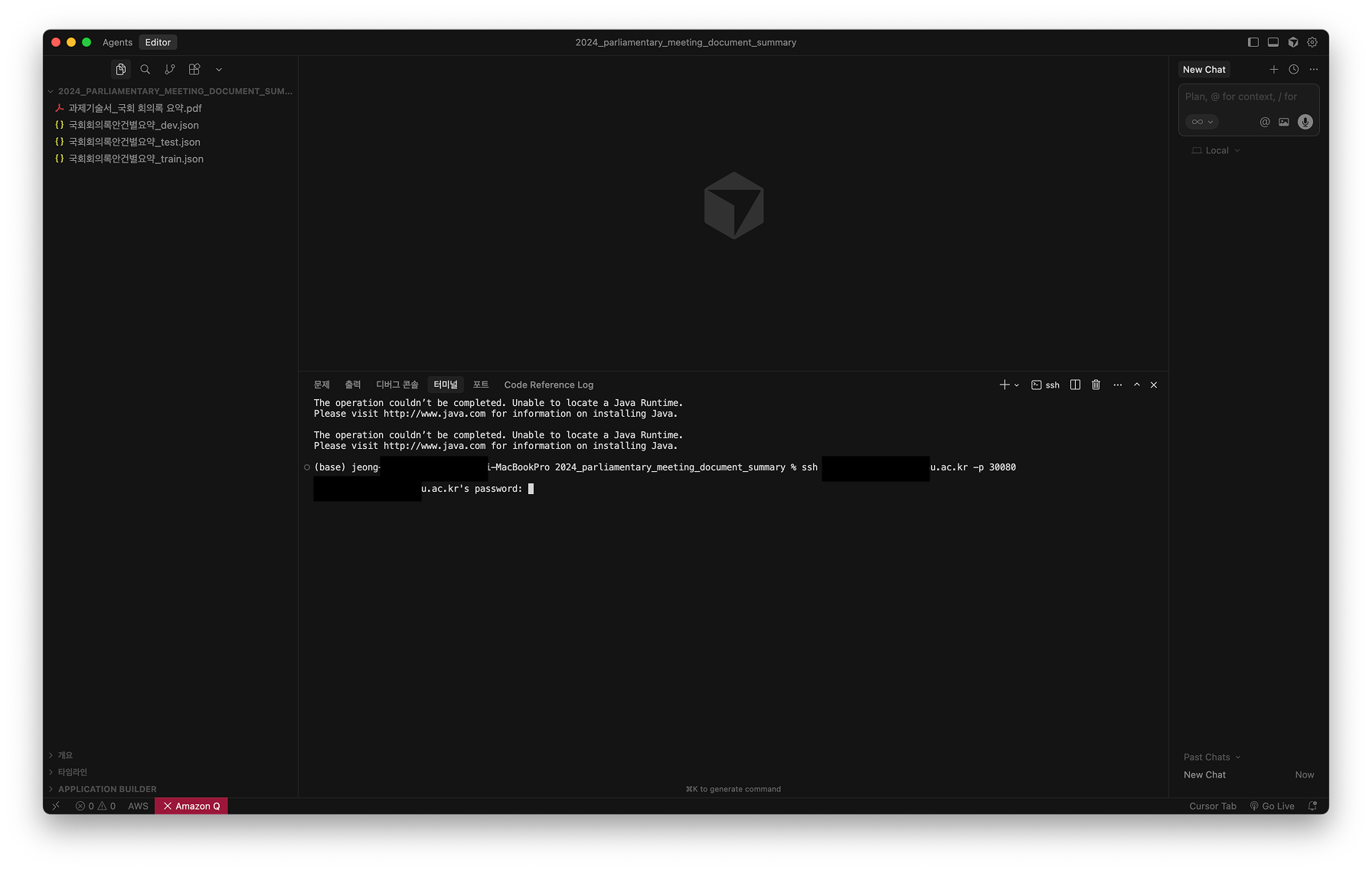

우선 LLM이 아무리 작아졌대도 우리의 노트북으로 학습시키거나 할 순 없기에 교내 소프트웨어 관련 학생들이 사용할 수 있는 세라프 사용법을 공유했고 사용 불가능한 경우 Colab Pro를 결제하였다.

처음 공부하는 입장에서 세라프 사용은 어렵기 때문에 기록해보겠다.

1. 한국어 일상 대화 연결

2. 그림(사진) 기반 문장 생성

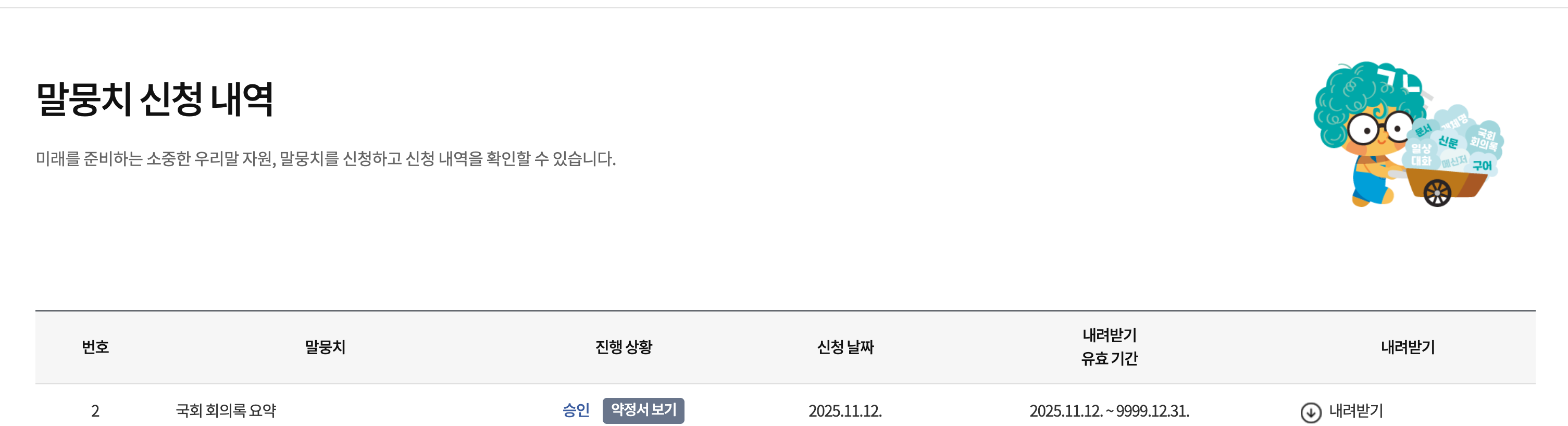

3. 국회 회의록 요약

세개 과제이고 나는 3번 국회 회의록 요약에 참여한다.

과제는 요약하자면

‘국회 회의록 요약’ 과제는 국립국어원의 2021·2022년 회의록 요약 말뭉치 연구 결과를 기반으로, 국회 회의록의 방대한 대화 내용을 자동으로 요약하는 인공지능 모델을 개발하는 것을 목표로 합니다. 참가자는 회의록 내 안건별 발언 데이터를 분석하여 주요 논의 내용, 결정 사항, 의견 차이를 간결하고 정보 가치 있게 요약해야 합니다. 입력 데이터는 발언자, 직책, 대화 내용, 안건 정보가 포함된 JSON 형식으로 제공되며, 출력은 모델이 생성한 요약문입니다. 성능 평가는 ROUGE-1 점수를 사용하여 생성된 요약문이 참조 요약문의 핵심어를 얼마나 잘 재현하는지를 측정합니다. 기준 모델은 GitHub(teddysum/Korean_NAMS_2024)에 공개되어 있으며, 외부 데이터를 학습에 활용할 수 있으나 ChatGPT 등 외부 API를 추론에 직접 사용하는 것은 금지됩니다.

로그인하고 자료 받기하고, 개인정보 사용 동의 서약을 쓰면 데이터를 다운로드할 수 있다.

데이터 다운로드를 하기위해서 앱 설치하고 데이터도 받을 수 있습니다.

전체 실험 기획

- Baseline → 전처리 → 언어전환 → 모델비교 순으로 실험을 설계해

단계별 개선 효과를 계량적으로 볼 수 있게 한다.- 외부 API 추론 금지 규칙을 지키면서도

공개 모델 fine-tuning을 통해 연구 확장성을 확보한다.- Aurora 환경에 맞춘 경량 모델(bart-base, kobart)로 자원 효율적인 실험을 진행한다.

| 단계 | 실험 목적 | 내용 요약 |

|---|---|---|

| 1단계 – Baseline 복제 | 기준 성능 확보 | 국립국어원 제공 기준 모델(teddysum/Korean_NAMS_2024)을 동일 환경에서 재현하여 기준 ROUGE-1 수치 확보 |

| 2단계 – 내부 모델 비교 | 구조별 성능 탐색 | Aurora 환경에서 직접 fine-tuning: 전처리·번역·한국어 모델별로 실험 (EXP A, B, C) |

| 3단계 – 외부 모델 확장(후순위) | 추가 개선 실험 | 허깅페이스 공개모델(예: BART, PEGASUS, KoBART)을 사전학습 기반으로 비교하되, ChatGPT 등 외부 API는 사용 X |

1) 데이터 준비

-

입력 형식:

{ "speaker": "홍길동", "position": "위원장", "agenda": "법안심사", "utterance": "본 안건에 대해 말씀드리겠습니다..." } -

출력:

summary필드에 참조 요약문 -

처리 대상: 발언 단위(utterance) 또는 안건 단위(agenda)로 병합 가능

-

파일 구조:

data/ ├─ raw.json ├─ preprocess/ │ ├─ split_train.jsonl │ ├─ split_val.jsonl │ └─ split_test.jsonl

2) 환경 세팅

너무 길어져서 다음 글로 패쓰

다음글 1(Aurora 너 누군데)

[다음글 2(말평 진행사항(1))]

3) 실험 구성

EXP A — Baseline / 전처리 최소화

- 입력: 원본 회의록 텍스트 (

utteranceoragenda단위) - 모델:

facebook/bart-large-cnn(또는kobart) - 목적: 전처리 없이 baseline 성능 확인

- 출력:

outputs/exp_A/ - 지표: ROUGE-1, GPU 메모리, 학습 시간

EXP B — 전처리 + 번역 + 영어모델

- 입력: 한국어 → 영어 번역 (Marian MT

opus-mt-ko-en) - 모델:

facebook/bart-large-cnn - 목적: 번역 중간단계를 거친 경우 성능 및 자원 사용량 비교

- 출력:

outputs/exp_B/

EXP C — 전처리 + 한국어모델

- 입력: 전처리된 한국어 데이터

- 모델:

hyunwoongko/kobart(국문용) - 목적: 한국어 전용 사전학습 모델과 비교

- 출력:

outputs/exp_C/

4) 데이터 전처리

생각해보면 이거 데이터가 발화 데이터라 요약에 필요없는 데이터가 많았습니다.

데이터 전처리 논의에서는 국회 회의록 요약 모델의 입력 품질을 극대화하기 위한 통합 파이프라인 설계에 초점을 맞추었습니다. 핵심 목표는 하나의 회의록 안에 포함된 여러 안건을 명확히 분리하고, 각 안건과 직접적으로 관련된 발화만을 선별하여 모델 입력을 정제하는 것입니다. 이를 위해 sentence_id를 안건 시작점으로, “~되었음을 선포합니다” 등의 종결 패턴을 종료점으로 활용하는 분리 규칙이 제안되었으며, 예외적인 경우에는 LLM을 활용해 “특정 keyword 관련 내용만 요약”하도록 후처리를 적용하는 방안이 논의되었습니다. 불필요한 짧은 문장이나 머뭇거림 발화는 제거하고, 숫자나 법안명 등 핵심 정보가 포함된 문장은 유지하는 세부 기준이 설정되었습니다.

전체 전처리 플로우는 4단계 파이프라인 구조로 설계되었습니다. (1) 화자명 앞에 [직책/역할] prefix를 부여하여 발화 구조를 명확히 하고, (2) 의례적·불용 문장을 정규식으로 제거하거나 결정문을 DECISION 태그로 표시하며, (3) 안건명과 핵심 키워드를 KEY 태그로 강조하고, (4) TF-IDF 기반으로 중요도가 높은 문장을 IMP 태그로 감싸 가중치를 부여합니다. 특히 TF-IDF는 회의 전체 단위보다 안건별 계산 단위로 수행하는 것이 타당하다는 결론이 도출되었습니다. 향후 실험 단계에서는 전처리된 데이터를 기반으로 GemmaX2-28-2B-v0.1 등 경량 LLM을 적용해 요약 성능을 검증할 예정입니다.

참고 링크

- 회의록 요약 과제 기술서: 국립국어원 말평 (NIKL)

- 기준 모델(GitHub): Korean_NAMS_2024

- 전처리 참고 모델: ModelSpace/GemmaX2-28-2B-v0.1 (Hugging Face)

5) 학습 단계

-

실행 예시:

python src/finetune_summarizer.py \ --model_name facebook/bart-large-cnn \ --data_dir data/preprocess \ --output_dir outputs/exp_A \ --epochs 3 -

주요 설정

항목 값 max_input_length1024 max_target_length128 batch_size1~2 fp16True evaluation_strategyepoch

6) 평가 및 로그

-

src/evaluate.py로 ROUGE-1 계산 -

GPU/CPU 메모리 모니터링(

src/monitor.py) -

결과 정리:

실험 모델 ROUGE-1 (F1) GPU Max (GB) CPU (GB) 시간 A - - - - - B - - - - - C - - - - -

7) 후속 실험

이건 일단 제 계획입니다.

| 추가 실험 | 목적 |

|---|---|

pegasus-xsum | 추상적 요약 성능 확인 |

longformer-encoder-decoder | 장문 처리 성능 확인 |

kobart vs kot5 | 한국어 구조 비교 |

데이터 augmentation | 저자원 구간 개선 실험 |

pseudo-labeling | unlabeled 회의록 확장 |