(ACL 2025, Accept)

Introduction

- 기존 LLM은 사전 학습 데이터의 불균형으로 인해 영어 외 저자원 언어에서 성능이 급격히 저하되는 문제가 있음

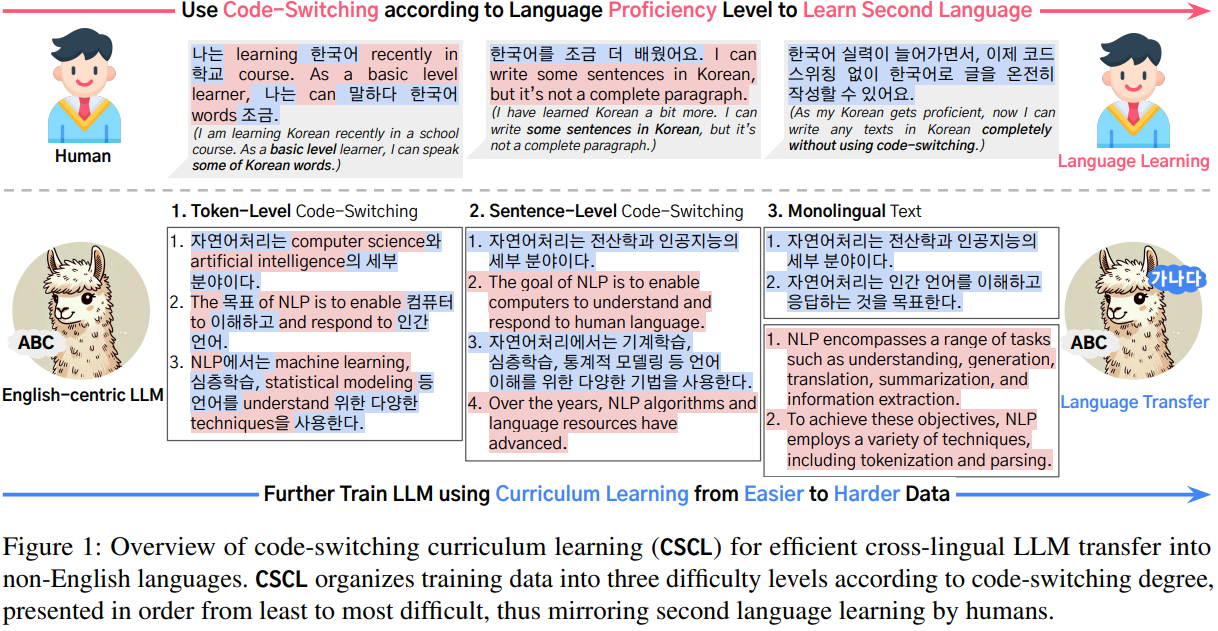

- LLM의 교차 언어 전이 성능을 향상시키기 위해 인간의 제2언어 습득 과정, 특히 코드 스위칭에서 영감을 받은 코드 스위칭 커리큘럼 학습(Code-Switching Curriculum Learning, CSCL) 제안

- CSCL은 LLM이 목표 언어를 학습하는 과정을 세 단계의 난이도별 데이터로 구성된 커리큘럼을 통해 모방

- 난이도는 코드 스위칭의 정도에 따라 결정되며, 쉬운 단계에서 어려운 단계로 점진적으로 모델을 훈련

Methonology

- 토큰 수준 코드 스위칭 코퍼스

- 두 언어의 토큰들이 혼합된 코퍼스 사용하여 LLM 훈련

- 이 데이터셋은 GPT-4o를 사용하여 합성하며, 합성된 토큰 수준 코드 스위칭 데이터를 정성 평가한 결과 인간의 코드 스위칭에서 흔히 관찰되는 품사의 빈번한 발생, 특정 용어의 반복 사용, 문법적 융합 또는 혼합 등의 특징을 보임

- 문장 수준 코드 스위칭(Sentence-Level Code-Switching) 코퍼스

- 동일한 의미적 맥락 내에서 목표 언어 문장과 영어 문장이 교대로 나타나는 코퍼스를 사용하여 LLM 훈련

- 이 데이터셋은 영어 문장과 목표 언어 문장을 정렬하는 병렬 코퍼스를 활용하여 생성되며, 의미적으로 겹치지 않으면서 동일한 맥락을 공유하는 문장들이 순차적으로 배열됨

- 단일 언어 텍스트

- 목표 언어와 영어의 단일 언어 텍스트로 모델 훈련

- 기존의 언어 전이 학습 방식과 유사하며, 영어의 catastrophic forgetting을 방지하기 위해 목표 언어와 영어 코퍼스의 크기를 동일하게 유지

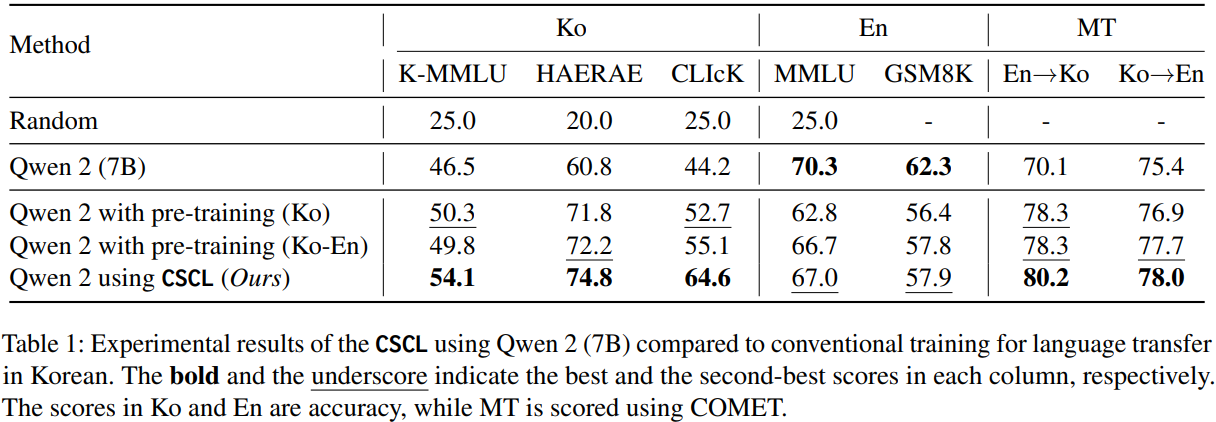

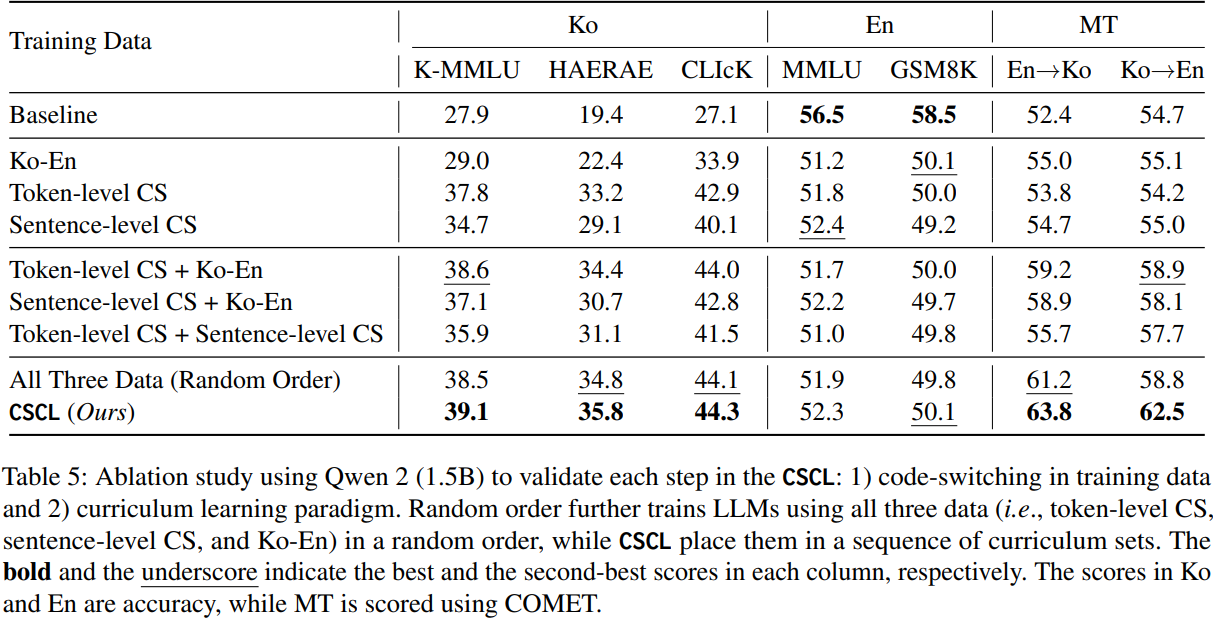

Experimental Result