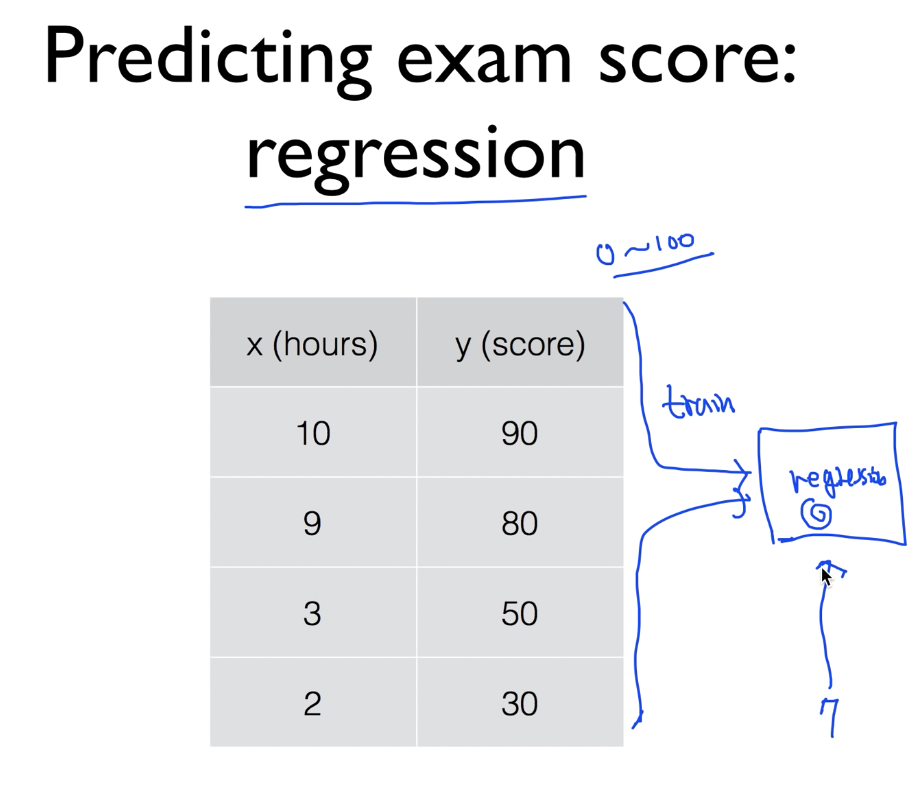

Regression model

Linear regression

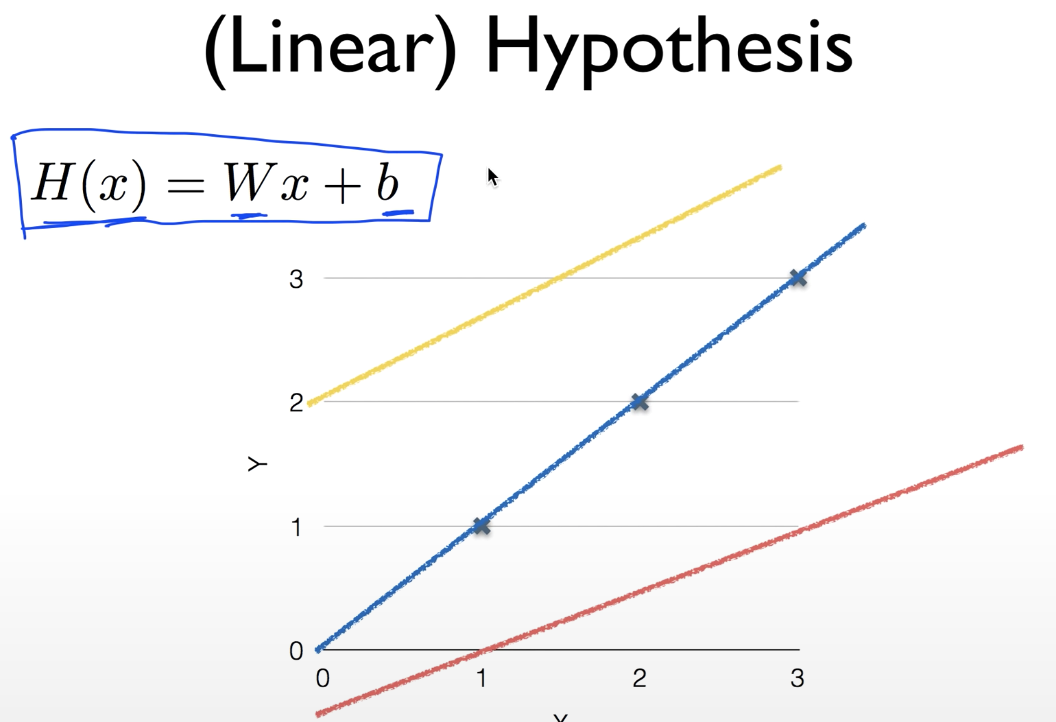

데이터에 맞는 선을 찾는것이 중요하다.

H(x) = Wx + b 다양한 H 중에서 어떤 W와 b 가 좋은지 찾아야한다.

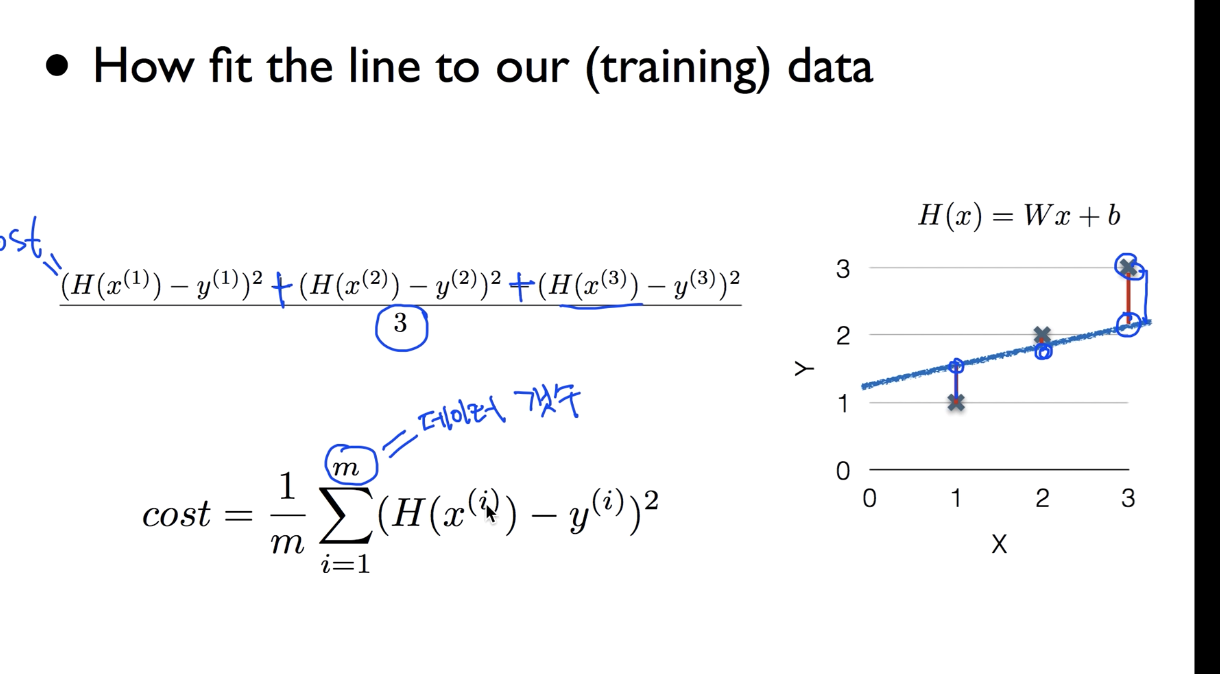

cost function

- how fit the line to our (training)data

- (H(x) - y)^2^ 값이 양수 음수 상관없이 찾을수 있고 제곱으로 인해 차이가 더 커보여서 확인하기 쉽다.

cost function

Linear regression 의 목표는 cost function의 값이 가장 작게 나오는 cost(W,b)를 구하는것

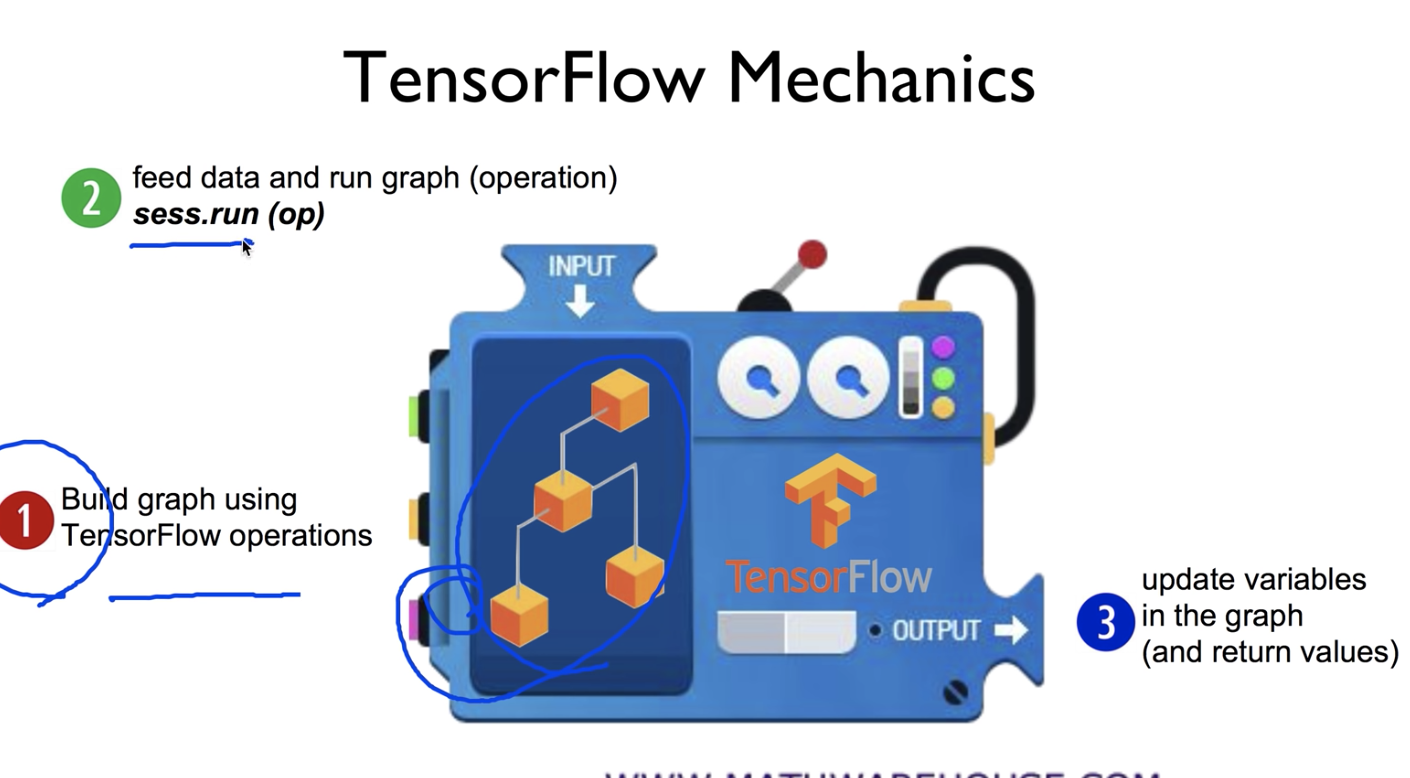

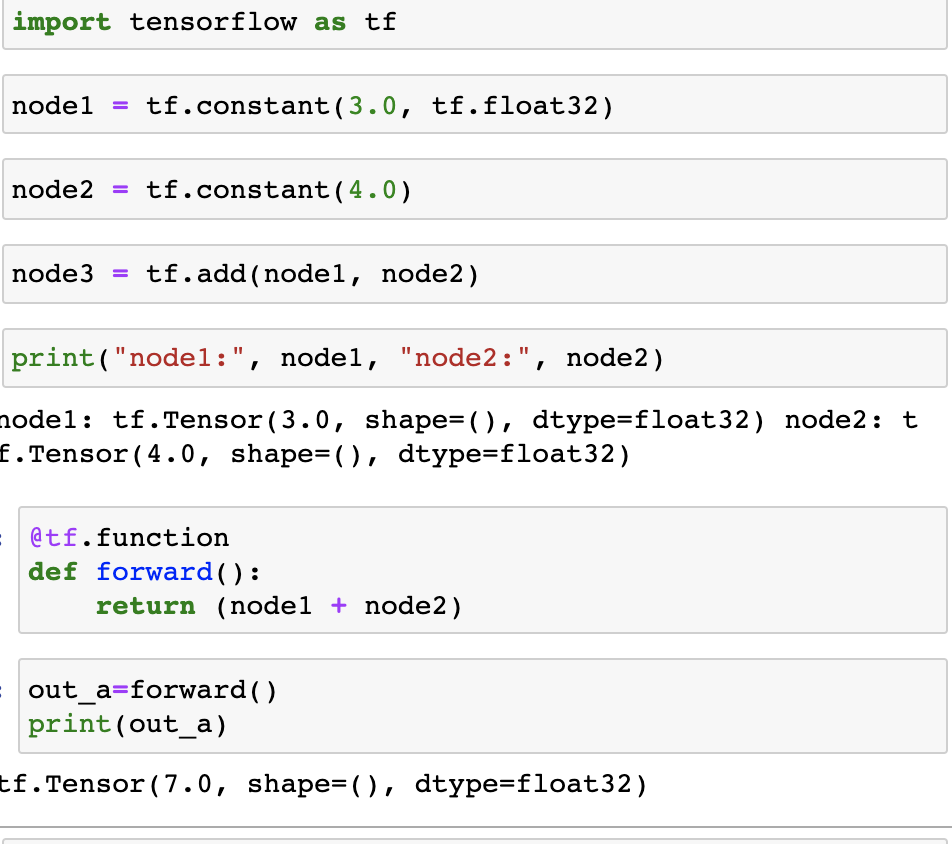

Lab 1

예제 코드

- Tensor Ranks, Shapes, and Types ?? 알아보기

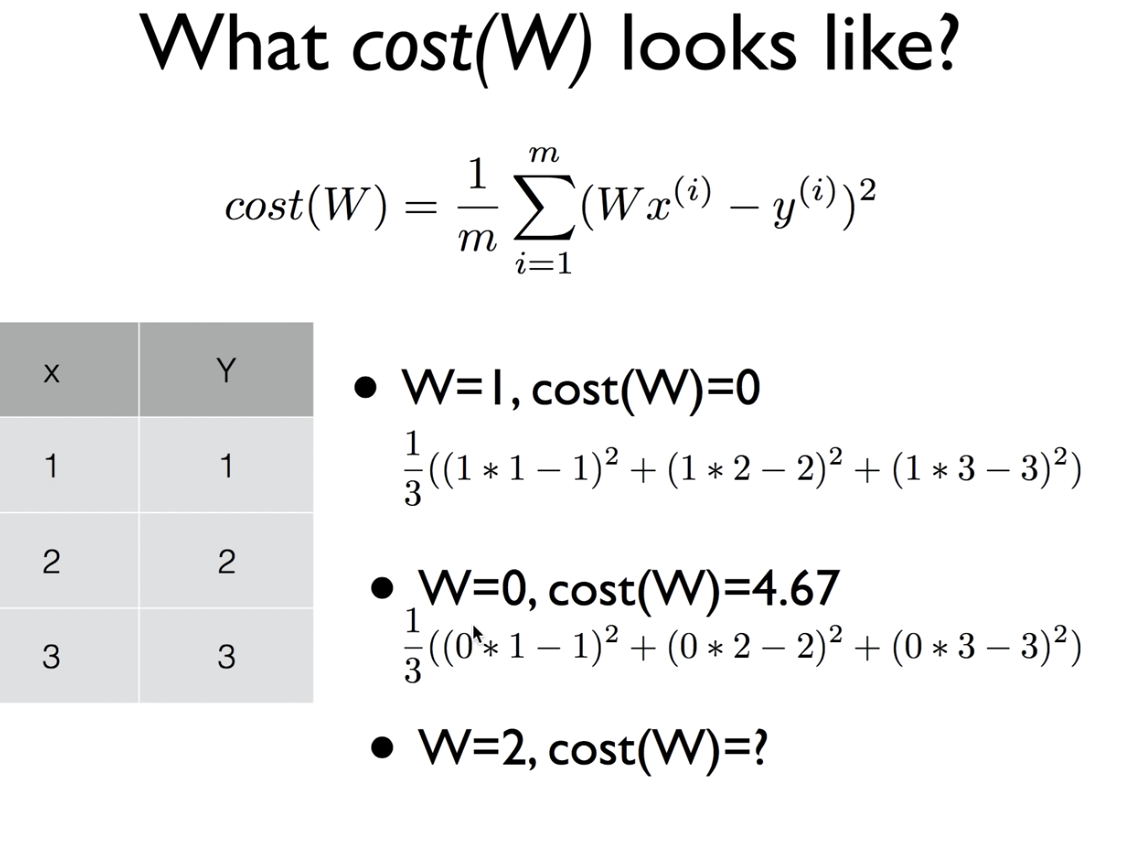

How to minimize cost

- Simplified hypothesis

H(x) = Wx

- w = 1, cost(W) = 0

- w = 0, cost(W) = 4.67

- w = 2, cost(W) = 4.67

Gradient descent algorithm

-

Minimize cost function

-

Gradient descent is used many minimization probleme

-

For a given cost function, cost(W,b), it will find W,b to minimize cost

-

It can be applied to more general function : cost (w1, w2 ...)

-

we can start any other value

-

keeping changeing W and b a little bit to try and reduce cost(W,b)

-repeat

기울기 = 미분 ????? 미분 ??????? -

Convex function 의 경우에만 Gradient descent algorithm이 작동한다

밥그릇을 뒤집어 놓은 모양의 그래프에서만 적용가능.